Evaluación del rendimiento de apps

La evaluación del rendimiento le permite realizar una evaluación a medida que desarrolla su app. Proporciona métricas claras y procesables, como los tiempos de respuesta de las hojas y losobjetos públicos. Puede utilizar estos conocimientos para identificar los cuellos de botella en el rendimiento y comparar las métricas entre las versiones de la app.

Quién puede utilizar la evaluación del rendimiento

La evaluación del rendimiento está pensada para los desarrolladores de apps que desean medir y mejorar el rendimiento de sus aplicaciones.

Para ejecutar una evaluación de rendimiento, debe tener uno de los siguientes roles:

-

Administrador de espacio empresarial inquilino

-

Propietario del espacio

-

Miembro del espacio con uno de estos roles:

-

Puede editar

-

Puede editar datos en las aplicaciones

-

Puede administrar

-

Puede operar (en espacios administrados)

-

-

Todos los usuarios, incluidos los administradores de un espacio empresarial inquilino, deben tener al menos permisos de visualización en el espacio para evaluar las apps que allí se encuentren.

-

Los administradores de un espacio empresarial inquilino siempre podrán ver los resultados de evaluación del rendimiento de todas las apps, aunque no tengan permiso de acceso para ese espacio o app en concreto.

Utilizar la evaluación del rendimiento

Puede evaluar el rendimiento de cualquier app de Qlik Sense en Qlik Cloud. Utilice la evaluación del rendimiento para:

-

Medir el rendimiento de su app.

-

Comprobar si los cambios realizados en su app han afectado al rendimiento.

La evaluación del rendimiento analiza los tiempos de respuesta de todas las hojas y objetos públicos de la app. Solo se incluyen las hojas publicadas, por lo que las hojas en desarrollo no afectan a los resultados.

Utilice los resultados para identificar los objetos que puedan necesitar una optimización. Tenga en cuenta que los resultados pretenden ser una orientación general y podrían no reflejar el rendimiento exacto en un entorno de producción en vivo.

Aspectos a tener en cuenta

-

La evaluación del rendimiento se ejecuta en un entorno basado en la nube, por lo que los tiempos de respuesta pueden variar debido a la latencia y a las fluctuaciones del ancho de banda.

-

Para garantizar comparaciones más coherentes, realice las evaluaciones muy próximas en el tiempo.

-

Los resultados pueden verse afectados si las evaluaciones se realizaron en motores de análisis de diferentes tamaños.

Para más información sobre los factores de rendimiento, consulte Optimizar el rendimiento de las apps.

Selección de motores para evaluaciones de apps

Cuando ejecuta una evaluación del rendimiento de una app en Qlik Cloud, la evaluación se ejecuta en un motor específico.

De manera predeterminada, las evaluaciones utilizan un motor de 20 GB (Standard-20). Si su licencia incluye la compatibilidad con apps de gran tamaño, las evaluaciones podrán ejecutarse en un motor más grande (de Grande-40 a Grande-200) cuando la app requiera más memoria y el espacio esté configurado para apps grandes.

El motor utilizado en la evaluación es del mismo tamaño que el que utilizarán los usuarios reales cuando abran la app. Esto le permite observar el rendimiento en el entorno de ejecución esperado.

Los motores más grandes suelen mejorar los tiempos de respuesta, pero las mejoras también pueden venir del diseño de la app o de optimizaciones. Comparar los resultados entre distintos tamaños de motor puede ayudarle a distinguir entre los efectos de capacidad y los ajustes de configuración de la app.

Tamaños de motor

-

Standard-20: es el motor predeterminado (20 GB)

-

Large-40, Large-60, ... Large-200: son los motores más grandes (la cifra indica los GB de memoria)

| Motor | Memoria | Hasta x núcleos*. |

|---|---|---|

| Large-40 | 40 GB | 10 núcleos |

| Large-60 | 60 GB | 14 núcleos |

| Large-80 | 80 GB | 20 núcleos |

| Large-120 | 120 GB | 30 núcleos |

| Large-160 | 160 GB | 40 núcleos |

| Large-200 | 200 GB | 50 núcleos |

* "Hasta x núcleos" significa que los recursos se aprovisionan según las necesidades, aunque no todos los cálculos pueden utilizar todos los núcleos simultáneamente.

Uso de la capacidad

-

Ejecutar una evaluación de rendimiento en una app de gran tamaño utiliza parte de su gran capacidad de recarga de la app, aunque la app no se recarga. Qlik Cloud aprovisiona temporalmente un motor más grande para realizar la evaluación,

-

Abrir la app directamente para probar el rendimiento gasta gran capacidad de consumo para la sesión, igual que el uso normal.

Si desea más información sobre la capacidad de apps de gran tamaño, consulte Compatibilidad con apps grandes.

Ejecutar evaluaciones del rendimiento en aplicaciones

Para ejecutar una evaluación de rendimiento, debe tener permiso de recarga para la app. Puede ejecutar una evaluación de rendimiento desde:

-

Sus centros de actividades

-

Detalles de la app

Ejecutar evaluaciones del rendimiento desde sus centros de actividades.

Haga lo siguiente:

-

En su centro de actividades, haga clic en

sobre la app que desee evaluar.

-

Seleccione

Evaluar el rendimiento.

Recibirá una notificación cuando se complete la evaluación.

Ejecutar evaluaciones del rendimiento desde los detalles de la aplicación

Haga lo siguiente:

-

En su centro de actividades, haga clic en

sobre la app que desee evaluar.

-

Seleccione

Detalles, después haga clic en

Evaluación del rendimiento.

-

Haga clic en Evaluar ahora.

Ejecutar evaluaciones de rendimiento desde una app

Haga lo siguiente:

-

En su app, haga clic en el nombre de la app para abrir Detalles.

-

Haga clic en

> Evaluar el rendimiento.

Ver los resultados de una evaluación

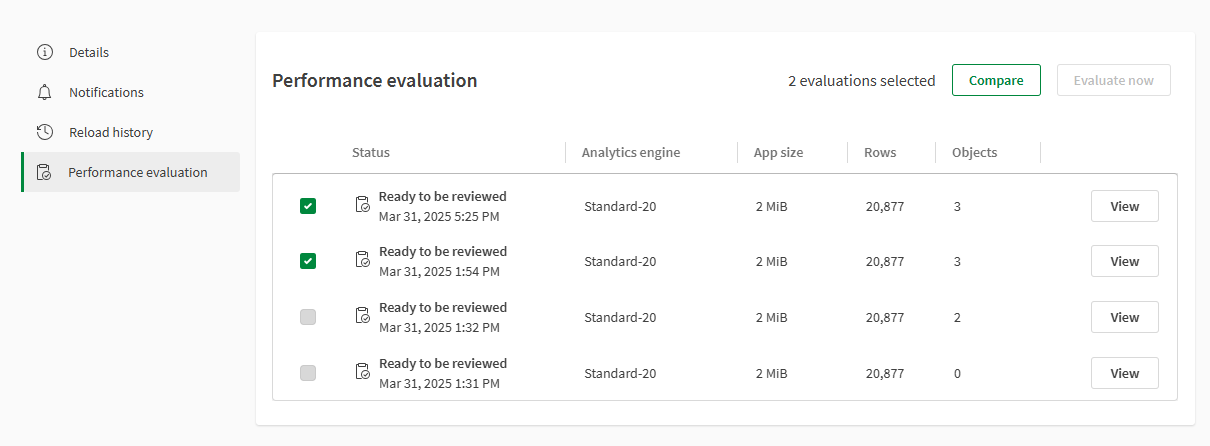

En función de si desea ver una única evaluación del rendimiento o comparar dos evaluaciones del rendimiento, las tablas de resultados pueden ser diferentes.

Los resultados de la evaluación del rendimiento de una app se conservan durante 90 días.

Ver una única evaluación del rendimiento

Haga lo siguiente:

-

Para ver la evaluación del rendimiento, haga clic en

en la app.

-

Seleccione

Detalles, después haga clic en

Evaluación del rendimiento. Todas las evaluaciones se muestran en la tabla de evaluaciones de rendimiento.

Nota de sugerenciaTambién puede ir a los resultados si hace clic en Ver resultados en la notificación. -

Haga clic en Ver en la evaluación que desee ver.

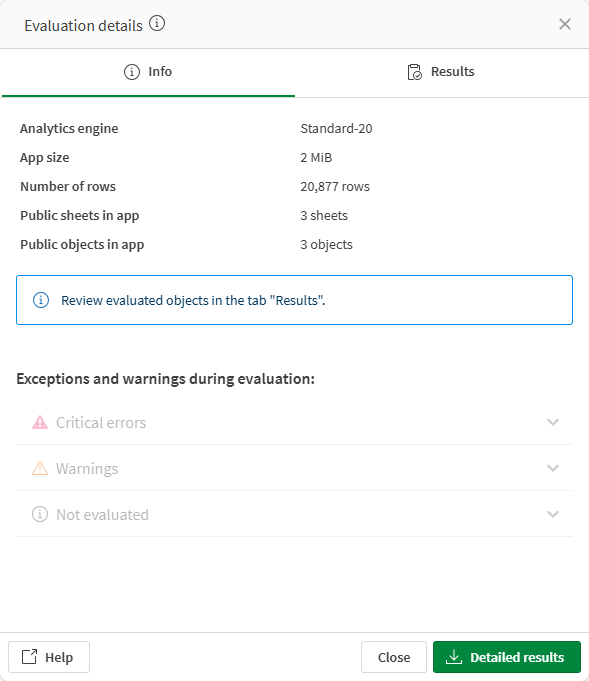

Vista general de la evaluación.

-

La ventana de resultados proporciona información sobre los resultados de la evaluación del rendimiento.

Nota de sugerenciaConsulte Información de la evaluación del rendimiento para ver detalles sobre métricas específicas.Ficha de información sobre la evaluación.

-

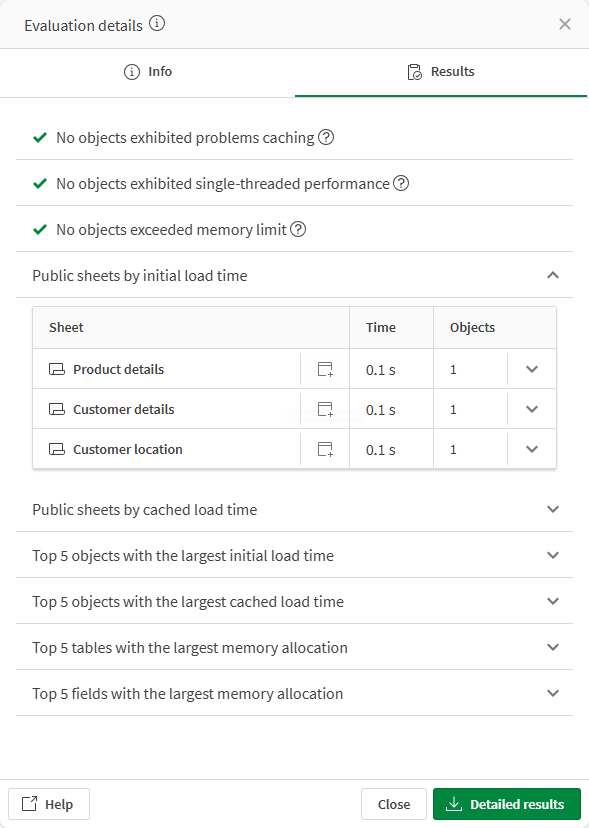

Seleccione la pestaña Resultados para ver información del rendimiento más específica.

Pestaña de resultados de la evaluación.

-

Haga clic en

para que se muestren los detalles de cada fila. También puede hacer clic en

para que cada hoja muestre los objetos con mayor tiempo de carga.

-

Haga clic en

para abrir la app que contiene el objeto. El objeto especificado se resalta en la hoja.

Comparar evaluaciones del rendimiento

Haga lo siguiente:

-

Para ver la evaluación del rendimiento, haga clic en

en la app.

-

Seleccione

Detalles, después haga clic en

Evaluación del rendimiento. Todas las evaluaciones se muestran en la tabla de evaluaciones de rendimiento.

-

Seleccione los dos que desee ver y, a continuación, haga clic en Comparar.

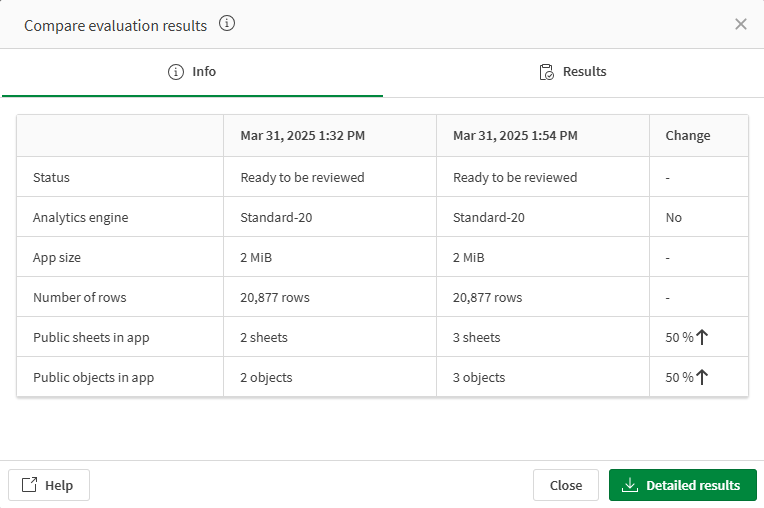

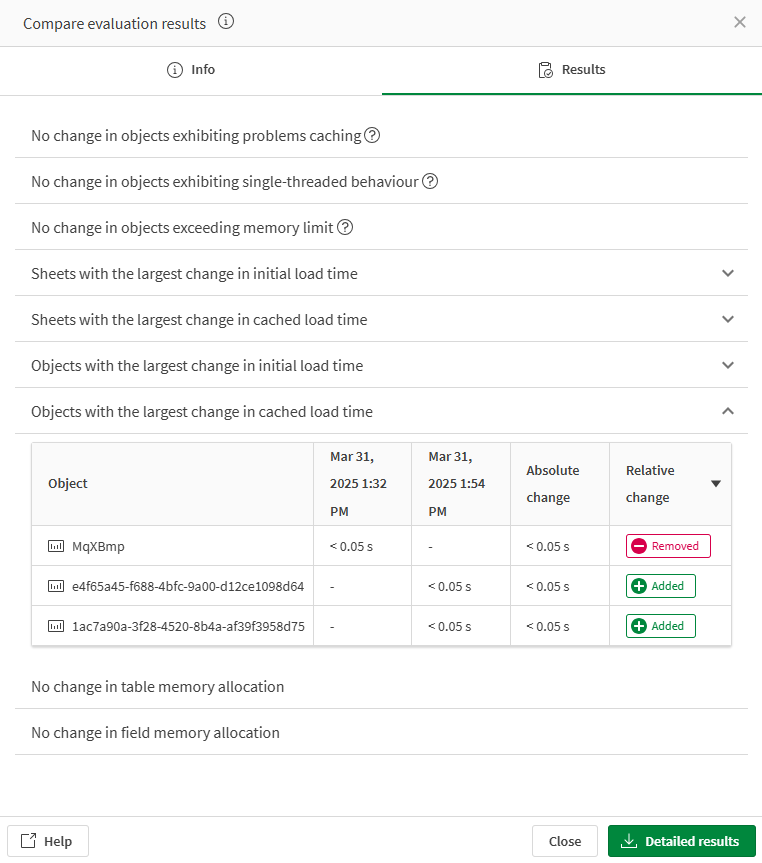

Comparativa de dos evaluaciones.

-

Los resultados de la evaluación se abren en una ventana. Consulte Información de la evaluación del rendimiento para ver detalles sobre métricas específicas. La pestaña Información muestra las métricas de la evaluación del rendimiento seleccionada, además de las diferencias entre ellas.

Información sobre la comparativa de evaluaciones.

-

Seleccione la pestaña Resultados para ver información más específica sobre el rendimiento. En cada fila, se muestra el cambio absoluto y relativo.

Puede ordenar las columnas de Cambio absoluto y Cambio relativo. Haga clic en el encabezado de la columna para ordenar por orden ascendente o descendente.

Resultados de la comparativa de evaluaciones.

-

Haga clic en

para que se muestren los detalles de cada fila.

Información de la evaluación del rendimiento

Las métricas se obtienen de los metadatos de la app, o se miden durante la evaluación del rendimiento.

La pestaña Información

La pestaña Información muestra información básica sobre la app en la versión seleccionada.

Motor de análisis

-

Muestra el motor de análisis utilizado durante la evaluación.

Nota informativaSi se activa la compatibilidad con apps grandes, se podrá utilizar un motor más grande en lugar del motor Standard-20.

Estado

-

El estado de la evaluación del rendimiento

-

Listo para ser revisado: la evaluación del rendimiento se completó con éxito.

-

Advertencia: la evaluación del rendimiento se completó, pero algunos resultados faltan o son inexactos.

-

No se pudo evaluar: la evaluación del rendimiento no se completó satisfactoriamente y faltan resultados o estos son inexactos.

-

Tamaño de app

-

Origen de la métrica: metadatos de la app

-

Muestra el tamaño total del modelo de datos de la app en memoria sin selecciones iniciales.

Número de filas

-

Origen de la métrica: metadatos de la app

-

Muestra las filas totales contenidas en las tablas del modelo de datos de la app.

Objetos públicos en la app

-

Origen de la métrica: metadatos de la app

-

Muestra el total de hojas públicas en la app.

Objetos públicos en la app

-

Origen de la métrica: metadatos de la app

-

Muestra el total de objetos públicos en la app.

Nota informativaEn los resultados de la evaluación del rendimiento, las hojas públicas no se contabilizan como objetos públicos.

No evaluado

-

Origen de la métrica: medición

-

Muestra todos los objetos que no se pudieron evaluar por completo. Los motivos típicos pueden incluir si el objeto tiene una condición de cálculo que no se ha cumplido o si el tipo de objeto no es compatible con la evaluación. Por ejemplo, el evaluador de la aplicación no conoce el comportamiento de la extensión desarrollada por el cliente y es posible que no se evalúe correctamente.

Advertencias

-

Origen de la métrica: medición

-

Muestra los objetos que tienen problemas relacionados con el desarrollo de aplicaciones, que podrían necesitar solución. Por ejemplo, un objeto que funciona en una hoja pero tiene códigos de error, como un objeto que no tiene medidas o dimensiones, aparece en Advertencias. Si un objeto devuelve una página de datos de un tamaño específico, también aparecerá aquí como Carga útil demasiado grande.

Errores críticos

-

Origen de la métrica: medición

-

Muestra los errores que impidieron que se completara la evaluación, junto con las cuotas de espacios inquilinos o aplicaciones. Esto puede incluir errores del evaluador de aplicaciones u otros problemas de infraestructura que impiden la finalización, como si se excede la cuota de evaluación de la aplicación o si la aplicación excede el límite de tamaño de evaluación de la aplicación de 20 GB y no se puede abrir.

La pestaña de resultados

La pestaña Resultados proporciona información más específica sobre la evaluación del rendimiento.

Objeto que da problemas al guardarse en caché

-

Origen de la métrica: medición

-

Muestra los objetos que no se guardan en la memoria caché de forma eficaz. Se determina cargando cada objeto dos veces. Después de haber cargado un objeto una vez, se espera un tiempo de respuesta más rápido porque el conjunto de resultados debería introducirse en la memoria caché. Se pueden realizar mejoras potenciales si se ajustan el modelo de datos o las expresiones. Para más información, vea Mejores prácticas de modelado de datos y Utilizar expresiones en las visualizaciones.

-

Para obtener más información sobre la optimización general de las apps, vea Optimizar el rendimiento de las apps.

Objetos de un solo subproceso

-

Origen de la métrica: medición

-

Esta sección contiene objetos cuyas métricas de rendimiento indican la predominancia del procesamiento de un solo subproceso durante la carga. Si un objeto aparece en esta sección y el tiempo de respuesta para un usuario se considera demasiado largo, las consultas resultantes de cualquier expresión del objeto deben revisarse en busca de cuellos de botella. Se pueden realizar mejoras potenciales si se ajustan el modelo de datos o las expresiones.

-

Para más información sobre el rendimiento de un solo subproceso, vea Los campos de diferentes tablas dentro de una tabla de agregación se evitan siempre que sea posible.

Objetos que exceden el límite de memoria

-

Origen de la métrica: medición

-

Esta sección contiene objetos que han alcanzado un límite de memoria, con su correspondiente código de error. Estos pueden incluir objetos que alcanzan un límite de espacio aislado de objetos del motor, excedieron la memoria total del motor o alcanzaron un límite de memoria relacionado.

Hojas públicas por tiempo de carga inicial

-

Origen de la métrica: medición

-

Medición del tiempo de respuesta por hoja. Estas mediciones se extraen de la primera vez que se recorre la app y cada una de las hojas se solicitan de una en una. Los valores incluidos en esta sección representan el peor tiempo posible de carga por hoja. Para cada hoja se pueden ver los 5 objetos más lentos que contiene haciendo clic en el icono de flecha a la derecha de la fila. Esto le brinda un desglose rápido de dónde se gasta el tiempo mientras se carga la hoja.

-

Si la evaluación se detiene debido a que finaliza un tiempo de espera, la lista de hojas estará disponible siempre que se haya completado al menos una evaluación de hojas. Puede utilizar esta lista para identificar qué hojas u objetos debe investigar primero.

Tiempo de carga de la hoja en caché

-

Origen de la métrica: medición

-

Medición del tiempo de respuesta por hoja. Cuando se solicitaron todas las hojas por primera vez, normalmente deberían haberse guardado en caché. Estas mediciones se extraen de la segunda vez que se recorre la app y cada una de las hojas se solicitan de una en una. También aquí puede obtener un desglose de dónde se gasta el tiempo por objeto, expandiendo una fila con el botón de la derecha.

Tiempo de carga inicial del objeto

-

Origen de la métrica: medición

-

Medición del tiempo de respuesta por objeto. Estas mediciones se extraen de la primera vez que se recorre la app y cada uno de los objetos se solicitan de uno en uno. Los valores incluidos en esta sección representan el peor tiempo de carga posible por objeto.

-

Por ejemplo, puede mejorar el uso del almacenamiento en caché utilizando elementos maestros. Para más información, vea Utilizar elementos maestros o variables para las expresiones.

Tiempo de carga del objeto en caché

-

Origen de la métrica: medición

-

Medición del tiempo de respuesta por objeto. Cuando se solicitaron todos los objetos por primera vez, normalmente deberían haberse guardado en caché. Estas mediciones se extraen de la segunda vez que se recorre la app y cada uno de los objetos se solicitan de uno en uno.

Asignación de memoria por tabla

-

Origen de la métrica: metadatos de la app

-

Una lista de las tablas incluidas en el modelo de datos y su tamaño. Esta sección será de interés al intentar minimizar el tamaño del modelo de datos, lo que se traduce en una mejora de la capacidad de respuesta.

-

Puede eliminar campos y tablas que no se utilicen en ninguna expresión del script de carga para mejorar la velocidad y el uso de recursos. Para más información, vea Rendimiento del modelo de datos.

Asignación de memoria por campo

-

Origen de la métrica: metadatos de la app

-

Una lista de los campos incluidos en el modelo de datos y su tamaño. Esta sección será de interés al intentar minimizar el tamaño del modelo de datos, lo que se traduce en una mejora de la capacidad de respuesta.

-

Puede eliminar campos y tablas que no se utilicen en ninguna expresión del script de carga para mejorar la velocidad y el uso de recursos. Para más información, vea Rendimiento del modelo de datos.

Preferencias de notificación

Puede elegir que se le notifique cuando la evaluación del rendimiento se haya completado o haya fallado.

Haga clic en en una pasarela de datos y seleccione Notificaciones. Están disponibles las siguientes notificaciones para evaluaciones de rendimiento:

-

Una evaluación del rendimiento de esta app está lista para su revisión

-

No se pudo ejecutar una evaluación del rendimiento de esta app

Limitaciones

-

Solo se evalúan las hojas públicas de la app, incluidos todos los objetos que contienen.

-

Gestión de los tiempos muertos de evaluación

Si una app tiene muchos objetos o es muy grande, es posible que la evaluación del rendimiento se demore. La interrupción o conclusión del tiempo de espera no significa que la evaluación haya fallado por completo. Aunque se detenga antes de tiempo, podrá revisar las hojas y los objetos más lentos que se hayan evaluado hasta ese momento. Utilice esa lista para investigar los problemas de rendimiento.

Para reducir el riesgo de que se agote el tiempo de espera:

-

Haga privadas las hojas irrelevantes antes de ejecutar la evaluación.

-

En el caso de las apps publicadas, puede duplicar la app y publicar una copia con menos hojas públicas.

Las conclusiones de tiempos de espera y las advertencias de memoria son normales en las apps complejas. Indican aquellas áreas en las que la optimización, menor cantidad de datos o un motor más grande pueden mejorar el rendimiento.

-

-

No se admiten todos los objetos de gráfico. Si un objeto no se admite, se menciona en la sección No evaluado de los resultados.

-

Los objetos de gráfico creados a partir de sugerencias de gráficos anteriores a la versión June 2020 deben actualizarse manualmente para ser compatibles.

-

Si la app utiliza Section access para reducir los datos, la evaluación se realiza con los datos reducidos para el usuario actual. Esto significa que debe ejecutar la evaluación como un usuario con acceso al conjunto de datos que desea evaluar. No es relevante comparar los resultados de usuarios con diferente Section Access.

-

Caso predeterminado (sin compatibilidad con apps grandes): la evaluación del rendimiento de la app está limitada a 20 GB de capacidad del motor. Las apps que requieran más memoria fallarán en la evaluación dando un mensaje de error.

-

Con soporte para apps grandes: si ha adquirido la compatibilidad con apps grandes, podrá evaluar apps de hasta 50 GB utilizando motores con mayor capacidad. Para más información sobre los tamaños de app admitidos, consulte Compatibilidad con apps grandes.

-

Las tablas de anotaciones no son compatibles con la evaluación del rendimiento de la aplicación.