Examen et affinement de modèles

Une fois la première version de l'apprentissage du modèle terminée, analysez les métriques des modèles obtenues et les modèles recommandés. Si des modifications supplémentaires sont nécessaires pour affiner les modèles, vous pouvez exécuter des versions supplémentaires en utilisant l'optimisation de modèle manuelle.

Lors de l'exécution de la version d'expérimentation, vous êtes dirigé vers l'onglet Modèles dans lequel vous pouvez commencer à analyser les métriques de modèle obtenues. Vous pouvez accéder à la Vue Schéma et à la Vue Données en revenant à l'onglet Données. Il est possible d'effectuer une analyse plus granulaire dans les onglets Comparer et Analyser.

Analyse du tableau Métriques des modèles

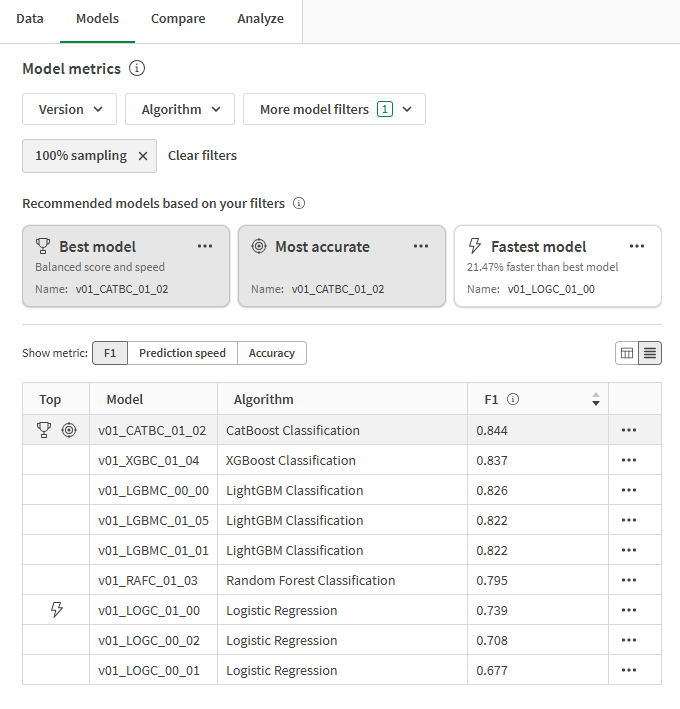

Revenez à l'onglet Modèles. Dans la section Métriques des modèles, les modèles recommandés sont mis en évidence en fonction d'exigences de qualité communes. Le meilleur modèle a été automatiquement sélectionné pour l'analyse.

Trois recommandations sont fournies par les modèles faisant l'objet d'un apprentissage dans le cadre de l'expérimentation. Un seul modèle peut être représenté dans plus d'une recommandation. Les recommandations sont les suivantes :

-

Meilleur modèle : modèle qui concilie le mieux les métriques d'exactitude et la vitesse de prédiction les plus performantes.

-

Le plus exact : modèle qui obtient le meilleur score en matière de métriques d'exactitude équilibrées et brutes.

-

Modèle le plus rapide : modèle qui offre la plus grande vitesse de prédiction, en plus d'excellentes métriques d'exactitude.

Il est important de sélectionner le modèle le mieux adapté à votre cas d'utilisation. Dans la plupart des cas, le Meilleur modèle est l'option la plus favorable. Cependant, votre cas d'utilisation prédictif peut nécessiter des spécifications particulières en matière de métriques d'exactitude ou de vitesse de prédiction.

Pour une vue d'ensemble approfondie de la manière dont les types de modèles les plus performants sont déterminés, consultez Sélection du modèle qui vous convient le mieux.

Tableau Métriques des modèles affichant les modèles recommandés et les métriques des modèles

Vous pouvez affiner votre recherche à l'aide des filtres déroulants situés au-dessus des recommandations. Les types de modèles les plus performants sont automatiquement recalculés chaque fois que vous modifiez le filtrage.

Passez d'une métrique principale à une autre à l'aide du sélecteur Afficher la métrique situé au-dessus du tableau. Vous pouvez trier les modèles en fonction du nom et de la métrique sélectionnée en cours d'analyse.

Les modèles présentant un surapprentissage sont marqués d'une icône d'avertissement dans le tableau. Ces modèles ne sont pas adaptés au déploiement. Les causes de surapprentissage peuvent inclure la complexité du modèle introduite par les algorithmes d'apprentissage et des problèmes liés au jeu de données d'apprentissage. Pour plus d'informations, consultez Surapprentissage.

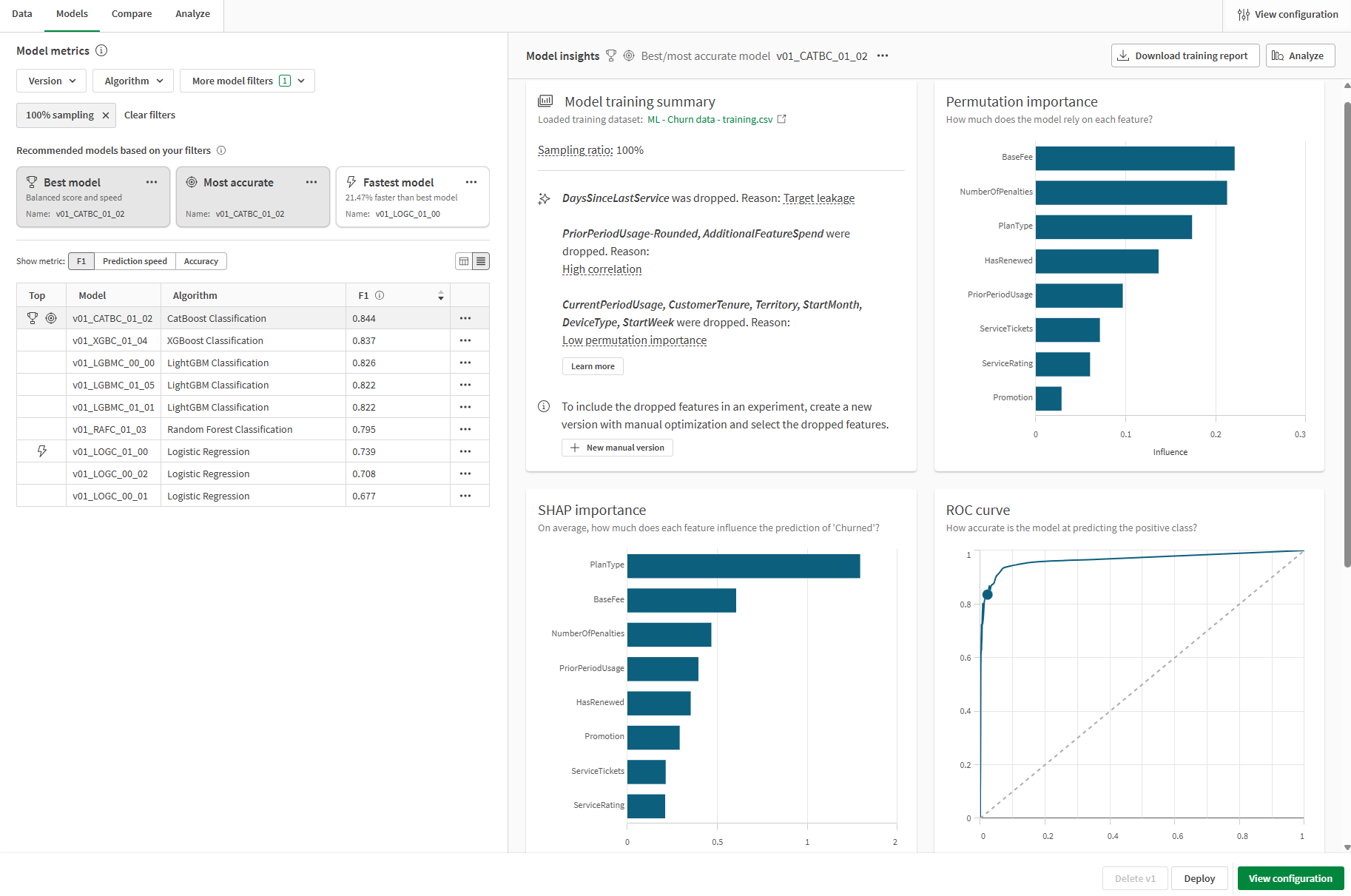

Analyse du Résumé de l'apprentissage du modèle

Nous pouvons maintenant nous concentrer sur le Résumé de l'apprentissage du modèle qui se trouve du côté droit de l'interface. Ce résumé vous permet d'explorer la manière dont le modèle et les données d'apprentissage d'entrée ont été optimisés pour obtenir les meilleures performances. Le résumé de l'apprentissage du modèle est une vue d'ensemble des améliorations apportées par l'optimisation de modèle intelligente.

D'après le résumé illustré sur l'image ci-dessous, nous pouvons voir les informations suivantes :

-

Les caractéristiques des données d'apprentissage ont été abandonnées au cours de l'apprentissage et n'ont pas été intégrées au modèle.

-

Le taux d'échantillonnage du modèle est de 100 %.

Caractéristique abandonnée en raison d'une fuite de la cible

La caractéristique DaysSinceLastService a été abandonnée lors de l'apprentissage en raison d'une fuite de la cible.

Dans la colonne de cette caractéristique, aucune logique n'a été définie lors de la collecte de données pour arrêter le comptage du nombre de jours depuis le dernier ticket de service d'un client pour les clients ayant annulé leur abonnement. En conséquence, le modèle aurait pu apprendre à associer un grand nombre de jours depuis le dernier ticket de service (présent pour les clients qui ont annulé le service il y a des années) à une valeur yes (Oui) dans le champ Churned (Perte de clientèle).

Cette caractéristique a dû être supprimée de l'apprentissage, car elle aurait donné lieu à un modèle aux performances très médiocres sur les nouvelles données.

Le problème sous-jacent est connu sous le nom de fuite de la cible, une sorte de fuite de données. Pour plus d'informations sur la fuite de données, voir Fuite de données.

Caractéristiques abandonnées en raison d'une forte corrélation

Nous pouvons constater que les caractéristiques PriorPeriodUsage-Rounded et AdditionalFeatureSpend ont été abandonnées lors de l'apprentissage.

Dans ce cas, au moins une colonne de caractéristique, PriorPeriodUsage-Rounded, était directement dérivée d'une autre colonne du jeu de données. D'autres problèmes de corrélation ont été détectés avec AdditionalFeatureSpend.

Il est important de retirer les caractéristiques qui posent des problèmes de corrélation pour effectuer l'apprentissage d'un modèle de qualité.

Pour plus d'informations sur la corrélation, consultez Corrélation.

Caractéristiques abandonnées en raison de leur faible importance

Plusieurs caractéristiques ont été également abandonnées en raison d'une faible permutation importance. Après une analyse préliminaire, ces caractéristiques ont été identifiées comme ayant un très faible impact sur les résultats de la cible. Ces caractéristiques peuvent être considérées comme des parasites et ont été retirées pour améliorer la qualité du modèle.

Pour plus d'informations sur permutation importance, consultez Familiarisation avec le concept de permutation importance.

Résumé de l'apprentissage du modèle

Analyse d'autres visualisations dans l'onglet Modèles

D'autres visualisations sont disponibles dans l'onglet Modèles pour une analyse de haut niveau supplémentaire. Sélectionnez différents modèles dans le tableau Métriques des modèles pour explorer les performances au niveau des caractéristiques ainsi que d'autres graphiques qui peuvent donner un aperçu de la qualité du modèle.

Onglet Modèles dans une expérimentation ML affichant d'autres visualisations disponibles pour l'analyse

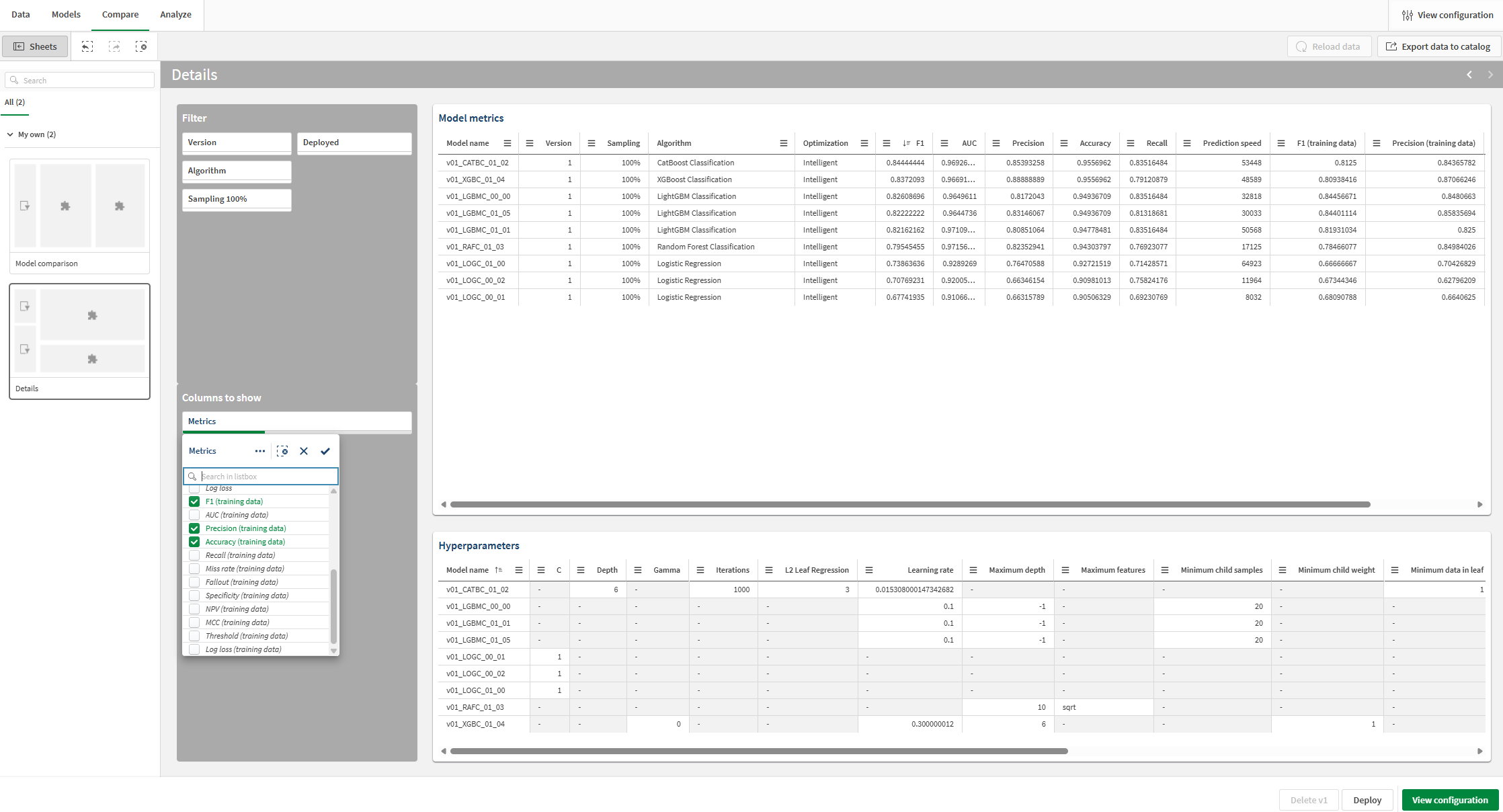

Comparaison des métriques d'apprentissage et de rétention

Vous pouvez voir des métriques supplémentaires et comparer les métriques de l'apprentissage de validation croisée aux métriques de rétention.

Procédez comme suit :

-

Dans l'expérimentation, accédez à l'onglet Comparer.

Une analyse intégrée s'ouvre. Vous pouvez utiliser l'interface interactive pour approfondir votre analyse de modèles comparative et découvrir de nouvelles informations analytiques.

-

Dans le panneau Feuilles sur le côté gauche de l'analyse, accédez à la feuille Détails.

-

Observez la visualisation Métriques des modèles. Il indique des métriques d'évaluation de modèle telles que F1 ainsi que d'autres informations.

-

Dans la section Colonnes à afficher, utilisez le volet de filtre pour ajouter des colonnes au tableau ou en retirer.

-

Dans la zone de liste déroulante, ajoutez des métriques supplémentaires. Les scores d'apprentissage sont disponibles et peuvent être ajoutés au tableau. Vous pouvez les ajouter, si nécessaire, pour votre analyse.

À présent, vous voyez les métriques F1 d'apprentissage de validation croisée et vous pouvez les comparer aux métriques de rétention.

Ajout et affichage des scores d'apprentissage pour les comparer aux scores de rétention

Concentration sur un modèle spécifique

À tout moment lors de l'analyse de modèles, vous pouvez effectuer une analyse granulaire d'un modèle individuel. Explorez l'exactitude des prédictions, l'importance des caractéristiques et la distribution des caractéristiques grâce à une expérience interactive.

Procédez comme suit :

-

Sélectionnez n'importe quel modèle et cliquez sur l'onglet Analyser.

Une analyse intégrée s'ouvre.

-

Grâce à la feuille Vue d'ensemble du modèle, vous pouvez analyser l'exactitude des prédictions du modèle. L'analyse est améliorée par la puissance des sélections. Cliquez sur une caractéristique ou une valeur prédite pour la sélectionner. Les données de l'analyse intégrée s'ajustent pour filtrer les données. Vous pouvez effectuer un zoom avant sur les valeurs et les plages d'une caractéristique spécifique pour voir dans quelle mesure elle est source d'influence et voir comment l'exactitude des prédictions change.

-

En passant aux autres feuilles, vous pouvez afficher des visualisations indiquant l'exactitude des prédictions, la distribution des caractéristiques et la distribution de l'impact (SHAP). Le contenu de ces analyses vous permet :

-

de découvrir les facteurs clés qui influencent les tendances des données ;

-

d'identifier la manière dont des caractéristiques et cohortes spécifiques affectent les valeurs prédites et l'exactitude des prédictions.

-

d'identifier les valeurs hors norme des données.

-

Onglet Analyser dans une expérimentation ML

Étapes suivantes

Après avoir exécuté une version de l'expérimentation avec l'optimisation de modèle intelligente, vous pouvez exécuter des versions manuelles, si nécessaire, pour affiner vos modèles. Pour créer rapidement une nouvelle version manuelle, vous pouvez revenir à l'onglet Modèles et cliquer sur Nouvelle version manuelle dans le Résumé de l'apprentissage du modèle.

Dans un scénario réel, il est important de répéter des étapes d'affinement autant de fois que nécessaire avant de déployer le modèle, pour être sûr d'avoir le meilleur modèle possible pour le cas d'utilisation en question.

Pour plus d'informations sur l'affinement des modèles, consultez Affinement des modèles.

Dans ce didacticiel, passez à la section suivante sur le déploiement du modèle.