Modellen herzien en verfijnen

Nadat de eerste versie van de modeltraining voltooid is, analyseert u de resulterende modelstatistieken en aanbevolen modellen. Als er verdere wijzigingen nodig zijn om de modellen te verfijnen, kunt u extra versies uitvoeren met handmatige modeloptimalisatie.

Als u de experimentversie uitvoert, wordt u naar het tabblad Modellen geleid waar u kunt starten met het analyseren van de resulterende modelstatistieken. U kunt Schemaweergave en Gegevensweergave openen door terug te gaan naar het tabblad Gegevens. U kunt een gedetailleerdere analyse uitvoeren op de tabbladen Vergelijken en Analyseren.

De tabel Modelstatistieken analyseren

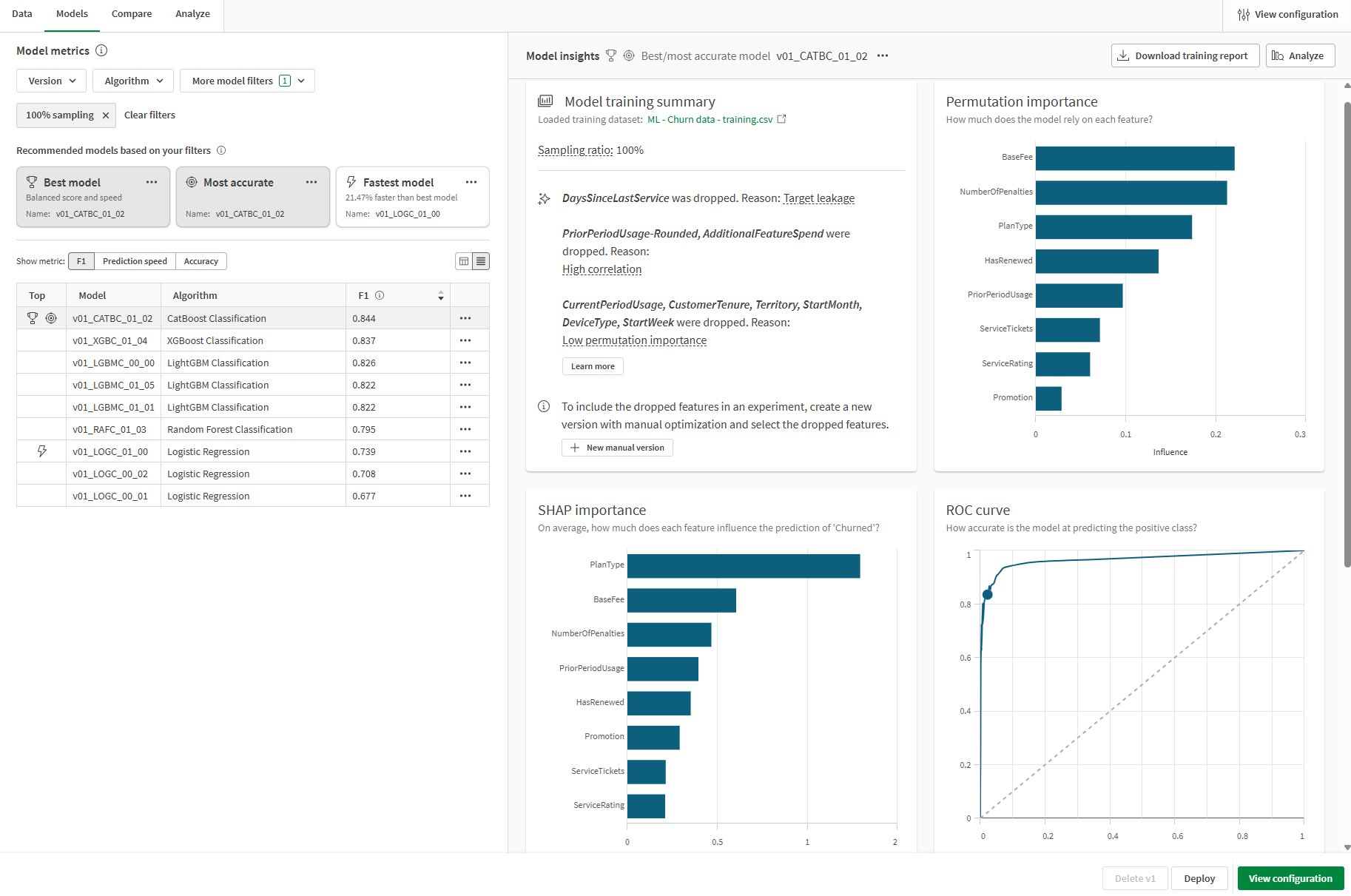

Ga terug naar het tabblad Modellen. In de sectie Modelstatistieken worden aanbevolen modellen uitgelicht op basis van gemeenschappelijke kwaliteitseisen. Het beste model is automatisch geselecteerd voor analyse.

De in het experiment getrainde modellen geven drie aanbevelingen. Een afzonderlijk model kan in meer dan één aanbeveling worden weergegeven. De aanbevelingen zijn:

-

Beste model: het model waarbij de statistieken voor nauwkeurigheid en voorspellingssnelheid het beste in evenwicht zijn.

-

Nauwkeurigst: het model scoort het hoogst op basis van evenwichtige en ruwe nauwkeurigheidscijfers.

-

Snelste model: het model heeft de snelste voorspellingssnelheid, naast sterke nauwkeurigheidsgerelateerde statistieken.

Het is belangrijk om het model te kiezen dat het meest geschikt is voor uw gebruiksscenario. In de meeste gevallen is het beste model de gunstigste optie. Uw voorspellende gebruiksscenario kan echter specifieke specificaties vereisen voor voorspellingssnelheid of nauwkeurigheid.

Zie Het beste model voor u selecteren voor een uitgebreid overzicht van hoe de topmodeltypen worden bepaald.

De tabel Modelstatistieken toont de aanbevolen modellen en modelstatistieken.

U kunt uw focus verfijnen met behulp van de vervolgkeuzefilters boven de aanbevelingen. De topmodeltypen worden automatisch opnieuw berekend telkens wanneer u de filtering wijzigt.

Schakel tussen de kernstatistieken met de kiezer Meeteenheid tonen boven de tabel. U kunt modellen sorteren op basis van naam en de geselecteerde meeteenheid die wordt geanalyseerd.

Overfitte modellen zijn in de tabel gemarkeerd met een waarschuwing . Deze modellen zijn niet geschikt voor implementatie. Oorzaken van overfitting kunnen de complexiteit van het model zijn die wordt geïntroduceerd door trainingsalgoritmen, en problemen met de trainingsgegevensverzameling. Ga voor meer informatie naar Overfitting.

Het Overzicht modeltraining analyseren

We kunnen ons nu richten op het Overzicht modeltraining aan de rechterkant van de interface. In dit overzicht kunt u zien hoe het model en de ingevoerde trainingsgegevens zijn geoptimaliseerd voor de beste prestaties. Het overzicht modeltraining is een overzicht van de verbeteringen die intelligente modeloptimalisatie biedt.

Uit het overzicht in de onderstaande afbeelding kunnen we het volgende afleiden:

-

Functies uit de trainingsgegevens zijn verwijderd tijdens de training en werden niet in het model opgenomen.

-

Het model heeft een steekproefverhouding van 100%.

Functie komt te vervallen vanwege doellek

De functie DaysSinceLastService is vervallen tijdens de training vanwege een doellek.

In deze functiekolom was er tijdens het verzamelen van gegevens geen logica vastgelegd voor het stopzetten van het tellen van het aantal dagen sinds het laatste serviceticket van klanten die hun abonnement hebben opgezegd. Daardoor kon het model leren om het grote aantal dagen sinds het laatste serviceticket (voor klanten die jaren geleden al hebben opgezegd) te associëren met een waarde van yes in het veld Churned.

Deze functie moest uit de training worden verwijderd omdat het zou hebben geleid tot een model met zeer slechte prestaties met betrekking tot nieuwe gegevens.

Dit onderliggende probleem staat bekend als een doellek, wat een vorm van een gegevenslek is. Meer informatie over het lekken van gegevens vindt u in Lekken van gegevens.

Functies vervallen vanwege hoge correlatie

We kunnen zien dat PriorPeriodUsage-Rounded en AdditionalFeatureSpend zijn vervallen tijdens de training.

In dit geval was er minstens één functiekolom—PriorPeriodUsage-Rounded—die rechtstreeks was afgeleid van een andere kolom in de gegevensverzameling. Andere problemen met correlatie werden gedetecteerd met AdditionalFeatureSpend.

Het verwijderen van functies die correlatieproblemen veroorzaken is belangrijk om een kwaliteitsmodel te trainen.

Ga voor meer informatie over correlatie naar Correlatie.

Functies die zijn vervallen omdat ze een lage urgentie hebben

Sommige functies zijn verwijderd vanwege een lage permutatie-urgentie. Na een voorlopige analyse is vastgesteld dat deze functies zeer weinig invloed hebben op de resultaten van het doel. Deze functies kunnen worden gezien als statistische ruis en zijn verwijderd om de kwaliteit van het model te verbeteren.

Zie Permutatie-urgentie begrijpen voor meer informatie over permutatie-urgentie.

Overzicht modeltraining

Andere visualisaties analyseren op het tabblad Modellen

Andere visualisaties zijn beschikbaar op het tabblad Modellen voor aanvullende analyses op hoog niveau. Selecteer verschillende modellen in de tabel Modelstatistieken om de prestaties op functieniveau en andere diagrammen te bekijken die inzicht kunnen geven in de kwaliteit van het model.

Tabblad Modellen in ML-experiment met andere visualisaties die beschikbaar zijn voor analyse

Trainings- en evaluatiegegevens vergelijken

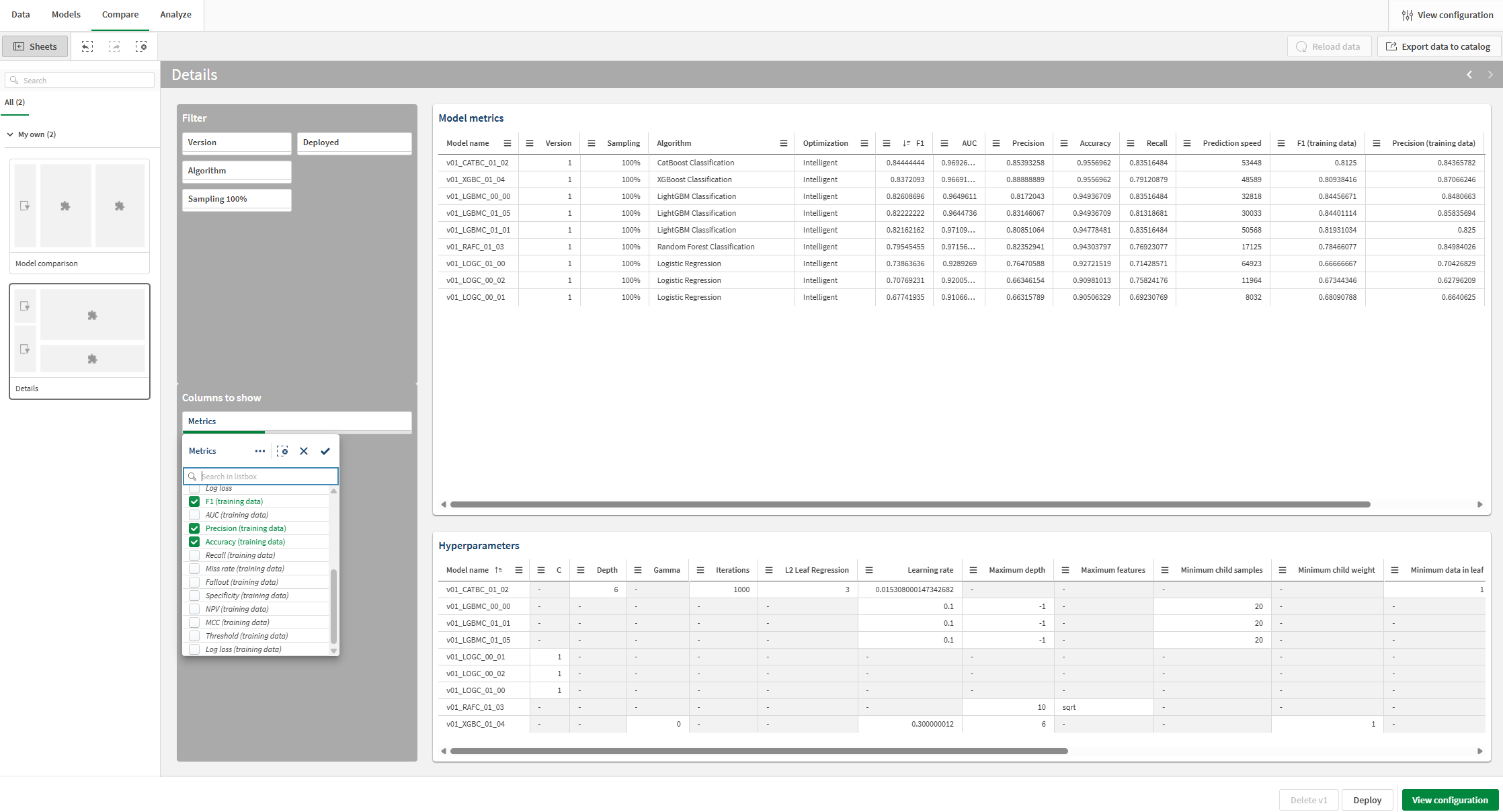

U kunt aanvullende statistieken bekijken en de statistieken van de kruisvalidatietraining en vergelijken met de evaluatiegegevens.

Doe het volgende:

-

Schakel in het experiment over naar het tabblad Vergelijken.

Er wordt een geïntegreerde analyse geopend. U kunt de interactieve interface gebruiken om dieper in te gaan op uw vergelijkende modelanalyse en nieuwe inzichten op te doen.

-

In het venster Werkbladen aan de linkerkant van de analyse gaat u naar het werkblad Details.

-

Bekijk de visualisatie Modelstatistieken. Deze toont statistieken van modelscores, zoals F1 en andere informatie.

-

Gebruik het filtervak in de sectie Weer te geven kolommen om kolommen toe te voegen of te verwijderen uit de tabel.

-

Voeg aanvullende meeteenheden toe via de vervolgkeuzelijst. Trainingsscores zijn beschikbaar om aan de tabel toegevoegd te worden. U kunt ze naar behoefte toevoegen voor uw analyse.

U kunt nu de F1-statistieken zien uit de kruisvalidatietraining en ze vergelijken met de evaluatiegegevens.

Trainingsscores toevoegen en bekijken voor vergelijking met de evaluatiescores

Focussen op een specifiek model

Op elk moment tijdens de modelanalyse kunt een diepgaande analyse uitvoeren voor een afzonderlijk model. Verken de nauwkeurigheid van voorspellingen, functie-urgentie en functieverdeling met een interactieve ervaring.

Doe het volgende:

-

Selecteer een willekeurig model en klik op het tabblad Analyseren.

Er wordt een geïntegreerde analyse geopend.

-

Met het werkblad Modeloverzicht kunt u de nauwkeurigheid van de voorspelling van het model analyseren. De analyse wordt verbeterd door middel van selecties. Klik op een functie of voorgespelde waarde om een selectie te maken. De gegevens in de geïntegreerde analyse worden aangepast om de gegevens te filteren. U kunt inzoomen op specifieke waarden en bereiken van de functie om te kijken hoe de invloed van de functie en de nauwkeurigheid van de voorspellingen veranderen.

-

Als u overschakelt naar andere werkbladen, kunt u visualisaties bekijken voor de nauwkeurigheid van de voorspelling, de verdeling van functies en verdeling van de impact (SHAP). Deze analyse-inhoud kan u helpen om:

-

Factoren te ontdekken die van invloed zijn op trends in de gegevens.

-

Identificeer hoe specifieke functies en cohorten van invloed zijn op voorspelde waarden en de nauwkeurigheid van voorspellingen.

-

Identificeer uitschieters binnen de gegevens.

-

Tabblad Analyseren in een ML-experiment

Volgende stappen

Nadat u een versie van het experiment met intelligente modeloptimalisatie hebt uitgevoerd, kunt u indien nodig handmatige versies uitvoeren om uw modellen te verfijnen. Om snel een nieuwe handmatige versie te maken, kunt u teruggaan naar het tabblad Modellen en op Nieuwe handmatige versie klikken in Overzicht modeltraining.

In de praktijk is het belangrijk om deze verfijningsstappen zo vaak als nodig uit te voeren voordat u uw model implementeert, om ervoor te zorgen dat u het best mogelijke model voor uw toepassing gebruikt.

Zie Modellen verfijnen voor meer informatie over het verfijnen van modellen.

Ga in deze tuturial naar het volgende hoofdstuk over het implementeren van uw model.