モデルのレビューと改良

モデル トレーニングの最初のバージョンが終了したら、結果のモデル メトリクスと推奨モデルを分析します。モデルを改良するためにさらなる変更が必要な場合は、手動モデル最適化を使用して追加のバージョンを実行できます。

実験バージョンを実行すると、 [モデル] タブに移動し、結果のモデル メトリクスの分析を開始できます。[データ] タブに戻ると、 [スキーマ ビュー] と [データ ビュー] にアクセスできます。より詳細な分析は、 [比較] タブと [分析] タブで実行できます。

モデル メトリクス テーブルの分析

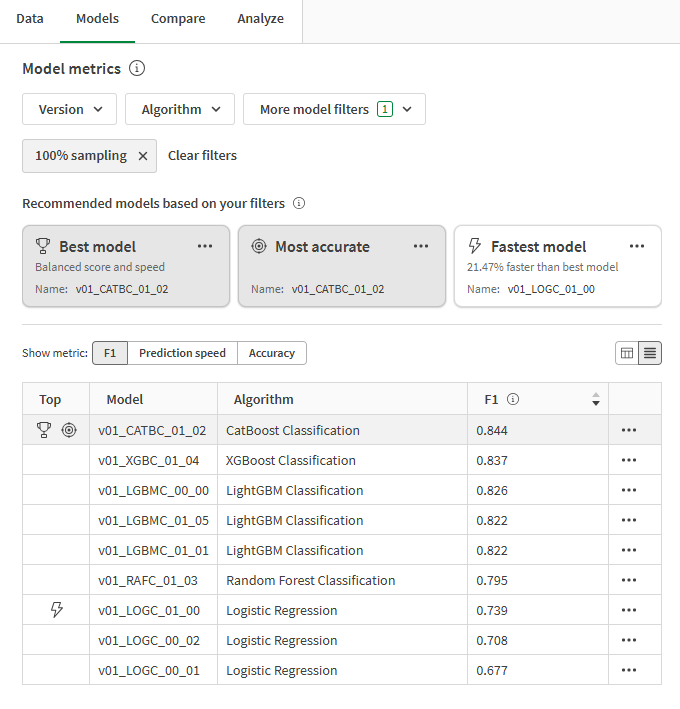

[モデル] タブに戻ります。[モデル メトリクス] セクションでは、一般的な品質要件に基づいて推奨モデルが強調表示されます。分析のベスト モデル が自動的に選択されました。

実験でトレーニングされたモデルから 3 つの推奨が提供されます。1 つのモデルが複数の推奨に含まれることもあります。推奨は次のとおりです。

-

ベスト モデル: 正確度メトリクスと予測速度のバランスが最も優れているモデル。

-

最も正確: バランスが取れた生の正確度メトリクスで最も高いスコアを記録するモデル。

-

最速モデル: 予測速度が最も速く、正確度に関するメトリクスも高いモデル。

ユース ケースに最適なモデルを選択することが重要です。ほとんどの場合、ベスト モデルが最も有効な選択肢です。ただし、予測ユース ケースでは、予測速度や正確度メトリクスに特定の仕様が必要になる場合があります。

最上位モデル タイプが決定される方法の詳細な概要については、「最適なモデルを選択する」を参照してください。

推奨モデルとモデル メトリクスを示す [モデル メトリクス] テーブル

推奨の上部にあるドロップダウン フィルターを使用して、絞り込むことができます。フィルタリングを変更するたびに、最上位モデル タイプが自動的に再計算されます。

テーブルの上部にある [メトリクスを表示] セレクターを使用して、主要なメトリクスを切り替えます。名前と分析対象の選択されたメトリクスに基づいて、モデルを並べ替えることができます。

オーバーフィット モデルには、テーブル内に警告 が付けられます。これらのモデルは展開には適していません。オーバーフィットの原因には、トレーニング アルゴリズムによって導入されたモデルの複雑さや、トレーニング データセットの問題などがあります。詳細については、「オーバーフィット」を参照してください。

モデル トレーニングの概要の分析

インターフェイスの右側にある [モデル トレーニングの概要] に注目してください。この概要では、モデルと入力トレーニング データがどのように最適化されて最高のパフォーマンスが実現されているかを確認できます。モデル トレーニングの概要は、インテリジェント モデル最適化によって提供される機能強化の概要です。

下の画像の概要から、次のことがわかります。

-

トレーニング データの特徴量はトレーニング中に削除され、モデルに組み込まれませんでした。

-

このモデルのサンプリング比率は 100% です。

ターゲット漏洩によりドロップされた特徴量

ターゲット漏洩により、トレーニング中に特徴量 DaysSinceLastService はドロップされました。

この特徴量列では、データ収集時に、サブスクリプションをキャンセルした顧客の最後のサービス チケットからの日数のカウントを停止するロジックが定義されていませんでした。その結果、最後のサービス チケットからの日数が多い (数年前にキャンセルした顧客) ことを、Churned 項目の yes の値と関連付けることをモデルは学習できた可能性があります。

この特徴量は、新しいデータに対して非常に低いパフォーマンスのモデルを生成することになるため、トレーニングから削除する必要がありました。

根本的な問題はターゲット漏洩として知られており、データ漏洩の一種です。データ漏洩に関する詳細については、データ漏洩を参照してください

相関が高いためドロップされた特徴量

トレーニング中に PriorPeriodUsage-Rounded および AdditionalFeatureSpend がドロップされたことがわかります。

この場合、データセット内の別の列から直接派生した特徴量列 (PriorPeriodUsage-Rounded) が少なくとも 1 つありました。AdditionalFeatureSpend でその他の相関の問題が検出されました。

質の高いモデルをトレーニングするためには、相関の問題を引き起こす特徴量を削除することが重要です。

相関の詳細については、「相関」を参照してください。

重要性が低いためドロップされた特徴量

Permutation Importance が低いために、いくつかの特徴量も削除されました。予備分析の結果、これらの特徴量はターゲットの成果に与える影響が非常に低いことが判明しました。これらの特徴量は統計的なノイズとみなされる可能性があり、モデルの品質を向上させるために削除されています。

Permutation Importance の詳細については、「Permutation Importance を理解する」を参照してください。

モデル トレーニングの概要

[モデル] タブでの他のビジュアライゼーションを分析する

[モデル] タブでは、さらに高度な分析を行うための、他のビジュアライゼーションも使用できます。[モデル メトリクス] テーブルで異なるモデルを選択すると、特徴量レベルでのパフォーマンスや、モデルの品質に関する情報を取得できるその他のチャートを確認できます。

分析に使用できる他のビジュアライゼーションが表示されている ML 実験の [モデル] タブ

![クリックしてフル サイズを表示 モデル分析に使用できる他のビジュアライゼーションが表示されている ML 実験の [モデル] タブ](../../Resources/Images/ui_ml-tutorial-tab_models.png)

トレーニングとホールドアウトのメトリクスを比較する

追加のメトリクスを表示し、クロス検証トレーニングとホールドアウトのメトリクスを比較できます。

次の手順を実行します。

-

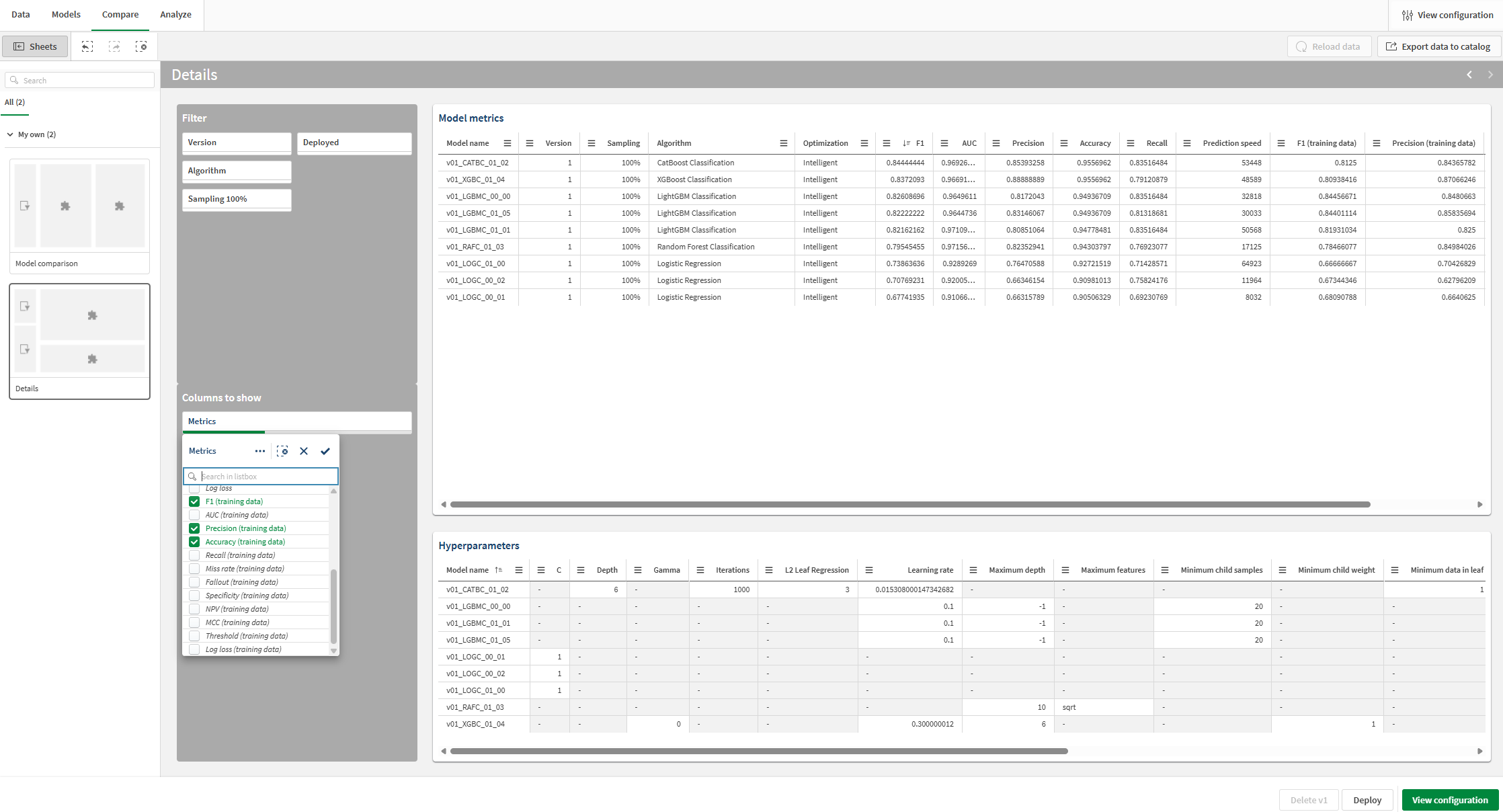

実験で、 [比較]タブに切り替えます。

組み込み型分析が開きます。インタラクティブなインターフェイスを使用すると、比較モデル分析をさらに深く掘り下げて、新たなインサイトを発見できます。

-

分析の左側にある [シート] パネルで、 [詳細] シートに切り替えます。

-

[モデル メトリクス] ビジュアライゼーションを見てください。F1 などのモデル スコアリング メトリクスやその他の情報が表示されます。

-

[表示する列] セクションでは、フィルター パネルを使用してテーブル内の列を追加および削除します。

-

ドロップダウン リスト ボックスで、追加のメトリクスを追加します。トレーニング スコアをテーブルに追加できます。分析の必要に応じて追加できます。

クロス検証トレーニングからの F1 メトリクスが表示され、ホールドアウト メトリクスと比較できるようになりました。

ホールドアウトスコアと比較するためのトレーニング スコアの追加と表示

特定のモデルに焦点を当てる

モデル分析のどの時点でも、個々のモデルの詳細な分析を実行できます。インタラクティブなエクスペリエンスを使用して、予測正確度、特徴量重要度、特徴量の分布を調べます。

次の手順を実行します。

-

いずれかのモデルを選択し、 [分析] タブをクリックします。

組み込み型分析が開きます。

-

[モデルの概要] シートを使用すると、モデルの予測正確度を分析できます。選択機能によって分析が強化されます。特徴量または予測値をクリックして選択します。組み込み型分析のデータは、データをフィルタリングするために調整されます。特定の特徴量値と範囲をドリルダウンして、特徴量の影響と予測精度がどのように変化するかを確認できます。

-

他のシートに切り替えると、予測精度、特徴量分布、影響分布 (SHAP) のビジュアライゼーションを表示できます。この分析コンテンツは、次のことに役立ちます。

-

データの傾向に影響を与える主要な要因を明らかにする。

-

特定の特徴量やコホートが予測値と予測精度にどのように影響しているかを特定する。

-

データ内の外れ値を特定する。

-

ML 実験の [分析] タブ

次のステップ

インテリジェント モデル最適化で実験のバージョンを実行した後、必要に応じて手動バージョンを実行してモデルを改良できます。新しい手動バージョンをすばやく作成するには、 [モデル] タブに戻り、 [モデル トレーニングの概要] で [新しい手動バージョン] をクリックします。

現実のシナリオでは、特定のユース ケースに最適なモデルを作成するために、モデルを展開する前に改良のステップを必要な回数繰り返すことが重要です。

モデルの改良の詳細については、「モデルの改良」を参照してください。

このチュートリアルでは、モデルの展開に関する次のセクションに移動します。