모델 검토 및 구체화

모델 교육의 첫 번째 버전이 완료된 후, 결과 모델 메트릭과 권장 모델을 분석합니다. 모델을 구체화하기 위해 추가적인 수정이 필요한 경우 수동 모델 최적화를 사용하여 추가 버전을 실행할 수 있습니다.

실험 버전을 실행하면 결과 모델 메트릭 분석을 시작할 수 있는 모델 탭으로 이동됩니다. 데이터 탭으로 돌아가서 스키마 보기 및 데이터 보기에 액세스할 수 있습니다. 더욱 세부적인 분석은 비교 및 분석 탭에서 수행할 수 있습니다.

모델 메트릭 테이블 분석

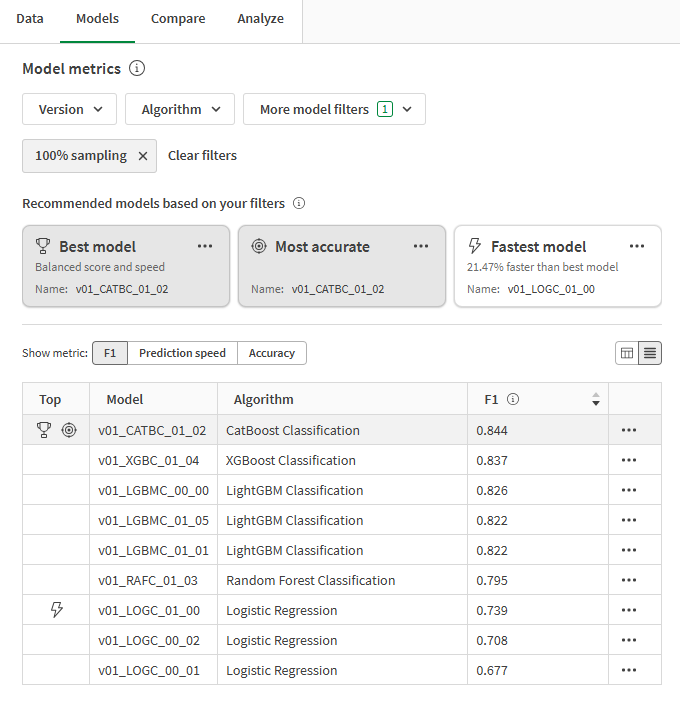

모델 탭으로 다시 전환합니다. 모델 메트릭 섹션에서는 일반적인 품질 요구 사항을 기반으로 권장 모델이 강조 표시됩니다. 분석을 위해 가장 적합한 모델 이(가) 자동으로 선택되었습니다.

실험에서 교육된 모델로부터 세 가지 권장 사항이 제공됩니다. 하나의 모델이 두 개 이상의 권장 사항으로 표현될 수 있습니다. 권장 사항은 다음과 같습니다.

-

가장 적합한 모델: 성능이 뛰어난 정확도 메트릭과 예측 속도의 균형을 가장 잘 맞추는 모델입니다.

-

가장 정확한 모델: 균형을 유지하는 정확도 메트릭과 원시 정확도 메트릭에서 가장 높은 점수를 받은 모델입니다.

-

가장 빠른 모델: 강력한 정확도 관련 메트릭 외에도 가장 빠른 예측 속도를 제공하는 모델입니다.

사용자의 사용 사례에 가장 적합한 모델을 선택해야 합니다. 대부분의 경우, 가장 적합한 모델이 가장 유리한 옵션입니다. 하지만 예측 사용 사례에는 예측 속도나 정확도 메트릭에 대한 특정 사양이 필요할 수 있습니다.

최상위 모델 유형이 결정되는 방법에 대한 자세한 개요는 사용자에게 가장 적합한 모델 선택을 참조하십시오.

권장 모델 및 모델 메트릭을 보여 주는 모델 메트릭 테이블

권장 사항 위의 드롭다운 필터를 사용하여 초점을 좁힐 수 있습니다. 필터링을 변경할 때마다 최상위 모델 유형이 자동으로 다시 계산됩니다.

테이블 위의 메트릭 표시 선택기를 사용하여 핵심 메트릭 간에 전환합니다. 모델 이름과 분석하려는 메트릭을 기준으로 모델을 정렬할 수 있습니다.

과적합된 모델은 테이블에서 경고로 표시됩니다. 이 모델은 배포에 적합하지 않습니다. 과적합의 원인으로는 교육 알고리즘으로 인해 발생하는 모델 복잡성, 교육 데이터 집합의 문제 등이 있습니다. 자세한 내용은 과적합을 참조하십시오.

모델 교육 요약 분석

이제 인터페이스 오른쪽에 있는 모델 교육 요약에 집중할 수 있습니다. 이 요약을 통해 가장 좋은 성능을 위해 모델과 입력 교육 데이터가 어떻게 최적화되었는지 살펴볼 수 있습니다. 모델 교육 요약에서는 지능형 모델 최적화를 통해 제공되는 개선 사항에 대해 간략히 설명합니다.

아래 이미지의 요약에서 다음을 확인할 수 있습니다.

-

교육 데이터의 기능이 교육 중에 삭제되었으며 모델에 통합되지 않았습니다.

-

해당 모델의 샘플링 비율은 100%입니다.

대상 유출로 인해 삭제된 기능

DaysSinceLastService 기능은 대상 유출로 인해 교육 중에 삭제되었습니다.

이 기능 열에는 구독을 취소한 고객에 대한 고객의 마지막 서비스 티켓 이후 일 수 계산을 중지하기 위해 데이터 수집 중에 정의된 논리가 없었습니다. 결과적으로 모델은 마지막 서비스 티켓(몇 년 전에 취소한 고객을 위한 선물) 이후 많은 일 수를 Churned 필드의 yes 값과 연결하는 방법을 학습했을 수 있습니다.

이 기능은 새로운 데이터에서 성능이 매우 떨어지는 모델을 만들어낼 수 있으므로 교육에서 제거해야 했습니다.

근본적인 문제는 대상 유출이라고 불리는 데이터 유출의 한 형태입니다. 데이터 유출에 대한 자세한 내용은 데이터 유출을 참조하십시오.

높은 상관 관계로 인해 삭제된 기능

교육 중에 PriorPeriodUsage-Rounded 및 AdditionalFeatureSpend가 삭제된 것을 볼 수 있습니다.

이 경우 데이터 집합의 다른 열에서 직접 파생된 적어도 하나의 기능 열(PriorPeriodUsage-Rounded)이 있었습니다. AdditionalFeatureSpend에서 다른 상관 관계 문제가 감지되었습니다.

품질 모델을 교육하려면 상관 관계 문제를 일으키는 기능을 제거해야 합니다.

상관 관계에 대한 자세한 내용은 상관 관계를 참조하십시오.

낮은 중요성으로 인해 삭제된 기능

또한 permutation importance가 낮아서 몇몇 기능이 삭제되었습니다. 예비 분석 결과, 이러한 기능은 대상의 결과에 매우 낮은 영향을 미치는 것으로 식별되었습니다. 이러한 기능은 통계적 노이즈로 볼 수 있으며, 모델 품질을 높이기 위해 제거되었습니다.

permutation importance에 대한 자세한 내용은 permutation importance 이해를 참조하십시오.

모델 교육 요약

모델 탭에서 다른 시각화 분석

추가적인 고급 분석을 위해 모델 탭에서 다른 시각화를 사용할 수 있습니다. 모델 메트릭 테이블에서 다양한 모델을 선택하여 기능 수준 성능과 모델 품질에 대한 통찰력을 제공하는 다른 차트를 살펴보십시오.

분석에 사용할 수 있는 다른 시각화를 보여 주는 ML 실험의 모델 탭

교육 및 홀드아웃 메트릭 비교

추가 메트릭을 보고 교차 유효성 검사 교육의 메트릭을 홀드아웃 메트릭과 비교할 수 있습니다.

다음과 같이 하십시오.

-

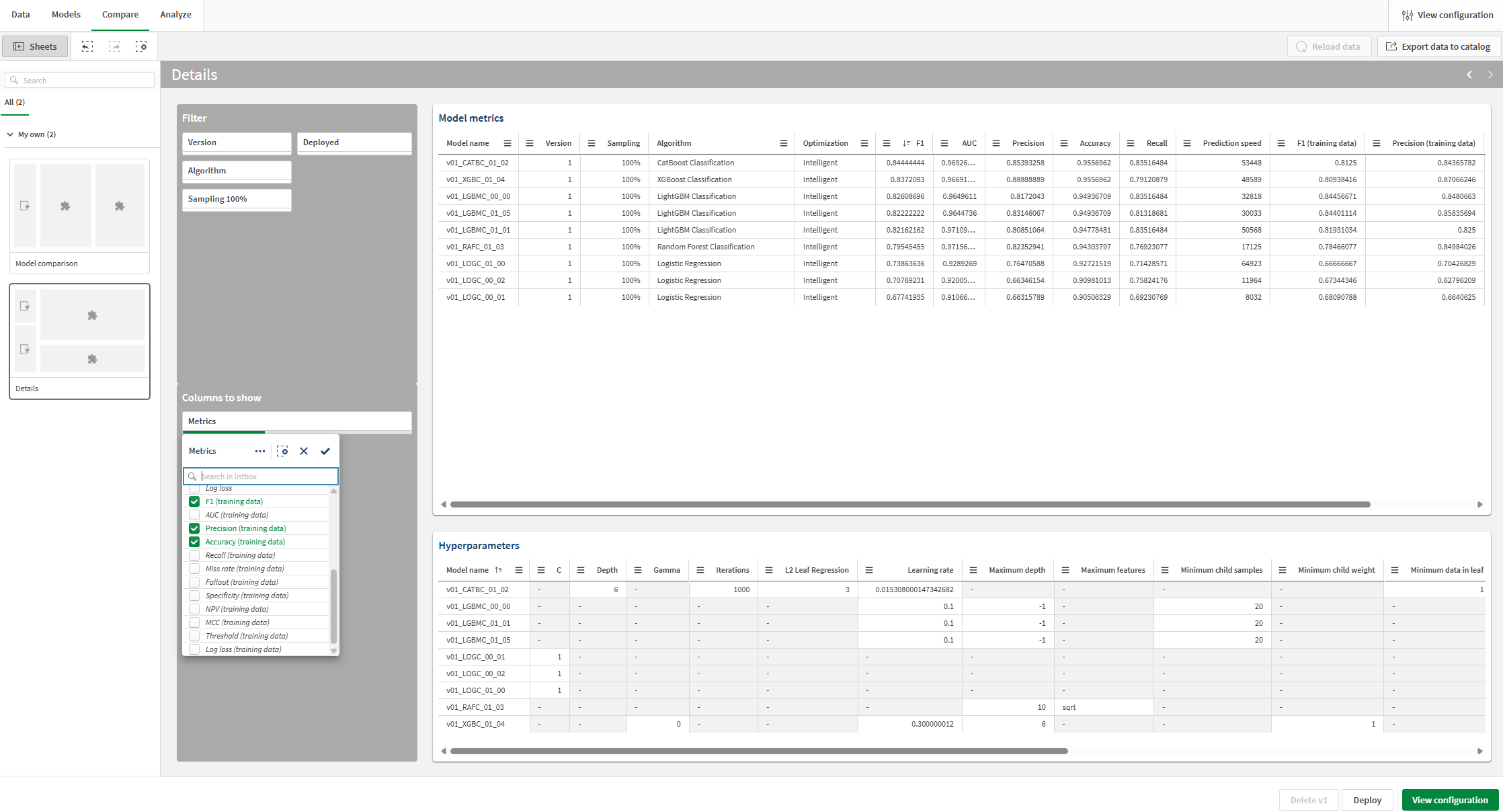

실험에서 비교 탭으로 전환합니다.

포함된 분석이 열립니다. 대화형 인터페이스를 사용하여 비교 모델 분석에 대해 더 자세히 알아보고 새로운 통찰력을 얻을 수 있습니다.

-

분석 왼쪽의 시트 패널에서 세부 정보 시트로 전환합니다.

-

모델 메트릭 시각화를 살펴봅니다. F1과 같은 모델 점수 메트릭과 기타 정보가 표시됩니다.

-

표시할 열 섹션에서 필터 창을 사용하여 표에 열을 추가하거나 제거합니다.

-

드롭다운 목록 상자에서 추가 메트릭을 추가합니다. 교육 점수를 테이블에 추가할 수 있습니다. 필요에 따라 분석에 추가할 수 있습니다.

이제 교차 유효성 검사 교육에서 F1 메트릭의 유효성을 검사하고 이를 홀드아웃 메트릭과 비교할 수 있습니다.

홀드아웃 점수와 비교하기 위해 교육 점수 추가 및 보기

특정 모델에 집중

모델 분석 중 언제든지 개별 모델에 대한 세부적인 분석을 수행할 수 있습니다. 대화형 환경을 통해 예측 정확도, 기능 중요성, 기능 분포를 살펴보십시오.

다음과 같이 하십시오.

-

모델을 선택하고 분석 탭을 클릭합니다.

포함된 분석이 열립니다.

-

모델 개요 시트를 사용하면 모델의 예측 정확도를 분석할 수 있습니다. 선택 기능을 통해 분석 기능이 향상됩니다. 기능이나 예측 값을 클릭하여 선택합니다. 포함된 분석의 데이터는 데이터 필터링을 위해 조정됩니다. 특정 기능 값과 범위를 드릴다운하여 기능이 어떻게 영향을 미치고 예측 정확도가 변경되는지 확인할 수 있습니다.

-

다른 시트로 전환하면 예측 정확도, 기능 분포 및 영향 분포(SHAP)에 대한 시각화를 볼 수 있습니다. 이 분석 콘텐츠는 다음을 수행하는 데 도움이 될 수 있습니다.

-

데이터 추세에 영향을 미치는 키 드라이버를 찾아보십시오.

-

특정 기능과 집단이 예측 값과 예측 정확도에 어떤 영향을 미치는지 식별합니다.

-

데이터의 이상값을 식별합니다.

-

ML 실험의 분석 탭

다음 단계

지능형 모델 최적화를 통해 실험 버전을 실행한 후 필요에 따라 수동 버전을 실행하여 모델을 구체화할 수 있습니다. 새로운 수동 버전을 빠르게 만들려면 모델 탭으로 돌아가서 모델 교육 요약에서 새 수동 버전을 클릭합니다.

실제 시나리오에서는 모델을 배포하기 전에 필요한 만큼 세부화 단계를 반복하여 특정 사용 사례에 가장 적합한 모델을 확보해야 합니다.

모델 구체화에 대한 자세한 내용은 모델 구체화를 참조하십시오.

이 자습서에서 모델 배포에 대한 다음 섹션으로 이동합니다.