Przeglądanie i ulepszanie modeli

Po zakończeniu pierwszej wersji uczenia modelu należy przeanalizować wynikowe wskaźniki modelu i zalecane modele. Jeśli wymagane są dalsze modyfikacje w celu udoskonalenia modeli, można uruchomić dodatkowe wersje przy użyciu ręcznej optymalizacji modelu.

Po uruchomieniu wersji eksperymentu nastąpi przejście do karty Modele, na której możesz przeanalizować wynikowe wskaźniki modelu. Dostęp do Widoku schematu i Widoku danych można uzyskać po powrocie do karty Dane. Bardziej szczegółową analizę można przeprowadzić na kartach Porównaj i Analizuj.

Analiza tabeli Wskaźniki modelu

Wróć do karty Modele. W sekcji Wskaźniki modelu, zalecane modele są wyróżnione na podstawie wspólnych wymagań jakościowych. Najlepszy model został wybrany automatycznie do analizy.

Na podstawie modeli nauczonych w eksperymencie przedstawiono trzy rekomendacje. Pojedynczy model może być reprezentowany przez więcej niż jedną rekomendację. Są to następujące rekomendacje:

-

Najlepszy model: model najlepiej równoważący najlepsze wskaźniki dokładności i szybkości przewidywania.

-

Największa dokładność: model uzyskuje najwyższe wyniki w zrównoważonych i surowych wskaźnikach dokładności.

-

Najszybszy model: model ma największą szybkość przewidywania oraz dobre wskaźniki związane z dokładnością.

Ważne jest, aby wybrać model, który najlepiej pasuje do danego zastosowania. W większości przypadków Najlepszy model jest najkorzystniejszą opcją. Dane zastosowanie predykcyjne może jednak wymagać określonych parametrów szybkości przewidywania lub dokładności.

Szczegółowy przegląd sposobu określania najlepszych typów modeli można znaleźć na stronie Wybór najlepszego modelu dla siebie.

Tabela Wskaźniki modelu przedstawiająca polecane modele i ich wskaźniki.

Możesz zawęzić obszar zainteresowania za pomocą rozwijanych filtrów nad rekomendacjami. Najlepsze typy modeli są automatycznie przeliczane przy każdej zmianie filtrowania.

Podstawowe wskaźniki można przełączać selektorem Pokaż wskaźnik nad tabelą. Modele można sortować na podstawie nazwy i wybranego analizowanego wskaźnika.

Modele przetrenowane są oznaczone w tabeli ostrzeżeniem . Modele te nie nadają się do wdrożenia. Przyczyny nadmiernego dopasowania mogą obejmować złożoność modelu wprowadzoną przez algorytmy uczenia oraz problemy z zestawem danych do uczenia. Więcej informacji zawiera temat Przetrenowanie.

Analiza podsumowania uczenia modelu

Możemy teraz skupić się na Podsumowaniu uczenia modelu po prawej stronie interfejsu. To podsumowanie pozwala sprawdzić, jak model i wejściowe dane szkoleniowe zostały zoptymalizowane pod kątem najlepszej wydajności. Podsumowanie uczenia modelu to przegląd ulepszeń zapewnianych przez inteligentną optymalizację modelu.

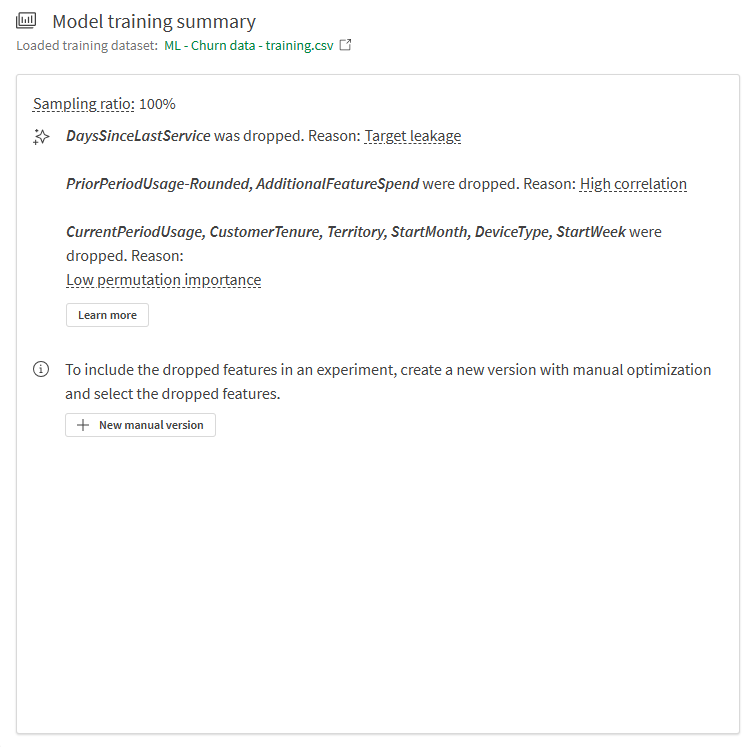

W podsumowaniu na poniższej ilustracji możemy zobaczyć:

-

Cechy z danych do uczenia zostały odrzucone podczas uczenia i nie zostały włączone do modelu.

-

Współczynnik próbkowania modelu wynosi 100%.

Cecha porzucona z powodu wycieku celu

Cecha DaysSinceLastService została usunięta podczas uczenia z powodu wycieku celu.

W tej kolumnie cechy nie zdefiniowano żadnej logiki podczas gromadzenia danych, aby zatrzymać zliczanie dni od ostatniego zgłoszenia serwisowego w przypadku klientów, którzy anulowali subskrypcję. W rezultacie model mógł się nauczyć kojarzyć dużą liczbę dni od ostatniego zgłoszenia serwisowego (występującą w przypadku klientów, którzy zrezygnowali wiele lat temu) z wartością yes w polu Churned.

Ta cecha musiała zostać usunięta z uczenia, ponieważ powodowałaby bardzo słabą wydajność modelu na nowych danych.

Występujący tu problem zasadniczy nazywa się wyciekiem danych celu i jest formą wycieku danych. Aby uzyskać więcej informacji na temat wycieku danych, zobacz Wyciek danych.

Cechy odrzucone z powodu wysokiej korelacji

Widzimy, że PriorPeriodUsage-Rounded i AdditionalFeatureSpend zostały porzucone podczas uczenia.

W tym przypadku istniała co najmniej jedna kolumna z cechami — PriorPeriodUsage-Rounded — która pochodziła bezpośrednio z innej kolumny w zestawie danych. Inne problemy związane z korelacją zostały wykryte w AdditionalFeatureSpend.

Usunięcie cech powodujących problemy z korelacją jest ważne dla nauczenia modelu wysokiej jakości.

Więcej informacji o korelacji zawiera temat Korelacja.

Cechy odrzucone z powodu niskiej ważności

Kilka cech zostało usuniętych ze względu na niską ważność permutacji. Po wstępnej analizie cechy te zostały zidentyfikowane jako mające bardzo mały wpływ na wyniki celu. Cechy te mogą być postrzegane jako szum statystyczny i zostały usunięte w celu uzyskania korzyści dla jakości modelu.

Więcej informacji na temat ważności permutacji zawiera temat Omówienie ważności permutacji.

Podsumowanie uczenia modelu

Analizowanie innych wizualizacji na karcie Modele

Inne wizualizacje są dostępne w zakładce Modele do dodatkowej analizy wysokiego poziomu. Wybierz różne modele w tabeli Wskaźniki modelu, aby zapoznać się z wydajnością na poziomie cech i innymi wykresami, które mogą zapewnić wgląd w jakość modelu.

Karta Modele w eksperymencie uczenia maszynowego pokazująca inne wizualizacje dostępne do analizy

Porównanie wskaźników uczenia i wstrzymania

Możesz zobaczyć dodatkowe wskaźniki i porównać wskaźniki z uczenia z walidacją krzyżową ze wskaźnikami danych wstrzymania.

Wykonaj następujące czynności:

-

W eksperymencie przejdź na kartę Porównaj.

Zostanie otwarta osadzona analiza. Możesz skorzystać z interaktywnego interfejsu, aby bardziej zagłębić się w analizę porównawczą modelu i odkryć nowe wnioski.

-

W panelu Arkusze po lewej stronie analizy przejdź do arkusza Szczegóły.

-

Spójrz na wizualizację Wskaźniki modelu. Pokazuje wskaźniki oceny modelu, takie jak F1, a także inne informacje.

-

W sekcji Kolumny do wyświetlenia użyj panelu filtrowania, aby dodawać i usuwać kolumny w tabeli.

-

Na liście rozwijanej dodaj dodatkowe wskaźniki. Wyniki uczenia można dodać do tabeli. Można je dodawać w zależności od potrzeb związanych z analizą.

Możesz teraz zobaczyć wskaźniki F1 z uczenia z walidacją krzyżową i porównać je ze wskaźnikami danych wstrzymania.

Dodawanie i przeglądanie wyników danych do uczenia w celu porównania z wynikami danych wstrzymania

Koncentracja na konkretnym modelu

W dowolnym momencie analizy modelu można przeprowadzić szczegółową analizę pojedynczego modelu. Interaktywne funkcje umożliwiają przeglądanie dokładności predykcji, ważności cech i rozkładu cech.

Wykonaj następujące czynności:

-

Wybierz dowolny model i kliknij kartę Analizuj.

Zostanie otwarta osadzona analiza.

-

Za pomocą arkusza Przegląd modelu można analizować dokładność predykcji modelu. Analizę ulepsza się przy użyciu wyborów. Kliknij cechę lub przewidywaną wartość, aby dokonać wyboru. Dane we wbudowanej analizie dostosowują się w celu filtrowania danych. Można drążyć określone wartości i zakresy cech, aby zobaczyć, jak zmienia się wpływ cech i dokładność predykcji.

-

Po przełączeniu na inne arkusze można przeglądać wizualizacje dotyczące dokładności predykcji, rozkładu cech i rozkładu wpływu (SHAP). Te treści analityczne mogą pomóc w wykonywaniu następujących zadań:

-

Odkrywanie kluczowych czynników wpływających na trendy w danych.

-

Identyfikacja, jak określone cechy i kohorty wpływają na przewidywane wartości i dokładność predykcji.

-

Identyfikacja wartości odstających w danych.

-

Karta Analizuj w eksperymencie uczenia maszynowego

Następne kroki

Po uruchomieniu wersji eksperymentu z inteligentną optymalizacją modelu można w razie potrzeby uruchomić wersje ręczne, aby udoskonalić modele. Aby szybko utworzyć nową wersję ręczną, można wrócić do karty Modele i kliknąć Nowa wersja ręczna w Podsumowaniu uczenia modelu.

W warunkach rzeczywistych ważne jest, aby przed wdrożeniem modelu powtórzyć kroki ulepszania tyle razy, ile potrzeba, by mieć pewność, że ma się najlepszy możliwy model do konkretnego zastosowania.

Więcej informacji o ulepszaniu modeli zawiera temat Ulepszanie modeli.

W tym kursie przejdź do następnej sekcji dotyczącej wdrażania modelu.