Revisando e refinando modelos

Após a conclusão da primeira versão do treinamento do modelo, analise as métricas do modelo resultante e os modelos recomendados. Se forem necessárias outras modificações para refinar os modelos, você pode executar versões adicionais usando a otimização manual de modelo.

Ao executar a versão experimental, você será levado para a guia Modelos, onde poderá começar a analisar as métricas do modelo resultante. Você pode acessar a Exibição de esquema e a Exibição de dados retornando à guia Dados. Uma análise mais granular pode ser realizada nas guias Comparar e Analisar.

Analisando a tabela Métricas de modelo

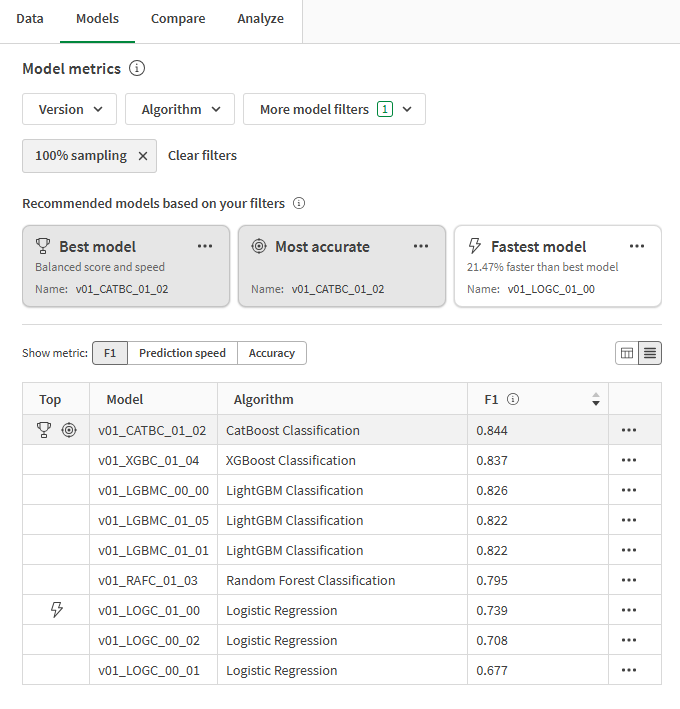

Volte para a guia Modelos. Na seção Métricas de modelo, os modelos recomendados são destacados com base nos requisitos comuns de qualidade. O melhor modelo foi selecionado automaticamente para análise.

Três recomendações são fornecidas pelos modelos treinados no experimento. Um único modelo pode ser representado em mais de uma recomendação. As recomendações são:

-

Melhor modelo: o modelo que melhor equilibra as métricas de acurácia de alto desempenho e a velocidade de previsão.

-

Mais preciso: o modelo tem a pontuação mais alta nas métricas de acurácia balanceada e bruta.

-

Modelo mais rápido: o modelo que tem a velocidade de previsão mais rápida, além de métricas fortes relacionadas à acurácia.

É importante escolher o modelo mais adequado ao seu caso de uso. Na maioria dos casos, o Melhor modelo é a opção mais favorável. No entanto, seu caso de uso preditivo pode exigir especificações particulares para métricas de velocidade ou acurácia de previsão.

Para obter uma visão geral detalhada de como os tipos de modelo principal são determinados, consulte Selecionando o melhor modelo para você.

Tabela Métricas de modelo mostrando modelos recomendados e métricas de modelo

Você pode restringir seu foco usando os filtros suspensos acima das recomendações. Os tipos de modelo principal são recalculados automaticamente sempre que o senhor altera a filtragem.

Alterne entre as métricas principais usando o seletor Mostrar métrica acima da tabela. Você pode classificar os modelos com base no nome e na métrica selecionada que está sendo analisada.

Os modelos com sobreajuste são marcados com um aviso na tabela. Esses modelos não são adequados para implementação. As causas do sobreajuste podem incluir a complexidade do modelo introduzida pelos algoritmos de treinamento e problemas com o conjunto de dados de treinamento. Para obter mais informações, consulte Sobreajuste.

Analisando o Resumo do treinamento de modelo

Agora podemos nos concentrar no Resumo do treinamento de modelo no lado direito da interface. Esse resumo permite que você explore como o modelo e os dados de treinamento de entrada foram otimizados para obter o melhor desempenho. O resumo do treinamento de modelo é uma visão geral dos aprimoramentos fornecidos pela otimização de modelo inteligente.

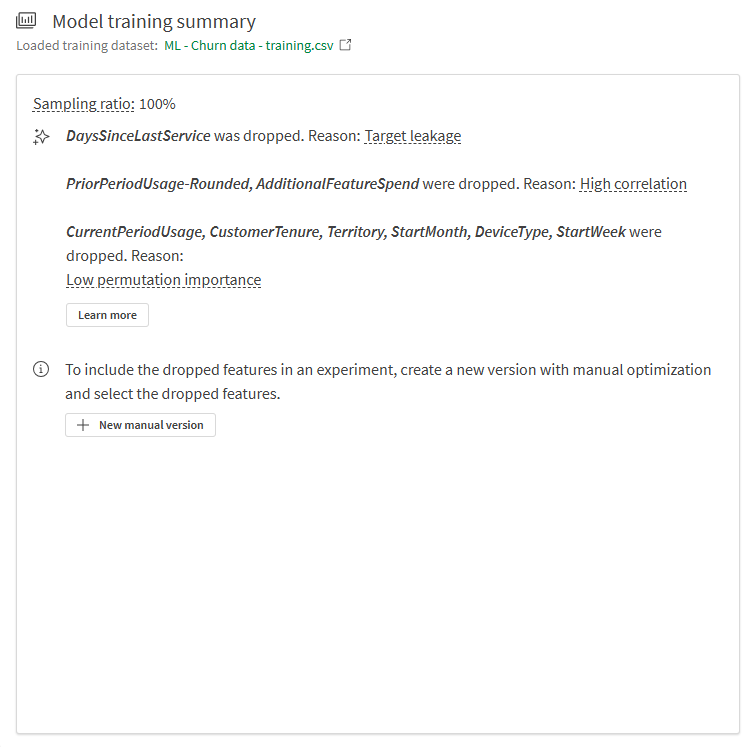

A partir do resumo na imagem abaixo, podemos ver:

-

Os recursos dos dados de treinamento foram descartados durante o treinamento e não foram incorporados ao modelo.

-

O modelo tem uma taxa de amostragem de 100%.

Recurso eliminado devido a vazamento de destino

O recurso DaysSinceLastService foi descartado durante o treinamento devido ao vazamento do destino.

Nesse coluna de recurso, não havia uma lógica definida durante a coleta de dados para interromper a contagem do número de dias desde o último tíquete de atendimento de um cliente para clientes que cancelaram sua assinatura. Como resultado, o modelo poderia ter aprendido a associar vários dias desde o último tíquete de serviço (presente para clientes que cancelaram anos atrás) com um valor de yes no campo Churned.

Esse recurso precisou ser descartado do treinamento porque teria resultado em um modelo com desempenho muito ruim em novos dados.

O problema subjacente é conhecido como vazamento de destino, que é uma forma de vazamento de dados. Para obter mais informações sobre vazamento de dados, consulte Vazamento de dados.

Recursos descartados devido a alta correlação

Podemos ver que PriorPeriodUsage-Rounded e AdditionalFeatureSpend foram descartados durante o treinamento.

Nesse caso, havia pelo menos uma coluna de recurso — PriorPeriodUsage-Rounded — que foi derivada diretamente de outra coluna no conjunto de dados. Outros problemas de correlação foram detectados em AdditionalFeatureSpend.

A remoção de recursos que causam problemas de correlação é importante para treinar um modelo de qualidade.

Para obter mais informações sobre correlação, consulte Correlação.

Recursos descartados devido a baixa importância

Vários recursos também foram descartados devido à baixa importância da permutação. Após análise preliminar, esses recursos foram identificados como tendo impacto muito baixo nos resultados do destino. Esses recursos podem ser vistos como ruído estatístico e foram removidos para gerar benefícios para a qualidade do modelo.

Para obter mais informações sobre a importância de permutação, consulte Entendendo a importância da permutação.

Resumo do treinamento de modelo

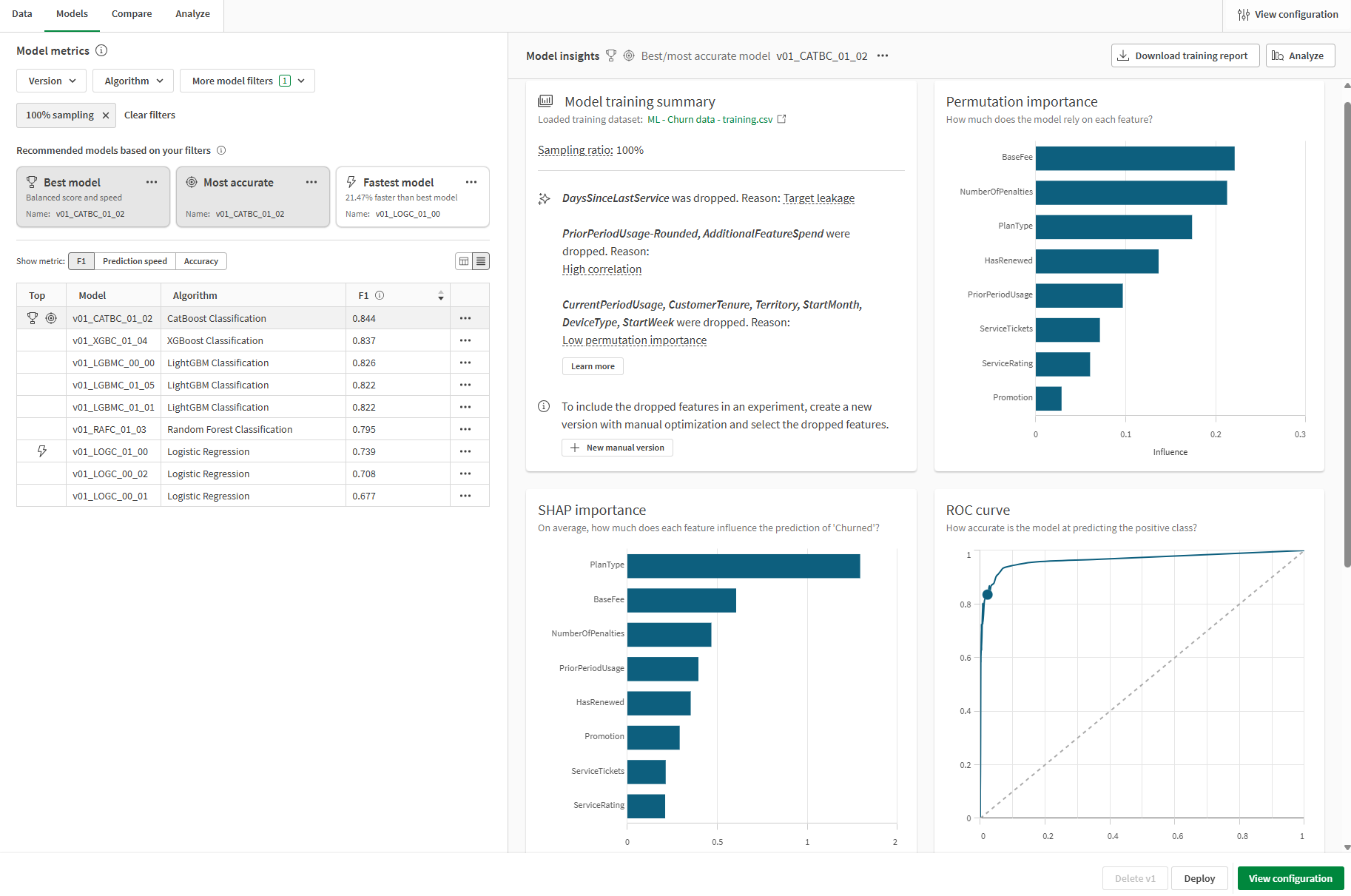

Analisando outras visualizações na guia Modelos

Outras visualizações estão disponíveis na guia Modelos para análise adicional de alto nível. Selecione modelos diferentes na tabela Métricas de modelo para explorar o desempenho em nível de recurso e outros gráficos que podem oferecer informações sobre a qualidade do modelo.

Guia Modelos no experimento de ML mostrando outras visualizações disponíveis para análise

Comparando métricas de treinamento e retenção

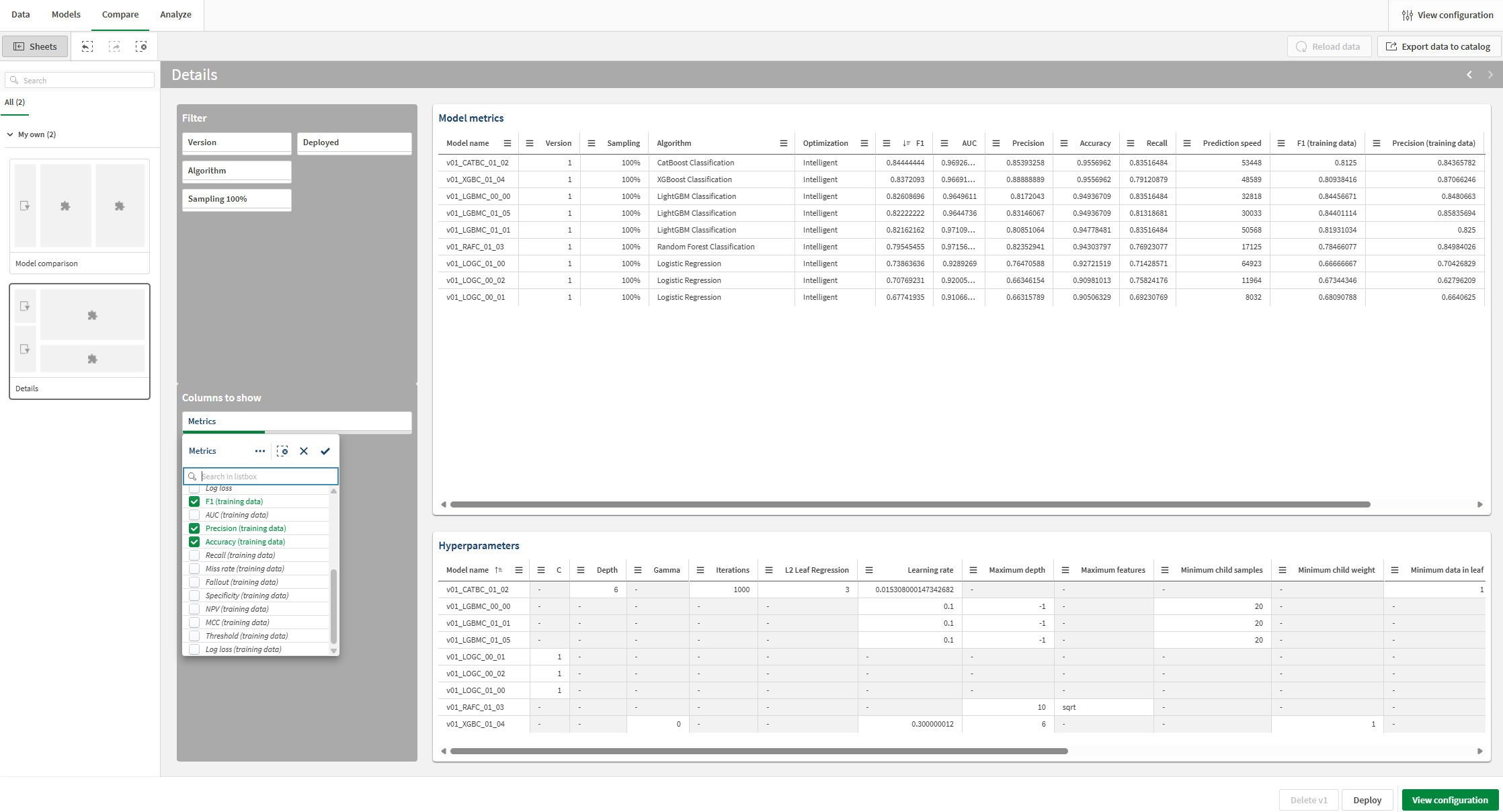

Você pode visualizar métricas adicionais e comparar as métricas do treinamento de validação cruzada com as métricas de retenção.

Faça o seguinte:

-

No experimento, alterne para a guia Comparar.

Uma análise integrada é aberta. Você pode usar a interface interativa para detalhar a análise do seu modelo comparativo e descobrir novas ideias.

-

No painel Pastas no lado esquerdo da análise, alterne para a pasta Detalhes.

-

Veja a visualização Métricas de modelo. Ela mostra métricas de pontuação do modelo, como F1, bem como outras informações.

-

Na seção Colunas para mostrar, use o painel de filtro para adicionar e remover colunas na tabela.

-

Na caixa de listagem suspensa, adicione métricas adicionais. Pontuações de treinamento estão disponíveis para serem adicionadas à tabela. Você pode adicioná-las conforme necessário para sua análise.

Agora você pode ver as métricas F1 do treinamento de validação cruzada e compará-las com as métricas de retenção.

Adicionando e exibindo pontuações de treinamento para comparação com as pontuações de retenção

Focando em um modelo específico

A qualquer momento durante a análise do modelo, você pode executar uma análise granular de um modelo individual. Explore a acurácia da previsão, a importância do recurso e a distribuição do recurso com uma experiência interativa.

Faça o seguinte:

-

Selecione qualquer modelo e clique na guia Analisar.

Uma análise integrada é aberta.

-

Com a pasta Visão geral do modelo, você pode analisar a acurácia de previsão do modelo. A análise é aprimorada pelo poder das seleções. Clique em um recurso ou valor previsto para fazer uma seleção. Os dados na análise integrada se ajustam para filtrar os dados. Você pode detalhar valores e intervalos de recursos específicos para visualizar como a influência do recurso e a acurácia da previsão mudam.

-

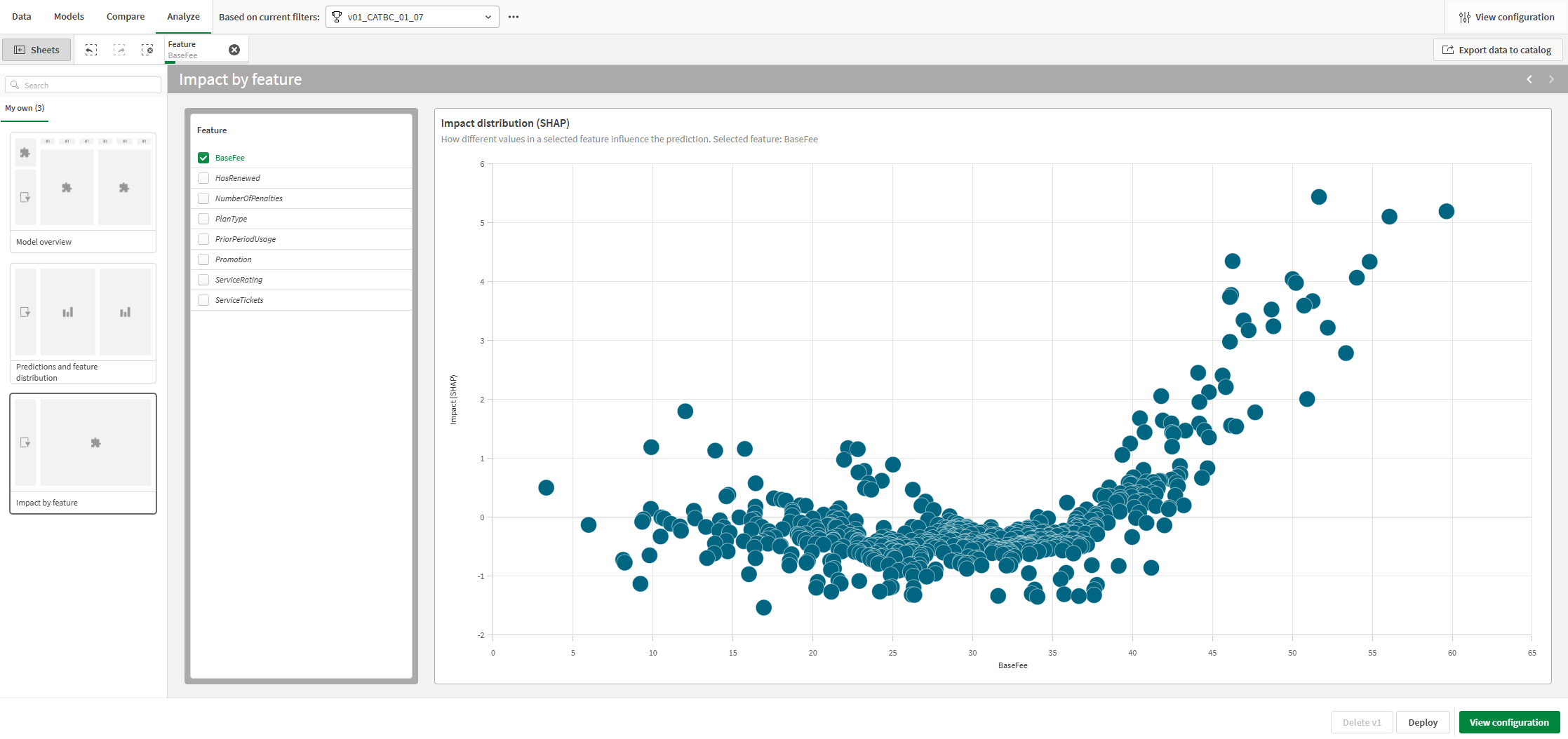

Ao alternar para as outras pastas, você pode visualizar visualizações para acurácia da previsão, distribuição de recursos e distribuição de impacto (SHAP). Este conteúdo analítico pode ajudar você a:

-

Descobrir os determinantes chave que influenciam as tendências nos dados.

-

Identificar como recursos e coortes específicos estão afetando os valores previstos e a acurácia da previsão.

-

Identificar discrepâncias nos dados.

-

Guia Analisar em um experimento de ML

Próximas etapas

Depois de executar uma versão do experimento com otimização de modelo inteligente, você pode executar versões manuais conforme necessário para refinar seus modelos. Para criar rapidamente uma nova versão do manual, você pode voltar à guia Modelos e clicar em Nova versão do manual no Resumo do treinamento de modelo.

Em um cenário real, é importante repetir essas etapas de refinamento quantas vezes forem necessárias antes de implementar seu modelo, para garantir que você tenha o melhor modelo possível para seu caso de uso específico.

Para obter mais informações sobre como refinar modelos, consulte Refinando modelos.

Neste tutorial, acesse para a próxima seção sobre como implementar seu modelo.