Revisione e perfezionamento dei modelli

Una volta terminata la prima versione dell'addestramento del modello, analizzare le metriche del modello risultanti e i modelli consigliati. Se sono necessarie ulteriori modifiche per perfezionare i modelli, è possibile eseguire ulteriori versioni utilizzando l'ottimizzazione manuale del modello.

Quando si esegue la versione dell'esperimento, si apre la scheda Modelli, dove è possibile iniziare ad analizzare le metriche del modello risultante. È possibile accedere a Vista schema e Vista dati tornando alla scheda Dati. È possibile eseguire un'analisi più granulare nelle schede Confronta e Analizza.

Analisi della tabella Metriche modello

Tornare alla scheda Modelli. Nella sezione Metriche modello, i modelli consigliati sono evidenziati in base ai requisiti di qualità comuni. Il miglior modello è stato selezionato automaticamente per l'analisi.

I modelli addestrati nell'esperimento forniscono tre raccomandazioni. Un singolo modello può essere rappresentato in più di una raccomandazione. Le raccomandazioni sono:

-

Modello migliore: il modello che bilancia meglio le metriche di accuratezza e la velocità di previsione.

-

Più preciso: il modello ottiene il punteggio più alto nelle metriche di accuratezza bilanciata e non elaborata.

-

Modello più veloce: il modello ha la velocità di previsione più elevata, oltre a metriche di accuratezza precise.

È importante scegliere il modello più adatto per il proprio caso d'uso. Nella maggior parte dei casi, il Modello migliore è l'opzione più appropriato. Tuttavia, il proprio caso d'uso predittivo potrebbe richiedere specifiche particolari per la velocità di previsione o le metriche di accuratezza.

Per una panoramica approfondita su come vengono determinati i tipi di modelli migliori, consultare Selezione del modello migliore per i propri casi d'uso.

La tabella Metriche modello che mostra i modelli raccomandati e le metriche del modello

È possibile restringere l'attenzione utilizzando i filtri a discesa sopra le raccomandazioni. I tipi di modello principali vengono ricalcolati automaticamente ogni volta che si cambiano i filtri.

Passare da una metrica chiave all'altra utilizzando il selettore Mostra metrica sopra la tabella. È possibile ordinare i modelli in base al nome e alla metrica selezionata da analizzare.

I modelli con overfitting sono contrassegnati da un avviso nella tabella. Questi modelli non sono adatti per la distribuzione. Le cause dell'overfitting possono includere la complessità del modello introdotta dagli algoritmi di addestramento e problemi con il training set. Per ulteriori informazioni, vedere Sovradattamento.

Analisi del Riepilogo addestramento modello

Ora è possibile concentrarsi sul Riepilogo addestramento modello sul lato destro dell'interfaccia. Questo riepilogo permette di esplorare il modo in cui il modello e i dati di input per l'addestramento sono stati ottimizzati per fornire le prestazioni migliori. Il riepilogo dell'addestramento del modello è una panoramica dei miglioramenti forniti dall'ottimizzazione intelligente del modello.

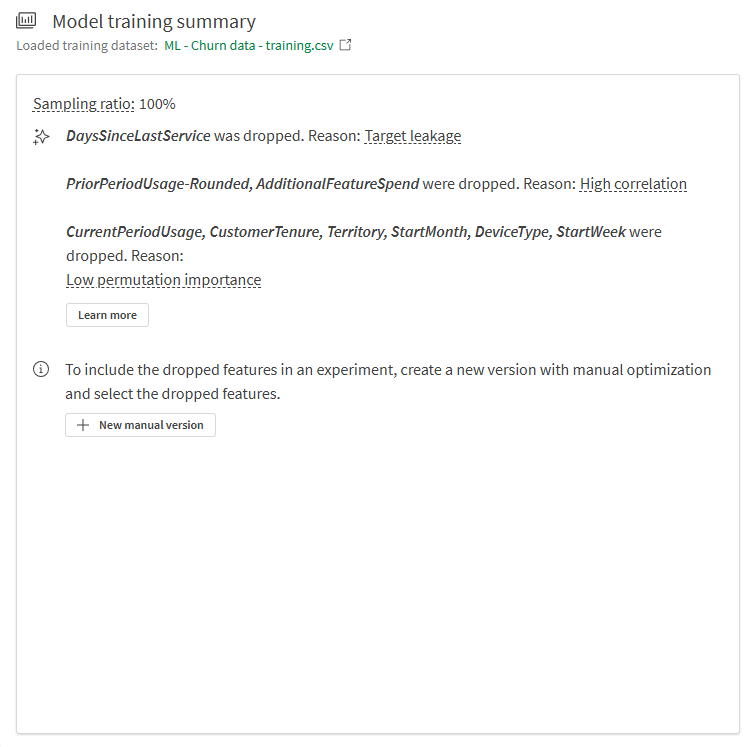

Dal riepilogo nell'immagine sottostante, è possibile vedere i seguenti elementi:

-

Le funzioni dei dati di addestramento sono state eliminate durante l'addestramento e non sono state incorporate nel modello.

-

Il modello ha un rapporto di campionamento del 100%.

Funzione scartata a causa della perdita di dati

La funzione DaysSinceLastService è stata scartata durante l'addestramento a causa della perdita di dati.

Nella colonna di questa funzione, non è stata definita una logica durante la raccolta dei dati per interrompere il conteggio del numero di giorni dall'ultimo ticket di assistenza per i clienti che hanno cancellato la sottoscrizione. Di conseguenza, il modello potrebbe aver appreso ad associare un numero elevato di giorni dall'ultimo ticket di assistenza (presente per i clienti che hanno annullato l'abbonamento anni prima) con valore yes nel campo Churned.

Questa funzione doveva essere rimossa dall'addestramento, perché avrebbe portato a un modello con prestazioni molto scarse sui nuovi dati.

Questo problema è noto come perdita nella destinazione, una forma di perdita di dati. Per ulteriori informazioni sulla perdita di dati, vedere Perdita di dati.

Funzioni rimosse a causa dell'elevata correlazione

È possibile vedere che PriorPeriodUsage-Rounded e AdditionalFeatureSpend sono state rimosse durante l'addestramento.

In questo caso, c'era almeno una colonna della funzione, PriorPeriodUsage-Rounded, che derivava direttamente da un'altra colonna nel set di dati. Altri problemi di correlazione sono stati rilevati in AdditionalFeatureSpend.

La rimozione delle funzioni che causano problemi di correlazione è importante per addestrare un modello di qualità.

Per maggiori informazioni sulla correlazione, vedere Correlazione.

Funzioni eliminate a causa della scarsa importanza

Anche diverse altre funzioni sono state eliminate a causa della bassa importanza di permutazione. Dopo un'analisi preliminare, queste funzioni sono state identificate come aventi un impatto molto basso sui risultati della destinazione. Queste funzioni possono essere considerate come rumore statistico e sono state rimosse per ottenere vantaggi sulla qualità del modello.

Per maggiori informazioni sull'importanza della permutazione, vedere Nozioni sull'importanza della permutazione.

Riepilogo addestramento modello

Analisi di altre visualizzazioni nella scheda Modelli

Altre visualizzazioni sono disponibili nella scheda Modelli per un'ulteriore analisi di alto livello. Selezionare diversi modelli nella tabella Metriche modello per esplorare le prestazioni a livello di funzioni e altri grafici che possono offrire una visione della qualità del modello.

La scheda Modelli nell'esperimento di ML mostra altre visualizzazioni disponibili per l'analisi.

Confronto dell'addestramento e metriche di controllo automatico

Ora è possibile visualizzare ulteriori metriche e confrontare le metriche dall'addestramento della convalida incrociata con quelle di controllo automatico.

Procedere come indicato di seguito:

-

Nell'esperimento, passare alla scheda Confronta.

Viene visualizzata un'analisi incorporata. È possibile utilizzare l'interfaccia interattiva un esame più approfondito dell'analisi del modello comparativo e scoprire nuove informazioni strategiche.

-

Nel pannello Fogli a sinistra dell'analisi, andare al foglio Dettagli.

-

Osservare la visualizzazione Metriche modello. che mostra le metriche di punteggio del modello, come F1, oltre ad altre informazioni.

-

Nella sezione Colonne da mostrare, utilizzare la casella di filtro per aggiungere e rimuovere colonne nella tabella.

-

Nella casella di riepilogo a comparsa, aggiungere ulteriori metriche. I punteggi dell'addestramento sono disponibili per essere aggiunti alla tabella. È possibile aggiungerli in base alle necessità per l'analisi.

Ora è possibile vedere le metriche F1 del training di convalida incrociata e confrontarle con le metriche di controllo.

Aggiunta e visualizzazione dei punteggi di addestramento per il confronto con i punteggi di controllo automatico

Esame di un modello specifico

In qualsiasi momento durante l'analisi del modello, è possibile eseguire un'analisi granulare di un modello individuale. Verificare l'accuratezza della previsione, l'importanza della funzione e la distribuzione delle funzioni con un'esperienza interattiva.

Procedere come indicato di seguito:

-

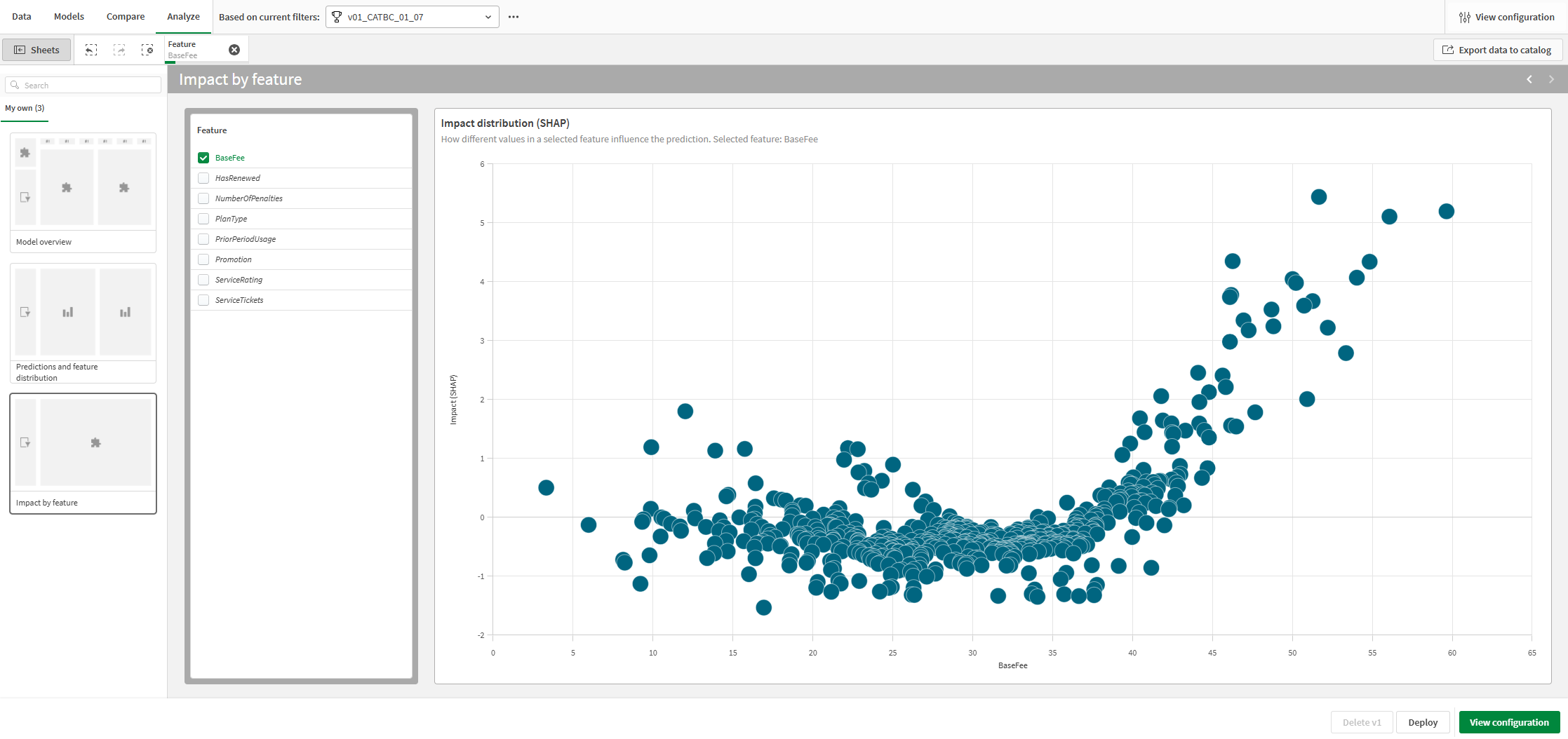

Selezionare un modello, quindi fare clic sulla scheda Analizza.

Viene visualizzata un'analisi incorporata.

-

Utilizzando il foglio Panoramica modello, è possibile analizzare l'accuratezza delle previsioni del modello. L'analisi viene migliorata dall'importanza delle selezioni. Fare clic su una funzione o su un valore previsto per effettuare una selezione. I dati nell'analisi incorporata si regolano per filtrare i dati. È possibile effettuare il drill-down di valori e intervalli della funzione specifici per visualizzare come cambiano l'influenza della funzione e l'accuratezza della previsione.

-

Passando ad altri fogli, è possibile mostrare le visualizzazioni per l'accuratezza della previsione e la distribuzione di funzioni e impatto (SHAP). Il contenuto dell'analisi può aiutare a fare quanto segue:

-

Individuare i fattori chiave che influenzano le tendenze nei dati.

-

Identificare il modo in cui funzioni e coorti specifiche influenzano i valori previsti e l'accuratezza della previsione.

-

Identificare gli outlier nei dati.

-

La scheda Analisi in un esperimento di ML

Prossimi passaggi

Dopo aver eseguito una versione dell'esperimento con l'ottimizzazione intelligente del modello, è possibile eseguire versioni manuali, in base alle necessità, per perfezionare i modelli. Per creare rapidamente una nuova versione manuale, è possibile tornare alla scheda Modelli e fare clic su Nuova versione manuale nel Riepilogo addestramento modello.

In uno scenario reale, è importante ripetere queste fasi di affinamento tutte le volte necessarie prima di distribuire il modello, per assicurarsi di avere il miglior modello possibile per il caso d'uso specifico.

Per maggiori informazioni sull'affinamento dei modelli, vedere Affinamento dei modelli.

In questo tutorial, passiamo alla sezione successiva sulla distribuzione del modello.