Überprüfen und Verfeinern von Modellen

Nachdem die erste Version des Modelltrainings abgeschlossen ist, analysieren Sie die resultierenden Modellmetriken und die empfohlenen Modelle. Wenn weitere Änderungen erforderlich sind, um die Modelle zu verfeinern, können Sie zusätzliche Versionen mit der manuellen Modelloptimierung ausführen.

Wenn Sie die Experimentversion ausführen, werden Sie zur Registerkarte Modelle geführt, wo Sie die sich ergebenden Modellmetriken analysieren können. Sie können auf die Schemaansicht und Datenansicht zugreifen, indem Sie zur Registerkarte Daten zurückkehren. Eine detailliertere Analyse kann auf den Registerkarten Vergleichen und Analysieren durchgeführt werden.

Analyse der Tabelle Modellmetriken

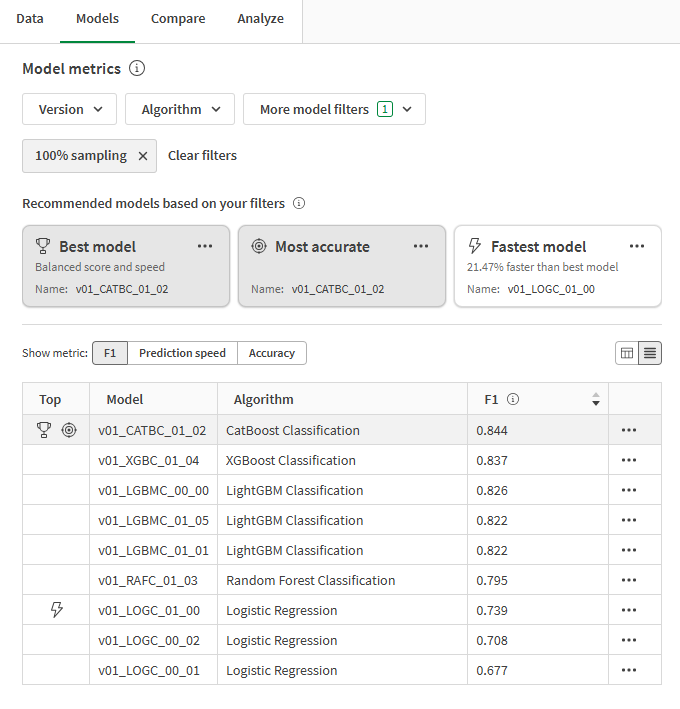

Wechseln Sie zurück zur Registerkarte Modelle. Im Abschnitt Modellmetriken werden empfohlene Modelle auf der Grundlage allgemeiner Qualitätsanforderungen hervorgehoben. Das beste Modell wurde automatisch für die Analyse ausgewählt.

Für die im Experiment trainierten Modelle werden drei Empfehlungen abgegeben. Ein einzelnes Modell kann in mehr als einer Empfehlung dargestellt werden. Die Empfehlungen sind:

-

Bestes Modell: Das Modell, dessen starke Leistung bezüglich Genauigkeit und Vorhersagegeschwindigkeit am ausgewogensten ist.

-

Am genauesten: Das Modell erzielt die höchste Punktzahl in den Metriken für ausgewogene und Rohmetriken für Genauigkeit.

-

Schnellstes Modell: Das Modell hat die schnellste Vorhersagegeschwindigkeit, zusätzlich zu starken Genauigkeitsmetriken.

Es ist wichtig, das Modell zu wählen, das für Ihren Anwendungsfall am besten geeignet ist. In den meisten Fällen ist Bestes Modell die vorteilhafteste Option. Ihr Vorhersage-Anwendungsfall könnte jedoch besondere Spezifikationen für die Metriken Vorhersagegeschwindigkeit oder Genauigkeit erfordern.

Eine ausführliche Übersicht darüber, wie die Typen der leistungsstärksten Modelle ermittelt werden, finden Sie unter Auswählen des für Sie am besten geeigneten Modells.

Tabelle Modellmetriken mit empfohlenen Modellen und Modellmetriken

Mit den Dropdown-Filtern oberhalb der Empfehlungen können Sie Ihre Suche eingrenzen. Die Typen der leistungsstärksten Modelle werden jedes Mal automatisch neu berechnet, wenn Sie die Filterung ändern.

Wechseln Sie zwischen den Hauptmetriken, indem Sie den Selektor Metrik anzeigen oberhalb der Tabelle verwenden. Sie können die Modelle nach dem Namen und der ausgewählten analysierten Metrik sortieren.

Überangepasste Modelle sind in der Tabelle mit einer Warnung gekennzeichnet. Diese Modelle sind nicht zur Bereitstellung geeignet. Ursachen für eine Überanpassung können die durch Trainingsalgorithmen verursachte Modellkomplexität und Probleme mit dem Trainingsdatensatz sein. Weitere Informationen finden Sie unter Überanpassung.

Analyseren der Modelltrainingsübersicht

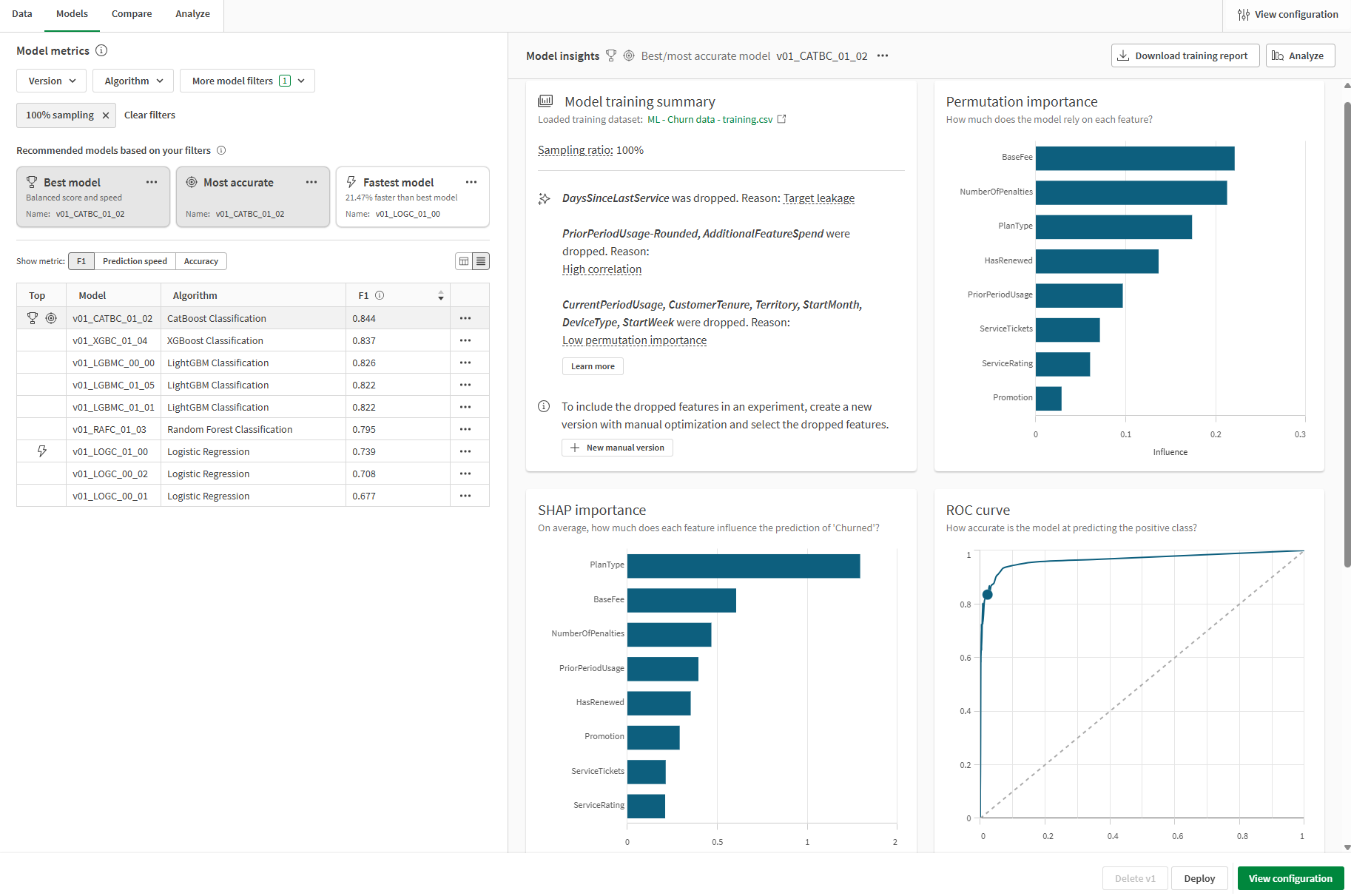

Wir können uns nun auf die Modeltrainingsübersicht auf der rechten Seite der Benutzeroberfläche konzentrieren. Anhand dieser Übersicht können Sie sehen, wie das Modell und die eingegebenen Trainingsdaten für die beste Leistung optimiert wurden. Die Modelltrainingsübersicht ist eine Übersicht über die von der intelligenten Modelloptimierung gebotenen Verbesserungen.

Der Übersicht in der Abbildung unten können wir Folgendes entnehmen:

-

Features aus den Trainingsdaten wurden beim Training entfernt und nicht in das Modell aufgenommen.

-

Das Modell hat einen Stichprobenanteil von 100 %.

Aufgrund eines Ziellecks entferntes Feature

Das Feature DaysSinceLastService wurde während des Trainings aufgrund eines Ziellecks entfernt.

In dieser Feature-Spalte war während der Datenerfassung keine Logik definiert, um das Zählen der Anzahl der Tage seit dem letzten Dienstticket eines Kunden für Kunden zu stoppen, die ihr Abonnement gekündigt hatten. Dadurch könnte das Modell gelernt haben, eine große Anzahl Tage seit dem letzten Dienstticket (für Kunden, die vor Jahren storniert haben) mit dem Ergebnis yes im Feld Churned zu assoziieren.

Dieses Feature musste aus dem Training entfernt werden, da es zu einem Modell mit sehr schlechter Leistung bei neuen Daten geführt hätte.

Das zugrunde liegende Problem ist als Zielleck bekannt, eine Form von Datenleck. Weitere Informationen zu Datenlecks finden Sie unter Datenleck.

Features, die aufgrund hoher Korrelation entfernt wurden

Wir können sehen, dass PriorPeriodUsage-Rounded und AdditionalFeatureSpend während des Trainings entfernt wurden.

In diesem Fall gab es mindestens eine Feature-Spalte (PriorPeriodUsage-Rounded), die direkt aus einer anderen Spalte des Datensatzes abgeleitet wurde. Weitere Korrelationsprobleme wurden für AdditionalFeatureSpend aufgedeckt.

Das Entfernen von Features, die Korrelationsprobleme verursachen, ist wichtig, um ein Modell in hoher Qualität zu trainieren.

Weitere Informationen zur Korrelation finden Sie unter Korrelation.

Features, die aufgrund ihrer geringen Wichtigkeit entfernt wurden

Es wurden auch mehrere Features aufgrund geringer Permutation Importance entfernt. Nach einer vorläufigen Analyse wurde festgestellt, dass diese Features einen sehr geringen Einfluss auf die Ergebnisse des Ziels haben. Diese Features können als statistisches Rauschen betrachtet werden und wurden entfernt, um die Modellqualität zu verbessern.

Weitere Informationen zur Permutation Importance finden Sie unter Verständnis der Permutation Importance.

Modelltrainingsübersicht

Analysieren anderer Visualisierungen auf der Registerkarte Modelle

Auf der Registerkarte Modelle stehen weitere Visualisierungen für zusätzliche Analysen auf hoher Ebene zur Verfügung. Wählen Sie in der Tabelle Modellmetriken verschiedene Modelle aus, um die Leistung auf Feature-Ebene und andere Diagramme zu prüfen, die Aufschluss über die Modellqualität geben können.

Registerkarte Modelle im ML-Experiment mit weiteren für die Analyse verfügbaren Visualisierungen

Vergleich von Trainings- und Holdout-Metriken

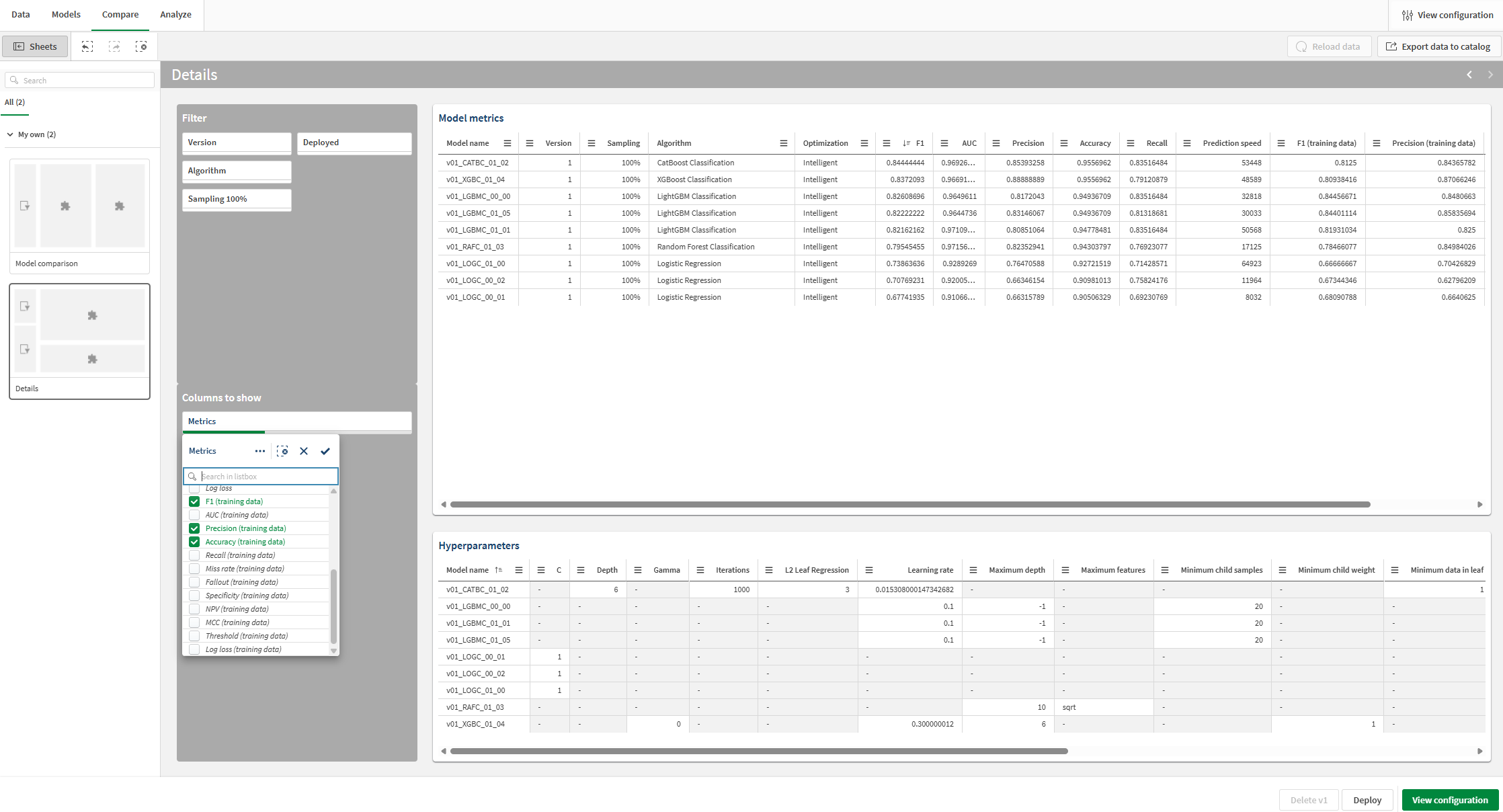

Sie können zusätzliche Metriken anzeigen und die Metriken aus dem Kreuzvalidierungstraining mit den Holdout-Metriken vergleichen.

Gehen Sie folgendermaßen vor:

-

Wechseln Sie im Experiment zur Registerkarte Vergleichen.

Es wird eine eingebettete Analyse geöffnet. Sie können die interaktive Benutzeroberfläche für eine eingehendere Untersuchung Ihrer Vergleichsmodellanalyse und für die Gewinnung neuer Einblicke nutzen.

-

Wechseln Sie im Fensterbereich Arbeitsblätter rechts in der Analyse zum Arbeitsblatt Details.

-

Sehen Sie sich die Visualisierung Modellmetriken an. Sie zeigt Modellbewertungsmetriken wie F1 sowie weitere Informationen.

-

Verwenden Sie im Abschnitt Anzuzeigende Spalten das Filterfenster, um Spalten in der Tabelle hinzuzufügen und zu entfernen.

-

Fügen Sie im Dropdown-Listenfeld zusätzliche Metriken hinzu. Der Tabelle können Trainings-Scores hinzugefügt werden. Sie können sie nach Bedarf für Ihre Analyse hinzufügen.

Sie können jetzt die F1-Metriken aus dem Kreuzvalidierungstraining anzeigen und sie mit den Holdout-Metriken vergleichen.

Hinzufügen und Anzeigen von Trainings-Scores für Vergleich mit den Holdout-Scores

Augenmerk auf ein spezifisches Modell

Sie können zu jeder Zeit während der Modellanalyse eine detaillierte Analyse eines einzelnen Modells durchführen. Erkunden Sie die Vorhersagegenauigkeit, die Feature-Relevanz und die Feature-Verteilung in einer interaktiven Erfahrung.

Gehen Sie folgendermaßen vor:

-

Wählen Sie ein beliebiges Modell aus und klicken Sie auf die Registerkarte Analysieren.

Es wird eine eingebettete Analyse geöffnet.

-

Mit dem Arbeitsblatt Modellübersicht können Sie die Vorhersagegenauigkeit des Models analysieren. Die Analyse wird durch das Leistungsvermögen von Auswahlen verbessert. Klicken Sie auf eine Funktion oder einen vorhergesagten Wert, um eine Auswahl zu treffen. Die Daten in der eingebetteten Analyse werden angepasst, um die Daten zu filtern. Sie können einen Drilldown in spezifische Funktionswerte und -bereiche durchführen, um zu sehen, wie sich der Funktionseinfluss und die Vorhersagegenauigkeit ändern.

-

Durch einen Wechsel zu den anderen Arbeitsblättern können Visualisierungen für Vorhersagegenauigkeit, Funktionsverteilung und Auswirkungsverteilung (SHAP) anzeigen. Diese Analyseinhalte können Ihnen bei Folgendem helfen:

-

Die Haupttreiber aufdecken, die Trends in den Daten beeinflussen.

-

Ermitteln, wie spezifische Funktionen und Kohorten vorhergesagte Werte und die Vorhersagegenauigkeit beeinflussen.

-

Ausreißer in den Daten identifizieren.

-

Registerkarte Analysieren in einem ML-Experiment

Nächste Schritte

Nachdem Sie eine Version des Experiments mit intelligenter Modelloptimierung ausgeführt haben, können Sie bei Bedarf manuelle Versionen ausführen, um Ihre Modelle zu verfeinern. Um schnell eine neue manuelle Version zu erstellen, können Sie zurück zur Registerkarte Modelle wechseln und in Modelltrainingsübersicht auf Neue manuelle Version klicken.

In einem realen Szenario ist es wichtig, Verfeinerungsschritte so oft wie erforderlich zu wiederholen, bevor das Modell bereitgestellt wird, um zu gewährleisten, dass Sie über das bestmögliche Modell für Ihren speziellen Anwendungsfall verfügen.

Weitere Informationen zum Verfeinern von Modellen finden Sie unter Verfeinern von Modellen.

In diesem Tutorial gehen Sie jetzt zum nächsten Abschnitt über die Bereitstellung Ihres Modells weiter.