Rilevamento dei bias nei modelli di machine learning

È possibile identificare i bias nei modelli di machine learning che si addestrano negli esperimenti ML. Affrontare i bias rilevati eliminando le funzionalità distorte, correggendo la raccolta dati impropria o modificando la struttura del set di dati di addestramento.

Nozioni sui bias

Nel machine learning, il bias è un fenomeno indesiderato in cui i modelli favoriscono, o potrebbero favorire, determinati gruppi rispetto ad altri. Il bias influisce negativamente sull'equità e ha implicazioni etiche per le previsioni e le decisioni che esse influenzano. Il bias può essere introdotto nei dati di addestramento, nei risultati previsti dai modelli addestrati o in entrambi.

Esempi di bias—e le sue conseguenze per il processo decisionale—includono:

-

Addestrare modelli su dati che rappresentano in modo sproporzionato determinati livelli di reddito o stati di salute, con conseguenti decisioni ingiuste per le richieste di risarcimento assicurativo.

-

Addestrare modelli su dati distorti rispetto alla razza e al genere dei candidati, influenzando le decisioni di assunzione.

-

Addestramento di modelli che associano i codici postali all'affidabilità creditizia.

Bias dei dati

Il bias dei dati si verifica quando i dati utilizzati per addestrare un modello sono distorti in modo da favorire determinati gruppi rispetto ad altri. Il bias dei dati è causato da una rappresentazione ineguale tra i gruppi nei dati di addestramento.

Ad esempio, un set di dati per prevedere gli esiti delle assunzioni potrebbe contenere dati che rappresentano un genere come più di successo rispetto ad altri.

Il bias dei dati può essere introdotto nei dati di addestramento in diversi modi, tra cui:

-

Raccolta dati impropria in cui determinati gruppi sono sottorappresentati o sovrarappresentati.

-

Dati che riflettono accuratamente i modelli storici, ma espongono il bias sottostante in queste tendenze e pratiche.

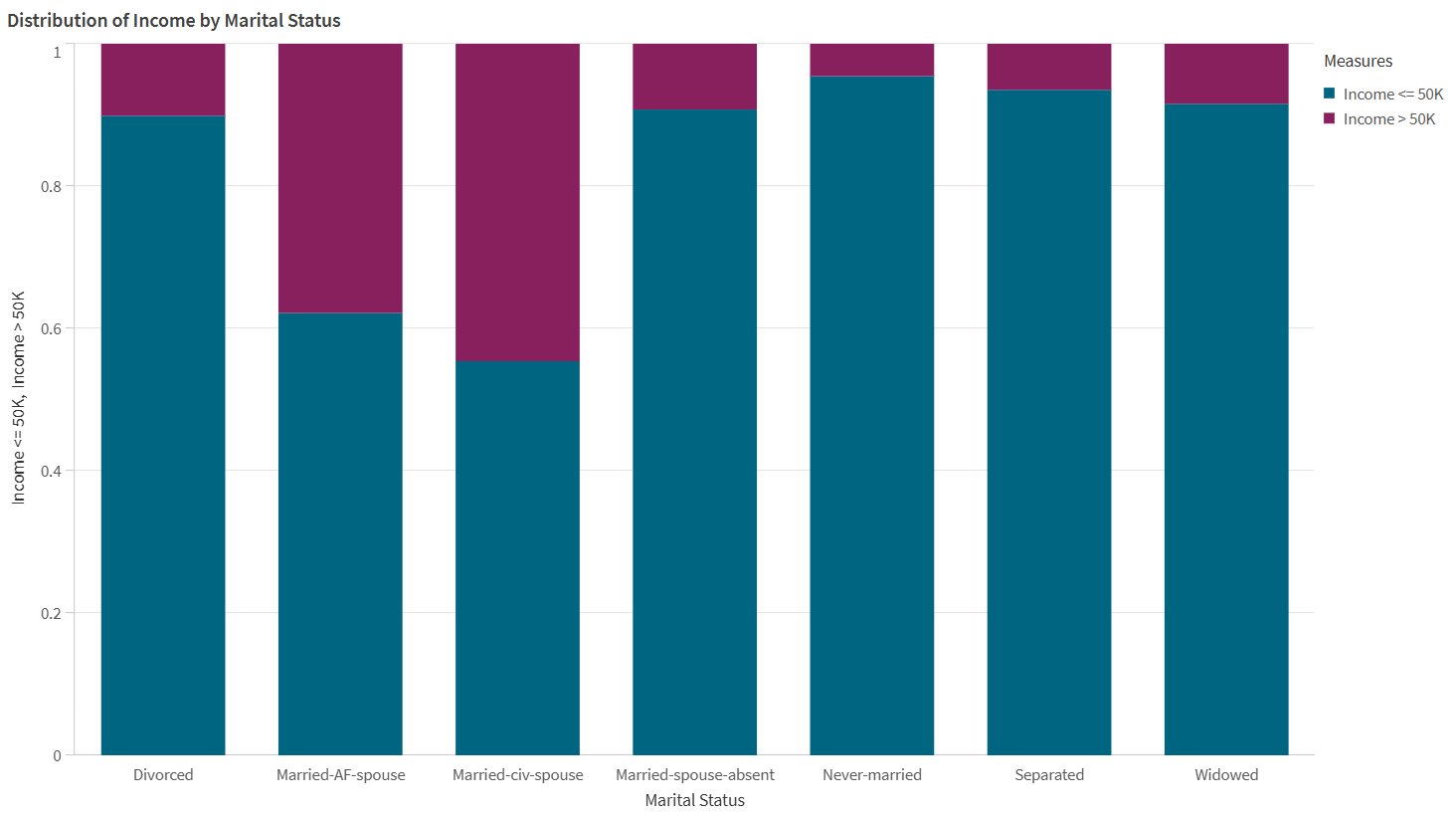

I dati nella visualizzazione seguente indicano un bias dei dati.

Un esempio di bias dei dati, visualizzato da un grafico a barre. Nei dati di origine, determinati stati civili sono sovrarappresentati rispetto ad altri per quanto riguarda i livelli di reddito.

Bias del modello

La distorsione del modello, o distorsione algoritmica, si verifica quando le previsioni fatte da un modello di machine learning favoriscono alcuni gruppi rispetto ad altri. Con la distorsione del modello, i modelli creano associazioni tra determinati gruppi e risultati, influenzando negativamente altri gruppi. La distorsione del modello può essere causata da dati raccolti in modo improprio o distorti, nonché da comportamenti specifici dell'algoritmo di addestramento in uso.

Ad esempio, un modello potrebbe prevedere tassi di assunzione sproporzionatamente negativi per determinate fasce d'età a causa di associazioni ingiuste fatte dal modello.

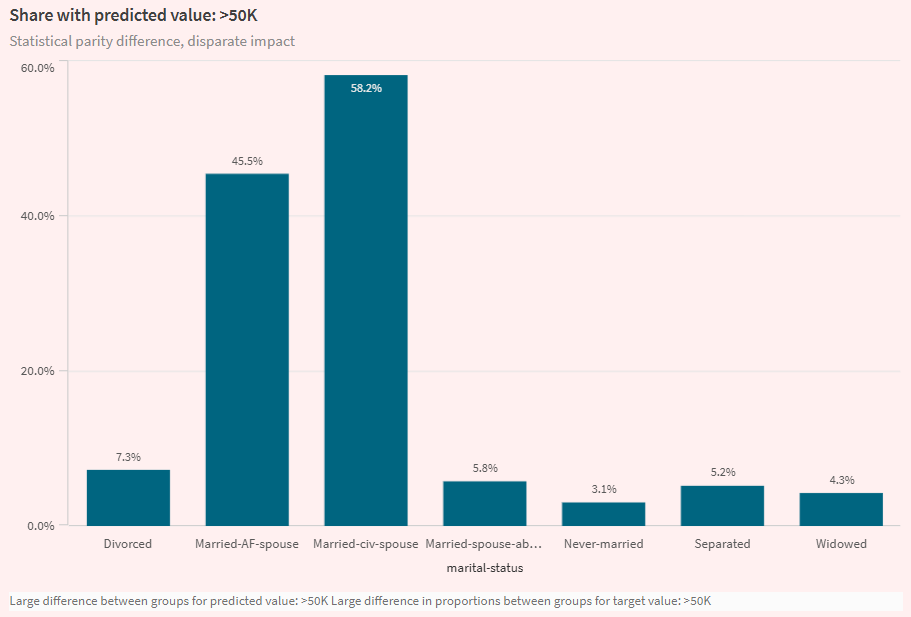

Visualizzazione dalla scheda Analizza in un esperimento ML, che evidenzia il bias del modello. La visualizzazione mostra che un modello effettua previsioni di reddito più elevate per determinati stati civili rispetto ad altri.

Metriche del bias dei dati

In Qlik Predict, il bias dei dati viene misurato analizzando:

-

Tasso di rappresentazione: Confronta la distribuzione dei dati appartenenti a ciascun gruppo nella funzionalità, in confronto a tutti i dati nella funzionalità. La metrica calcolata è il rapporto di parità del tasso di rappresentazione.

-

Rapporto di parità della distribuzione condizionale: Confronta l'equilibrio tra i dati per ciascun gruppo nella funzionalità, rispetto ai valori della colonna di destinazione. La metrica calcolata è il rapporto di parità della distribuzione condizionale.

Per saperne di più sui valori accettabili per queste metriche, vedere Valori accettabili per le metriche di bias.

Metriche di bias del modello

In Qlik Predict, le metriche di bias del modello sono meglio comprese nel contesto del tipo di modello per l'esperimento. In linea generale, esistono le seguenti categorie di metriche di bias:

-

Metriche dei modelli di classificazione

-

Metriche dei modelli di regressione e serie temporali

Per saperne di più sui valori accettabili per queste metriche, vedi Valori accettabili per le metriche di bias.

Modelli di classificazione

Nei modelli di classificazione binaria e multiclasse, il bias viene misurato analizzando i valori target previsti (risultati). In particolare, vengono confrontate le differenze nei tassi di esito positivo e negativo per i gruppi ("positivo" e "negativo" qui si riferiscono a esiti favorevoli rispetto a sfavorevoli, ad esempio, un valore di sì o no per una colonna target Assunto.). Questi modelli presentano le seguenti metriche di bias:

-

Impatto disparato

-

Differenza di parità statistica

-

Differenza di pari opportunità

Impatto disparato

Il rapporto di impatto disparato (DI) valuta se i gruppi in una funzionalità sensibile vengono favoriti o danneggiati negli esiti previsti dal modello. Si misura calcolando con quale frequenza ogni gruppo viene selezionato come valore previsto, confrontandolo con il tasso di selezione per il gruppo più favorito nella funzionalità.

Differenza di parità statistica

Simile all'impatto sproporzionato, la differenza di parità statistica (SPD) valuta le previsioni del modello per determinare se favoriscono o danneggiano gruppi individuali. La metrica viene calcolata confrontando i tassi di esito positivo tra il gruppo più grande e quello più piccolo.

Differenza di pari opportunità

La differenza di pari opportunità (EOD) è simile alle altre due metriche di bias del modello di classificazione. L'EOD confronta i tassi di veri positivi più alti e più bassi tra i gruppi in una funzionalità.

Modelli di regressione e serie temporali

Nei modelli di regressione e serie temporali, il bias viene misurato confrontando la frequenza con cui i modelli commettono errori nelle loro previsioni, utilizzando i rapporti di parità per determinare l'equità dei risultati previsti.

Vengono calcolate le seguenti metriche di bias, utilizzando metriche di errore comunemente usate per valutare l'accuratezza del modello:

Valori accettabili per le metriche di bias

| Metrica di bias | Categoria di bias | Tipi di modello applicabili | Valori accettabili |

|---|---|---|---|

| Rapporto di parità del tasso di rappresentazione | Bias dei dati | Tutti |

Valore ideale: tra 0,8 e 1. Un rapporto inferiore indica una rappresentazione sproporzionata. |

| Rapporto di parità della distribuzione condizionale | Bias dei dati | Tutti |

Valore ideale: tra 0,8 e 1. Un rapporto inferiore indica una rappresentazione sproporzionata. |

| Differenza di parità statistica (SPD) | Bias del modello | Classificazione binaria, classificazione multiclasse |

Valore ideale: 0. Un valore superiore a 0,2 è un forte segnale di iniquità. |

| Impatto disparato (DI) | Bias del modello | Classificazione binaria, classificazione multiclasse |

Valore ideale: 1. Un valore inferiore a 0,8 segnala iniquità. |

| Differenza di pari opportunità (EOD) | Bias del modello | Classificazione binaria, classificazione multiclasse |

Valore ideale: 0. Un valore superiore a 0,1 segnala ingiustizia. |

| Rapporto di parità MAE | Bias del modello | Regressione |

Valore ideale: tra 0,8 e 1. Un valore superiore a 1,25 segnala ingiustizia. |

| Rapporto di parità MSE | Bias del modello | Regressione |

Valore ideale: tra 0,8 e 1. Un valore superiore a 1,25 indica iniquità. |

| Rapporto di parità RMSE | Bias del modello | Regressione |

Valore ideale: tra 0,8 e 1. Un valore superiore a 1,25 indica iniquità. |

| Differenza R2 | Bias del modello | Regressione |

Valore ideale: 0. Un valore superiore a 0,2 indica iniquità. |

| Rapporto di parità MASE | Bias del modello | Serie temporale | Un valore superiore a 1,25 segnala iniquità. |

| Rapporto di parità MAPE | Bias del modello | Serie temporale | Un valore superiore a 1,25 segnala iniquità. |

| Rapporto di parità SMAPE | Bias del modello | Serie temporale | Un valore superiore a 1,25 segnala iniquità. |

Configurazione del rilevamento del bias

Il rilevamento del bias è configurato per funzionalità di training nella versione dell'esperimento.

Procedere come indicato di seguito:

-

In un esperimento ML, espandi Bias nel pannello di configurazione dell'addestramento.

-

Seleziona le funzionalità su cui vuoi eseguire il rilevamento del bias.

In alternativa, attiva il rilevamento del bias per le funzionalità desiderate nella vista Schema.

Analisi rapida dei risultati del bias

Al termine del training, è possibile ottenere una rapida panoramica dei risultati del rilevamento del bias nella scheda Modelli.

Scorri verso il basso tra gli elementi di analisi rapida per trovare Rilevamento bias. Espandi le sezioni utilizzando le icone. È possibile analizzare le funzionalità con possibili bias di dati e di modello.

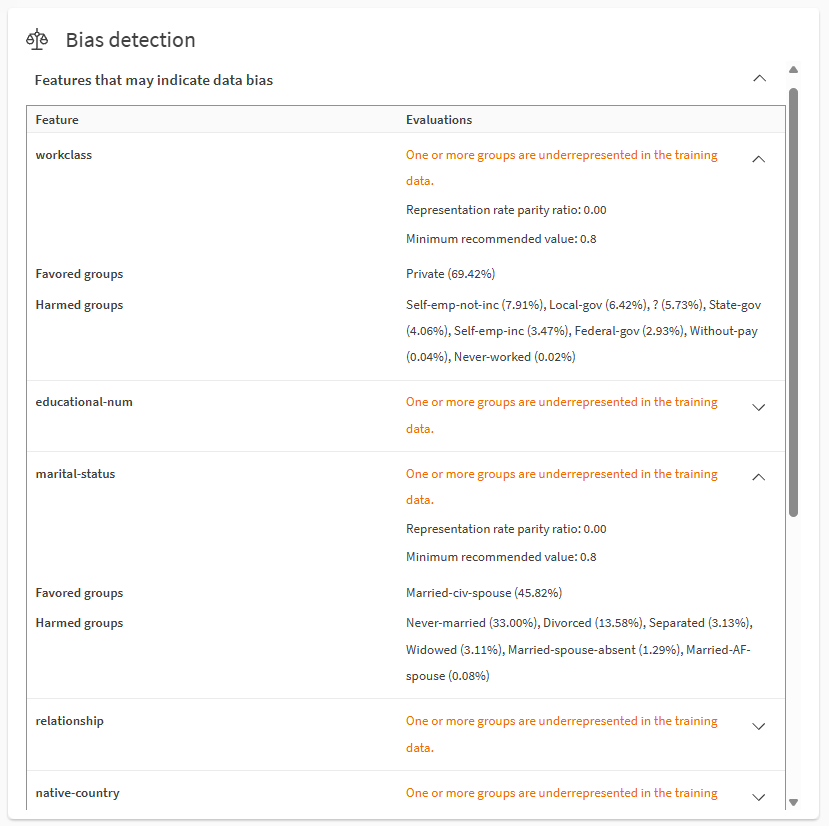

Analisi del bias dei dati utilizzando la sezione Rilevamento bias nella scheda Modelli.

Note

-

I gruppi favoriti sono i valori o gli intervalli target sovrarappresentati nei dati o nei risultati previsti del target, in base alle metriche di bias. I gruppi svantaggiati sono i valori o gli intervalli target sottorappresentati nei dati o nei risultati previsti del target, in base alle metriche di bias.

Per informazioni su come vengono utilizzate le metriche di bias, consultare Valori accettabili per le metriche di bias.

I numeri tra parentesi descrivono i criteri utilizzati per calcolare la metrica. Ad esempio, se la metrica è la differenza di pari opportunità (EOD), femmine (10%) e maschi (80%) indica tassi di veri positivi dell'80% per i maschi e del 10% per le femmine.

-

Risultato target si riferisce al valore della colonna target che viene previsto dal modello.

-

Non tutte le metriche e i valori di bias sono mostrati nella scheda Modelli a causa dello spazio limitato. Ad esempio:

-

A seconda del tipo di metrica e di modello, alcune metriche e gruppi potrebbero includere solo minimi e massimi.

-

Se più metriche superano la soglia di bias per una funzionalità, viene mostrata la metrica che indica il più alto grado di iniquità.

-

Per le funzionalità con bias nei modelli di classificazione multiclasse, viene mostrata solo la metrica che indica il più alto grado di iniquità.

-

-

Informazioni più dettagliate sono disponibili nella scheda Analizza e nel report di addestramento del modello. Vedere Analisi dettagliata dei risultati del bias.

- Per maggiori informazioni sulla terminologia in questa sezione, vedere Terminologia in questa pagina.

Analisi dettagliata dei risultati del bias

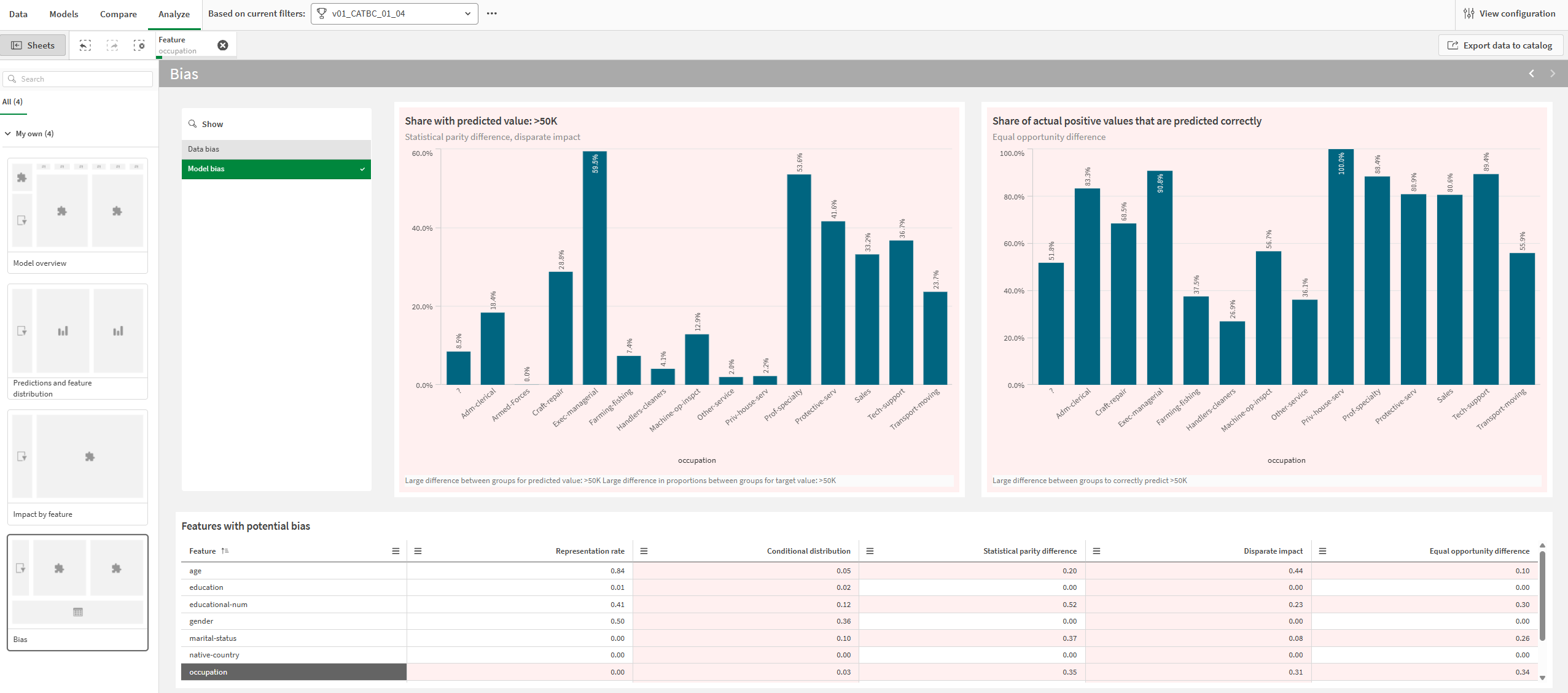

È possibile approfondire i risultati del bias nella scheda Analizza.

Procedere come indicato di seguito:

-

In un esperimento ML, seleziona un modello e vai alla scheda Analizza.

-

Apri il foglio Bias.

-

Seleziona tra Bias dei dati e Bias del modello a seconda dell'analisi desiderata.

-

Nella tabella Funzionalità con potenziale bias, seleziona una singola funzionalità.

Grafici e metriche che indicano un possibile bias vengono visualizzati con uno sfondo rosso. È possibile selezionare le funzionalità facendo clic ed eseguendo il tracciamento nelle visualizzazioni.

Le metriche nella tabella sono statiche per le metriche di bias corrispondenti alle funzionalità standard. Per le funzionalità future, le metriche di bias cambiano dinamicamente a seconda della selezione del gruppo di serie temporali.

Scheda Analizza che mostra un'analisi del bias del modello per la funzionalità selezionata. Il possibile bias è indicato da sfondi rossi per i grafici e le metriche.

Per maggiori informazioni sulla navigazione delle analisi dettagliate del modello, vedere Esecuzione di analisi dettagliate dei modelli.

Risultati del bias nei report di training

Le metriche del bias sono presentate anche nei report di training ML.Sono incluse in una sezione Bias dedicata nel report.

Per ulteriori informazioni sui report di addestramento, consultare Download dei report di addestramento di ML.

Gestione del bias

Dopo aver analizzato i risultati del rilevamento del bias per i tuoi modelli, potresti voler eseguire una delle seguenti operazioni:

-

Eseguire nuove versioni dell'esperimento dopo aver eliminato le funzionalità con bias.

-

Evitare di distribuire modelli che mostrano bias, distribuendo invece modelli che soddisfano i criteri consigliati per le metriche di bias.

-

Aggiorna il tuo set di dati per correggere qualsiasi raccolta di dati impropria o per affrontare tassi di rappresentazione disuguali.

-

Ridefinisci il tuo problema di machine learning utilizzando il framework strutturato. Ad esempio, se la tua domanda originale di machine learning è intrinsecamente distorta, i modelli saranno probabilmente sempre inaffidabili nel creare previsioni eque.

Terminologia in questa pagina

In questa pagina, e in Qlik Predict, "gruppi" è un termine che ha significati diversi a seconda del contesto:

-

"Gruppi" si riferisce ai valori o agli intervalli nelle funzionalità che vengono analizzati per il bias. Ad esempio, una funzionalità Stato civile potrebbe avere quattro possibili gruppi nei dati di addestramento: Sposato, Divorziato, Separato o Vedovo.

-

Negli esperimenti di serie temporali, "gruppi" si riferisce a una funzionalità che consente di tenere traccia dei risultati target per valori specifici di funzionalità compatibili. In questa pagina, questi gruppi sono denominati "gruppi di serie temporali". Per maggiori informazioni su questi gruppi, vedi Gruppi.

Limitazioni

-

Non è possibile attivare il rilevamento delle distorsioni per:

-

La funzionalità target.

-

Funzionalità di testo libero (anche se il tipo di funzionalità viene modificato in categorico).

-

Funzionalità data che vengono utilizzate come indice di data negli esperimenti di serie temporali.

-

Funzionalità data progettate automaticamente. È possibile eseguire il rilevamento del bias su queste funzionalità, ma non le si attiva in modo indipendente. Invece, attiva la funzionalità della data padre per il rilevamento dei bias e assicurati che le funzionalità della data auto-ingegnerizzate siano incluse per l'addestramento.

-