Verzerrungserkennung in Modellen für maschinelles Lernen

Sie können Verzerrung in ML-Modellen identifizieren, die Sie in ML-Experimenten trainieren. Beheben Sie erkannte Verzerrungen, indem Sie verzerrte Features entfernen, ungeeignete Datenerfassung korrigieren oder die Struktur Ihres Trainingsdatensatzes ändern.

Verstehen von Verzerrung

Beim maschinellen Lernen wird als Verzerrung ein unerwünschtes Phänomen bezeichnet, bei dem Modelle bestimmte Gruppen gegenüber anderen bevorzugen oder bevorzugen könnten. Verzerrung beeinträchtigt die Fairness negativ und hat ethische Auswirkungen auf Vorhersagen und die von diesen beeinflussten Entscheidungen. Verzerrung kann in Trainingsdaten, in den von trainierten Modellen vorhergesagten Ergebnissen oder in beidem auftreten.

Beispiele für Verzerrung – und deren Folgen für die Entscheidungsfindung – sind:

-

Trainieren von Modellen mit Daten, die bestimmte Einkommensniveaus oder Gesundheitszustände unverhältnismäßig stark repräsentieren, was zu unfairen Entscheidungen bei Versicherungsansprüchen führt.

-

Trainieren von Modellen mit verzerrten Daten in Bezug auf Rasse und Geschlecht von Kandidaten, was sich auf Einstellungsentscheidungen auswirkt.

-

Trainieren von Modellen, die Postleitzahlen mit der Kreditwürdigkeit in Verbindung bringen.

Datenverzerrung

Datenverzerrung tritt auf, wenn die zum Trainieren eines Modells verwendeten Daten auf eine Weise verzerrt sind, dass bestimmte Gruppen gegenüber anderen bevorzugt werden. Datenverzerrung wird durch ungleiche Repräsentation von Gruppen in den Trainingsdaten verursacht.

Zum Beispiel könnte ein Datensatz zur Vorhersage von Einstellungsergebnissen Daten enthalten, die ein Geschlecht als erfolgreicher darstellen als andere.

Datenverzerrung kann auf verschiedene Weisen in Trainingsdaten eingeführt werden, darunter:

-

Ungeeignete Datenerfassung, bei der bestimmte Gruppen unterrepräsentiert oder überrepräsentiert sind.

-

Daten, die historische Muster genau widerspiegeln, aber die zugrunde liegende Verzerrung in diesen Trends und Praktiken offenlegen.

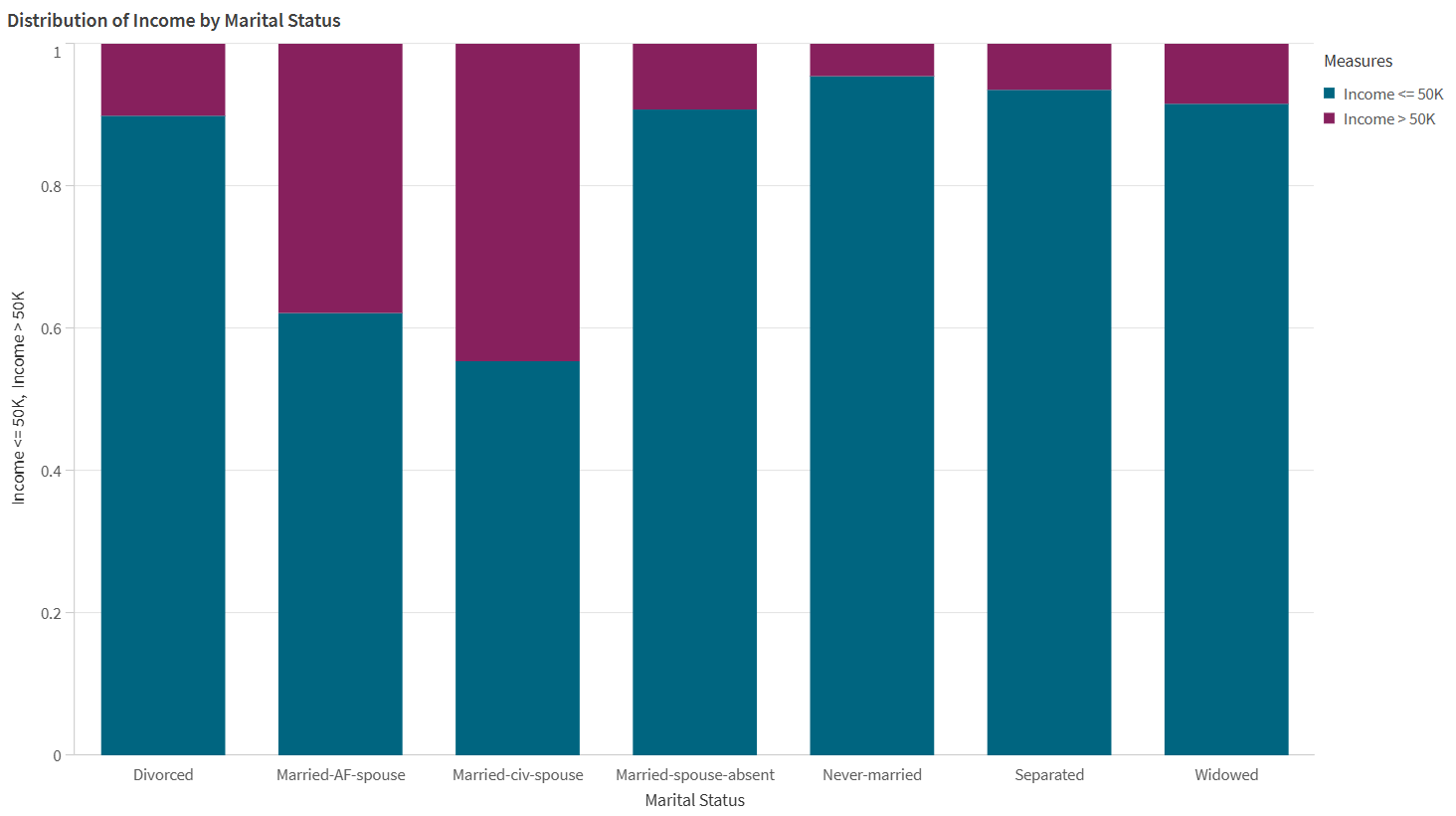

Die Daten in der unten angezeigten Visualisierung weisen Datenverzerrungen auf.

Ein Beispiel für Datenverzerrungen, visualisiert durch ein Balkendiagramm. In den Quelldaten sind bestimmte Familienstände im Vergleich zu anderen in Bezug auf Einkommensniveaus überrepräsentiert.

Modellverzerrung

Modellverzerrung oder algorithmische Verzerrung tritt auf, wenn die Vorhersagen eines ML-Modells bestimmte Gruppen gegenüber anderen bevorzugen. Bei Modellverzerrung stellen Modelle Assoziationen zwischen bestimmten Gruppen und Ergebnissen her, was sich negativ auf andere Gruppen auswirkt. Modellverzerrung kann durch nicht angemessen erfasste oder verzerrte Daten sowie durch Verhaltensweisen verursacht werden, die spezifisch für den verwendeten Trainingsalgorithmus sind.

Zum Beispiel könnte ein Modell unverhältnismäßig negative Einstellungsquoten für bestimmte Altersgruppen vorhersagen, die auf vom Modell getroffenen unfairen Assoziationen basieren.

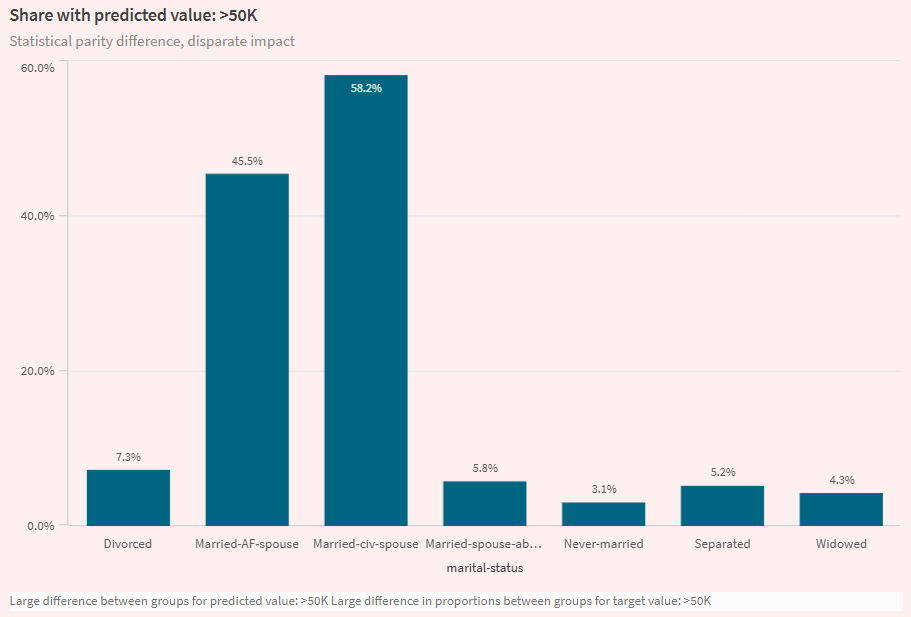

Visualisierung auf der Registerkarte Analysieren in einem ML-Experiment, die die Modellverzerrung hervorhebt. Die Visualisierung zeigt, dass ein Modell für bestimmte Familienstände höhere Einkommensprognosen erstellt als für andere.

Datenverzerrungsmetriken

In Qlik Predict wird die Datenverzerrung durch die Analyse folgender Metriken gemessen:

-

Repräsentationsrate: Vergleicht die Verteilung der Daten, die zu jeder Gruppe im Feature gehören, im Vergleich zu allen Daten im Feature. Die berechnete Metrik ist das Paritätsverhältnis der Repräsentationsrate.

-

Paritätsverhältnis der bedingten Verteilung: Vergleicht die Ausgewogenheit zwischen Daten für jede Gruppe im Feature bezüglich der Werte der Zielspalte. Die berechnete Metrik ist das Paritätsverhältnis der bedingten Verteilung.

Weitere Informationen zu den akzeptablen Werten für diese Metriken finden Sie unter Akzeptable Werte für Verzerrungsmetriken.

Modellverzerrungsmetriken

In Qlik Predict lassen sich Modellverzerrungsmetriken am besten im Kontext des Modelltyps für das Experiment verstehen. Im Allgemeinen gibt es die folgenden Kategorien für Verzerrungsmetriken:

-

Metriken für Klassifizierungsmodelle

-

Metriken für Regressions- und Zeitreihenmodelle

Weitere Informationen zu den akzeptablen Werten für diese Metriken finden Sie unter Akzeptable Werte für Verzerrungsmetriken.

Klassifizierungsmodelle

In binären und Mehrklassen-Klassifizierungsmodellen wird die Verzerrung durch die Analyse der vorhergesagten Zielwerte (Ergebnisse) gemessen. Insbesondere werden Unterschiede in den Raten positiver und negativer Ergebnisse für Gruppen verglichen („positiv“ und „negativ“ beziehen sich hier auf günstige bzw. ungünstige Ergebnisse – zum Beispiel ein Wert von Ja oder Nein für eine Zielspalte Eingestellt). Diese Modelle haben die folgenden Verzerrungsmetriken:

-

Ungleichmäßige Auswirkung

-

Statistischer Paritätsunterschied

-

Unterschied bei Chancengleichheit

Ungleichmäßige Auswirkung

Das Verhältnis der ungleichmäßigen Auswirkung bewertet, ob Gruppen in einem sensiblen Feature in den vorhergesagten Ergebnissen des Modells bevorzugt oder benachteiligt werden. Zu seiner Messung wird berechnet, wie oft jede Gruppe als vorhergesagter Wert ausgewählt wird, und dies wird mit der Auswahlrate für die am meisten bevorzugte Gruppe im Feature verglichen.

Statistischer Paritätsunterschied

Ähnlich wie bei der ungleichmäßigen Auswirkung bewertet der statistische Paritätsunterschied Modellvorhersagen, um festzustellen, ob sie einzelne Gruppen bevorzugen oder benachteiligen. Die Metrik wird berechnet, indem die Raten positiver Ergebnisse zwischen der größten und der kleinsten Gruppe verglichen werden.

Unterschied bei Chancengleichheit

Der Unterschied bei Chancengleichheit ähnelt den beiden anderen Metriken für die Klassifizierungsmodellverzerrung. Der Unterschied bei Chancengleichheit vergleicht die höchsten und niedrigsten Wahr-Positiv-Raten über Gruppen hinweg in einem Feature.

Regressions- und Zeitreihenmodelle

In Regressions- und Zeitreihenmodellen wird die Verzerrung gemessen, indem verglichen wird, wie oft Modelle Fehler in ihren Vorhersagen machen, wobei Paritätsverhältnisse verwendet werden, um die Fairness der vorhergesagten Ergebnisse zu bestimmen.

Die folgenden Verzerrungsmetriken werden berechnet, wobei Fehlermetriken genutzt werden, die üblicherweise zur Bewertung der Modellgenauigkeit verwendet werden:

Akzeptable Werte für Verzerrungsmetriken

| Verzerrungsmetrik | Verzerrungskategorie | Anwendbare Modelltypen | Akzeptable Werte |

|---|---|---|---|

| Paritätsverhältnis der Repräsentationsrate | Datenverzerrung | Alle |

Idealer Wert: zwischen 0,8 und 1. Ein niedrigeres Verhältnis deutet auf eine unverhältnismäßige Repräsentation hin. |

| Paritätsverhältnis der bedingten Verteilung | Datenverzerrung | Alle |

Idealer Wert: zwischen 0,8 und 1. Ein niedrigeres Verhältnis deutet auf eine unverhältnismäßige Repräsentation hin. |

| Statistischer Paritätsunterschied | Modellverzerrung | Binärklassifizierung, Mehrklassen-Klassifizierung |

Idealer Wert: 0. Ein Wert über 0,2 ist ein starker Hinweis auf Unfairness. |

| Ungleichmäßige Auswirkung | Modellverzerrung | Binärklassifizierung, Mehrklassen-Klassifizierung |

Idealer Wert: 1. Ein Wert unter 0,8 signalisiert Unfairness. |

| Unterschied bei Chancengleichheit | Modellverzerrung | Binärklassifizierung, Mehrklassen-Klassifizierung |

Idealer Wert: 0. Ein Wert unter 0,1 signalisiert Unfairness. |

| MAE-Paritätsverhältnis | Modellverzerrung | Regression |

Idealer Wert: zwischen 0,8 und 1. Ein Wert über 1,25 signalisiert Unfairness. |

| MSE-Paritätsverhältnis | Modellverzerrung | Regression |

Idealer Wert: zwischen 0,8 und 1. Ein Wert über 1,25 signalisiert Unfairness. |

| RMSE-Paritätsverhältnis | Modellverzerrung | Regression |

Idealer Wert: zwischen 0,8 und 1. Ein Wert über 1,25 signalisiert Unfairness. |

| R2-Lücke | Modellverzerrung | Regression |

Idealer Wert: 0. Ein Wert über 0,2 signalisiert Unfairness. |

| MASE-Paritätsverhältnis | Modellverzerrung | Zeitreihen | Ein Wert über 1,25 signalisiert Unfairness. |

| MAPE-Paritätsverhältnis | Modellverzerrung | Zeitreihen | Ein Wert über 1,25 signalisiert Unfairness. |

| SMAPE-Paritätsverhältnis | Modellverzerrung | Zeitreihen | Ein Wert über 1,25 signalisiert Unfairness. |

Konfigurieren der Verzerrungserkennung

Die Verzerrungserkennung wird pro Trainings-Feature in der Experimentversion konfiguriert.

Gehen Sie folgendermaßen vor:

-

Erweitern Sie in einem ML-Experiment Verzerrung im Trainingskonfigurationsfenster.

-

Wählen Sie die Features aus, für die Sie die Verzerrungserkennung ausführen möchten.

Alternativ aktivieren Sie die Verzerrungserkennung für die gewünschten Features in Schemaansicht.

Schnellanalyse der Verzerrungsergebnisse

Nach Abschluss des Trainings erhalten Sie eine schnelle Übersicht über die Ergebnisse der Verzerrungserkennung auf der Registerkarte Modelle.

Scrollen Sie durch die Schnellanalyse-Elemente nach unten zu Verzerrungserkennung. Erweitern Sie Abschnitte mithilfe der -Symbole. Sie können Features mit möglichen Daten- und Modellverzerrungen analysieren.

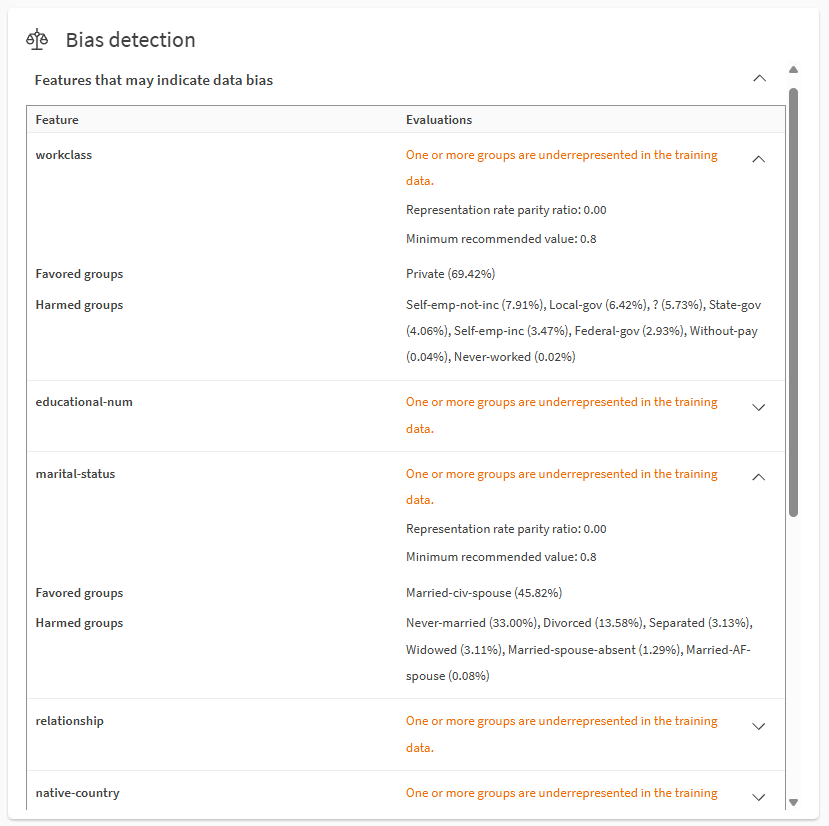

Analysieren von Datenverzerrungen mithilfe des Abschnitts Verzerrungserkennung auf der Registerkarte Modelle.

Notizen

-

Bevorzugte Gruppen sind die Zielwerte oder -bereiche, die in den Daten oder den prognostizierten Ergebnissen des Ziels basierend auf den Verzerrungsmetriken überrepräsentiert sind. Geschädigte Gruppen sind die Zielwerte oder -bereiche, die in den Daten oder den prognostizierten Ergebnissen des Ziels basierend auf den Verzerrungsmetriken unterrepräsentiert sind.

Informationen zur Verwendung der Verzerrungsmetriken finden Sie unter Akzeptable Werte für Verzerrungsmetriken.

Die Zahlen in Klammern beschreiben die Kriterien, die zur Berechnung der Metrik verwendet wurden. Wenn die Metrik beispielsweise der Unterschied bei der Chancengleichheit ist, zeigt weiblich (10 %) und männlich (80 %) Wahr-Positiv-Raten von 80 % für Männer und 10 % für Frauen an.

-

Zielergebnis ist der Wert der Zielspalte, der vom Modell vorhergesagt wird.

-

Aufgrund des begrenzten Platzes werden nicht alle Verzerrungsmetriken und -werte auf der Registerkarte Modelle angezeigt. Beispiel:

-

Je nach Metrik- und Modelltypen können einige Metriken und Gruppen nur Mindest- oder Höchstwerte enthalten.

-

Wenn mehrere Metriken den Verzerrungsschwellenwert für ein Feature überschreiten, wird die Metrik angezeigt, die den höchsten Grad an Unfairness aufweist.

-

Für verzerrte Features in Mehrklassen-Klassifizierungsmodellen wird nur die Metrik angezeigt, die den höchsten Grad an Unfairness aufweist.

-

-

Detailliertere Informationen finden Sie auf der Registerkarte Analysieren und im Modelltrainingsbericht. Weitere Informationen finden Sie unter Detaillierte Analyse der Verzerrungsergebnisse.

- Weitere Informationen zur Terminologie in diesem Abschnitt finden Sie unter Auf dieser Seite verwendete Terminologie.

Detaillierte Analyse der Verzerrungsergebnisse

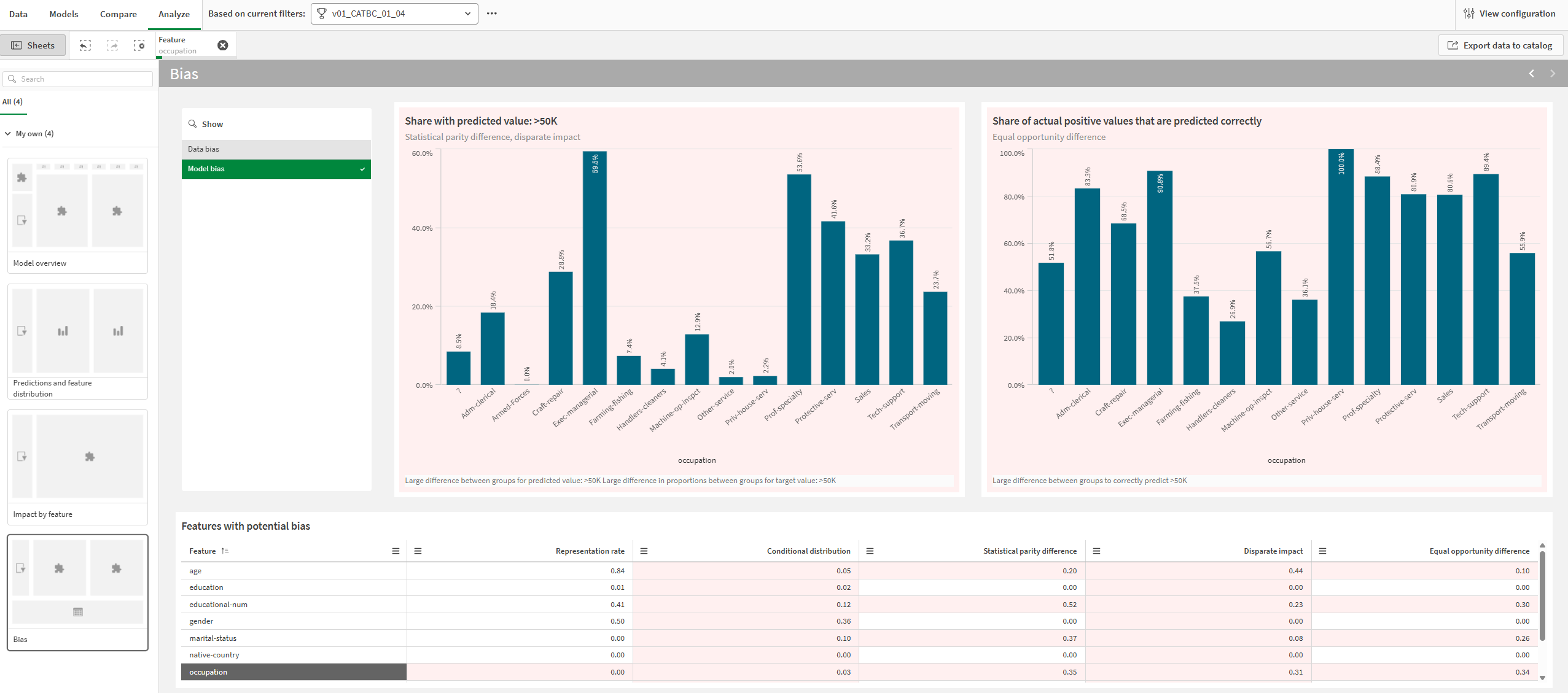

Auf der Registerkarte Analysieren können Sie die Verzerrungsergebnisse eingehender prüfen.

Gehen Sie folgendermaßen vor:

-

Wählen Sie in einem ML-Experiment ein Modell aus und wechseln Sie zur Registerkarte Analysieren.

-

Öffnen Sie das Arbeitsblatt Verzerrung.

-

Wählen Sie je nach gewünschter Analyse zwischen Datenverzerrung und Modellverzerrung aus.

-

Wählen Sie in der Tabelle Features mit potenzieller Verzerrung ein einzelnes Feature aus.

Diagramme und Metriken, die eine mögliche Verzerrung anzeigen, werden mit rotem Hintergrund dargestellt. Sie können Features auswählen, indem Sie in den verschiedenen Visualisierungen klicken und ziehen.

Metriken in der Tabelle sind statisch für Verzerrungsmetriken, die Standard-Features entsprechen. Für zukünftige Features ändern sich die Verzerrungsmetriken dynamisch, abhängig von der Auswahl der Zeitreihengruppe.

Registerkarte Analyse, die eine Analyse der Modellverzerrung für das ausgewählte Feature zeigt. Mögliche Verzerrungen werden durch rote Hintergründe für Diagramme und Metriken angezeigt.

Weitere Informationen zum Navigieren in detaillierten Modellanalysen finden Sie unter Durchführen von detaillierten Modellanalysen.

Verzerrungsergebnisse in Trainingsberichten

Verzerrungsmetriken werden auch in ML-Trainingsberichten dargestellt. Sie sind in einem eigenen Abschnitt Verzerrung im Bericht enthalten.

Weitere Informationen zu Trainingsberichten finden Sie unter Herunterladen von ML-Trainingsberichten.

Beheben von Verzerrungen

Nach der Analyse der Ergebnisse der Verzerrungserkennung für Ihre Modelle haben Sie folgende Möglichkeiten:

-

Führen Sie neue Experimentversionen aus, nachdem Sie die verzerrten Features entfernt haben.

-

Vermeiden Sie die Bereitstellung von Modellen, die eine Verzerrung aufweisen, und stellen Sie stattdessen Modelle bereit, die die empfohlenen Kriterien für Verzerrungsmetriken erfüllen.

-

Aktualisieren Sie Ihren Datensatz, um ungeeignete Datenerfassungen zu korrigieren oder Raten der ungleichmäßigen Repräsentation zu verbessern.

-

Definieren Sie Ihr ML-Problem mithilfe des strukturierten Frameworks neu. Wenn beispielsweise Ihre ursprüngliche ML-Frage von Natur aus verzerrt ist, werden Modelle wahrscheinlich immer unzuverlässig sein, wenn es darum geht, faire Vorhersagen zu treffen.

Auf dieser Seite verwendete Terminologie

Auf dieser Seite und in Qlik Predict hat „Gruppen“ je nach Kontext unterschiedliche Bedeutungen:

-

„Gruppen“ bezieht sich auf die Werte oder Bereiche in Features, die auf Verzerrungen analysiert werden. Beispielsweise könnte ein Feature „Familienstand“ vier mögliche Gruppen in den Trainingsdaten haben: Verheiratet, Geschieden, Getrennt lebend oder Verwitwet.

-

In Zeitreihenexperimenten bezieht sich „Gruppen“ auf eine Funktionalität, die es ermöglicht, Zielergebnisse für bestimmte Werte kompatibler Features zu verfolgen. Auf dieser Seite werden diese Gruppen als „Zeitreihengruppen“ bezeichnet. Weitere Informationen zu diesen Gruppen finden Sie unter Gruppen.

Beschränkungen

-

Für folgende Features kann keine Verzerrungserkennung aktiviert werden:

-

Das Ziel-Feature.

-

Freitext-Features (auch wenn der Feature-Typ in kategorial geändert wird).

-

Datums-Features, die als Datumsindex in Zeitreihenexperimenten verwendet werden.

-

Automatisch erstellte Datums-Features. Sie können eine Verzerrungserkennung für diese Features ausführen, aber aktivieren Sie sie nicht unabhängig. Aktivieren Sie stattdessen das übergeordnete Datums-Feature für die Verzerrungserkennung und stellen Sie sicher, dass die automatisch generierten Datums-Features für das Training enthalten sind.

-