Détection des biais dans les modèles d'apprentissage automatique

Vous pouvez identifier les biais dans les modèles d'apprentissage automatique dont vous effectuez l'apprentissage lors d'expérimentations ML. Traitez les biais détectés en abandonnant les caractéristiques faussées, en corrigeant la collecte de données inappropriée ou en modifiant la structure de votre jeu de données d'apprentissage.

Comprendre les biais

En apprentissage automatique, le biais est un phénomène indésirable dans lequel les modèles favorisent, ou pourraient favoriser, certains groupes par rapport à d'autres. Le biais affecte négativement l'équité et a des implications éthiques pour les prédictions et les décisions qu'elles influencent. Le biais peut être introduit dans les données d'apprentissage et/ou dans les résultats prédits par les modèles ayant fait l'objet d'un apprentissage.

Voici des exemples de biais et leurs conséquences sur la prise de décision :

-

Apprentissage de modèles sur des données qui représentent de manière disproportionnée certains niveaux de revenus ou états de santé, entraînant des décisions injustes pour les déclarations de sinistres auprès des assurances.

-

Apprentissage de modèles sur des données biaisées concernant la race et le sexe des candidats, affectant les décisions d'embauche.

-

Apprentissage de modèles associant des codes postaux à la solvabilité.

Biais de données

Il se produit un biais de données lorsque les données utilisées pour effectuer l'apprentissage d'un modèle sont faussées d'une manière qui favorise certains groupes par rapport à d'autres. Le biais de données est causé par une représentation inégale des groupes dans les données d'apprentissage.

Par exemple, un jeu de données utilisé pour prédire des résultats d'embauche pourrait contenir des données qui représentent un sexe comme étant plus performant que l'autre.

Le biais de données peut être introduit dans les données d'apprentissage de plusieurs manières, notamment :

-

Collecte de données inappropriée dans laquelle certains groupes sont sous-représentés ou surreprésentés.

-

Données qui reflètent avec précision des modèles historiques, mais exposent le biais sous-jacent dans ces tendances et pratiques.

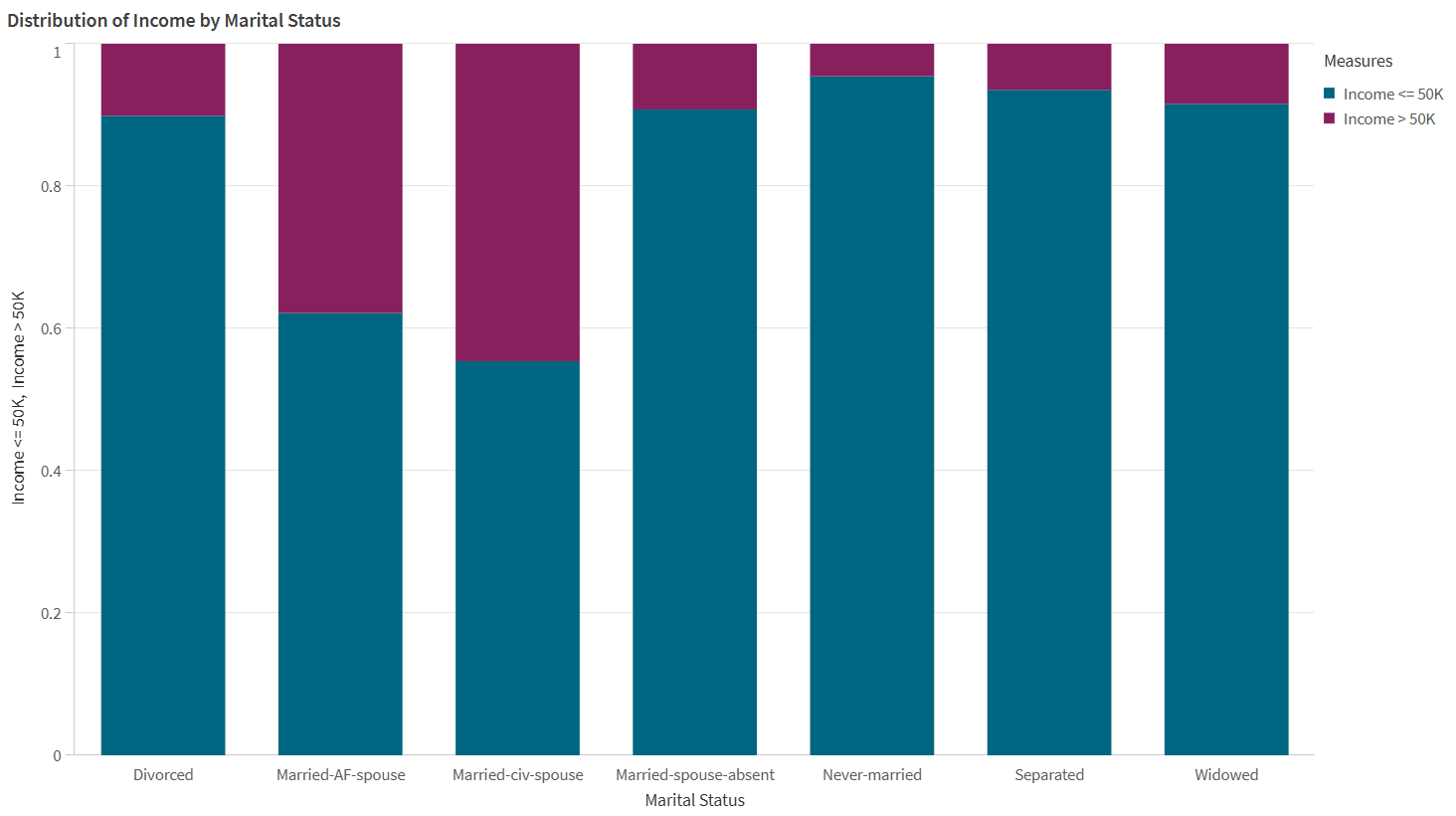

Les données de la visualisation ci-dessous indiquent un biais de données.

Exemple de biais de données, visualisé via un graphique à barres. Dans les données sources, certains états civils sont surreprésentés par rapport à d'autres en ce qui concerne les niveaux de revenus.

Biais de modèle

Il se produit un biais de modèle, ou biais algorithmique, lorsque les prédictions effectuées par un modèle d'apprentissage automatique favorisent certains groupes par rapport à d'autres. Avec le biais de modèle, les modèles établissent des associations entre certains groupes et les résultats, impactant négativement d'autres groupes. Le biais de modèle peut être causé par des données mal collectées ou biaisées, ainsi que par des comportements spécifiques à l'algorithme d'apprentissage utilisé.

Par exemple, un modèle pourrait prédire des taux d'embauche négatifs disproportionnés pour certaines tranches d'âge en raison d'associations injustes effectuées par le modèle.

Visualisation de l'onglet Analyser dans une expérimentation ML, mettant en évidence un biais de modèle. La visualisation montre qu'un modèle effectue des prédictions de revenus plus élevées pour certains états civils que pour d'autres.

Métriques de biais de données

Dans Qlik Predict, le biais de données est mesuré via l'analyse des éléments suivants :

-

Taux de représentation : compare la distribution des données appartenant à chaque groupe de la caractéristique à l'ensemble des données de la caractéristique. Le ratio de parité du taux de représentation est la métrique calculée.

-

Ratio de parité dans la distribution conditionnelle : compare l'équilibre entre les données de chaque groupe de la caractéristique aux valeurs de la colonne cible. Le ratio de parité dans la répartition conditionnelle est la métrique calculée.

Pour en savoir plus sur les valeurs acceptables de ces métriques, consultez Valeurs acceptables des métriques de biais.

Métriques de biais de modèle

Dans Qlik Predict, les métriques de biais de modèle sont le mieux comprises dans le contexte du type de modèle utilisé pour l'expérimentation. De manière générale, on trouve les catégories de métriques de biais suivantes :

-

Métriques de modèle de classification

-

Métriques de modèle de régression et de série temporelle

Pour en savoir plus sur les valeurs acceptables de ces métriques, consultez Valeurs acceptables des métriques de biais.

Modèles de classification

Dans les modèles de classification binaire et multiclasse, le biais est mesuré via l'analyse des valeurs cibles prédites (résultats). En particulier, on compare les différences de taux de résultats positifs et négatifs des groupes (ici, « positif » et « négatif » désignent des résultats favorables et défavorables, par exemple, une valeur oui ou non pour une colonne cible Embauché). Ces modèles comportent les métriques de biais suivantes :

-

Impact différencié

-

Différence de parité statistique

-

Différence dans l'égalité des chances

Impact différencié

Le ratio Impact différencié (Disparate Impact ou DI en anglais) évalue si des groupes d'une caractéristique sensible sont favorisés ou lésés dans les résultats prédits du modèle. Il est mesuré via le calcul de la fréquence à laquelle chaque groupe est sélectionné comme valeur prédite, en la comparant au taux de sélection du groupe le plus favorisé de la caractéristique.

Différence de parité statistique

Similaire à l'impact différencié, la Différence de parité statistique (Statistical Parity Difference ou SPD en anglais) évalue les prédictions du modèle pour déterminer si elles favorisent ou lèsent des groupes individuels. La métrique est calculée via la comparaison des taux de résultats positifs entre les groupes les plus grands et les plus petits.

Différence dans l'égalité des chances

La Différence dans l'égalité des chances (Equal Opportunity Difference ou EOD en anglais) est similaire aux deux autres métriques de biais de modèle de classification. L'EOD compare les taux de vrais positifs les plus élevés et les plus bas entre les groupes d'une caractéristique.

Modèles de régression et de série temporelle

Dans les modèles de régression et de série temporelle, le biais est mesuré via la comparaison de la fréquence à laquelle les modèles commettent des erreurs dans leurs prédictions, en utilisant des ratios de parité pour déterminer l'équité des résultats prédits.

Les métriques de biais suivantes sont calculées, en utilisant des métriques d'erreur couramment employées pour évaluer l'exactitude du modèle :

Valeurs acceptables des métriques de biais

| Métrique de biais | Catégorie de biais | Types de modèles applicables | Valeurs acceptables |

|---|---|---|---|

| Ratio de parité dans le taux de représentation | Biais de données | Tout |

Valeur idéale : entre 0,8 et 1. Un ratio inférieur indique une représentation disproportionnée. |

| Ratio de parité dans la répartition conditionnelle | Biais de données | Tout |

Valeur idéale : entre 0,8 et 1. Un ratio inférieur indique une représentation disproportionnée. |

| Différence de parité statistique (SPD) | Biais de modèle | Classification binaire, classification multiclasse |

Valeur idéale : 0. Une valeur supérieure à 0,2 est un signal fort d'iniquité. |

| Impact différencié (DI) | Biais de modèle | Classification binaire, classification multiclasse |

Valeur idéale : 1. Une valeur inférieure à 0,8 signale une iniquité. |

| Différence dans l'égalité des chances (EOD) | Biais de modèle | Classification binaire, classification multiclasse |

Valeur idéale : 0. Une valeur supérieure à 0,1 signale une iniquité. |

| Ratio de parité MAE | Biais de modèle | Régression |

Valeur idéale : entre 0,8 et 1. Une valeur supérieure à 1,25 signale une iniquité. |

| Ratio de parité MSE | Biais de modèle | Régression |

Valeur idéale : entre 0,8 et 1. Une valeur supérieure à 1,25 signale une iniquité. |

| Ratio de parité RMSE | Biais de modèle | Régression |

Valeur idéale : entre 0,8 et 1. Une valeur supérieure à 1,25 signale une iniquité. |

| Variance R2 | Biais de modèle | Régression |

Valeur idéale : 0. Une valeur supérieure à 0,2 signale une iniquité. |

| Ratio de parité MASE | Biais de modèle | Série temporelle | Une valeur supérieure à 1,25 signale une iniquité. |

| Ratio de parité MAPE | Biais de modèle | Série temporelle | Une valeur supérieure à 1,25 signale une iniquité. |

| Ratio de parité SMAPE | Biais de modèle | Série temporelle | Une valeur supérieure à 1,25 signale une iniquité. |

Configuration de la détection de biais

La détection de biais est configurée par caractéristique d'apprentissage dans la version d'expérimentation.

Procédez comme suit :

-

Dans une expérimentation ML, développez Biais dans le panneau de configuration de l'apprentissage.

-

Sélectionnez les caractéristiques sur lesquelles vous souhaitez exécuter la détection de biais.

Sinon, activez la détection de biais pour les caractéristiques souhaitées dans Vue du schéma.

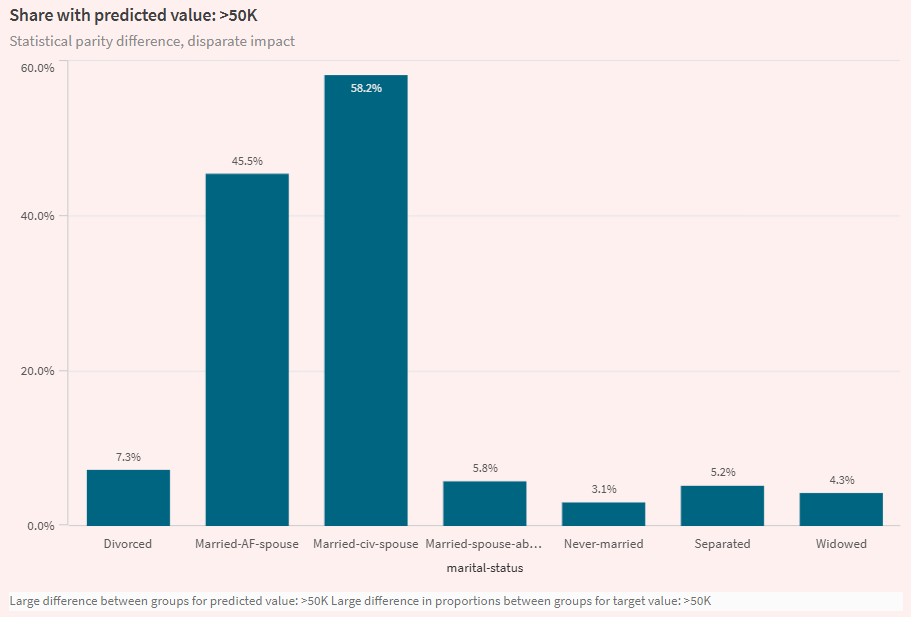

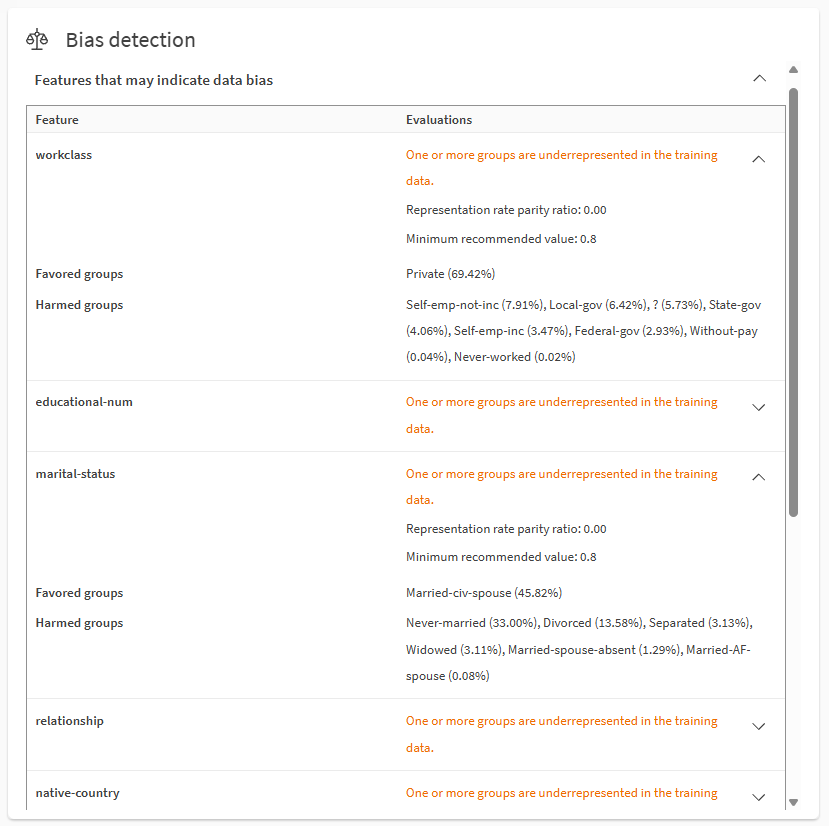

Analyse rapide des résultats des biais

Une fois l'apprentissage terminé, vous pouvez obtenir une vue d'ensemble rapide des résultats de détection des biais dans l'onglet Modèles.

Faites défiler les éléments d'analyse rapide pour trouver Détection de biais. Développez les sections à l'aide des icônes . Vous pouvez analyser les caractéristiques présentant des biais de données et de modèle potentiels.

Analyse des biais de données à l'aide de la section Détection de biais de l'onglet Modèles.

Notes

-

Les Groupes favorisés représentent les valeurs ou plages cibles surreprésentées dans les données ou les résultats projetés de la cible, en fonction des métriques de biais. Les Groupes défavorisés représentent les valeurs ou plages cibles sous-représentées dans les données ou les résultats projetés de la cible, en fonction des métriques de biais.

Pour des informations sur la manière dont les métriques de biais sont utilisées, consultez Valeurs acceptables des métriques de biais.

Les nombres entre parenthèses décrivent les critères utilisés pour calculer la métrique. Par exemple, si la métrique est la différence dans l'égalité des chances (EOD), femmes (10 %) et hommes (80 %) indique des taux de vrais positifs de 80 % pour les hommes et de 10 % pour les femmes.

-

Résultat de la cible fait référence à la valeur de la colonne cible qui est prédite par le modèle.

-

Toutes les métriques et valeurs de biais ne sont pas affichées dans l'onglet Modèles en raison de l'espace limité. Par exemple :

-

Selon les types de métrique et de modèle, certaines métriques et certains groupes peuvent n'inclure que des minimums et des maximums.

-

Si plusieurs métriques dépassent le seuil de biais d'une caractéristique, la métrique indiquant le degré le plus élevé d'iniquité est affichée.

-

Pour les caractéristiques biaisées dans les modèles de classification multiclasse, seule la métrique indiquant le degré d'iniquité le plus élevé est affichée.

-

-

Des informations plus détaillées sont disponibles dans l'onglet Analyser et le rapport d'apprentissage du modèle. Consultez Analyse détaillée des résultats des biais.

- Pour plus d'informations sur la terminologie de cette section, consultez Terminologie sur cette page.

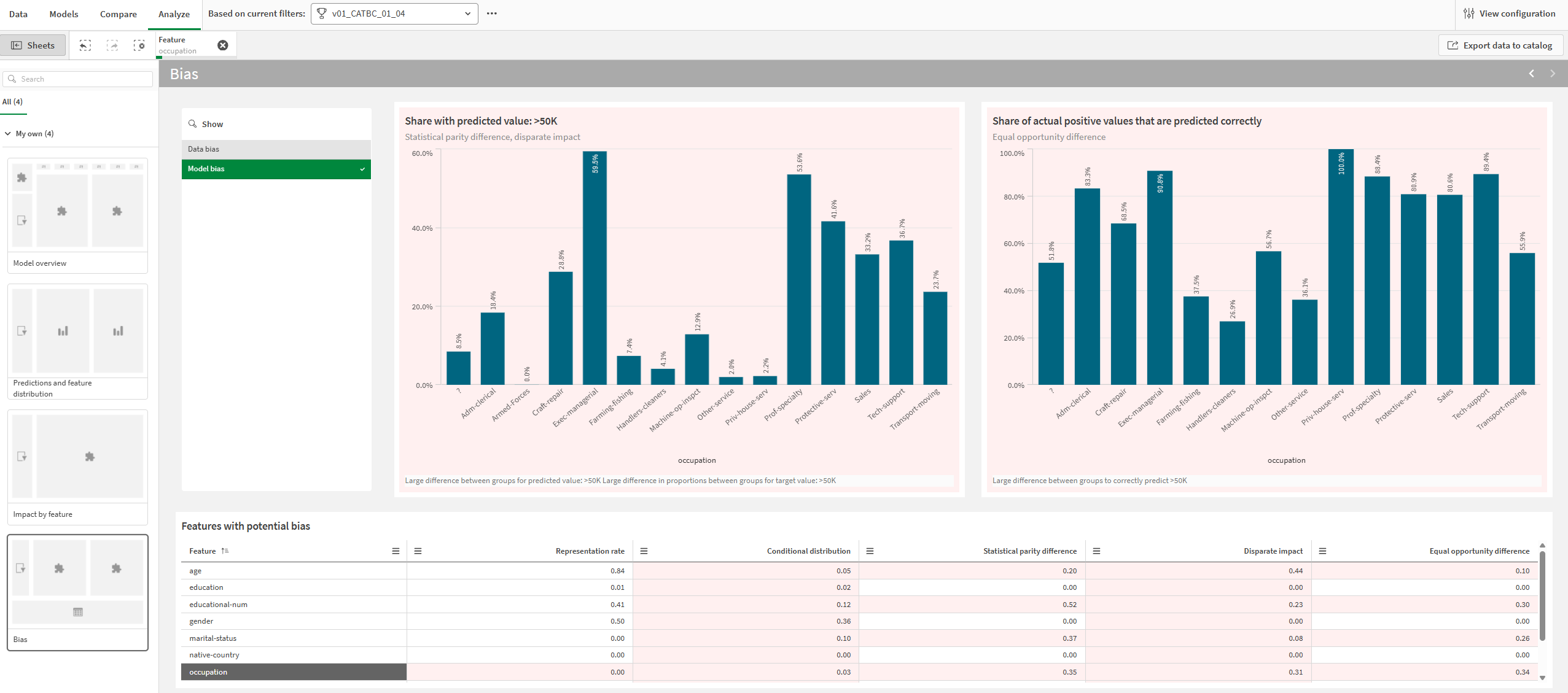

Analyse détaillée des résultats des biais

Vous pouvez approfondir les résultats des biais dans l'onglet Analyser.

Procédez comme suit :

-

Dans une expérimentation ML, sélectionnez un modèle et accédez à l'onglet Analyser.

-

Ouvrez la feuille Biais.

-

Faites votre choix entre Biais de données et Biais de modèle en fonction de l'analyse souhaitée.

-

Dans le tableau Caractéristiques avec biais potentiel, sélectionnez une seule caractéristique.

Les graphiques et les métriques qui indiquent un biais possible sont affichés avec un arrière-plan rouge. Vous pouvez sélectionner des caractéristiques en cliquant sur les visualisations et en y traçant des zones.

Les métriques du tableau sont statiques pour les métriques de biais correspondant aux caractéristiques standards. Pour les caractéristiques futures, les métriques de biais changent dynamiquement en fonction de la sélection Groupe de séries temporelles.

Onglet Analyser affichant une analyse de biais de modèle pour la caractéristique sélectionnée. Un biais possible est indiqué par des arrière-plans rouges dans les graphiques et les métriques.

Pour plus d'informations sur le parcours des analyses de modèle détaillées, consultez Réalisation d'une analyse de modèle détaillée.

Résultats des biais dans les rapports d'apprentissage

Les métriques de biais sont également présentées dans les rapports d'apprentissage ML. Elles sont incluses dans une section Biais dédiée dans le rapport.

Pour plus d'informations sur les rapports d'apprentissage, consultez Téléchargement de rapports d'apprentissage ML.

Gestion des biais

Après avoir analysé les résultats de détection des biais de vos modèles, vous pourriez vouloir effectuer l'une des opérations suivantes :

-

Exécuter de nouvelles versions d'expérimentation après avoir abandonné les caractéristiques biaisées.

-

Éviter de déployer des modèles qui présentent des biais et déployer plutôt des modèles qui répondent aux critères recommandés pour les métriques de biais.

-

Mettre à jour votre jeu de données pour corriger toute collecte de données inappropriée ou pour remédier à des taux de représentation inégaux.

-

Redéfinir votre problème d'apprentissage automatique à l'aide du cadre structuré. Par exemple, si votre question d'apprentissage automatique initiale est intrinsèquement biaisée, les modèles seront probablement toujours peu fiables pour créer des prédictions équitables.

Définition de questions d'apprentissage automatique

Utilisation de la projection de série temporelle multivariables

Terminologie sur cette page

Sur cette page et dans Qlik Predict, le terme « Groupes » a des significations différentes selon le contexte :

-

Le terme « Groupes » désigne les valeurs ou les plages des caractéristiques qui sont analysées à des fins de détection des biais. Par exemple, une caractéristique État civil peut avoir quatre groupes possibles dans les données d'apprentissage : Marié, Divorcé, Séparé ou Veuf.

-

Dans les expérimentations de série temporelle, les « Groupes » permettent de suivre les résultats cibles pour rechercher des valeurs spécifiques de caractéristiques compatibles. Sur cette page, ces groupes sont appelés « Groupes de séries temporelles ». Pour plus d'informations sur ces groupes, consultez Groupes.

Limitations

-

Vous ne pouvez pas activer la détection de biais pour :

-

La caractéristique cible.

-

Les caractéristiques sous forme de texte libre (même si le type de caractéristique est remplacé par catégorique).

-

Les caractéristiques de type date qui sont utilisées comme index de date dans les expérimentations de série temporelle.

-

Les caractéristiques de type date auto-conçues. Vous pouvez exécuter la détection de biais sur ces caractéristiques, mais vous ne les activez pas indépendamment. Au lieu de cela, activez la caractéristique de date parente pour la détection de biais et assurez-vous que les caractéristiques de date auto-conçues sont incluses dans l'apprentissage.

-