Detectando viés em modelos de aprendizado de máquina

Você pode identificar viés em modelos de aprendizado de máquina que você treina em experimentos de ML. Corrija o viés detectado descartando recursos distorcidos, corrigindo a coleta inadequada de dados ou alterando a estrutura do seu conjunto de dados de treinamento.

Entendendo o viés

No aprendizado de máquina, o viés é um fenômeno indesejado no qual os modelos favorecem, ou poderiam favorecer, certos grupos em detrimento de outros. O viés afeta negativamente a imparcialidade e tem implicações éticas para previsões e as decisões que elas influenciam. O viés pode ser introduzido em dados de treinamento, nos resultados previstos por modelos treinados, ou em ambos.

Exemplos de viés — e suas consequências para a tomada de decisões — incluem:

-

Treinamento de modelos com dados que representam desproporcionalmente certos níveis de renda ou condições de saúde, resultando em decisões injustas para pedidos de indenização de seguros.

-

Treinamento de modelos com dados distorcidos em relação à raça e ao gênero dos candidatos, afetando as decisões de contratação.

-

Treinamento de modelos que associam códigos postais à capacidade de crédito.

Viés de dados

O viés de dados ocorre quando os dados usados para treinar um modelo são distorcidos de uma forma que favorece certos grupos em detrimento de outros. O viés de dados é causado pela representação desigual entre grupos nos dados de treinamento.

Por exemplo, um conjunto de dados para prever resultados de contratação poderia conter dados que representam um gênero como sendo mais bem-sucedido do que outros.

O viés de dados pode ser introduzido nos dados de treinamento de várias maneiras, incluindo:

-

Coleta de dados inadequada na qual certos grupos são sub ou super-representados.

-

Dados que refletem padrões históricos com precisão, mas expõem o viés subjacente nestas tendências e práticas.

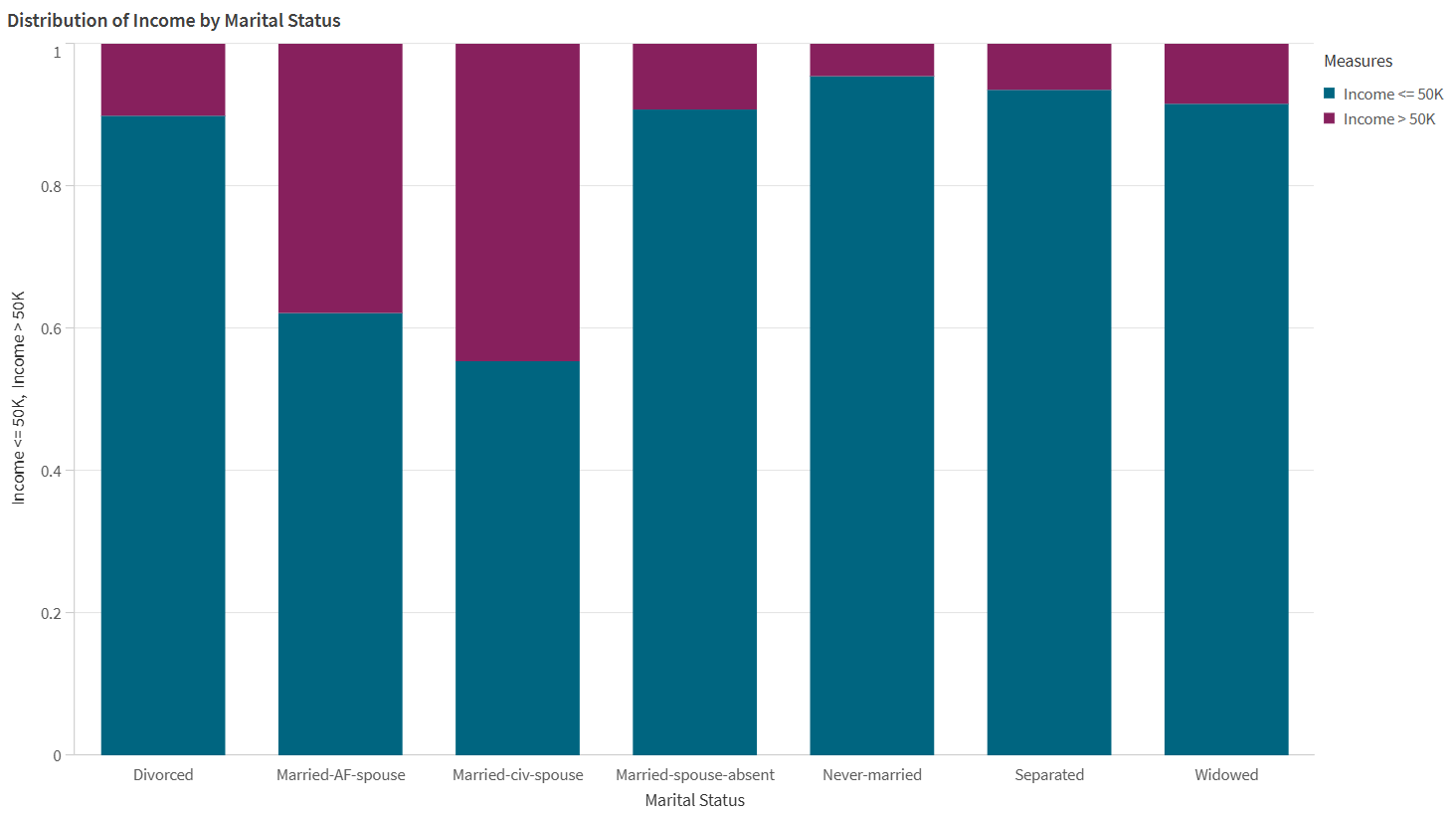

Os dados na visualização abaixo indicam viés de dados.

Um exemplo de viés de dados, visualizado por um gráfico de barras. Nos dados de origem, certos estados civis estão super-representados em comparação com outros em relação aos níveis de renda.

Viés de modelo

O viés do modelo, ou viés algorítmico, ocorre quando as previsões feitas por um modelo de aprenzidado de máquina favorecem alguns grupos em detrimento de outros. Com o viés do modelo, os modelos fazem associações entre certos grupos e resultados, impactando negativamente outros grupos. O viés do modelo pode ser causado por dados coletados incorretamente ou distorcidos, bem como por comportamentos específicos do algoritmo de treinamento em uso.

Por exemplo, um modelo poderia prever taxas de contratação desproporcionalmente negativas para certos grupos etários devido a associações injustas feitas pelo modelo.

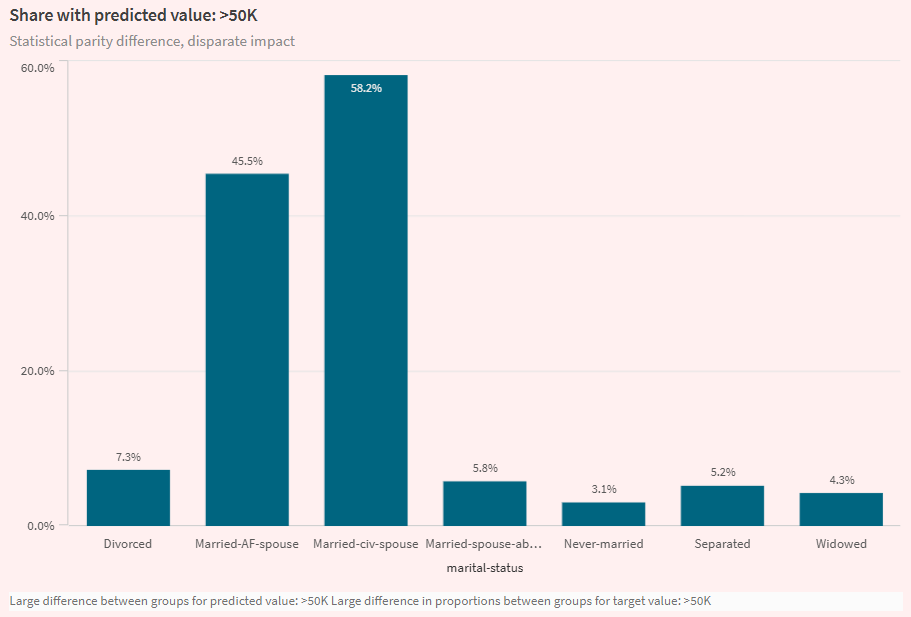

Visualização da guia Analisar em um experimento de ML, destacando o viés do modelo. A visualização mostra que um modelo faz previsões de renda mais altas para certos estados civis do que para outros.

Métricas de viés de dados

No Qlik Predict, o viés de dados é medido analisando:

-

Taxa de representação: compara a distribuição de dados pertencentes a cada grupo no recurso, em comparação com todos os dados no recurso. A métrica calculada é a taxa de paridade da taxa de representação.

-

Taxa de paridade da distribuição condicional: compara o equilíbrio entre os dados de cada grupo no recurso, em relação aos valores da coluna alvo. A métrica calculada é a razão de paridade de distribuição condicional.

Para saber mais sobre os valores aceitáveis para essas métricas, consulte Valores aceitáveis para métricas de viés.

Métricas de viés do modelo

No Qlik Predict, as métricas de viés do modelo são melhor compreendidas no contexto do tipo de modelo para o experimento. Em termos gerais, existem as seguintes categorias de métricas de viés:

-

Métricas do modelo de classificação

-

Métricas de modelo de regressão e série temporal

Para saber mais sobre os valores aceitáveis para essas métricas, consulte Valores aceitáveis para métricas de viés.

Modelos de classificação

Em modelos de classificação binária e multiclasse, o viés é medido analisando os valores-alvo previstos (resultados). Em particular, as diferenças nas taxas de resultados positivos e negativos para grupos são comparadas ("positivo" e "negativo" aqui se referem a resultados que são favoráveis versus desfavoráveis — por exemplo, um valor de sim ou não para uma coluna alvo Contratado). Esses modelos têm as seguintes métricas de viés:

-

Impacto desproporcional

-

Diferença de paridade estatística

-

Diferença de igualdade de oportunidades

Impacto desproporcional

A razão de impacto desproporcional (DI) avalia se grupos em um recurso sensível estão sendo favorecidos ou prejudicados nos resultados previstos pelo modelo. Ela é medida calculando a frequência com que cada grupo é selecionado como o valor previsto, comparando-a com a taxa de seleção do grupo mais favorecido no recurso.

Diferença de paridade estatística

Semelhante ao impacto desproporcional, a diferença de paridade estatística (SPD) avalia as previsões do modelo para determinar se elas favorecem ou prejudicam algum grupo individual. A métrica é calculada comparando as taxas de resultados positivos entre os grupos maior e menor.

Diferença de igualdade de oportunidades

A diferença de igualdade de oportunidades (EOD) é semelhante às outras duas métricas de viés do modelo de classificação. A EOD compara as taxas de verdadeiros positivos mais altas e mais baixas entre os grupos em um recurso.

Modelos de regressão e séries temporais

Em modelos de regressão e séries temporais, o viés é medido comparando a frequência com que os modelos cometem erros em suas previsões, usando taxas de paridade para determinar a imparcialidade dos resultados previstos.

As seguintes métricas de viés são calculadas, usando métricas de erro que são comumente usadas para avaliar a acurácia do modelo:

Valores aceitáveis para métricas de viés

| Métrica de viés | Categoria do viés | Tipos de modelo aplicáveis | Valores aceitáveis |

|---|---|---|---|

| Razão de paridade da taxa de representação | Viés de dados | Tudo |

Valor ideal: entre 0,8 e 1. Uma proporção menor indica representação desproporcional. |

| Razão de paridade de distribuição condicional | Viés de dados | Tudo |

Valor ideal: entre 0,8 e 1. Uma proporção menor indica representação desproporcional. |

| Diferença de paridade estatística (SPD) | Viés de modelo | Classificação binária, classificação multiclasse |

Valor ideal: 0. Um valor acima de 0,2 é um forte sinal de injustiça. |

| Impacto desproporcional (DI) | Viés de modelo | Classificação binária, classificação multiclasse |

Valor ideal: 1. Um valor abaixo de 0,8 sinaliza injustiça. |

| Diferença de igualdade de oportunidades (EOD) | Viés de modelo | Classificação binária, classificação multiclasse |

Valor ideal: 0. Um valor acima de 0.1 sinaliza injustiça. |

| Razão de paridade MAE | Viés de modelo | Regressão |

Valor ideal: entre 0,8 e 1. Um valor acima de 1.25 sinaliza injustiça. |

| Razão de paridade MSE | Viés de modelo | Regressão |

Valor ideal: entre 0,8 e 1. Um valor acima de 1.25 sinaliza injustiça. |

| Razão de paridade RMSE | Viés de modelo | Regressão |

Valor ideal: entre 0,8 e 1. Um valor acima de 1.25 sinaliza injustiça. |

| Lacuna R2 | Viés de modelo | Regressão |

Valor ideal: 0. Um valor acima de 0.2 sinaliza injustiça. |

| Razão de paridade MASE | Viés de modelo | Série temporal | Um valor acima de 1.25 sinaliza injustiça. |

| Razão de paridade MAPE | Viés de modelo | Série temporal | Um valor acima de 1.25 sinaliza injustiça. |

| Razão de paridade SMAPE | Viés de modelo | Série temporal | Um valor acima de 1.25 sinaliza injustiça. |

Configurando a detecção de viés

A detecção de viés é configurada por recurso de treinamento na versão do experimento.

Faça o seguinte:

-

Em um experimento de ML, expanda Viés no painel de configuração de treinamento.

-

Selecione os recursos nos quais você deseja executar a detecção de viés.

Alternativamente, ative a detecção de viés para os recursos desejados na Exibição de esquema.

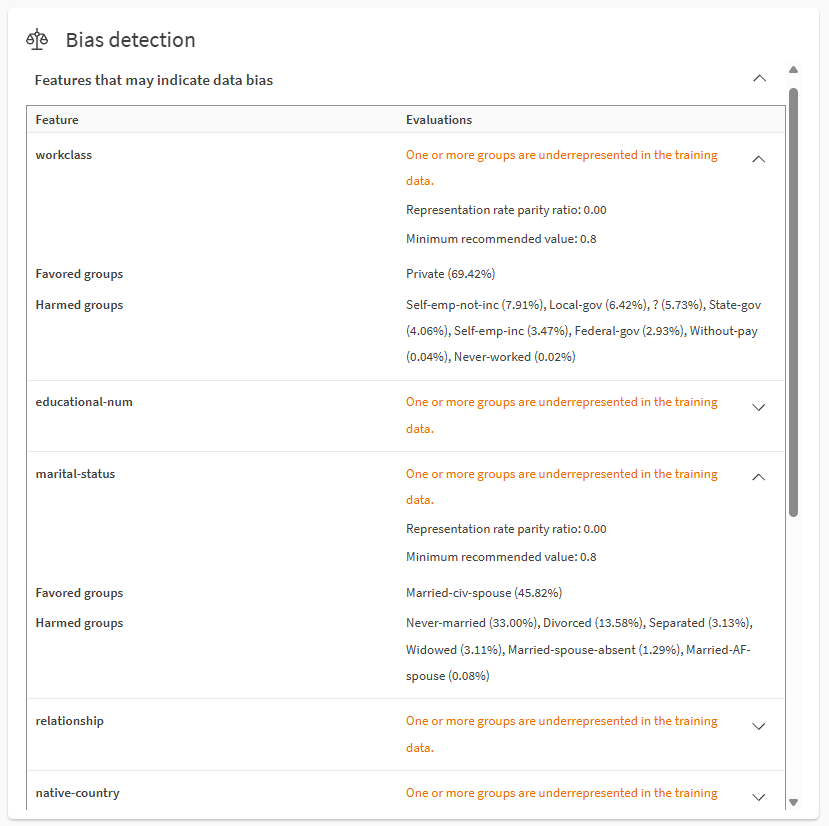

Análise rápida dos resultados de viés

Após a conclusão do treinamento, você pode obter uma rápida visão geral dos resultados da detecção de viés na guia Modelos.

Role para baixo nos itens de análise rápida para encontrar Detecção de viés. Expanda as seções usando os ícones . Você pode analisar recursos com possíveis vieses de dados e de modelo.

Analisando o viés de dados usando a seção Detecção de viés na guia Modelos.

Notas

-

Grupos favorecidos são os valores ou intervalos alvo que estão super-representados nos dados ou resultados projetados do destino, com base nas métricas de viés. Grupos prejudicados são os valores ou intervalos alvo que estão sub-representados nos dados ou nos resultados projetados do alvo, com base nas métricas de viés.

Para obter informações sobre como as métricas de viés são usadas, consulte Valores aceitáveis para métricas de viés.

Os números entre parênteses descrevem os critérios usados para calcular a métrica. Por exemplo, se a métrica for diferença de oportunidade igual (EOD), feminino (10%) e masculino (80%) indicará taxas de verdadeiros positivos de 80% para masculino e 10% para feminino.

-

Resultado alvo refere-se ao valor da coluna alvo que é previsto pelo modelo.

-

Nem todas as métricas e valores de viés são mostrados na guia Modelos devido ao espaço limitado. Por exemplo:

-

Dependendo dos tipos de métrica e modelo, algumas métricas e grupos podem incluir apenas mínimos e máximos.

-

Se várias métricas excederem o limite de viés para um recurso, a métrica que indica o maior grau de injustiça será exibida.

-

Para recursos distorcidos em modelos de classificação multiclasse, apenas a métrica que indica o maior grau de injustiça é exibida.

-

-

Informações mais detalhadas estão disponíveis na guia Analisar e no relatório de treinamento do modelo. Consulte Análise detalhada dos resultados de viés.

- Para obter mais informações sobre a terminologia nesta seção, consulte Terminologia nesta página.

Análise detalhada dos resultados de viés

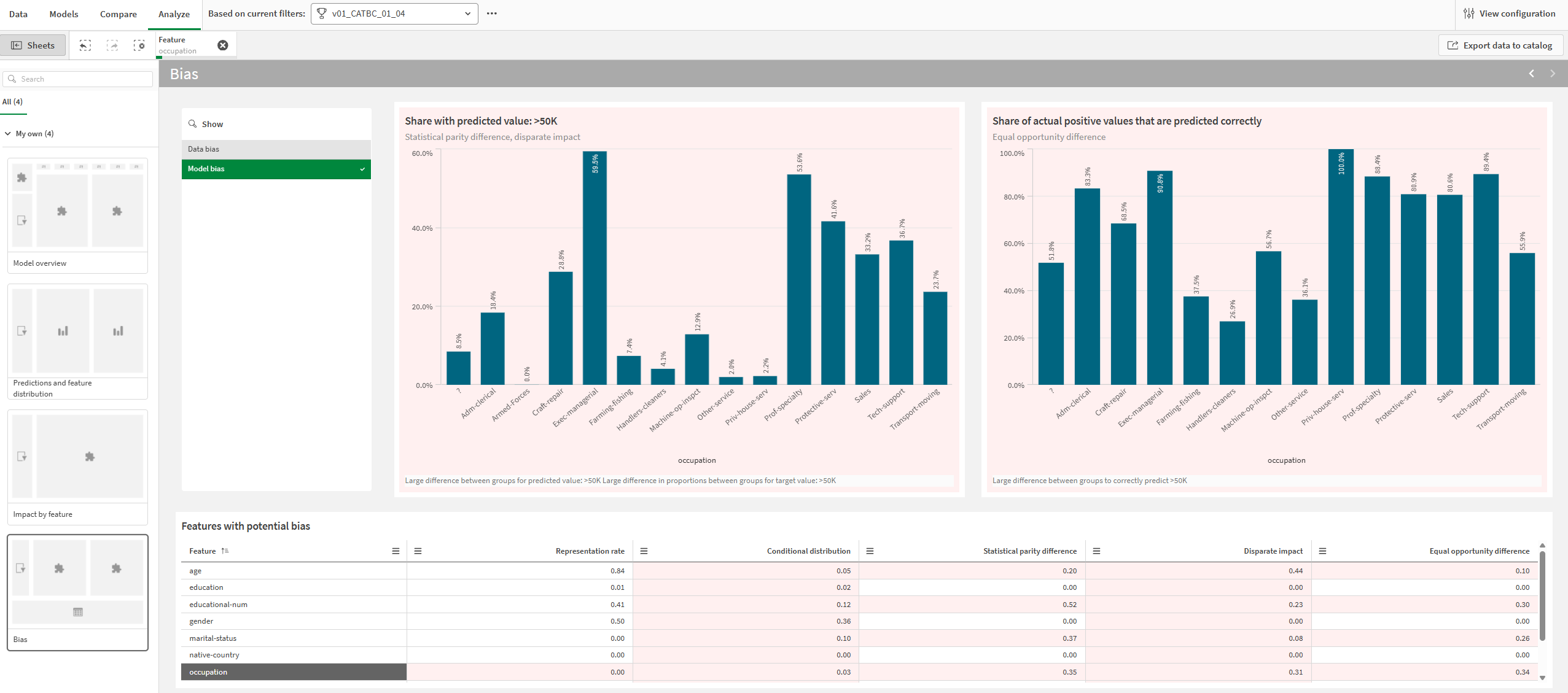

Você pode se aprofundar nos resultados de viés na guia Analisar.

Faça o seguinte:

-

Em um experimento de ML, selecione um modelo e vá para a guia Analisar.

-

Abra a pasta Viés.

-

Selecione entre Viés de dados e Viés de modelo dependendo da análise desejada.

-

Na tabela Recursos com viés potencial, selecione um único recurso.

Gráficos e métricas que indicam possível viés são exibidos com um fundo vermelho. Você pode selecionar recursos clicando e desenhando nas visualizações.

As métricas na tabela são estáticas para métricas de viés correspondentes a recursos padrão. Para recursos futuros, as métricas de viés mudam dinamicamente dependendo da seleção do grupo de séries temporais.

Guia Analisar mostrando uma análise do viés do modelo para o recurso selecionado. O possível viés é indicado por fundos vermelhos para gráficos e métricas.

Para obter mais informações sobre como navegar em análises detalhadas de modelos, consulte Executando análise detalhada de modelo.

Resultados de viés em relatórios de treinamento

Métricas de viés também são apresentadas em relatórios de treinamento de ML. Elas são incluídas em uma seção dedicada de Viés no relatório.

Para obter mais informações sobre o treinamento de relatórios, consulte Download de relatórios de treinamento de ML.

Tratando viés

Após analisar os resultados da detecção de viés para seus modelos, você pode querer fazer qualquer um dos seguintes:

-

Executar novas versões de experimento após descartar os recursos distorcidos.

-

Evite implementar modelos que apresentem viés; em vez disso, implemente modelos que atendam aos critérios recomendados para métricas de viés.

-

Atualizar seu conjunto de dados para corrigir qualquer coleta de dados inadequada ou para abordar taxas de representação desiguais.

-

Redefinir seu problema de aprendizado de máquina usando a estrutura organizada. Por exemplo, se sua pergunta original de aprendizado de máquina for inerentemente tendenciosa, os modelos provavelmente sempre serão não confiáveis na criação de previsões justas.

Terminologia nesta página

Nesta página, e no Qlik Predict, "grupos" é um termo que tem significados diferentes dependendo do contexto:

-

"Grupos" refere-se aos valores ou intervalos em recursos que estão sendo analisados para viés. Por exemplo, um recurso de Estado Civil pode ter quatro grupos possíveis nos dados de treinamento: Casado, Divorciado, Separado ou Viúvo.

-

Em experimentos de séries temporais, "grupos" refere-se à funcionalidade que permite que os resultados-alvo sejam rastreados para valores específicos de recursos compatíveis. Nesta página, esses grupos são referidos como "grupos de séries temporais". Para obter mais informações sobre esses grupos, consulte Grupos.

Limitações

-

Não é possível ativar a detecção de viés para:

-

O recurso alvo.

-

Recursos de texto livre (mesmo que o tipo de recurso seja alterado para categórico).

-

Recursos de data que são usados como índice de data em experimentos de séries temporais.

-

Recursos de data de engenharia automática. Você pode executar a detecção de viés nesses recursos, mas não os ativa independentemente. Em vez disso, ative o recurso de data principal para detecção de viés e garanta que os recursos de data de engenharia automática sejam incluídos para treinamento.

-