Replikeringsinställningar

Du kan konfigurera inställningar för datareplikeringsuppgiften.

-

Öppna replikeringsuppgiften och klicka på Inställningar i verktygsfältet.

Dialogrutan Inställningar: <Uppgift-Namn> öppnas. De tillgängliga inställningarna beskrivs nedan.

Allmänt

I den här fliken kan du ändra replikeringsläge, inställningar för mellanlagring (om de är tillgängliga), läget för att tillämpa ändringar på målet och publiceringsinställningar.

Replikeringsläge

Följande replikeringslägen är tillgängliga:

-

Fullständig laddning Laddar data från de valda källtabellerna till målplattformen och skapar måltabellerna vid behov. Den fullständiga laddningen sker automatiskt när uppgiften startar, men kan också utföras manuellt vid behov. Manuell fullständig laddning krävs t.ex. om du behöver replikera uppdateringar till vyer (som inte fångas upp under CDC) eller om du replikerar från en datakälla som inte stöder CDC.

-

Tillämpa ändringar: Håller måltabellerna uppdaterade med de ändringar som görs i källtabellerna.

-

Lagra ändringar: Lagrar ändringarna i källtabellerna i Change Tables (en per källtabell).

Se Lagra ändringar för mer information.

När du arbetar med Gateway för dataflytt registreras ändringar från källan i nära realtid. När du arbetar utan Gateway för dataflytt (t.ex. med en Qlik Talend Cloud Starter-prenumeration eller när du väljer Inga) registreras ändringar enligt schemaläggarens inställningar. Se Replikeringsinställningar för mer information.

Om du väljer Lagra ändringar eller Tillämpa ändringar och dina källdata innehåller tabeller som inte stöder CDC eller vyer, skapas två datapipelines. En pipeline för tabeller som stöder CDC, och en annan pipeline för alla andra tabeller och vyer som endast stöder Fullständig laddning.

Laddningsmetod

Vid replikering till Snowflake kan du välja en av följande laddningsmetoder:

-

Massinläsning (standard)

Om du väljer Massinläsning kan du justera inläsningparametrarna i fliken Datainläsning.

-

Snowpipe Streaming

Anteckning om informationSnowpipe Streaming kommer endast att vara tillgänglig för urval om följande villkor är uppfyllda:

- Replikeringsläget för Lagra ändringar är inställt, utan Tillämpa ändringar.

- Autentiseringsmekanismen i Snowflake-kopplingen är inställd på Nyckelpar.

- Om du använder Gateway för dataflytt krävs version 2024.11.45 eller senare.

Om du väljer Snowpipe Streaming, se till att du känner till begränsningarna och beaktanden när du använder den här metoden. Om du dessutom väljer Snowpipe Streaming och sedan aktiverar replikeringsläget för Tillämpa ändringar eller inaktiverar Lagra ändringar så kommer laddningsmetoden automatiskt att återställas till Massinläsningar.

De främsta anledningarna till att välja Snowpipe Ström framför Massinläsning är

-

Mindre kostsamt: Eftersom Snowpipe Streaming inte använder Snowflake-lagret bör driftskostnaderna vara betydligt billigare, även om detta beror på ditt specifika användningsfall.

-

Minskad latenstid: Eftersom data strömmas direkt till måltabellerna (utan mellanlagring) bör replikering från datakällan till målet vara snabbare.

Koppling till ett mellanlagringsområde

När replikering görs till de datalager som anges nedan behöver du konfigurera ett mellanlagringsområde. Data bearbetas och förbereds i mellanlagringsområdet innan det överförs till lagret.

Välj antingen ett befintligt mellanlagringsområde eller klicka på Skapa ny för att definiera ett nytt mellanlagringsområdet och följ instruktionerna i Ansluta till molnlagring.

Klicka på Redigera för att redigera kopplingsinställningarna. Klicka på Testa koppling för att testa kopplingen (rekommenderas).

Information om vilka mellanlagringsområden som stöds med vilka datalager finns i kolumnen Stöds som ett mellanlagringsområde i Användningsfall och versioner som stöds på målplattformen.

Tillämpa ändringar-läge

Ändringar tillämpas i måltabellerna med en av följande metoder:

- Batchoptimerad: detta är standardvärdet. När det här alternativet väljs tillämpas ändringar i batcher. En förbearbetningsåtgärd inträffar för att gruppera transaktionerna i batcher på det mest effektiva sättet.

- Transaktionell: Välj det här alternativet för att tillämpa varje transaktion individuellt i den ordning den allokeras. I det här fallet är strikt referentiell integritet säkerställd för alla tabeller.

Publiceringsinställningar

-

Publicera i katalogen

Välj det här alternativet för att publicera den här versionen av data till Katalogen som en datauppsättning. Kataloginnehållet kommer att uppdateras nästa gång du förbereder den här uppgiften.

Mer information om Katalog finns i Förstå data med hjälp av katalogverktyg.

Uppladdning av data

Den här fliken kommer bara att visas när datalagermål eller Kafka-mål replikeras. Dessutom kommer inställningarna på den här fliken att skilja sig åt beroende på det valda målet.

Relevant för alla datalagringsmål

Maximal filstorlek

Den maximala storleken en fil kan nå innan den stängs. Mindre filer kan laddas upp snabbare (beroende på nätverket) och förbättrar prestandan när de används i kombination med alternativet parallell körning. Att belamra databasen med små filer anses emellertid generellt vara en dålig arbetsmetod.

Relevant endast för Snowflake-mål

På fliken Allmänt kan du välja om du vill läsa in data till Snowflake med Massinläsning eller Snowpipe Streaming. När Snowpipe Streaming är valt visas inte fliken Inläsning av data ). När Massinläsning är valt kommer följande inställningar att vara tillgängliga:

-

Maximal filstorlek (MB): Relevant för den inledande fullständiga laddningen och CDC. Den maximala storleken en fil kan nå innan den laddas till målet. Om du får prestandaproblem kan du försöka justera den här parametern.

-

Antal filer att ladda per batch: Relevant endast för den inledande fullständiga laddningen. Antalet filer som ska laddas i en enda batch. Om du får prestandaproblem kan du försöka justera den här parametern.

För en beskrivning av laddningsmetoderna Massinläsning och Snowpipe Streaming, se Allmänt.

Relevant endast för Kafka-mål

Meddelandeinställningar

Komprimering

Välj eventuellt en av de tillgängliga komprimeringsmetoderna (Snappy eller Gzip). Standardvärdet är Ingen.

Publicering av datameddelande

Välj ett av följande Publicera data till alternativ:

- Specifikt ämne: Publicerar data till ett enda ämne. Antingen skriver du ett ämnesnamn eller använder bläddringsknappen för att välja önskat ämne.

-

Separat ämne för varje tabell: Publicerar data till flera ämnen som motsvarar källtabellnamnen.

Målets topic namn består av källschemanamnet och källtabellnamnet, separerat med en punkt (till exempel, dbo.Employees). Formatet på målets topic namn är viktigt eftersom du kommer att behöva förbereda dessa topics i förväg.

Om ämnena inte finns, konfigurera mäklarna med auto.create.topics.enable=true för att aktivera datauppgiften att skapa ämnena under körning. Annars kommer uppgiften att misslyckas.

För information om att åsidosätta denna inställning på datamängdsnivå, se Åsidosätta uppgiftsinställningar för enskilda datamängder vid publicering till Kafka

Meddelandenyckel

Välj ett av de tillgängliga alternativen.

-

Primärnyckelkolumner: För varje meddelande kommer meddelandenyckeln att innehålla värdet för primärnyckelkolumnen.

När Efter meddelandenyckel väljs som Partitionsstrategi, kommer meddelanden som består av samma primärnyckelvärde att skrivas till samma partition.

-

Schema- och tabellnamn: För varje meddelande kommer meddelandenyckeln att innehålla en kombination av schema- och tabellnamn (till exempel, dbo+Employees).

När Efter meddelandenyckel väljs som Partitionsstrategi, kommer meddelanden som består av samma schema- och tabellnamn att skrivas till samma partition.

- Ingen: Skapar meddelanden utan meddelandenyckel.

För information om att åsidosätta den här inställningen på datamängdsnivå, se Åsidosätta uppgiftsinställningar för enskilda datamängder vid publicering till Kafka

Partitionsstrategi

Välj antingen Slumpmässigt eller Efter meddelandenyckel. Om du väljer Slumpmässigt skrivs varje meddelande till en slumpmässigt vald partition. Om du väljer Efter meddelandenyckel skrivs meddelanden till partitioner baserat på den valda Meddelandenyckeln (beskrivs ovan).

Publicering av metadatameddelande

Strategi för ämnesnamn

Den första strategin (Schema- och tabellnamn) är en proprietär Qlik strategi medan de andra tre är standardstrategier för Confluent-ämnesnamn.

Välj en av de tillgängliga strategierna för ämnesnamn.

- Schema- och tabellnamn (standard)

- Namn på avsnitt

- Namn på post

- Namn på ämne och post

För mer information om Confluents strategier för ämnesnamn, se Strategi för ämnesnamn

Kompatibilitetsläge för ämne

Välj ett av följande kompatibilitetslägen från rullgardinslistan Kompatibilitetsläge för ämne:

-

Använd standardinställningar för schemaregistrering: Hämtar kompatibilitetsnivån från serverkonfigurationen för schemaregistreringen.

-

Bakåt – endast senaste schema: Nya scheman kan läsa motsvarande data och data som producerats av endast det senast registrerade schemat.

-

Bakåtkompatibel – Alla tidigare scheman: Nya scheman kan läsa data som producerats av alla tidigare registrerade scheman.

-

Framåt – Endast senaste schema: Senast registrerade schemat kan läsa data som producerats av det nya schemat.

-

Framåtkompatibel - alla tidigare scheman: Alla tidigare registrerade scheman kan läsa data som producerats av det nya schemat.

-

Komplett - endast senaste schema: Det nya schemat är bakåt- och framåtkompatibelt med det senast registrerade schemat.

-

Helt kompatibel - alla tidigare scheman: Nytt schema är bakåt- och framåtkompatibelt med alla tidigare registrerade scheman.

-

Inga

- Beroende på den valda ämnesnamnsstrategin kanske vissa av kompatibilitetslägena inte är tillgängliga.

-

När meddelanden publiceras till ett schemaregister kommer standardkompatibilitetsläget för ämnen för alla nyskapade kontrolltabellämnen att vara Ingen, oavsett valt kompatibilitetsläge för ämnen.

Om du vill att det valda kompatibilitetsläget för ämnen även ska gälla för kontrolltabeller, ställ in den interna parametern setNonCompatibilityForControlTables i Kafka-målkopplingen till false.

Använd en proxy för att ansluta till Confluent Schema Registry

Detta alternativ stöds endast vid publicering till Confluent Schema Registry.

Aktivera om din Gateway för dataflytt är konfigurerad att använda en proxyserver.

Meddelandeattribut

Du kan ange anpassade meddelandeattribut som åsidosätter standardmeddelandeattributen. Detta är användbart om konsumentapplikationen behöver bearbeta meddelandet i ett visst format.

Anpassade meddelandeattribut kan definieras på både uppgifts- och tabellnivå. När attributen definieras på både uppgifts-och tabellnivå, kommer meddelandeattributen som definieras för tabellen att ha företräde framför de som definieras för uppgiften.

För information om att åsidosätta meddelandeattributen på datamängdsnivå, se Åsidosätta uppgiftsinställningar för enskilda datamängder vid publicering till Kafka

Hierarkiskt strukturerade meddelanden stöds inte.

Allmänna regler och användningsriktlinjer

När du definierar ett anpassat meddelande är det viktigt att beakta reglerna och användningsriktlinjerna som listas nedan.

Avsnittsnamn

Följande namngivningsregler gäller:

- Delavsnittsnamn måste börja med tecknen a-z, A-Z eller _ (ett understreck) och kan sedan följas av vilket som helst av följande tecken: a-z, A-Z, 0-9, _

- Med undantag för Postnamn och Nyckelnamnsdelavsnitt (som inte slutar med ett snedstreck), kommer att ta bort snedstrecket från delavsnittsnamn att platta till hierarkin för det associerade delavsnittet (se Snedstreck nedan).

- Alla delavsnittsnamn utom Postnamn och Nyckelnamn kan tas bort (se Borttagning nedan)

-

Datnamn och Inkludera post före-data delavsnittsnamn kan inte båda tas bort

-

Namnen på delavsnitten Datanamn och Inkludera post före data kan inte vara desamma

Vissa av delavsnittsnamnen i användargränssnittet slutar med ett snedstreck (t.ex. beforeData/). Syftet med snedstrecket är att upprätthålla en hierarki av de olika delavsnitten i meddelandet. Om snedstrecket tas bort kommer följande att inträffa:

- Den hierarkiska strukturen för det delavsnittet kommer att plattas ut, vilket resulterar i att delavsnittsnamnet tas bort från meddelandet

- Delavsnittsnamnet kommer att läggas till som prefix till den faktiska metadata, antingen direkt eller med hjälp av ett skiljetecken (t.ex. ett understreck) som du lade till namnet

Exempel på ett datameddelande när headers/ anges med ett snedstreck:

"message":{

"data":{

"COL1": "159",

"COL2": "159"

},

"beforeData": null,

"headers": {

"operation": "INSERT",

"changeSequence": "2018100811484900000000233",

Exempel på ett datameddelande när headers_ anges med ett understreck istället för ett snedstreck:

"message":{

"data":{

"COL1": "159",

"COL2": "159"

},

"beforeData": null,

"headers_operation": "INSERT",

"headers_changeSequence": "2018100811484900000000233",

Om ett delavsnittsnamn tas bort från meddelandet plattas den hierarkiska strukturen för det delavsnittet ut. Detta kommer att resultera i att all data från det delavsnittet visas omedelbart under innehållet i det föregående delavsnittet.

Exempel på ett datameddelande med headers delavsnittsnamnet:

"message":{

"data":{

"COL1": "159",

"COL2": "159"

},

"headers": {

"operation": "INSERT",

"changeSequence": "2018100811484900000000233",

Exempel på ett datameddelande utan headers delavsnittsnamnet:

"message":{

"data":{

"COL1": "159",

"COL2": "159"

},

"beforeData": null,

"operation": "INSERT",

"changeSequence": "2018100811484900000000233",

Variabler

Du kan lägga till variabler i namn genom att klicka på knappen ![]() i slutet av raden. Följande variabler är tillgängliga:

i slutet av raden. Följande variabler är tillgängliga:

- SERVER_NAME – Värdnamnet för Gateway för dataflytt servern

- TARGET_TABLE_NAME – Namnet på tabellen

- TARGET_TABLE_OWNER – Tabellens ägare

- TASK_NAME – Namnet på datauppgiften

Variabeln TARGET_TABLE_OWNER är inte tillgänglig för alternativen Postnamn och Nyckelnamn (beskrivs i tabellen nedan).

Definiera anpassade meddelandeattribut

För att definiera ett anpassat meddelandeformat, aktivera Använd anpassade inställningar och konfigurera alternativen enligt beskrivningen i tabellen nedan.

För att återgå till standardmeddelandeattributen, inaktivera Använd anpassade inställningar.

| Alternativ | Beskrivning |

|---|---|

|

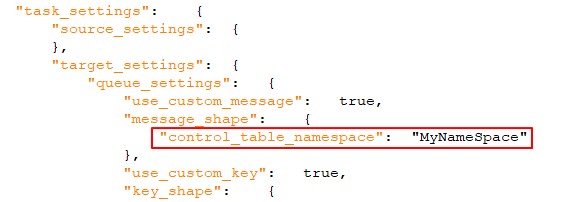

När den är aktiverad (standardinställningen) kommer en unik identifierare att inkluderas i meddelandet. Detta ska vara en sträng, avgränsad med punkter. Observera att namnutrymmet kommer att inkluderas både i meddelandet och i meddelandenyckeln. Exempel: mycompany.queue.msg Standardnamn: com.attunity.queue.msg.{{TASK_NAME}}.{{TARGET_TABLE_OWNER}}.{{TARGET_TABLE_NAME}} Standardnamn för kontrolltabeller: com.attunity.queue.msg.{{TARGET_TABLE_NAME}} Anteckning om information

Standardnamnrymden för kontrolltabellen kan inte ändras via användargränssnittet. Du kan dock ändra standardnamnrymden för kontrolltabellen på följande sätt:

|

|

|

Namn på post |

Namnet på posten (meddelandet). Standardnamn: Datapost |

|

Namn på data |

Alla datakolumner som ingår i posten. Standardnamn: data/ |

|

Inkludera rubriker |

När den är aktiverad (standardinställningen) kommer rubrikkolumner att inkluderas i meddelandet. Rubrikkolumner ger ytterligare information om källåtgärderna. Mer information finns i Inkludera följande rubriker nedan. |

|

Inkludera utrymme för rubriknamn |

När den är aktiverad (standardinställningen) kommer en unik identifierare för avsnittet med rubrikkolumner att inkluderas i meddelandet. Detta bör vara en sträng, separerad med punkter. Exempel: headers.queue.msg Standardnamn: com.attunity.queue.msg |

|

Rubriknamn |

Namnet på delavsnittet som innehåller Qlik kolumnrubrikerna. Standardnamn: rubriker/ |

|

För en beskrivning av de tillgängliga rubrikkolumnerna, se Datameddelanden i Qlik Hjälp. Standard: Alla kolumner inkluderas som standard, utom Externt schema-ID kolumnen. |

|

|

Inkludera postens tidigare data |

När aktiverad (standard) kommer både före och efter UPDATE-data att inkluderas i UPDATE-meddelanden. För att endast inkludera efter UPDATE-data i meddelanden, avaktivera alternativet. Standardnamn: föreData/ |

|

Nyckelnamn |

Namnet på delavsnittet som innehåller meddelandenyckeln. Standardnamn: nyckelpost Det här alternativet gäller endast när:

|

Ytterligare inställningar

-

Maximal meddelandestorlek

I fältet Maximal meddelandestorlek anger du den maximala storleken på meddelanden som mäklaren/mäklarna är konfigurerade att ta emot (message.max.bytes). Datatasken skickar inte meddelanden som är större än den maximala storleken.

Metadata

Enkel

-

Måltabellschema

Det schema på målet som källtabellerna kommer att replikeras till om du inte vill använda källtabellschemat (eller om det inte finns något schema i källdatabasen).

Anteckning om informationVid replikering till ett Oracle-mål är standardtabellschemat för målet "system". Observera också att om du lämnar detta fält tomt (i så fall kommer källschemat att användas) måste du se till att källschemat redan finns på målet. Annars kommer uppgiften att misslyckas.Anteckning om informationDen maximala tillåtna längden för schemanamnet är 128 tecken.

Mappning av JSON-kolumner

Mappa kompatibla JSON-kolumner från källa till mål

-

Om du använder Gateway för dataflytt för att komma åt din datakälla, krävs version 2024.11.70 eller senare.

-

Stöds endast med förhandsgranskningskopplingar för SaaS-applikationer.

När det här alternativet är valt mappas JSON-kolumner på källan automatiskt till JSON-kolumner på målet.

Det här alternativets tillstånd och synlighet bestäms av följande faktorer:

-

Nya uppgifter: Detta alternativ kommer att vara aktiverat som standard om både källan och målet stöder JSON-datatypen.

-

Befintliga uppgifter: Detta alternativ kommer att vara inaktiverat som standard, även om både källan och målet stöder JSON-datatypen. Detta är för att bevara bakåtkompatibilitet med nedströms processer – såsom transformationer – som förväntar sig att måldata ska vara i STRING-format (vilket är det äldre beteendet). Du kan antingen lämna alternativet inaktiverat eller så kan du redigera de nedströms processerna så att de är kompatibla med JSON-format, och sedan aktivera det här alternativet.

-

Nya och befintliga uppgifter: Om bara källan stöder JSON-datatypen kommer detta alternativ inte att vara synligt. Om JSON-stöd läggs till målet i ett senare skede kommer alternativet att bli synligt men förbli inaktiverat. Detta är för att bevara bakåtkompatibilitet med nedströms processer – såsom transformationer – som förväntar sig att måldata ska vara i STRING-format (vilket är det äldre beteendet).

LOB-inställningar

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.Tillgängliga LOB-inställningar varierar beroende på valt replikeringsmål. Eftersom datalagermål inte har stöd för obegränsade LOB-kolumnstorlekar kommer det här alternativet inte att vara tillgängligt vid replikering till ett datalager.

LOB-inställningar för mål som inte är datalager

- Inkludera inte LOB-kolumner: välj detta om du inte vill att käll-LOB-kolumnerna ska replikeras.

-

Begränsa LOB-kolumnstorlek till (KB): Detta är förvalt. Välj det här alternativet om du bara behöver replikera små LOB:ar eller om målplattformen inte har stöd för obegränsad LOB-storlek. Det maximala tillåtna värdet för det här fältet är 102 400 KB (100 MB).

När små LOB:ar replikeras är det här alternativet effektivare än alternativet Begränsa inte LOB-kolumnstorlek, eftersom LOB:arna replikeras "inline" och inte via sökning från källan. Under ändringsbearbetning replikeras små LOB:er vanligen via sökning från källan.

Gränsen gäller för antalet LOB-byte som läses från källans slutpunkt. För BLOB-kolumner kommer målstorleken för BLOB att vara exakt enligt den angivna gränsen. För CLOB- och NCLOB-kolumner kan målstorleken för LOB skilja sig från den angivna gränsen om käll- och mål-LOB:en inte har samma teckenuppsättning. I så fall utför datauppgiften en teckenuppsättningskonvertering vilket kan resultera i en avvikelse mellan källans och målets LOB-storlekar.

Eftersom värdet på Begränsa LOB-storlek till uttrycks i bytes ska storleken beräknas med följande formler:

- BLOB: längden på den största LOB:en.

- NCLOB: Längden på den längsta TEXTen i tecken gånger två (eftersom varje tecken behandlas som en dubbel-byte). Om det finns 4-bytetecken i data ska de multipliceras med fyra.

- CLOB: Längden på den längsta TEXTen i tecken (eftersom varje tecken behandlas som ett UTF8-tecken). Om det finns 4-bytetecken i data ska de multipliceras med två.

Anteckning om information- Alla LOB:er som är större än den angivna storleken kommer att trunkeras.

- Under ändringsbearbetning från en Oracle-källa replikeras inline-BLOB:ar inline.

- Ändringar av den här inställningen kommer bara att påverka befintliga tabeller efter att de laddats igen.

-

Begränsa inte storleken på LOB-kolumnen När det här alternativet väljs kommer LOB-kolumner att replikeras, oavsett storlek.

Anteckning om informationAtt replikera LOB-kolumner kan påverka prestandan. Detta gäller framför allt i fråga om stora LOB-kolumner där replikeringsuppgiften behöver utföra en sökning från källtabellen för att hämta käll-LOB-värdet.-

Optimera när LOB-storleken är mindre än: Välj det här alternativet om du behöver replikera både små och stora LOB:er och de flesta av LOB:erna är små.

Anteckning om informationDet här alternativet stöds bara med följande källor och mål:

-

Källor: Oracle, Microsoft SQL server, MySQL, PostgreSQL och IBM DB2 for LUW

-

Mål: Oracle, Microsoft SQL Server, MySQL, PostgreSQL.

När det här alternativet väljs kommer, under fullständig laddning, små LOB:er att replikeras "inline" (vilket är mer effektivt) och de stora LOB:erna kommer att replikeras genom att en sökning utförs från källtabellen. Men under ändringsbearbetning kommer både små och stora LOB:er att replikeras genom att en sökning utförs från källtabellen.

Anteckning om informationNär det här alternativet väljs kommer replikeringsuppgiften att kontrollera alla LOB-storlekar för att avgöra vilka som ska överföras "inline". LOB:er som är större än den angivna storleken kommer att replikeras i fullständigt LOB-läge.

Om du vet att de flesta av LOB:erna är större än den angivna inställningen är det därför lämpligare att använda alternativet Replikera obegränsade LOB-kolumner i stället.

-

-

Segmentstorlek (KB): Du kan om du vill ändra vilken storlek på LOB-segmenten som ska användas när data replikeras till målet. Standardsegmentstorleken bör vara tillräcklig i de flesta fall, men om du får prestandaproblem kan prestandan förbättras genom att justera storleken.

Anteckning om informationMed vissa databaser sker datatypvalideringen när data infogas eller uppdateras. I de här fallen kan replikeringen av strukturerade datatyper (t.ex. XML, JSON, GEOGRAPHY osv.) misslyckas om data är större än den angivna segmentstorleken.

-

Lob-inställningar för datalagermål som stöds

-

Inkludera LOB-kolumner och begränsa kolumnstorleken till (kB):

Du kan välja att inkludera LOB-kolumner i uppgiften och ställa in maximal LOB-storlek. LOB:er som är större än maximal storlek kommer att trunkeras.

Avancerat

Inställningar för kontrolltabell

-

Schema kontrolltabell: Ange målschemat för kontrolltabellerna om du inte vill att de ska skapas i källschemat (standard) eller i målschemat.

Anteckning om informationDen maximala tillåtna längden för schemanamnet är 128 tecken. - Skapa målkontrolltabeller i tabellutrymme:När replikeringsmålet är Oracle anger du det tabellutrymme där du vill att målkontrolltabellerna ska skapas. Om du inte anger någon information i det här fältet kommer tabellerna att skapas i standardtabellutrymmet i måldatabasen.

- Skapa index för målkontrolltabeller i tabellutrymme: När replikeringsmålet är Oracle anger du det tabellutrymme där du vill att kontrolltabellsindexen ska skapas. Om du inte anger någon information i det här fältet skapas indexen i samma tabellutrymme som kontrolltabellerna.

- Tidsfönster replikeringshistorik (minuter): Längden för varje tidsfönster i Replikeringshistorik-kontrolltabellen. Standardvärdet är 5 minuter.

Urval kontrolltabell

Välj de kontrolltabeller du vill ska skapas på målplattformen:

| Logiskt namn | Namn i mål |

|---|---|

| Tillämpa undantag | attrep_apply_exceptions |

| Replikeringsstatus | attrep_status |

| Inaktiverade tabeller | attrep_suspended_tables |

| Replikeringshistorik | attrep_history |

| DDL-historia |

attrep_ddl_history DDL-historiktabellen stöds endast på följande målplattformar: Anteckning om informationAmazon Redshift , Amazon S3, Google Cloud Storage och Snowflake kräver Gateway för dataflytt 2024.11.14 eller senare.

|

Se Kontrolltabeller för mer information om kontrolltabeller.

Fullständig laddning

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.Enkel

Dessa inställningar kommer att tillämpas under förberedelsesteget för datauppgiften och varje gång en tabell laddas om.

Om måltabellen redan finns: Välj något av följande för att bestämma hur data ska laddas till måltabellerna:

Alternativet att ta bort eller trunkera måltabellerna är bara relevanta om sådana åtgärder stöds av källans slutpunkt.

-

Ta bort och skapa tabell: Måltabellen tas bort och en ny tabell skapas i dess ställe.

Anteckning om informationKontrolltabeller kommer inte att tas bort. Men alla inaktiverade tabeller som tas bort kommer också att tas bort från kontrolltabellen attrep_suspended_tables om den associerade uppgiften laddas igen.

-

TRUNCATE before loading (trunkera före laddning): data trunkeras utan att måltabellens metadata påverkas. Observera att när det här alternativet väljs kommer det inte ha någon påverkan att aktivera alternativet Skapa primärnyckel eller unikt index efter att fullständig laddning slutförts.

Anteckning om informationStöds inte när Microsoft Fabric är målplattformen. - Ignorera: Befintliga data och metadata i måltabellen kommer inte att påverkas. Nya data läggs till i tabellen.

Avancerat

Finjustering av prestanda

Om datareplikeringen är för långsam kan prestandan förbättras genom att du justerar följande parametrar.

- Maximalt antal tabeller: ange det maximala antalet tabeller som ska laddas till målet direkt. Som standard är värdet 5.

-

Tidsgräns transaktionskonsekvens (sekunder): ange antalet sekunder som replikeringsuppgiften ska vänta på att öppna transaktioner ska stängas innan åtgärden fullständig laddning påbörjas. Standardvärdet är 600 (10 minuter). Replikeringsuppgiften kommer att påbörja den fullständiga laddningen efter att värdet för överskriden tidsgräns har nåtts även om det finns öppna transaktioner.

Anteckning om informationFör att replikera transaktioner som var öppna när fullständig laddning startades men inte överfördes förrän efter att värdet för tidsgränsen nåddes måste du ladda om måltabellerna. - Överföringsfrekvens vid fullständig laddning: Det maximala antalet händelser som kan överföras tillsammans. Som standard är värdet 10 000.

Efter slutförd fullständig laddning

Du kan ställa in uppgiften att stanna automatiskt efter att fullständig laddning har slutförts. Detta är användbart om du behöver utföra DBA-åtgärder på måltabellen innan uppgiftens ändringstillämpnings- (dvs. CDC-) fas inleds.

Under fullständig laddning cachelagras alla DML-åtgärder som utförs på källtabellerna. När den fullständiga laddningen slutförs tillämpas de cachelagrade ändringarna automatiskt på måltabellerna (förutsatt att alternativen Före/Efter-cachelagrade ändringar tillämpas som beskrivs nedan är inaktiverade).

- Skapa primärnyckel eller unikt index: Välj det här alternativet om du vill fördröja skapandet av primärnycklar eller unika index på målet tills efter den fullständiga laddningen har slutförts.

- Stoppa uppgiften: Anteckning om information

De här inställningarna är inte tillgängliga vid:

- Replikering från SaaS-programkällor (eftersom det inte finns några cachelagrade händelser)

- Replikering till datalagermål

Innan cachelagrade ändringar har tillämpats: Välj att stoppa uppgiften efter att fullständig laddning har slutförts.

Efter att cachelagrade ändringar har tillämpats: Välj att stoppa uppgiften när data är konsekventa i alla tabeller i uppgiften.

Anteckning om informationNär uppgiften konfigureras att stoppas efter att den fullständiga laddningen har slutförts måste du beakta följande:

- Uppgiften stoppas inte vid tidpunkten då den fullständiga laddningen slutförs. Den stoppas först när den första batchen med ändringar har registrerats (eftersom detta är det som medför att uppgiften stoppas). Detta kan dröja en stund beroende på hur ofta källdatabasen uppdateras. Efter att uppgiften stoppas kommer ändringarna inte att tillämpas på målet förrän uppgiften återupptas.

- Att välja Innan cachelagrade ändringar tillämpas kan påverka prestandan, eftersom de cachelagrade ändringarna bara tillämpas på tabeller (även de som redan har slutfört den fullständiga laddningen) efter att den sista tabellen slutför den fullständiga laddningen.

- När det här alternativet har valts och en DDL utförs på en av källtabellerna under den fullständiga laddningsprocessen (i en uppgift med fullständig laddning och ändringstillämpning), kommer replikeringsuppgiften att ladda tabellen igen. Detta betyder i praktiken att alla DML-åtgärder som utförs på källtabellerna kommer att replikeras till målet innan uppgiften stoppas.

För initial laddning

När data flyttas från en SaaS-programkälla kan du ställa in hur den initiala fullständiga laddningen ska utföras.

| Använd cachelagrade data |

Med det här alternativet kan du använda mellanlagrade data som lästes in när metadata genererades med Fullständig datasökning valt. Då skapas mindre overhead avseende API-användning och kvoter, eftersom data redan läses in från källan. Alla ändringar sedan den initiala datasökningen kan plockas upp av Change data capture (CDC). |

| Ladda data från källa |

Med det här alternativet utförs en ny laddning från datakällan. Det här alternativet är användbart när:

|

Tillämpa ändringar

De här inställningarna är bara tillgängliga när replikeringsläget Tillämpa ändringar är aktiverat.

Enkel

Välj typ av DDL-ändringar som ska tillämpas på målet

Följande alternativ avgör om DDL-åtgärder som utförs på motsvarande källtabell även kommer att utföras på måltabellen.

-

Ta bort tabell: Välj att ta bort måltabellen när källtabellen tas bort.

Anteckning om informationStöds inte när Kafka är målplattformen. -

Trunkera tabell: Välj att ta trunkera måltabellen när källtabellen trunkeras.

Anteckning om informationStöds inte när Microsoft Fabric är målplattformen. -

Modifiera tabell: Välj att ta modifiera måltabellen när källtabellen modifieras.

Anteckning om informationAtt byta namn på en tabell stöds inte när Kafka är målplattformen.

Ändra finjustering av behandling

-

Tillämpa batchade ändringar till flera tabeller samtidigt: Att välja det här alternativet kan förbättra prestandan när ändringar tillämpas från flera olika källtabeller.

Anteckning om informationDetta alternativ stöds endast när:

- Tillämpa ändringar-läge är inställt på Batchoptimerat. Mer information finns i Replikeringsinställningar.

- Replikeringsmålen är inte MySQL, PostgreSQL, Oracle och Google BigQuery.

-

Maximalt antal tabeller: Det maximala antalet tabeller som batchade ändringar kan tillämpas på samtidigt. Standard är fem, maximalt antal är 50 och det minsta antalet är två.

När alternativet Tillämpa batchade ändringar på flera tabeller samtidigt gäller följande begränsningar:

-

Standardalternativen för policyn för hantering av fel i uppgifter kommer att vara oförändrad för Miljö- och Tabell-fel, men standardvärdena för Data-fel och Tillämpa konflikter kommer att vara enligt följande:

- Datafel:

- Datatrunkeringsfel: Logga post i undantagstabellen

- Övriga datafel: Inaktivera tabell

- Tillämpa konflikter-fel:

- Tar bort: Ignorera post

Infogar: UPDATE den befintliga målposten

Anteckning om informationDetta är inte relevant för ett Snowflake-mål (eftersom Snowflake inte har stöd för primära nycklar).- Uppdateringar: Ignorera post

- Eskaleringsåtgärd:

- Eskaleringsåtgärden för både Data-fel och Tillämpa konflikter stöds inte.

- Kontrolltabellen attrep_apply_exception stöds inte.

- För datafel:

- Logga post till undantagstabellen är bara tillgänglig för datatrunkeringsfel.

- Det finns inget Ignorera-alternativ.

- För Tillämpa konflikter:

- Alternativet Logga poster till undantagstabell är inte tillgängligt.

- Ignorera-alternativet är bara tillgängligt för Ingen post hittades för att tillämpa en UPDATE-tillämpa konflikt.

- Datafel:

Se även: Felhantering.

-

Begränsa antalet ändringar som tillämpas per ändringsbearbetningssats till: För att begränsa antalet ändringar som tillämpas i en enda ändringsbearbetningssats markerar du den här kryssrutan och ändrar vid behov det förvalda värdet. Som standard är värdet 10 000.

Anteckning om informationDet här alternativet stöds bara med följande mål: MySQL, PostgreSQL, Oracle och Google BigQuery.

Avancerat

Se Ändra finjustering av behandling.

Lagra ändringar

De här inställningarna är bara tillgängliga när replikeringsläget Lagra ändringar är aktiverat.

Enkel

DDL-alternativ

Välj ett av följande alternativ för att avgöra hur DDL-åtgärder på källtabellerna ska hanteras:

- Tillämpa på ändringstabell: DDL-åtggärder på källtabellerna (till exempel att en kolumn läggs till) kommer bara att tillämpas på motsvarande Ändringstabeller.

- Ignorera: alla DDL-åtgärder på källtabeller kommer att ignoreras.

Avancerat

Vid uppdatering

Välj Lagra före och efter bild för att lagra både pre-UPDATE-data och post-UPDATE-data. Om det inte väljs kommer bara post-UPDATE-data att lagras.

Skapande av ändringstabell

I följande avsnitt beskrivs de tillgängliga alternativen när ändringar lagras i Ändringstabeller.

- Suffix: Ange en sträng som används som suffix för alla Ändringstabeller. Standardvärdet är __ct. Namnen i Ändringstabellen är namnen på måltabellen med suffixet tillagt. Om exempelvis standardvärdet används kommer namnet på Ändringstabellen att bli HR__ct.

- Prefix för rubrikkolumner: Ange en sträng som ska användas som prefix för alla kolumner för Ändringstabellers i rubriker. Standardvärdet är header__. Om exempelvis standardvärdet används kommer rubrikkolumnen stream_position benämnas header__stream_position.

Mer information om Ändringstabeller finns i Använda Ändringstabeller.

Om ändringstabellen finns när fullständig laddning startar: välj något av följande för att avgöra hur Ändringstabellerna ska laddas när den fullständiga laddningsreplikeringen startar:

- Ta bort och skapa ändringstabell: tabellen tas bort och en ny tabell skapas i dess ställe.

-

Ta bort gamla ändringar och spara nya ändringar i befintlig ändringstabell: data trunkeras och läggs till utan att tabellens metadata påverkas.

Anteckning om informationStöds inte när Microsoft Fabric är målplattformen. - Behåll gamla ändringar och spara nya ändringar i befintlig ändringstabell: data och metadata i den befintliga Ändringstabellen påverkas inte.

Kolumner för tabellrubrik

Ändringstabellens rubrikkolumner ger information om Ändringsbearbetningsåtgärder, till exempel typ av åtgärd (t.ex. INSERT), överföringstidpunkt och så vidare. Om du inte behöver all den här informationen kan du konfigurera flyttar-uppgiften så att Ändringstabeller skapas med valda rubrikkolumner (eller inga kolumner) så att deras fotavtryck i måldatabasen minskar.

En beskrivning av rubrikkolumnerna finns i Ändringstabeller.

Felhantering

Enkel

Tillämpa konflikter

Kopiera nyckel när INSERT tillämpas: Välj vilken åtgärd som ska vidtas när det finns en konflikt med en INSERT-åtgärd.

-

Ignorera: uppgiften fortsätter och felet ignoreras.

-

UPPDATERA den befintliga målposten: målposten med samma primärnyckel som den INSERTED (infogade) källposten uppdateras.

- Logga post till undantagstabellen (standard): uppgiften fortsätter och felet skrivs till undantagstabellen.

-

Stänga av tabell: uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte.

- Stoppa uppgift : uppgiften stoppas och manuellt ingrepp krävs.

Ingen post hittades för att tillämpa en UPDATE: Välj vilken åtgärd som ska vidtas när det finns en konflikt med en UPDATE-åtgärd

- Ignorera: uppgiften fortsätter och felet ignoreras.

-

INSERT den saknade posten:den saknade målposten kommer att infogas i måltabellen. När källändpunkten är Oracle måste ytterligare loggning aktiveras för alla källtabellkolumner.

- Logga post till undantagstabellen (standard): uppgiften fortsätter och felet skrivs till undantagstabellen.

-

Stänga av tabell: uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte.

- Stoppa uppgift : uppgiften stoppas och manuellt ingrepp krävs.

Avancerat

Hantering av datafel stöds bara i replikeringsläget Tillämpa ändringar (inte Fullständig laddning).

Datafel

För datatrunkeringsfel: Välj vad du vill ska hända när en trunkering sker i en eller flera poster. Du kan välja något av följande från listan:

- Ignorera: Uppgiften fortsätter och felet ignoreras.

- Logga post i undantagstabellen (standard): Uppgiften fortsätter och felet skrivs till undantagstabellen.

- Inaktivera tabell: Uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte

- Stoppa uppgift: Uppgiften stoppas och manuellt ingrepp krävs.

För övriga datafel: Välj vad du vill ska hända när ett fel sker i en eller flera poster. Du kan välja något av följande från listan:

- Ignorera: Uppgiften fortsätter och felet ignoreras.

- Logga post i undantagstabellen (standard): Uppgiften fortsätter och felet skrivs till undantagstabellen.

- Inaktivera tabell: Uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte

- Stoppa uppgift: Uppgiften stoppas och manuellt ingrepp krävs.

Eskalera felhantering när övriga datafel når (per tabell) : Välj den här kryssrutan för att eskalera felhantering när antalet icke-trunkeringsdatafel (per tabell) når det angivna antalet: Giltiga värden är 1–10 000.

Eskaleringsåtgärd: Välj vad som ska hända när felhantering eskaleras. Observera att de tillgängliga åtgärderna beror på vilken åtgärd som väljs från listrutan För övriga datafel som beskrivs ovan.

-

Inaktivera tabell (standard): Uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data flyttad inte.

Anteckning om informationBeteendet skiljer sig åt beroende på ändringsbearbetningsläge:

-

I Transaktionell tillämpning-läget kommer de senaste ändringarna inte att flyttad.

-

I Batchoptimerad tillämpning kan en situation uppstå där data inte flyttad alls, eller bara delvis flyttad.

-

- Stoppa uppgift: Uppgiften stoppas och manuellt ingrepp krävs.

- Logga post i undantagstabellen: Uppgiften fortsätter och posten skrivs till undantagstabellen.

Tabellfel

Antal försök innan ett tabellfel returneras

Det här alternativet låter dig styra när principen för hantering av tabellfel ska utlösas. Som standard, efter att ett tabellfel uppstått, kommer tabellen att pausas eller uppgiften att stoppas (enligt den valda åtgärden) efter tre försök. Ibland uppstår ett tabellfel på grund av planerat underhåll av SaaS-applikationen. I dessa fall kanske standardantalet försök inte räcker för att underhållet ska slutföras innan principen för hantering av tabellfel utlöses. Detta beror också på uppgiftens schemaläggningsintervall, eftersom ett nytt försök kommer att utföras varje gång uppgiften körs. Så, till exempel, om du schemalägger en uppgift att köras varje timme och SaaS-applikationen tas offline för underhåll precis när uppgiften börjar köras, kommer standardinställningen med tre försök att tillåta att SaaS-applikationen är offline i upp till tre timmar utan att principen för hantering av tabellfel utlöses. Ett längre underhållsfönster skulle kräva att du ökar antalet försök (eller ändrar schemaläggningen) för att förhindra att principen för hantering av tabellfel utlöses.

Sammanfattningsvis, om du är medveten om att din SaaS-applikation genomgår periodiskt underhåll, är bästa praxis att öka antalet försök enligt schemaläggningen så att underhållet kan slutföras utan att principen för hantering av tabellfel utlöses.

-

Det här alternativet visas endast för uppgifter som är konfigurerade med en Lite- eller Standard SaaS-applikationskoppling.

-

Om du använder Gateway för dataflytt krävs version 2024.11.70 eller senare.

När du stöter på ett tabellfel: välj något av följande från listrutan:

- Stänga av tabell (standard): uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte.

- Stoppa uppgift : uppgiften stoppas och manuellt ingrepp krävs.

Eskalera felhantering när tabellfel når (per tabell): välj den här kryssrutan för att eskalera felhantering när antalet tillämpningskonflikter (per tabell) når det angivna antalet. Giltiga värden är 1–10 000.

Eskaleringspolicy: eskaleringspolicyn för tabellfel är inställd på Stoppa uppgift och kan inte ändras.

Tillämpa konflikter

Ingen post hittades för att tillämpa en DELETE: välj vilken åtgärd som ska vidtas när det finns en konflikt med en DELETE-åtgärd.

- Ignorera: uppgiften fortsätter och felet ignoreras.

- Logga post till undantagstabellen: uppgiften fortsätter och felet skrivs till undantagstabellen.

- Stänga av tabell: uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte.

- Stoppa uppgift : uppgiften stoppas och manuellt ingrepp krävs.

Eskalera felhantering när tillämpa konflikter når (per tabell): välj den här kryssrutan för att eskalera felhantering när antalet tillämpningskonflikter (per tabell) når det angivna antalet. Giltiga värden är 1–10 000.

Eskaleringsåtgärd: välj vad som ska hända när felhantering eskaleras:

- Logga post till undantagstabellen (standard): uppgiften fortsätter och felet skrivs till undantagstabellen.

-

Stänga av tabell: uppgiften fortsätter men data från tabellen med felposten flyttas till ett feltillstånd och dess data replikeras inte.

Anteckning om informationBeteendet skiljer sig åt beroende på ändringsbearbetningsläge:

-

I Transaktionell tillämpning-läget kommer de senaste ändringarna inte att replikeras

-

I det batchoptimerade tillämpningsläget är en situation möjlig där det inte sker någon replikering av data eller datareplikeringen sker delvis.

-

-

Stoppa uppgift : uppgiften stoppas och manuellt ingrepp krävs.

Miljöfel

-

Maximalt antal nya försök: Välj det här alternativet och ange sedan det maximala antalet försök att utföra en uppgift igen när ett återställningsbart miljöfel inträffar. Efter att uppgiften har försökt utföras det angivna antalet gånger stoppas uppgiften och manuellt ingrepp krävs.

För att aldrig försöka utföra uppgiften igen avmarkerar du kryssrutan eller anger "0".

För att försöka utföra uppgiften ett oändligt antal gånger anger du "-1".

-

Mellanrum mellan försök (sekunder): Använd räknaren för att välja eller ange antalet sekunder som systemet väntar mellan försöken att utföra en uppgift.

Giltiga värden är 0–2 000.

-

- Förläng intervallet mellan försök vid långa avbrott: Välj den här kryssrutan för att förlänga intervallet mellan försök vid långa avbrott. När det här alternativet är aktiverat fördubblas intervallet mellan varje försök tills Maximalt intervall nås (och fortsätter att försöka enligt det angivna maximala intervallet).

- Maximalt intervall mellan försök (sekunder): Använd räknaren för att välja eller ange antalet sekunder för väntetiden mellan försöken att utföra en uppgift när alternativet Förläng intervallet för nytt försök vid långa avbrott är aktiverat. Giltiga värden är 0–2 000.

Ändra finjustering av behandling

Optimering av avlastning av transaktioner

-

Avlasta pågående transaktioner till disk om:

Replikeringsuppgiften behåller normalt transaktionsdata i minnet tills det är fullständigt överfört till källan och/eller målet. Men transaktioner som är större än det tilldelade minnet eller inte överförs inom den angivna tidsgränsen kommer att avlastas till disk.

- Transaktionsminnets storlek överskrider (MB): den maximala storleken som alla transaktioner kan uppta i minnet innan de avlastas till disk. Standardvärdet är 1024.

- Transaktionens varaktighet överskrider (sekunder): den maximala tiden som varje transaktion kan uppta i minnet innan de avlastas till disk. Varaktigheten beräknas från tiden då replikeringsuppgiften började registrera transaktionen. Standardvärdet är 60.

Finjustering av batch

Inställningarna på den här fliken bestäms av läget Tillämpa ändringar.

Följande inställningar är bara tillgängliga när Tillämpningsläget är inställt till Batchoptimerat.

- Använd grupperade ändringar i intervall:

-

Större än: Den kortaste tiden att vänta mellan varje tillämpning av batchändringar. Som standard är värdet 1.

Om värdet Längre än ökas minskar frekvensen som ändringar tillämpas med på målet samtidigt som storleken på batcherna ökar. Det kan förbättra prestandan när ändringar tillämpas på måldatabaser som är optimerade för bearbetning av stora batcher.

- Mindre än: den längsta tiden att vänta mellan varje tillämpning av batchändringar (innan en tidsgräns överskriden deklareras). Med andra ord, den maximala acceptabla latensen. Som standard är värdet 30. Värdet avgör den maximala tiden att vänta innan ändringarna tillämpas efter att Längre än-värdet har nåtts.

-

Framtvinga tillämpning av en batch när bearbetningsminnet överskrider (MB): den maximala mängden minne som ska användas vid förbearbetning i Batchoptimerat tillämpningsläge. Som standard är värdet 500.

Om du vill ha den maximala batchstorleken ställer du in det här värdet till den maximala mängden minne som du kan allokera till replikeringsuppgiften. Det kan förbättra prestandan när ändringar tillämpas på måldatabaser som är optimerade för bearbetning av stora batcher.

Följande inställningar är bara tillgängliga när Tillämpningsläget är inställt till Transaktionellt.

Följande inställningar är bara tillgängliga i "Transaktionellt" tillämpningsläge. Observera att "Transaktionell" är det enda tillgängliga tillämpningsläget (och därför inte kan väljas) vid replikering till Snowflake, och att inläsningsmetoden är Snowpipe Streaming.

-

Maximalt antal ändringar per transaktion: Det minsta antalet ändringar som ska tas med i varje transaktion. Som standard är värdet 1000.

Anteckning om informationÄndringarna tillämpas i målet antingen när antalet ändringar är lika med eller större än värdet Minsta antalet ändringar per transaktion ELLER när värdet Maximal tid att samla transaktioner i batcher före tillämpning (sekunder) som beskrivs nedan nås, beroende på vilket som kommer först. Eftersom frekvensen av ändringar som tillämpas på målet styrs av dessa två parametrar kommer ändringar i källposterna eventuellt inte att återspeglas omedelbart i målposterna.

- Maxtid att samla transaktioner i batcher före tillämpning (sekunder): maxtiden för att samla transaktioner i batcher innan en tidsgräns överskrids. Som standard är värdet 1.

Intervalldata

Inställningar vid användning av SAP ODP- och SaaS (Lite)-applikationskopplingar

-

Läs in ändringar var (minuter)

Ställ in antal minuter för intervallet mellan inläsning av ändringar från källan. Giltigt intervall är 1 till 1 440.

Anteckning om informationDet här alternativet är endast tillgängligt när dataarbetsuppgiften definieras med:

- Gateway för dataflytt

- Någon av följande källor:

- SaaS-applikation endast via Lite-kopplingar

- SAP ODP

- Uppdateringsmetoden Tillämpa ändringar eller Lagra ändringar

Inställningar vid användning av SAP OData-kopplingen

Kontrollera om det finns ändringar

-

I enlighet med intervallet för deltaextraheringNär det här alternativet är valt kontrollerar datauppgiften om det finns ändringar enligt intervallet för deltaextrahering.

Anteckning om informationIntervallet startar efter varje ”runda”. En runda kan definieras som den tid det tar för datauppgiften att läsa ändringarna från källtabellerna och skicka dem till målet (som en enskild transaktion). Längden på en runda varierar beroende på antalet tabeller och ändringar. Så om du anger ett intervall på 10 minuter och en runda tar 4 minuter, kommer den faktiska tiden mellan kontrollerna efter ändringar att vara 14 minuter.-

Intervall för deltaextrahering: Frekvensen med vilken deltan kommer att extraheras från ditt system. Standardtiden är var 60:e sekund.

-

-

Enligt schema: När det här alternativet är valt kommer datauppgiften att extrahera deltat en gång och sedan stoppa. Den kommer sedan att fortsätta att köras enligt schema.

Anteckning om informationDet här alternativet är endast relevant om intervallet mellan CDC-cyklerna är 24 timmar eller mer.För information om schemaläggning:

-

"Replikera data-uppgifter" i ett replikeringsprojekt, se Schemalägga datauppgifter

-

Diverse finjustering

Cachestorlek för satser (antal satser)

Det maximala antalet förberedda satser som ska lagras på servern för senare körning (när ändringar tillämpas på målet). Standardvärdet är 50. Maxvärdet är 200.

DELETE och INSERT när en primärnyckelkolumn uppdateras

För det här alternativet måste full kompletterande loggning vara aktiverat i källdatabasen.

Skicka tombstone-meddelande vid DELETE

När det här alternativet är valt kommer endast meddelandenyckeln att fyllas i; själva meddelandet kommer att vara null, vilket indikerar att objektet har tagits bort. Detta kan hjälpa konsumenter att upptäcka att en DELETE-åtgärd har utförts.

Lagra uppgiftsåterställningsdata i måldatabas

Välj det här alternativet för att lagra uppgiftsspecifik återställningsinformation i måldatabasen. När det här alternativet har valts skapar replikeringsuppgiften en tabell benämnd attrep_txn_state i måldatabasen. Den här tabellen innehåller transaktionsdata som kan användas för att återställa en uppgift om filerna i Gateway för dataflytt datamappen är skadade eller om lagringsenheten som innehåller Datamappen inte fungerar.

Tillämpa ändringar med SQL MERGE

Om det här alternativet inte väljs kommer replikeringsfunktionen att utföra separata INSERT-, UPDATE- och DELETE-satser i bulk för var och en av de olika ändringstyperna i tabellen Net Changes.

Även om den här metoden är mycket effektiv är det ännu effektivare att aktivera alternativet Tillämpa ändringar med using SQL MERGE när du arbetar med slutpunkter som stöder det här alternativet.

Detta är av följande anledningar:

- Det minskar antalet SQL-satser som körs per tabell från tre till en. De flesta UPDATE-åtgärderna i stora, oåterkalleliga, filbaserade molndatabaser (till exempel Google Cloud BigQuery) omfattar omskrivning av berörda filer. För sådana operationer är minskningen av antalet SQL-satser per tabell från tre till en mycket avsevärd.

- Måldatabasen behöver bara söka genom tabellen Net Changes en gång, vilket innebär en betydande minskning av I/O.

Optimera infogningar

När Tillämpa ändringar med SQL MERGE är valt tillsammans med alternativet Optimera infogningar och ändringarna endast består av INSERTs, kommer replikeringsuppgiften att utföra INSERTs istället för att använda SQL MERGE. Observera att även om detta vanligtvis förbättrar prestandan och därigenom minskar kostnaderna kan det också leda till dubblettposter i måldatabasen.

- Alternativen Tillämpa ändringar med SQL MERGE och Optimera infogningar är endast tillgängliga för aktiviteter som konfigurerats med följande målslutpunkter:

- Google Cloud BigQuery

- Databricks

- Snowflake

- Alternativen Tillämpa ändringar med SQL MERGE och Optimera infogningar stöds inte med följande källslutpunkter:

- Salesforce

- Oracle

-

När alternativet Tillämpa ändringar med SQL MERGE är aktiverat:

- Icke kritiska datafel eller datafel som inte kan återställas kommer att hanteras som tabellfel.

- Felhanteringspolicyn Tillämpa konflikter kommer att vara icke-redigerbar med följande inställningar.

- Ingen post hittades för att tillämpa DELETE: ignorera post

Kopiera nyckel när INSERT tillämpas: UPDATE den befintliga målposten

Anteckning om informationOm alternativet Optimera infogningar också har valts kommer alternativet Kopiera nyckel när INSERT tillämpas att ställas in till Tillåt kopior i mål.- Ingen post hittades för att tillämpa en UPDATE: INSERT den saknade målposten

- Eskaleringsåtgärd: Logga post i undantagstabell

- Följande alternativ För övriga datafel Hanteringspolicy för datafel kommer inte att vara tillgängliga:

- Ignorera post

- Logga post i undantagstabellen

- Den faktiska SQL MERGE-operationen kommer bara att utföras på de slutgiltiga måltabellerna. INSERT-operationer kommer att utföras på de mellanliggande ändringstabellerna (när lägena Tillämpa ändringar eller Lagra ändringar är aktiverade).

Transaktionell tillämpning

Vid replikering till datalagringsmål eller när du arbetar utan Gateway för dataflytt är de här alternativen inte relevanta eftersom Tillämpningsläget alltid är Batchoptimerat, med ett undantag.

Undantaget är vid replikering till Snowflake när Laddningsmetod är inställd på Snowpipe streaming.

Följande inställningar är bara tillgängliga i transaktionellt tillämpningsläge. Vid replikering till databaser kan Tillämpningsläget ställas in på antingen Batch-optimerad eller Transaktionellt. Men vid replikering till Snowflake-mål när Laddningsmetod är inställd på Snowpipe streaming, är tillämpningsläget alltid transaktionellt och kan därför inte ställas in.

-

Maximalt antal ändringar per transaktion: det minsta antalet ändringar som ska tas med i varje transaktion. Som standard är värdet 1000.

Anteckning om informationReplikeringsuppgiften tillämpar ändringarna i målet antingen när antalet ändringar är lika med eller större än värdet Minsta antalet ändringar per transaktion ELLER när tidsgränsen för batchen nås (se nedan), beroende på vilket som kommer först. Eftersom frekvensen av ändringar som tillämpas på målet styrs av dessa två parametrar kommer ändringar i källposterna eventuellt inte att återspeglas omedelbart i målposterna. - Maxtid att samla transaktioner i batcher före tillämpning (sekunder): maxtiden för att samla transaktioner i batcher innan en tidsgräns överskrids. Som standard är värdet 1.

Utveckling av schema

Välj hur du ska hantera följande typer av DDL-ändringar i schemat. När du har ändrat inställningarna för schemautveckling måste du förbereda uppgiften på nytt. I tabellen nedan beskrivs vilka åtgärder som är tillgängliga för de DDL-ändringar som stöds.

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.| Förändring av DDL | Tillämpa på mål | Ignorera | Inaktivera tabell | Stoppa uppgift |

|---|---|---|---|---|

| Lägg till kolumn | Ja | Ja | Ja | Ja |

| Ändra kolumndatatyp: | Ja | Ja | Ja | Ja |

| Byt namn på kolumn | Ja | Nej | Ja | Ja |

|

Byt namn på tabell Anteckning om informationStöds inte när Kafka är målplattformen.

|

Nej | Nej | Ja | Ja |

| Släpp kolumn | Ja | Ja | Ja | Ja |

|

Släpp tabell Anteckning om informationStöds inte när Kafka är målplattformen.

|

Ja | Ja | Ja | Ja |

| Skapa tabell

Om du använde en Urvalsregel för att lägga till datauppsättningar som matchar ett mönster kommer nya tabeller som uppfyller mönstret att upptäckas och läggas till. |

Ja | Ja | Nej | Nej |

Teckenbyte

Du kan ersätta eller ta bort källtecken i måldatabasen och/eller du kan ersätta eller ta bort källtecken som inte stöds av en vald teckenuppsättning.

-

Alla tecken måste anges som Unicode-kodpunkter.

- Teckenersättning kommer också att utföras på -kontrolltabellerna.

-

Ogiltiga värden anges med en röd triangel uppe till höger på tabellcellen. Hovra med muspekaren över triangeln för att visa felmeddelandet.

-

Alla omvandlingar på tabellnivå eller globalt som definierats för uppgiften kommer att utföras efter att teckenersättningen har slutförts.

-

Ersättningsåtgärder som definierats i tabellen Ersätt eller ta bort källtecken utförs innan ersättningsåtgärden som definierats i tabellen Ersätt eller ta bort källtecken som inte stöds av en vald teckenuppsättning.

- Teckenersättningen har inte stöd för LOB-datatyper.

Byta ut eller radera källtecken

Använd tabellen Ersätt eller ta bort källtecken för att definiera ersättningar för specifika källtecken. Detta kan exempelvis vara användbart när Unicode-representationen av ett tecken är olika på käll- och målplattformarna. Exempelvis visas minustecknet i teckenuppsättningen Shift_JIS som U+2212 på Linux, men på Windows visas det som U+FF0D.

| Till | Gör så här |

|---|---|

|

Definiera ersättningsåtgärder |

|

|

Redigera det angivna käll- eller måltecknet |

Klicka på |

|

Ta bort poster från tabellen |

Klicka på |

Ersätta eller ta bort källtecken som inte stöds av den valda teckenuppsättningen.

Använd tabellen Källtecken som inte stöds av teckenuppsättning för att definiera ett enda ersättningstecken för alla tecken som inte stöds av den valda teckenuppsättningen.

| Till | Gör så här |

|---|---|

|

Definiera eller redigera en ersättningsåtgärd |

|

|

Inaktivera ersättningsåtgärden. |

Välj den tomma posten från listrutan Teckenuppsättning. |

Fler alternativ

Dessa alternativ visas inte i gränssnittet eftersom de bara är relevanta för specifika versioner eller miljöer. Konfigurera därför inte dessa alternativ om du inte uttryckligen har blivit instruerad att göra det av Qlik Support eller om det står i produktdokumentationen.Qlik

För att ställa in ett alternativ kopierar du bara alternativet i fältet Lägg till funktionsnamn och klickar på Lägg till. Ställ sedan in värdet eller aktivera alternativet enligt de instruktioner du har fått.

Parallell inläsning av datauppsättningssegment

Vid fullständig laddning kan du påskynda inläsningen av stora datauppsättningar genom att dela upp datauppsättningen i segment som läses in parallellt. Tabeller kan delas upp efter dataintervall, alla partitioner, alla underpartitioner eller specifika partitioner.

Mer information finns i Parallell replikering av datauppsättningssegment.

Schemalägga datauppgifter

I följande användningsfall måste du definiera ett schemaläggningsintervall för att uppdatera målet med de ändringar som har gjorts i källan:

- Vid åtkomst till en datakälla utan Gateway för dataflytt

- Använd kopplingar för förhandsgranskning av SaaS-program. Kopplingar för förhandsgranskning anges med en

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen.

-knapp, både i dialogrutan Skapa koppling och i onlinehjälpen. - När du samlar in ändringar från en SAP OData-källa med alternativet Enligt schema.

Schemat avgör hur ofta måldatauppsättningen ska uppdateras med ändringar i källdatauppsättningen. Medan schemat bestämmer uppdateringsfrekvensen, bestämmer typen av datauppsättning uppdateringsmetoden. Om källdatauppsättningarna stöder CDC (Change Data Capture) kommer endast ändringarna i källdata att replikeras och tillämpas på motsvarande måltabeller. Om källdatauppsättningarna inte har stöd för CDC (till exempel Vyer) kommer ändringar att tillämpas genom att ladda alla källdata till motsvarande måltabeller. Om vissa av källdatauppsättningarna har stöd för CDC och andra inte, skapas två separata deluppgifter (förutsatt att replikeringsalternativet Tillämpa ändringar eller Lagra ändringar har valts): en för att ladda om de datauppsättningar som inte stöder CDC, och den andra för att registrera ändringarna i datauppsättningar som stöder CDC. I det här fallet rekommenderas det starkt att du inte använder samma schemaläggningsintervall för båda uppgifterna (om du bestämmer dig för att ändra uppdateringsfrekvensen i framtiden) för att säkerställa datakonsistens.

Information om minsta schemaläggningsintervall beroende på typ av datakälla och prenumerationsnivå finns i Minsta tillåtna schemaläggningsintervall.

Så här ändrar du schemaläggningen:

-

Öppna ditt projekt och gör sedan något av följande:

- I uppgiftsvyn klickar du på

på en replikeringsuppgift och väljer Schemaläggning.

- I pipeline-vyn klickar du på

på en replikeringsuppgift och väljer Schemaläggning.

- Öppna replikeringsuppgiften och klicka på knappen Schemaläggning i verktygsfältet.

- I uppgiftsvyn klickar du på

- Ändra schemaläggningsinställningarna efter behov och klicka sedan på OK.

Kör en missad körning för en uppgift baserat på Gateway för dataflytt

Ibland kan ett nätverksproblem leda till att kopplingen till Gateway för dataflytt går förlorad. Om kopplingen till Gateway för dataflytt inte återställs före nästa schemalagda körning kommer inte dataaktiviteten att kunna köras som schemalagt. I sådana fall kan du välja om du vill köra en körning eller inte omedelbart efter att kopplingen har återställts.

Standardinställningarna för alla Gateway för dataflyttar är definierade i aktivitetscentret Administration. Du kan åsidosätta dessa inställningar för enskilda uppgifter enligt beskrivningen nedan.

Gör så här

-

Öppna ditt projekt och gör sedan något av följande:

-

I uppgiftsvyn klickar du på

på datauppgiften och väljer Schemaläggning.

-

I pipeline-vyn klickar du på

på datauppgiften och väljer Schemaläggning.

-

Öppna datauppgiften och klicka på knappen Schemaläggning i verktygsfältet.

Dialogrutan Schemaläggning – <uppgift> öppnas.

-

-

Aktivera Använd anpassade inställningar för den här uppgiften.

-

Längst ned i dialogrutan väljer du något av följande alternativ för Kör missade schemalagda uppgifter.

-

Så snart som möjligt och sedan enligt schemat om det är viktigt att köra en uppgift före nästa schemalagda instans

-

Enligt schemat att köra uppgiften vid nästa schemalagda instans

-

-

Spara dina inställningar.

Se även: Utförande av en uppgiftskörning efter ett missat schema.