Erstellen eines Daten-Pipeline-Projekts

Sie können eine Daten-Pipeline erstellen, um Ihre ganze Datenintegration innerhalb eines Projekts mithilfe von Datenaufgaben durchzuführen. Beim Onboarding werden Daten aus lokalen bzw. Cloud-Datenquellen in das Projekt verschoben und in einsatzbereiten Datensätzen gespeichert. Sie können Daten in ein Data Warehouse oder in Qlik Open Lakehouse eingliedern.

Wenn Sie Daten in ein Data Warehouse eingliedern, können Sie auch Umwandlungen vornehmen und Data Marts erstellen, um Ihre generierten und umgewandelten Datensätze zu nutzen. Neben einfachen und linearen Pipelines stehen auch komplexe Pipelines zur Verfügung, die verschiedene Datenquellen nutzen und zahlreiche Ausgaben erzeugen.

Alle Datenaufgaben werden im gleichen Bereich wie das Projekt erstellt, zu dem sie gehören.

Sie können auch die Herkunft anzeigen, um Daten und Datenumwandlungen zurück zur ursprünglichen Quelle zu verfolgen und Auswirkungsanalysen durchführen, die eine vorwärtsgerichtete, nachgelagerte Ansicht von Datenaufgaben-, Datensatz- oder Feldabhängigkeiten zeigt. Weitere Informationen finden Sie unter Arbeiten mit Herkunft und Auswirkungsanalyse in Datenintegration.

Eingliedern von Daten in einem Data Warehouse

Dies umfasst das Bereitstellen der Daten in einem Bereitstellungsbereich und das anschließende Speichern der Datensätze in einem Cloud Data Warehouse. Bereitstellungs- und Speicherdatenaufgaben werden in einem einzigen Schritt erstellt. Bei Bedarf können Sie die Bereitstellung und die Speicherung auch in getrennten Aufgaben durchführen.

Eingliedern von Daten in Qlik Open Lakehouse

Erstellen Sie ein Qlik Open Lakehouse Pipeline-Projekt, um Daten aus jeder unterstützten Quelle in das offene Iceberg-Tabellenformat zu kopieren. Mit Spiegeldatenaufgaben können Sie von Snowflake aus auf Tabellen zugreifen und diese abfragen, ohne Daten zu duplizieren.

Registrieren von Daten, die bereits in der Datenplattform vorhanden sind

Registrieren Sie Daten, die bereits auf der Datenplattform vorhanden sind, um Daten zusammenzustellen und umzuwandeln und um Data Marts zu erstellen. Damit können Daten nach der Eingliederung mit anderen Tools als Qlik Talend Data Integration verwendet werden, z. B. Qlik Replicate oder Stitch.

Umwandeln von Daten

Erstellen Sie nach dem Onboarding der Daten wiederverwendbare Umwandlungen auf Zeilenebene, die auf Regeln und benutzerdefinierter SQL basieren. Damit wird eine Umwandlungsdatenaufgabe erstellt.

Erstellen und Verwalten von Data Marts

Erstellen Sie einen Data Mart, um Ihre Datensätze zu nutzen. Damit wird eine Data Mart-Datenaufgabe erstellt.

Erstellen von Wissens-Marts

Erstellen Sie einen Wissens-Mart, um Ihre strukturierten und unstrukturierten Daten in einer Vektordatenbank einzubetten und zu speichern. Damit wird eine Wissens-Mart-Datenaufgabe erstellt.

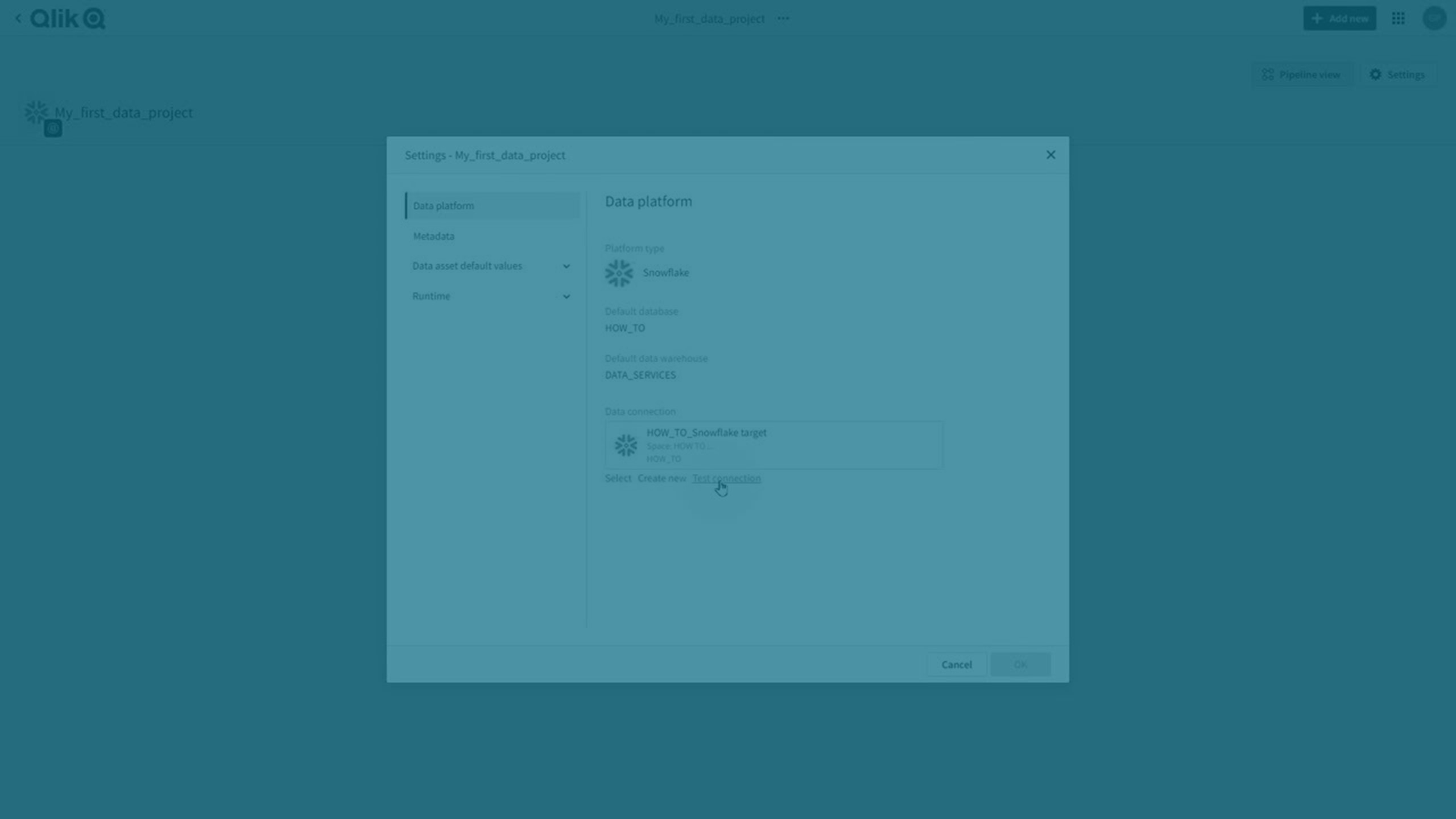

Zieldatenplattformen

Das Projekt wird mit einer Datenplattform verknüpft, die als Ziel für alle Ausgaben verwendet wird.

Weitere Informationen zu unterstützten Datenplattformen finden Sie unter Einrichten von Verbindungen zu Zielen.

Video: Einführung in Projekte

Beispiel für das Erstellen eines Projekts

Im folgenden Beispiel wird das Onboarding von Daten, das Umwandeln der Daten und das Erstellen eines Data Mart gezeigt. Damit wird eine einfache lineare Daten-Pipeline erstellt, die Sie durch Onboarding weiterer Datenquellen erweitern können. Sie können weitere Umwandlungen erstellen und die generierten Datenaufgaben zum Data Mart hinzufügen.

Beispiel einer linearen Daten-Pipeline in einem Projekt

-

Erstellen Sie ein neues Projekt.

Klicken Sie in Data Integration > Pipeline-Projekte auf Neu erstellen > Projekt.

-

Geben Sie einen Namen und eine Beschreibung für das Projekt ein.

InformationshinweisWenn Sie später die Versionskontrolle für das Projekt aktivieren, können Sie den Projektnamen nicht mehr ändern, solange sich das Projekt unter Versionskontrolle befindet. -

Wählen Sie einen Bereich, in dem Sie das Projekt erstellen möchten. Alle Datenaufgaben werden im Bereich des Projekts erstellt, zu dem sie gehören.

- Wählen Sie in Anwendungsfall die Option Daten-Pipeline aus.

-

Wählen Sie aus, welche Datenplattform im Projekt verwendet werden soll.

-

Wählen Sie eine Verbindung zum Cloud Data Warehouse aus, die Sie im Projekt verwenden möchten. Sie wird verwendet, um Datendateien bereitzustellen und Datensätze und Ansichten zu speichern. Wenn Sie noch keine Verbindung vorbereitet haben, erstellen Sie eine mit Neu erstellen.

-

Wenn Sie Google BigQuery, Databricks oder Microsoft Azure Synapse Analytics als Datenplattform ausgewählt haben, müssen Sie auch eine Verbindung mit einem Bereitstellungsbereich herstellen.

-

Wenn Sie Snowflake als Datenplattform gewählt haben, können Sie die Bereitstellung von Daten im Cloud-Speicher auswählen. Weitere Informationen finden Sie unter Bereitstellen von Daten in einem Lakehouse.

-

Wenn Sie Qlik Cloud als Datenplattform ausgewählt haben:

Sie können Daten entweder im verwalteten Speicher von Qlik oder in Ihrem eigenen verwalteten Amazon S3-Bucket speichern. Wenn Sie Ihren eigenen Amazon S3-Bucket verwenden möchten, müssen Sie eine Verbindung mit diesem Bucket auswählen.

In beiden Fällen müssen Sie auch eine Verbindung mit einem Amazon S3-Bereitstellungsbereich auswählen. Wenn Sie den gleichen Bucket verwenden, den Sie im vorherigen Schritt definiert haben, vergewissern Sie sich, dass Sie einen anderen Ordner im Bucket für die Bereitstellung verwenden.

-

-

Klicken Sie auf Erstellen.

Das Projekt wird erstellt, und Sie können Ihre Daten-Pipeline erstellen, indem Sie Datenaufgaben hinzufügen.

-

-

Onboarding für die Daten

Klicken Sie im Projekt auf Erstellen und dann auf Daten eingliedern.

Weitere Informationen finden Sie unter Eingliedern von Daten in einem Data Warehouse.

Damit wird eine Bereitstellungsdatenaufgabe und eine Speicherdatenaufgabe erstellt. Um mit der Replikation von Daten zu beginnen, müssen Sie Folgendes tun:

-

Die Bereitstellungsdatenaufgabe vorbereiten und ausführen.

Weitere Informationen finden Sie unter Bereitstellen von Daten aus Datenquellen.

-

Die Speicherdatenaufgabe vorbereiten und ausführen.

Weitere Informationen finden Sie unter Speichern von Datensätzen.

-

-

Umwandeln der Daten

Nachdem die Speicherdatenaufgabe erstellt ist, gehen Sie zurück zum Projekt. Jetzt können Sie für die erstellten Datensätze Umwandlungen durchführen.

Klicken Sie in der Speicherdatenaufgabe auf ... und wählen Sie Daten umwandeln aus, um eine Umwandlungsdatenaufgabe basierend auf dieser Speicherdatenaufgabe zu erstellen. Anleitungen zu Umwandlungen finden Sie unter Umwandeln von Daten.

-

Erstellen eines Data Mart

Sie können einen Data Mart basierend auf einer Speicherdatenaufgabe oder einer Umwandlungsdatenaufgabe erstellen.

Klicken Sie in der Datenaufgabe auf ... und wählen Sie Data Mart erstellen aus, um eine Data Mart-Datenaufgabe zu erstellen. Anleitungen zum Erstellen eines Data Mart finden Sie unter:

Nachdem Sie das erste vollständige Laden der gespeicherten und umgewandelten Datensätze und Data Marts durchgeführt haben, können Sie sie beispielsweise in einer Analyse-App verwenden. Weitere Informationen zum Erstellen von Analyse-Apps finden Sie unter Erstellen einer Analyse-App anhand von in Data Integration erstellen Datensätzen.

Sie können auch die Daten-Pipeline erweitern, indem Sie ein Onboarding weiterer Datenquellen durchführen, und diese in der Umwandlung oder im Data Mart kombinieren.

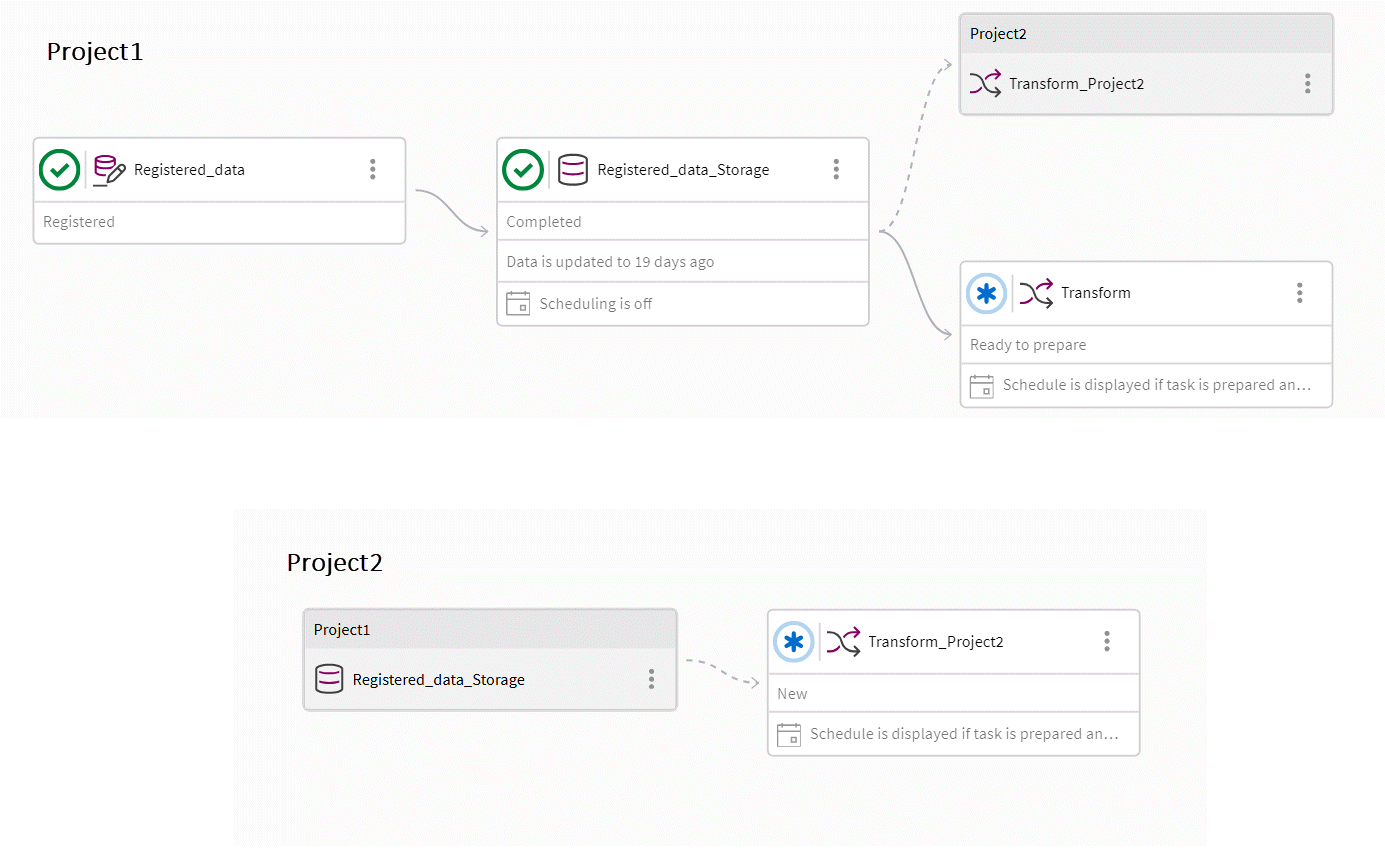

Erstellen projektübergreifender Pipelines

Sie können projektübergreifende Pipelines erstellen, in denen eine Aufgabe Aufgaben aus einem anderen Projekt nutzen kann. So können Sie die Segmentierung auf verschiedene Arten erreichen:

-

Sie können für jede Organisationseinheit eine eigene Datenverschiebungspipeline erstellen und die Ergebnisse in einer einzigen Data-Mart-Pipeline nutzen.

-

Sie können eine einzelne Datenverschiebungspipeline erstellen und die Ausgabe in mehreren Pipelines für die Umwandlung nutzen.

Umwandlungs- und Data-Mart-Aufgaben können Speicher- und Umwandlungsaufgaben nutzen, die sich in einem anderen Projekt befinden.

-

Sie müssen mindestens die Rolle Kann nutzen in dem Bereich des genutzten Projekts haben.

-

Beide Projekte müssen sich auf derselben Datenplattform befinden.

Alle Datensätze einer Aufgabe werden für nachgelagerte Projekte freigegeben. Wenn Sie also eine Trennung der Datensätze erreichen möchten, müssen Sie die Datensätze im genutzten Projekt herausfiltern, indem Sie eine Umwandlungsaufgabe erstellen.

In der Projektansicht können Sie Aufgaben anzeigen, die von einem anderen Projekt genutzt werden, sowie Aufgaben aus anderen Projekten, die im aktuellen Projekt genutzt werden. Alle Aufgaben außerhalb des aktuellen Projekts sind grau. Die Abhängigkeiten bestehen aus einer Referenz und nicht aus einem Namen. Das bedeutet, dass Sie eine Aufgabe umbenennen können, ohne die Referenz zu unterbrechen. Es bedeutet auch, dass, wenn Sie eine genutzte Aufgabe löschen und eine neue Aufgabe mit demselben Namen erstellen, die Referenz immer noch unterbrochen wird.

Es gibt mehrere Möglichkeiten, vorhandene Daten wiederzuverwenden:

-

Erstellen eines neuen Projekts

Wählen Sie die Option Daten aus einem anderen Projekt verwenden, nachdem Sie ein Projekt erstellt haben.

Sie können eine Umwandlung oder einen Data Mart erstellen, indem Sie die von einer anderen Pipeline übernommenen Daten verwenden.

-

In einer Umwandlungsaufgabe oder Data-Mart-Aufgabe können Sie unter Quelldaten auswählen Daten aus einem anderen Projekt auswählen.

Wenn Sie Quelldaten auswählen, sollten Sie Projekt und dann Datenaufgabe auswählen, um zu sehen, welche Datensätze verfügbar sind.

Sie können wählen, ob Sie Aufgaben in anderen Projekten anzeigen möchten, die eine Aufgabe in diesem Projekt nutzen.

-

Klicken Sie auf Ebenen und schalten Sie die Projektübergreifende Ausgabe ein oder aus.

Alle Aufgaben außerhalb des aktuellen Projekts sind grau.

Einschränkungen der Versionskontrolle

Da projektübergreifende Pipelines auf mehrere Projekte aufgeteilt sind, erhöht sich die Komplexität bei der Versionskontrolle. In diesen Beispielen wird Project1 von Project2 genutzt.

Beispiel für eine projektübergreifende Pipeline

-

Project2 kann nur den Hauptzweig von Project1 nutzen. Project2 kann selbst aber auf einem anderen Zweig liegen.

-

Sie können einen Zweig für Projekc1 erstellen, aber in der verzweigten Version wird nicht angezeigt, dass sie von Project2 genutzt wird.

-

Sie können Project2 mit dem Hauptzweig zusammenführen, aber die Abhängigkeit bleibt bestehen.

Best Practices

-

Prüfen Sie, ob die Aufgaben im genutzten Projekt zumindest vorbereitet sind, um sicherzustellen, dass sie gültig sind.

-

Wenn Sie planen, Projekte zwischen Mandanten zu exportieren und zu importieren, ist es einfacher, wenn Sie die gleichen Namen für Bereiche und Projekte in den Mandanten beibehalten. Wenn sich die Namen unterscheiden, müssen Sie beim Importieren des Projekts die Projekte und Aufgaben zuordnen.

-

Wenn Sie die Datenplattform durch Exportieren und Importieren ändern möchten, müssen sich alle Projekte mit Abhängigkeiten auf der gleichen Plattform befinden.

Folgen Sie den folgenden Schritten für einen sicheren und einfachen Plattformwechsel. In diesem Beispiel heißt das Projekt, das genutzt wird, Consumed, und das Projekt, das aus Consumed liest, heißt Consumer.

-

Exportieren Sie Consumed und Consumer.

-

Importieren Sie Consumed nach Consumed_New und wechseln Sie zur neuen Datenplattform.

-

Importieren Sie Consumer in Consumer_New, wechseln Sie zur gleichen Datenplattform wie Consumed_New und ersetzen Sie das Quellprojekt (Consumed) durch Consumed_New.

-

Vorgänge in einem Daten-Pipeline-Projekt

Sie können die gleichen Vorgänge, die für eine Datenaufgabe verfügbar sind, auch als Projektvorgänge ausführen. So können Sie die Vorgänge in der Daten-Pipeline organisieren.

-

Pläne aktivieren und deaktivieren

-

Designvorgänge ausführen

-

Die Ausführung von Datenaufgaben starten und anhalten

-

Datenaufgaben löschen

Klicken Sie auf Vorgänge, um den Status eines laufenden Vorgangs oder des letzten ausgeführten Vorgangs anzuzeigen.

Sie können einen laufenden Vorgang anhalten, indem Sie auf Vorgang anhalten klicken. Laufende Datenaufgaben werden nicht angehalten, aber alle noch nicht gestarteten Aufgaben werden abgebrochen.

Aktivieren und Deaktivieren von Plänen

Sie können die Pläne für Datenaufgaben auf Projektebene steuern.

-

Klicken Sie auf ... und dann auf Plan.

Sie können den Plan für alle Datenaufgaben oder für eine Aufgabenauswahl aktivieren oder deaktivieren. Nur Aufgaben mit einem definierten Plan werden angezeigt.

InformationshinweisDiese Option ist für Projekte mit Qlik Cloud als Datenplattform nicht verfügbar.

Weitere Informationen zum Planen von individuellen Datenaufgaben finden Sie unter:

Durchführen von Designvorgängen

Sie können Designvorgänge für alle Datenaufgaben im Projekt oder für eine Aufgabenauswahl ausführen. Damit wird es einfacher, die Datensatzaufgaben im Projekt zu steuern, da die Designvorgänge nicht einzeln für jede Aufgabe ausgeführt werden müssen.

-

Validieren

Klicken Sie auf Validieren, um alle Aufgaben oder eine Aufgabenauswahl zu validieren. Datenaufgaben, die seit dem letzten Validierungsvorgang geändert wurden, sind bereits ausgewählt.

Die Datenaufgaben werden in Reihenfolge der Pipeline validiert.

-

Vorbereiten

Klicken Sie auf Vorbereiten, um alle Aufgaben oder eine Aufgabenauswahl vorzubereiten. Datenaufgaben, die seit dem letzten Vorbereitungsvorgang geändert wurden, sind bereits ausgewählt.

Sie können wählen, einen Datensatz neu zu erstellen, der eine von der Datenplattform nicht unterstützte Strukturänderung erfordert. Dies kann zu Datenverlust führen.

-

Neu erstellen

Klicken Sie auf ... und dann auf Tabellen neu erstellen, um die Datensätze für alle Aufgaben oder für eine Aufgabenauswahl aus der Quelle neu zu erstellen.

InformationshinweisWenn Probleme mit einzelnen Tabellen bestehen, wird empfohlen, die Tabellen zuerst neu zu laden, statt sie neu zu erstellen. Die Neuerstellung von Tabellen kann zum Verlust von Verlaufsdaten führen. Wenn kritische Änderungen vorliegen, müssen Sie auch nachgelagerte Datenaufgaben vorbereiten, die die neu erstellten Datenaufgaben nutzen, damit die Daten neu geladen werden.

Ausführen von Datenaufgaben

Sie können die Ausführung aller Datenaufgaben im Projekt oder einer Aufgabenauswahl einleiten, statt die Aufgaben einzeln auszuführen. Beispielsweise können Sie alle Aufgaben nach einem zeitbasierten Plan ausführen. Dadurch werden nachgelagerte Aufgaben mit einem ereignisbasierten Plan begonnen.

-

Ausführen

Klicken Sie auf Ausführen, um die Ausführung aller Aufgaben oder einer Aufgabenauswahl zu beginnen. Damit wird die Ausführung aller ausgewählten Aufgaben begonnen, und der Befehl endet, sobald die Ausführung gestartet hat.

Sie können unter allen Aufgaben wählen, die zur Ausführung bereit sind. Aufgaben mit einem zeitbasierten Plan und Aufgaben, die CDC verwenden, sind vorausgewählt. Aufgaben mit einem ereignisbasierten Plan sind nicht vorausgewählt, da sie dann ausgeführt werden, wenn neue zu verarbeitende Daten vorliegen.

In einem Projekt mit Qlik Cloud als Datenplattform sind alle Bereitstellungs- und Speicheraufgaben vorausgewählt.

InformationshinweisAlle Datenaufgaben werden parallel ausgeführt. Das bedeutet, dass Abhängigkeitsprüfungen die Ausführung mancher Aufgaben verhindern können. -

Anhalten

Klicken Sie auf Anhalten, um alle Aufgaben oder eine Aufgabenauswahl anzuhalten.

Sie können unter Aufgaben wählen, die ausgeführt werden.

Löschen von Datenaufgaben

-

Klicken Sie auf „Löschen“, um alle Datenaufgaben im Projekt oder eine Aufgabenauswahl zu löschen.

Ändern der Ansicht eines Projekts

Es gibt zwei verschiedene Ansichten für ein Projekt. Sie können zwischen den Ansichten wechseln, indem Sie auf Pipeline-Ansicht klicken.

-

Die Pipeline-Ansicht zeigt den Datenfluss der Datenaufgaben.

Sie können wählen, wie viele Informationen Sie für die Datenaufgaben anzeigen möchten, indem Sie auf Ebenen klicken. Aktivieren oder deaktivieren Sie die folgenden Informationen:

-

Status

-

Aktualität der Daten

-

Zeitplan

-

Projektübergreifende Ausgabe

Dadurch werden Aufgaben in anderen Projekten angezeigt, die eine Aufgabe in diesem Projekt nutzen. Alle Aufgaben außerhalb des aktuellen Projekts sind grau.

-

-

Die Kartenansicht zeigt Informationen über die Datenaufgabe.

Sie können nach Objekttyp und Besitzer filtern.

Anzeigen von Daten

Sie können Beispieldaten anzeigen, um die Form Ihrer Daten zu sehen und zu validieren, während Sie die Daten-Pipeline entwerfen.

Die folgenden Berechtigungen sind erforderlich:

-

Das Anzeigen von Daten auf Mandantenebene wird in Administration aktiviert.

Aktivieren Sie Einstellungen > Funktionssteuerung > Anzeigen von Daten in Datenintegration.

-

Ihnen wird die Rolle Kann Daten anzeigen in dem Bereich zugewiesen, in dem sich die Verbindung befindet.

-

Ihnen wird die Rolle Kann anzeigen in dem Bereich zugewiesen, in dem sich das Projekt befindet.

So zeigen Sie Beispieldaten in der Daten-Pipeline-Ansicht an:

-

Klicken Sie im Vorschau-Banner unten in der Pipeline-Ansicht auf

.

-

Wählen Sie aus, für welche Datenaufgabe Sie eine Vorschau der Daten anzeigen möchten.

Ein Beispiel der Daten wird angezeigt. Mit Zeilenanzahl können Sie festlegen, wie viele Datenzeilen in das Beispiel eingeschlossen werden sollen.

Exportieren und Importieren von Projekten

Sie können ein Projekt in eine JSON-Datei exportieren, die alle erforderlichen Informationen zum Rekonstruieren des Projekts enthält. Die exportierte JSON-Datei kann in den gleichen Mandanten oder in einen anderen Mandanten exportiert werden. Sie können dies beispielsweise zum Verschieben von Projekten von einem Mandanten zu einem anderen oder zum Erstellen von Sicherungskopien von Projekten verwenden.

Weitere Informationen finden Sie unter Exportieren und Importieren von Daten-Pipelines.

Ändern des Besitzers eines Projekts

Datenaufgaben werden im Kontext des Besitzers des Projekts, zu dem sie gehören, ausgeführt. Sie können jetzt den Besitzer eines Projekts ändern, um die Kontrolle über alle Aufgaben im Datenprojekt an einen anderen Benutzer zu übertragen. Dies ist zum Beispiel nützlich, wenn es Projekte gibt, die einem Benutzer gehören, der gelöscht wurde.

-

Klicken Sie in der Projektansicht auf ... und dann auf Besitzer ändern.

Die Besitzeränderung gilt für alle Aufgaben im Projekt. Alle katalogisierten Datensätze, die durch Aufgaben im Projekt erstellt werden, wechseln ebenfalls den Besitzer.

Ändern der Datenplattformverbindung

Wenn Sie die Verbindung zur Datenplattform für ein Projekt ändern, müssen Sie:

-

Tabellen in allen Bereitstellungsaufgaben neu erstellen.

-

Alle anderen Aufgaben im Projekt vorbereiten.

Projekteinstellungen

Sie können gemeinsame Eigenschaften für das Projekt und alle eingeschlossenen Datenaufgaben festlegen.

-

Klicken Sie auf Einstellungen.

Weitere Informationen finden Sie unter Daten-Pipeline-Projekteinstellungen.