S3システムにDatabricksからアクセスするためにS3固有のプロパティを追加する

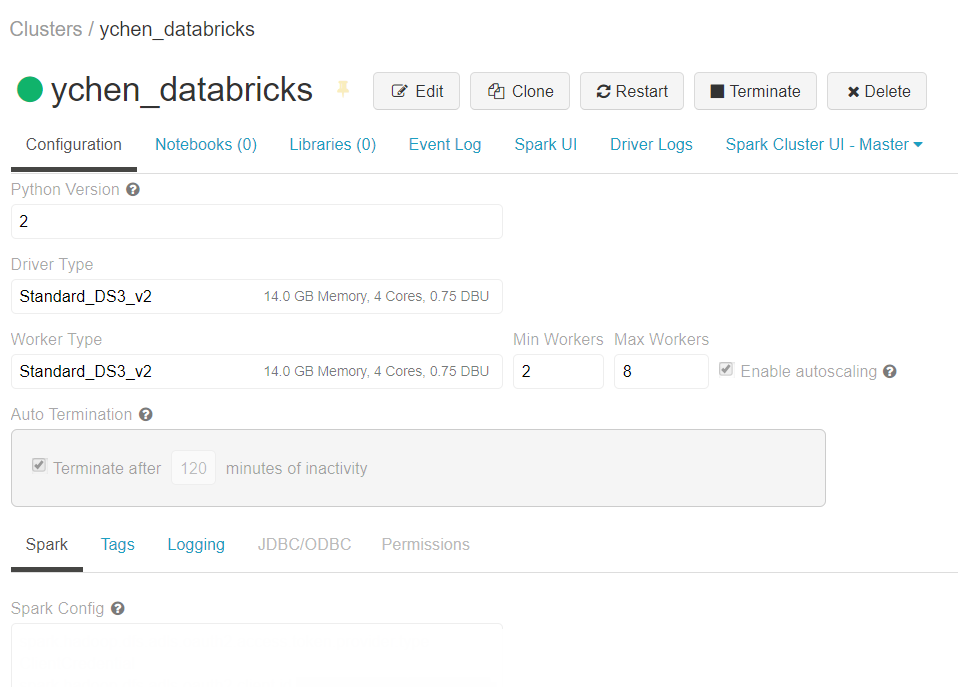

S3固有のプロパティをAWS上のDatabricksクラスターのSpark設定に追加します。

始める前に

- DatabricksのSparkクラスターが正しく作成され、実行されていることと、バージョンが3.5 LTSであることを確認します。詳細は、DatabricksドキュメンテーションでCreate Databricks workspace (英語のみ)をご覧ください。

- AWSアカウントを持っていること。

- 使用するS3バケットが適切に作成されており、それにアクセスするための適切な権限があること。