Sparkを使ってAzure Data Lake Storageからデータの書き込みと読み取りを行う(Azure Databricks)

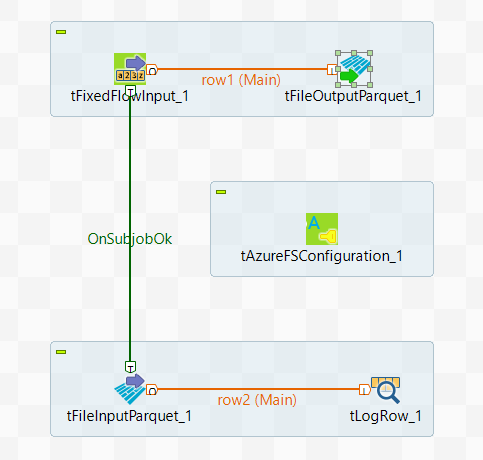

このシナリオでは、tAzureFSConfigurationを使ってSpark Batchジョブを作成し、Parquetコマンドを使ってデータをAzure Data Lake Storageに書き込み、Azureからデータを読み取ります。

このシナリオは、ビッグデータ関連Talend製品にのみ適用されます。

Talendでサポートされているテクノロジーの詳細は、Talendコンポーネントをご覧ください。

読み取られたサンプルデータは次のとおりです。

01;ychenこのデータには、ユーザー名とこのユーザーに配布されたID番号が含まれています。

サンプルデータはあくまでも例示用です。