Groupement de données clients numériques dans des clusters dans HDFS (déprécié)

Ce scénario s'applique uniquement aux solutions Talend avec Big Data.

Pour plus de technologies supportées par Talend, consultez Composants Talend.

Ce scénario s'inspire d'une recherche concernant le clustering basé sur des modèles. Les données sont accessibles sur le site Wholesale customers Data Set (uniquement en anglais) (en anglais). La recherche est disponible à l'adresse suivante Enhancing the selection of a model-based clustering with external categorical variables (uniquement en anglais) (en anglais). Ce scénario est compris dans le projet Data Quality Demos que vous pouvez importer dans votre Studio Talend . Pour plus d'informations, consultez le Guide d'utilisation du Studio Talend.

Le Job de ce scénario se connecte à un système de fichiers distribué Hadoop (HDFS), regroupe les clients d'un distributeur grossiste dans deux clusters à l'aide des algorithmes du tMahoutClustering et écrit en sortie des données dans un HDFS donné.

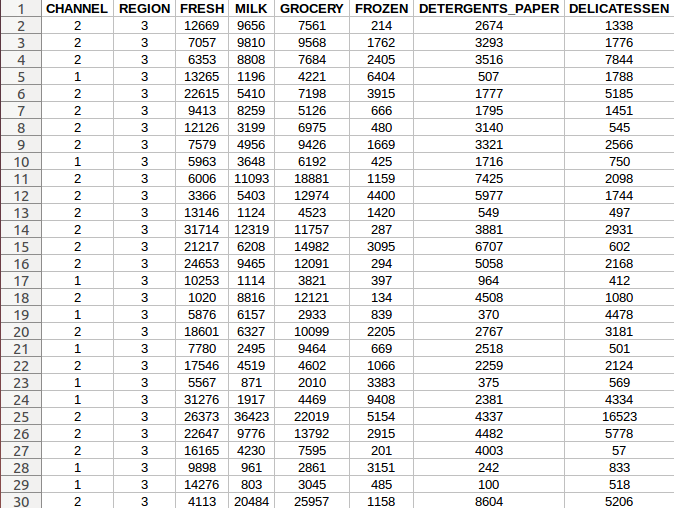

Le jeu de données contient 440 exemples de données se référant à des clients d'un distributeur en gros. Il comprend les dépenses annuelles (en unité monétaire) dans les différentes catégories de produits, comme les produits frais, les produits d'épicerie ou le lait.

Le jeu de données fait référence à des clients de différents canaux de vente - Horeca (Hôtel/Restaurant/Café) ou commerce de détail et de différentes régions (Lisbonne/Porto/autres).

Ce Job utilise :

-

un tMahoutClustering afin de calculer les clusters pour l'ensemble des données d'entrée,

-

deux tAggregateRow pour compter le nombre de clients dans les clusters selon les colonnes region et channel,

-

trois tMap afin de mapper les flux d'entrée des canaux de vente et des régions dans deux flux de sortie séparés. Les composants sont également utilisés pour mapper l'unique colonne clusterID reçue du tMahoutClustering vers le flux de données contenant deux colonnes, alimentant les clusters des régions et des canaux de vente,

-

deux tHDFSOutput pour écrire des données dans HDFS, dans deux fichiers de sortie.

Prérequis : Avant de pouvoir utiliser le composant tMahoutClustering vous devez avoir un système Hadoop fonctionnel.