Créer une connexion à MapR-DB

Procédure

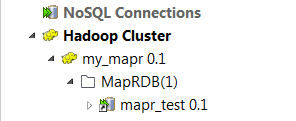

Résultats

Si vous devez utiliser un contexte environnemental pour définir les paramètres de cette connexion, cliquez sur le bouton Export as context pour ouvrir l'assistant correspondant et choisir parmi les options suivantes :

-

Create a new repository context : créer le contexte environnemental depuis la connexion Hadoop actuelle, c'est-à-dire que les paramètres à configurer dans l'assistant sont pris comme variables de contexte avec les valeurs données à ces paramètres.

-

Reuse an existing repository context : utiliser les variables d'un contexte environnemental afin de configurer la connexion actuelle.

Pour un exemple étape par étape concernant l'utilisation de la fonctionnalité Export as context, consultez Exporter une métadonnée en tant que contexte et réutiliser ses paramètres de contexte pour configurer une connexion.