Nouvelles fonctionnalités

Intégration d'application

| Fonctionnalité | Description |

|---|---|

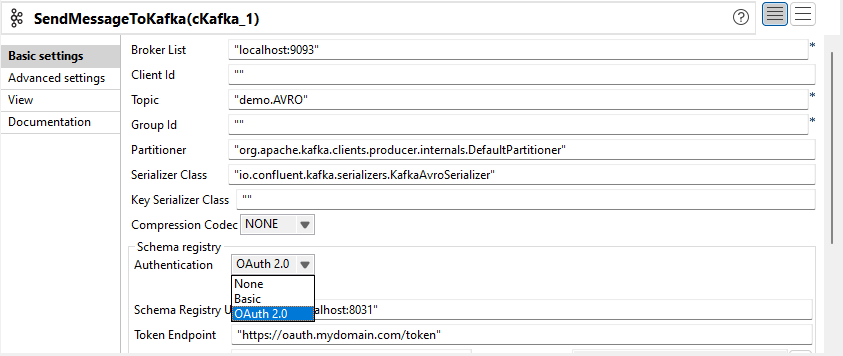

| Support de la connexion à Kafka Registry via OAuth dans le composant cKafka | Le Studio Talend supporte à présent l'authentification OAuth 2.0 pour la connexion au Registre Kafka dans le composant cKafka.  |

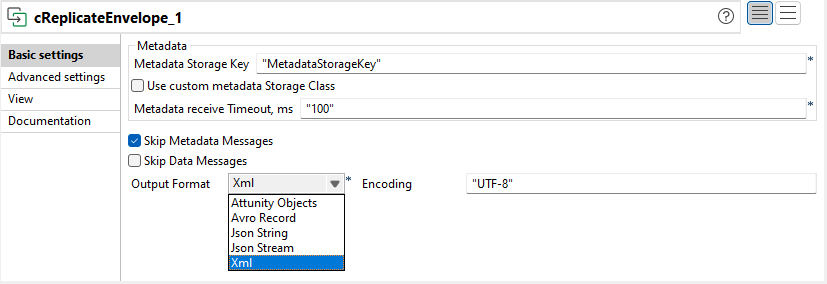

| Support de la sélection du décodeur et du choix de format de sortie Avro dans le composant cReplicateEnvelope | Le composant cReplicateEnvelope a été amélioré comme suit :

|

| Support du serveur Jetty et de la configuration des logs d'accès pour les microservices | Des paramètres ont été ajoutés dans le fichier des propriétés du microservice afin de configurer le serveur Jetty et accéder aux logs. Pour plus d'informations, consultez Exécuter un microservice. |

Big Data

| Fonctionnalité | Description |

|---|---|

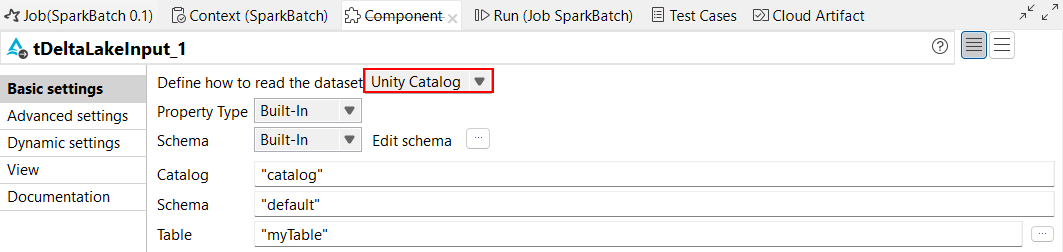

| Support des tables gérées par Delta Lake avec Unity Catalog | Vous pouvez utiliser Unity Catalog avec les tables gérées dans les composants tDeltaLakeInput et tDeltaLakeOutput. Avec Unity Catalog, vous pouvez également analyser vos données à l'aide du lignage de données. Notez que le lignage de données est supporté uniquement pour les composants utilisant des DS et non des RDD. Pour plus d'informations, consultez Utiliser des tables gérées Databricks avec Unity Catalog.  |

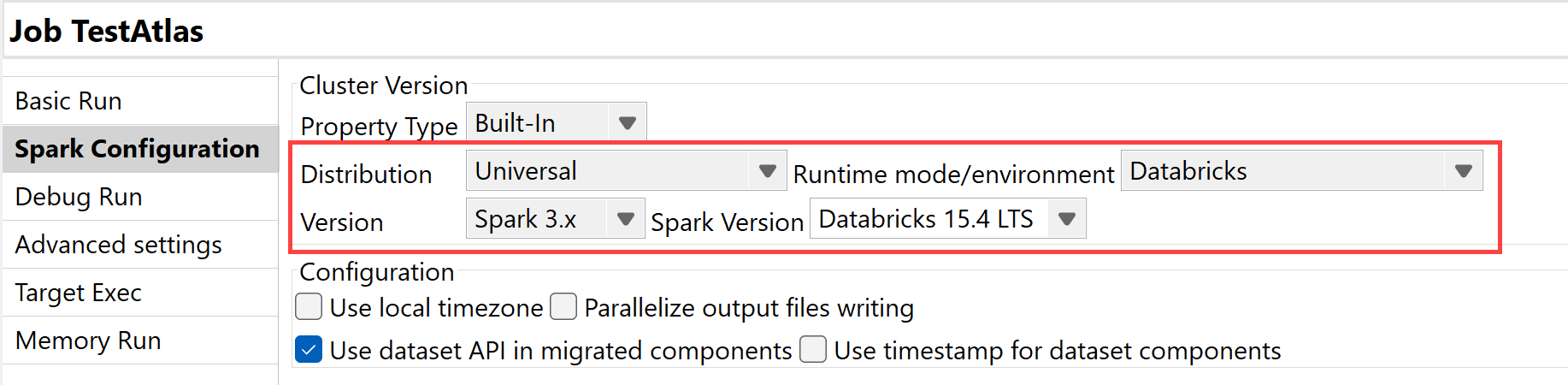

| Support de Databricks 15.4 LTS avec Spark Universal 3.x |

Vous pouvez à présent exécuter vos Jobs Spark Batch et Streaming sur des clusters de jobs et des clusters universels Databricks sur Google Cloud Platform (GCP), AWS et Azure, à l'aide de Spark Universal avec Spark 3.x. Vous pouvez la configurer dans la vue Spark Configuration (Configuration de Spark) de vos Jobs Spark ou dans l'assistant de métadonnées Hadoop Cluster Connection (Connexion au cluster Hadoop). Lorsque vous sélectionnez ce mode, le Studio Talend est compatible avec Databricks 15.4 LTS.  |

Intégration de données

| Fonctionnalité | Description |

|---|---|

|

Nouveau composant tClaudeAIClient permettant d'utiliser des modèles Claude dans les Jobs Standards |

Le nouveau composant tClaudeAIClient est à présent disponible dans les Jobs Standards et vous permet de tirer parti des modèles Claude et de leurs différentes fonctionnalités. |

|

Support des fonctionnalités de recherche vectorielle pour les composants Snowflake dans les Jobs Standards |

L'option Use vectors (Utiliser des vecteurs) a été ajoutée aux composants tSnowflakeOutput, tSnowflakeOutputBulkExec et tSnowflakeBulkExec, vous permettant d'utiliser les fonctionnalités de recherche vectorielle. |

Data Mapper

| Fonctionnalité | Description |

|---|---|

| Support des éléments de tableaux et des entrées de maps dans la clause SET dans les maps DSQL | Dans les maps DSQL, vous pouvez à présent déclarer une variable SET avec un élément de tableau :Vous pouvez également déclarer une variable SET avec une entrée de map :

|