Neue Funktionen

Anwendungsintegration

| Funktion | Beschreibung |

|---|---|

| Unterstützung der OAuth-Verbindung mit Kafka-Registrierung in der cKafka-Komponente | Talend Studio unterstützt jetzt die Oauth 2.0-Authentifizierung für die Verbindung mit der Kafka-Registrierung in der cKafka-Komponente.  |

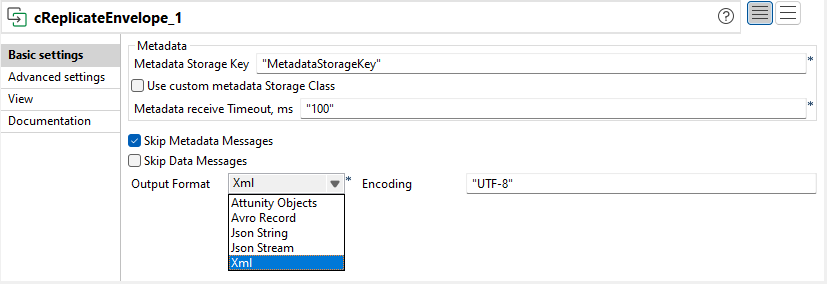

| Unterstützung der Inline-Auswahl des Avro-Decoders und Auswahl des Ausgabeformats in der cReplicateEnvelope-Komponente | Die cReplicateEnvelope-Komponente wird mit folgenden Elementen verbessert:

|

| Unterstützung für Jetty-Server und Zugriffsprotokollkonfiguration für Microservices | Neue Parameter werden in der Eigenschaftsdatei für Microservice hinzugefügt, um Jetty-Server und Zugriffsprotokolle zu konfigurieren. Weitere Informationen finden Sie unter Ausführen eines Microservice. |

Big Data

| Funktion | Beschreibung |

|---|---|

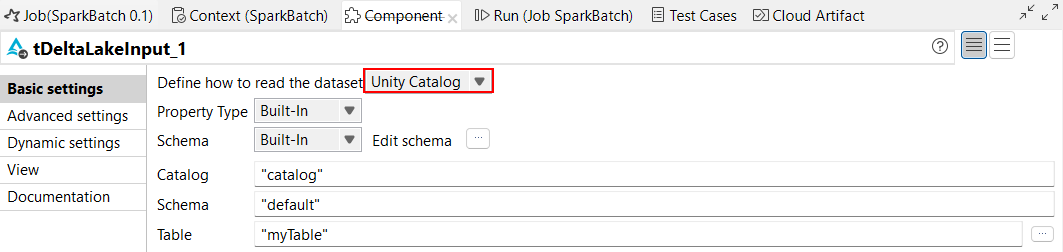

| Unterstützung für von Delta Lake verwaltete Tabellen mit Unity Catalog | Sie können jetzt Unity Catalog für die Arbeit mit verwalteten Tabellen in tDeltaLakeInput- und tDeltaLakeOutput-Komponenten verwenden. Mit Unity Catalog können Sie auch Ihre Daten mithilfe von Datenherkunft analysieren. Beachten Sie, dass Datenherkunft nur für Komponenten unterstützt wird, die DS (nicht RDD) verwenden. Weitere Informationen finden Sie im Abschnitt zum Arbeiten mit von Databricks verwalteten Tabellen mithilfe von Unity Catalog.  |

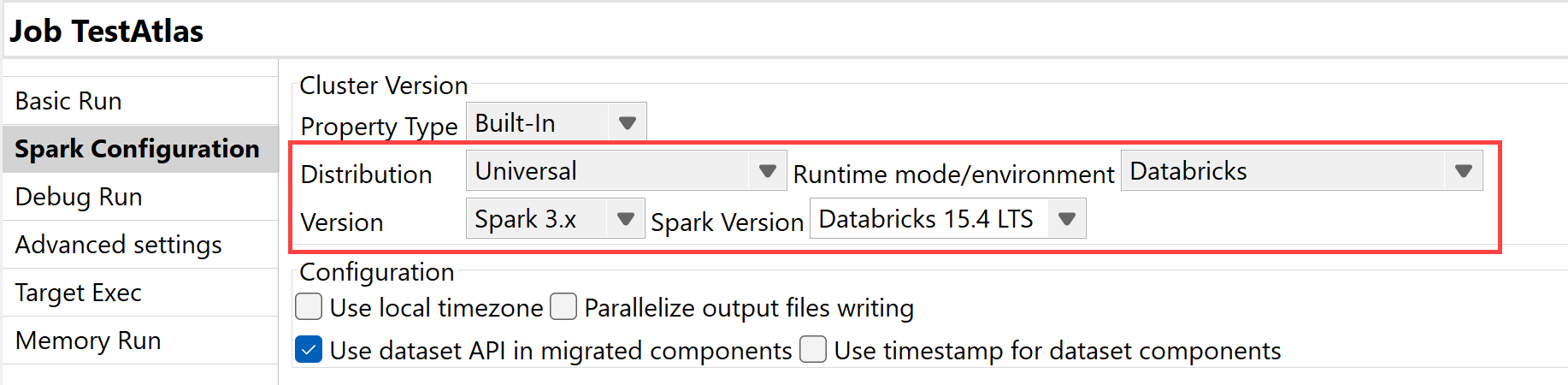

| Unterstützung für Databricks 15.4 LTS mit Spark Universal 3.x |

Sie können Ihre Spark Batch- und Streaming-Jobs jetzt in jobbasierten wie auch in multifunktionalen Databricks-Clustern in Google Cloud Platform (GCP), AWS und Azure unter Rückgriff auf Spark Universal mit Spark 3.x ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, ist Talend Studio mit Databricks 15.4 LTS kompatibel.  |

Datenintegration

| Funktion | Beschreibung |

|---|---|

|

Neue tClaudeAIClient-Komponente zum Verwenden von Claude-Modellen in Standard-Jobs |

Die neue tClaudeAIClient-Komponente ist jetzt in Standard-Jobs verfügbar und ermöglicht Ihnen die Nutzung von Claude-Modellen und deren verschiedenen Funktionen. |

|

Unterstützung für die Vektorsuchfunktionen für Snowflake-Komponenten in Standard-Jobs |

Die Option Use vectors (Vektoren verwenden) wurde zu den Komponenten tSnowflakeOutput, tSnowflakeOutputBulkExec und tSnowflakeBulkExec hinzugefügt, damit Sie Vektorsuchfunktionen nutzen können. |

Data Mapper

| Funktion | Beschreibung |

|---|---|

| Unterstützung für Array-Elemente und Map-Einträge in der SET-Klausel in DSQL-Maps | In DSQL-Maps können Sie jetzt eine SET-Variable mit einem Array-Element deklarieren:Sie können jetzt auch eine SET-Variable mit einem Map-Eintrag deklarieren:

|