Écrire et lire des données depuis Azure Data Lake Storage à l'aide de Spark (Azure Databricks)

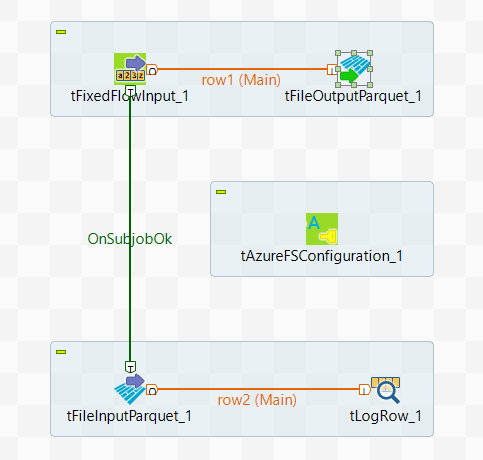

Dans ce scénario, vous allez créer un Job Spark Batch utilisant un tAzureFSConfiguration et les composants Parquet pour écrire des données dans Azure Data Lake Store et les lire depuis Azure.

Ce scénario s'applique uniquement aux solutions Talend avec Big Data.

Pour plus de technologies supportées par Talend, consultez Composants Talend.

L'échantillon de données utilisé est le suivant :

01;ychenCes données contiennent un identifiant utilisateur·rice et un ID distribué à cet·te utilisateur·rice.

Notez que les données d'exemple sont créées à des fins de démonstration uniquement.