Nouvelles fonctionnalités

Intégration d'application

| Fonctionnalité | Description |

|---|---|

| Nouveaux composants cAzureEventHubs et cAzureConnection dans les Routes | Les nouveaux composants cAzureEventHubs et cAzureConnection sont à présent disponibles dans les Routes, vous permettant d'envoyer des messages vers ou de consommer des messages depuis Azure Event Hubs. |

| Nouveau composant cReplicateEnvelope dans les Routes (Bêta) | Le nouveau composant cReplicateEnvelope est à présent disponible dans les Routes en version Bêta, vous permettant de décoder des messages créés par Qlik Replicate. |

Big Data

| Fonctionnalité | Description |

|---|---|

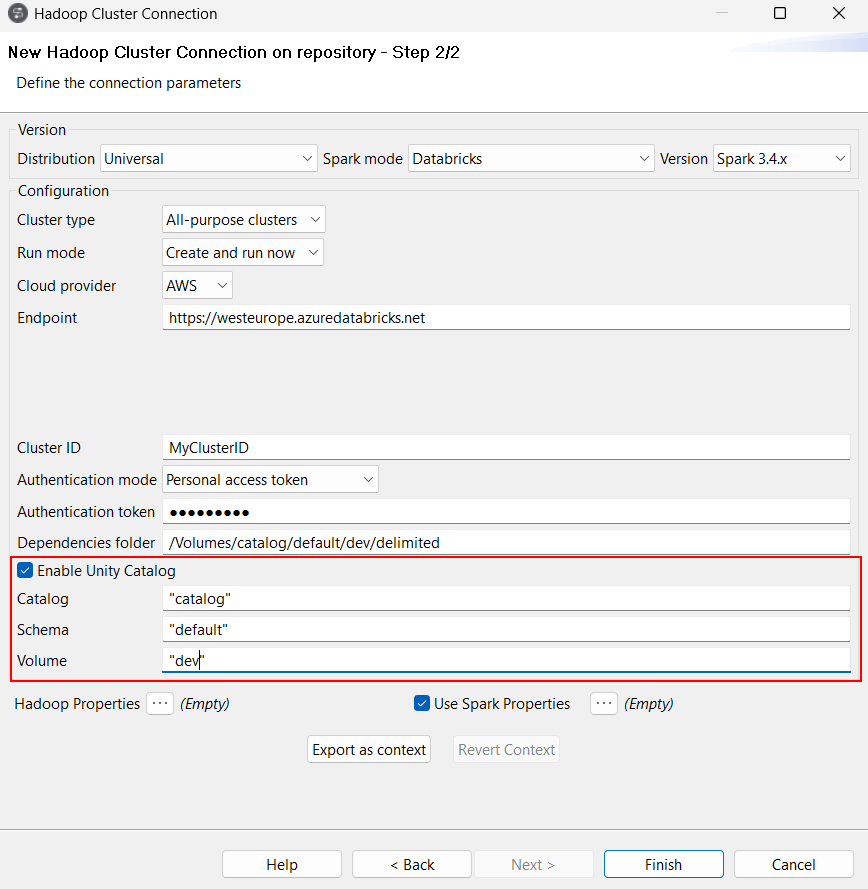

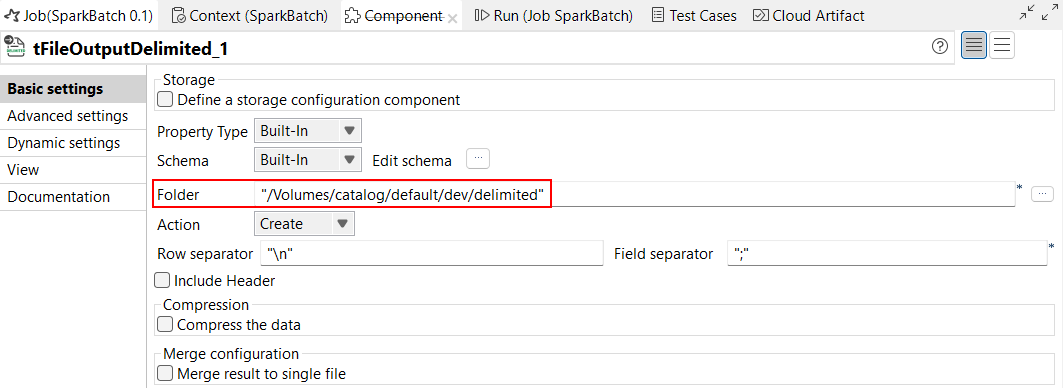

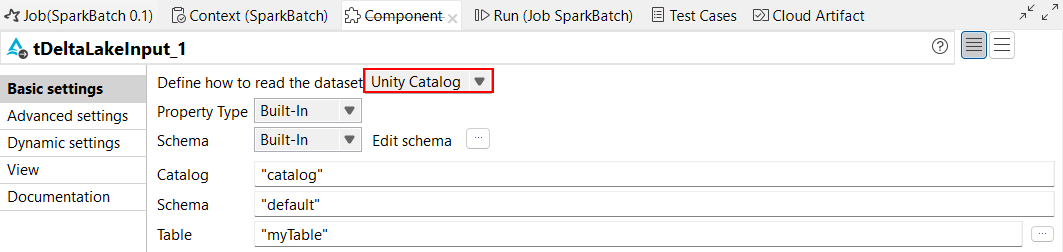

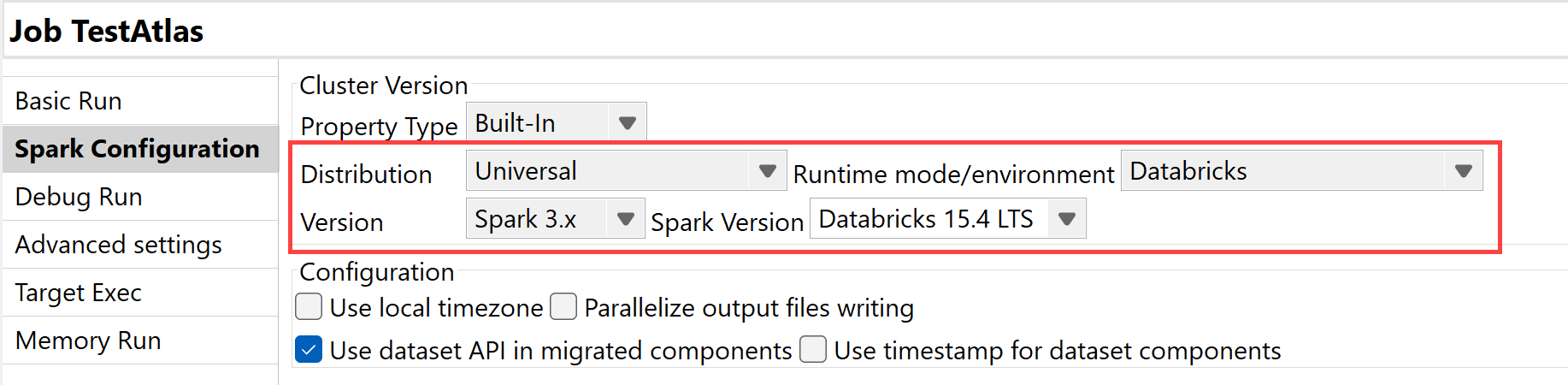

| Support d'Unity Catalog | Unity Catalog est à présent supporté dans les Jobs Spark Batch lorsque vous utilisez Spark Universal 3.4.x avec Databricks 13.3 LTS et Spark Universal avec Databricks 15.4 LTS. Vous pouvez la configurer dans la vue Spark Configuration (Configuration de Spark) de vos Jobs Spark Batch ou dans l'assistant de métadonnées Hadoop Cluster Connection (Connexion au cluster Hadoop).  Vous pouvez également configurer Unity Catalog dans les composants de traitement et d'extraction, ainsi que dans tous les composants d'entrée et de sortie disponibles dans les Jobs Spark Batch en spécifiant le chemin d'accès complet à Unity Catalog dans le paramètre Folder (Dossier), contenant le nom du catalogue, du schéma et du volume. Notez que seuls les composants utilisant l'API Dataset (DS) sont supportés avec Unity Catalog. Avec la version bêta de cette fonctionnalité, les composants Hive ne sont pas supportés.  Pour les composants tDeltaLakeInput et tDeltaLakeOutput, vous pouvez utiliser Unity Catalog afin qu'il fonctionne avec les tables gérées.

|

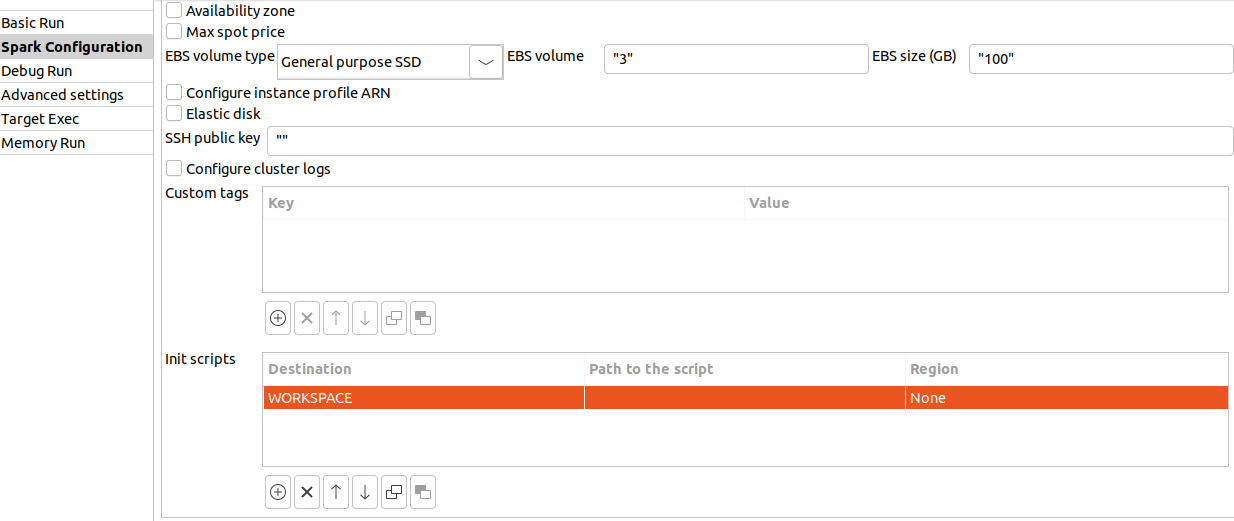

| Support de l'emplacement de l'espace de travail pour Databricks |

Pour Databricks, l'option DBFS n'est plus supportée pour l'emplacement de script. Elle a été remplacée par Workspace (Espace de travail).

À partir de Databricks 15.4 LTS, le système de fichiers DBFS n'est plus utilisé pour stocker les bibliothèques des applications. Le paramètre Dependencies folder (Dossier des dépendances) utilise le chemin d'accès à l'espace de travail (Workspace), au lieu de l'emplacement par défaut des bibliothèques. |

| Support de Databricks 15.4 LTS avec Spark Universal 3.x |

Vous pouvez à présent exécuter vos Jobs Spark Batch et Streaming sur des clusters de jobs et des clusters universels Databricks sur Google Cloud Platform (GCP), AWS et Azure, à l'aide de Spark Universal avec Spark 3.x. Vous pouvez la configurer dans la vue Spark Configuration (Configuration de Spark) de vos Jobs Spark ou dans l'assistant de métadonnées Hadoop Cluster Connection (Connexion au cluster Hadoop). Lorsque vous sélectionnez ce mode, le Studio Talend est compatible avec Databricks 15.4 LTS.  |

Intégration de données

| Fonctionnalité | Description |

|---|---|

|

Support des fonctionnalités de recherche vectorielle pour les composants Delta Lake dans les Jobs Standards |

Les composants Delta Lake peuvent à présent utiliser les fonctionnalités de recherche vectorielle Databricks. |

|

Le composant tOllamaClient est à présent supporté en tant que composant d'entrée dans les Jobs Standards |

Le composant tOllamaClient peut à présent être utilisé comme composant de début dans un Job. |

|

Améliorations des options du tHTTPClient pour télécharger et enregistrer des ressources dans les Jobs Standards |

Les options Use custom attachment name (Utiliser le nom personnalisé de la pièce jointe ) et Use cache to save resource (Utiliser le cache pour économiser les ressources) ont été ajoutées au composant tHTTPClient et vous permettent de définir le nom de fichier de la pièce jointe, ainsi que d'enregistrer les données dans le cache pour améliorer les performances. |

Data Mapper

| Fonctionnalité | Description |

|---|---|

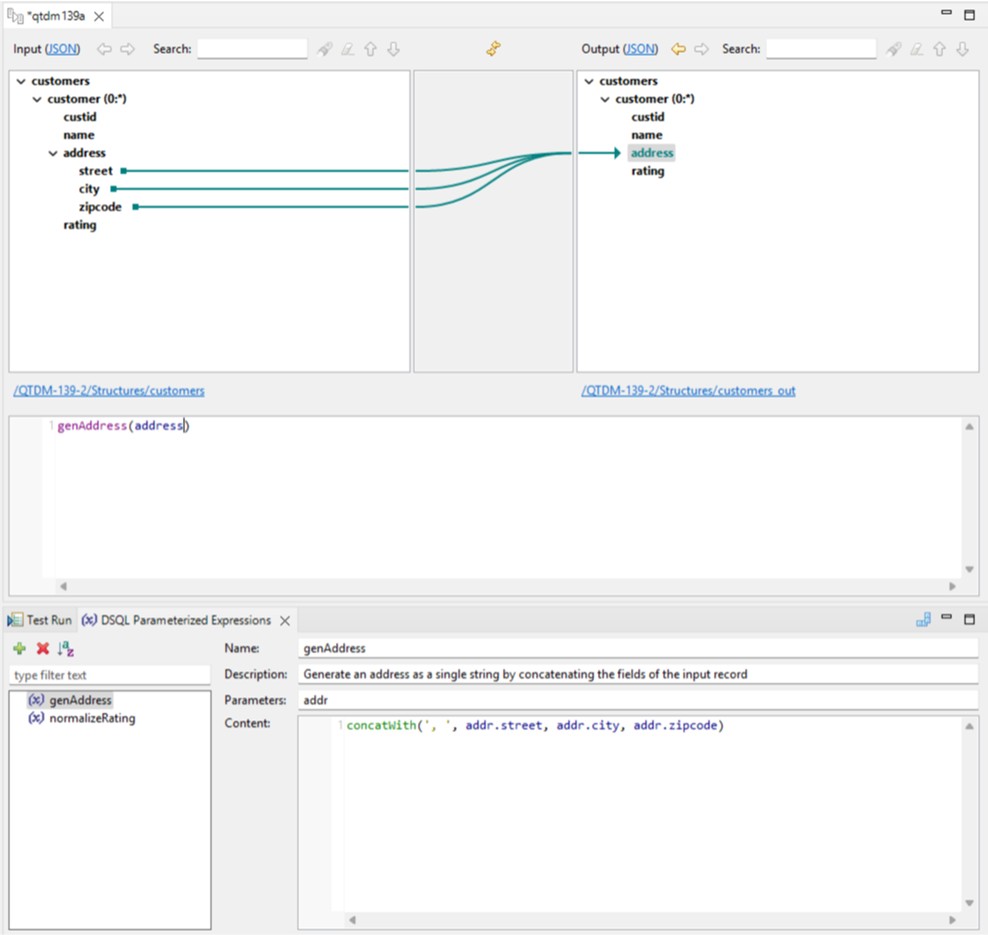

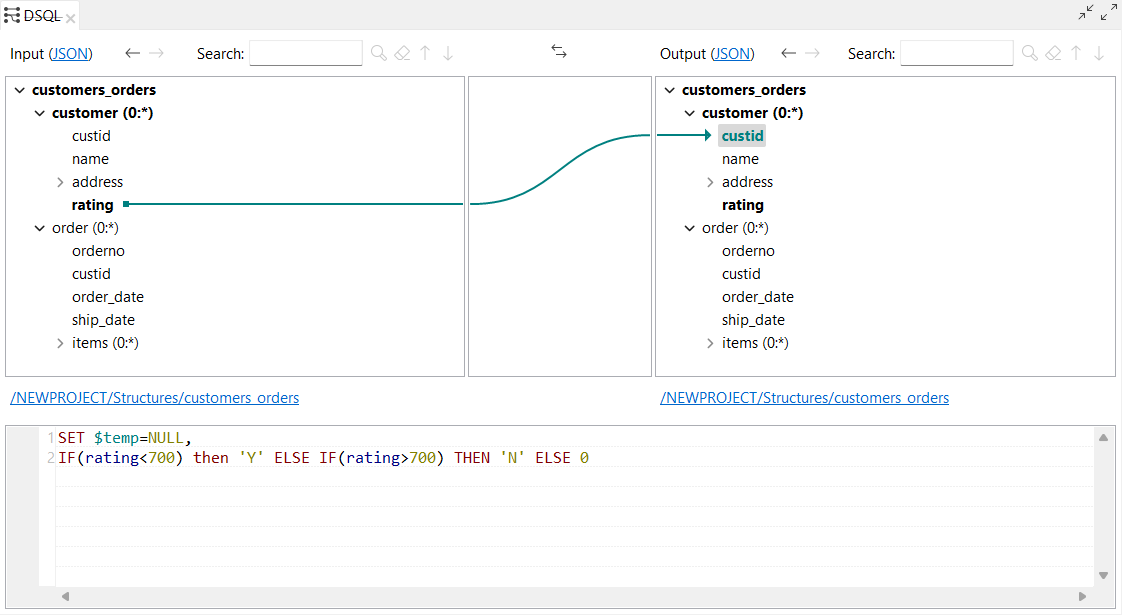

| Support des expressions paramétrées dans l'éditeur de map DSQL (DSEL) | Le Studio Talend supporte à présent les expressions paramétrées dans l'éditeur de maps, qui vous permettent de créer des expressions flexibles et adaptables. |

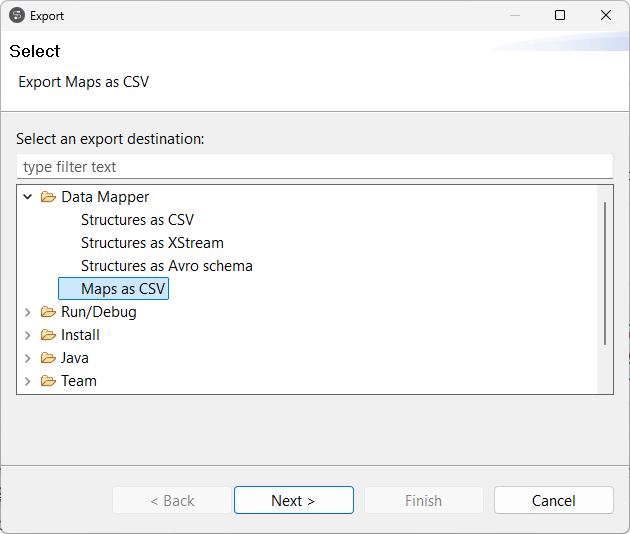

| Support de l'export de maps DSQL vers CSV | Vous pouvez à présent exporter une map DSQL en tant que fichier CSV, avec la nouvelle option Maps as CSV (Maps en tant que CSV). Le fichier exporté est également compatible avec Excel. Pour plus d'informations, consultez Exporter une map.  |

| Support des schémas Avro (Confluent registry) avec import de structure | Vous pouvez à présent créer une structure à partir d'un schéma Avro stocké dans Confluent Schema Registry. Pour plus d'informations, consultez Utiliser un schéma Avro (Confluent Registry).  |

| Support des maps d'aplatissement DSQL | Le Studio Talend supporte à présent les maps d'aplatissement DSQL. Cette fonctionnalité remplace le support des maps d'aplatissement standards. Pour plus d'informations concernant les maps d'aplatissement DSQL, consultez Créer une map d'aplatissement.  |

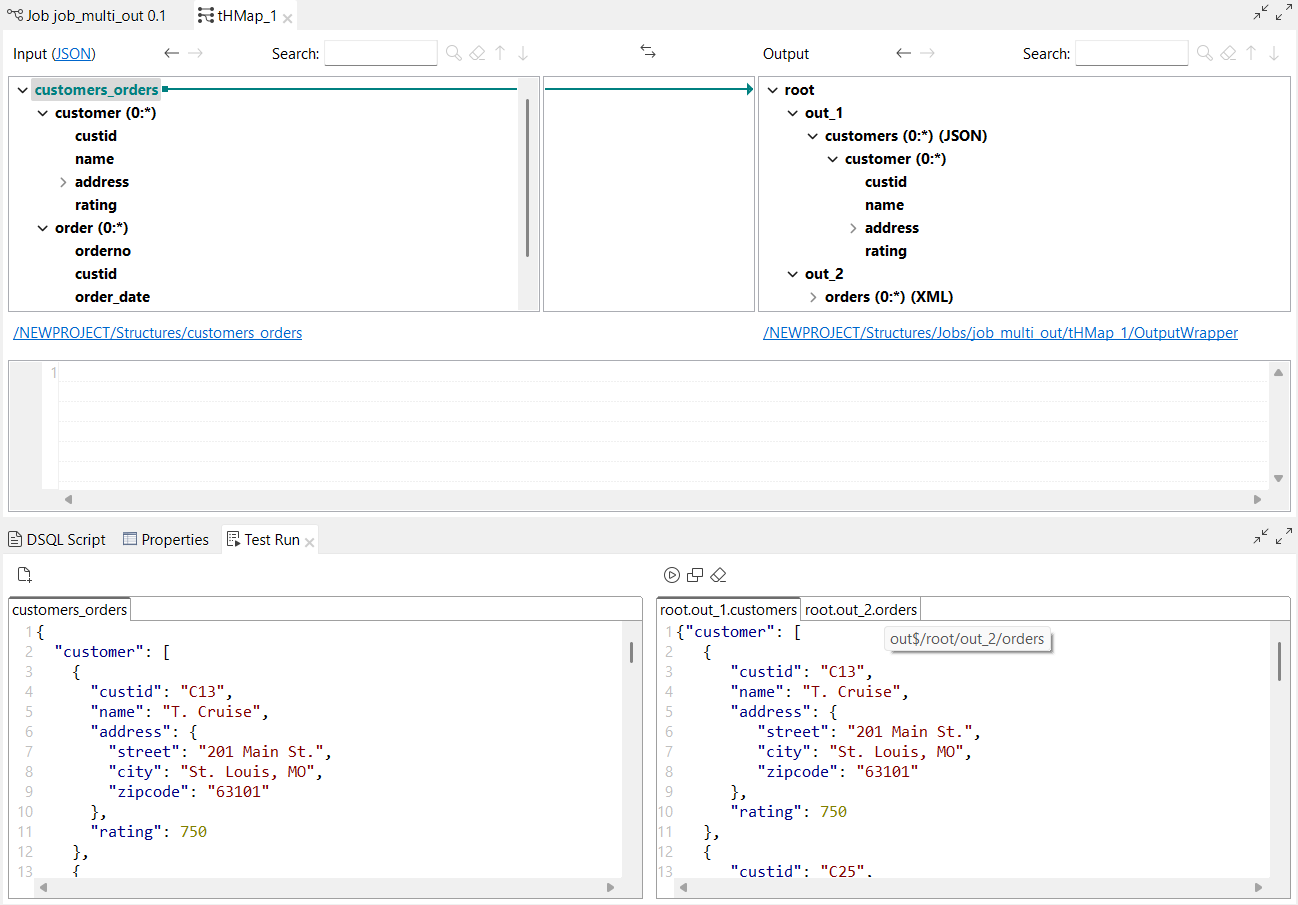

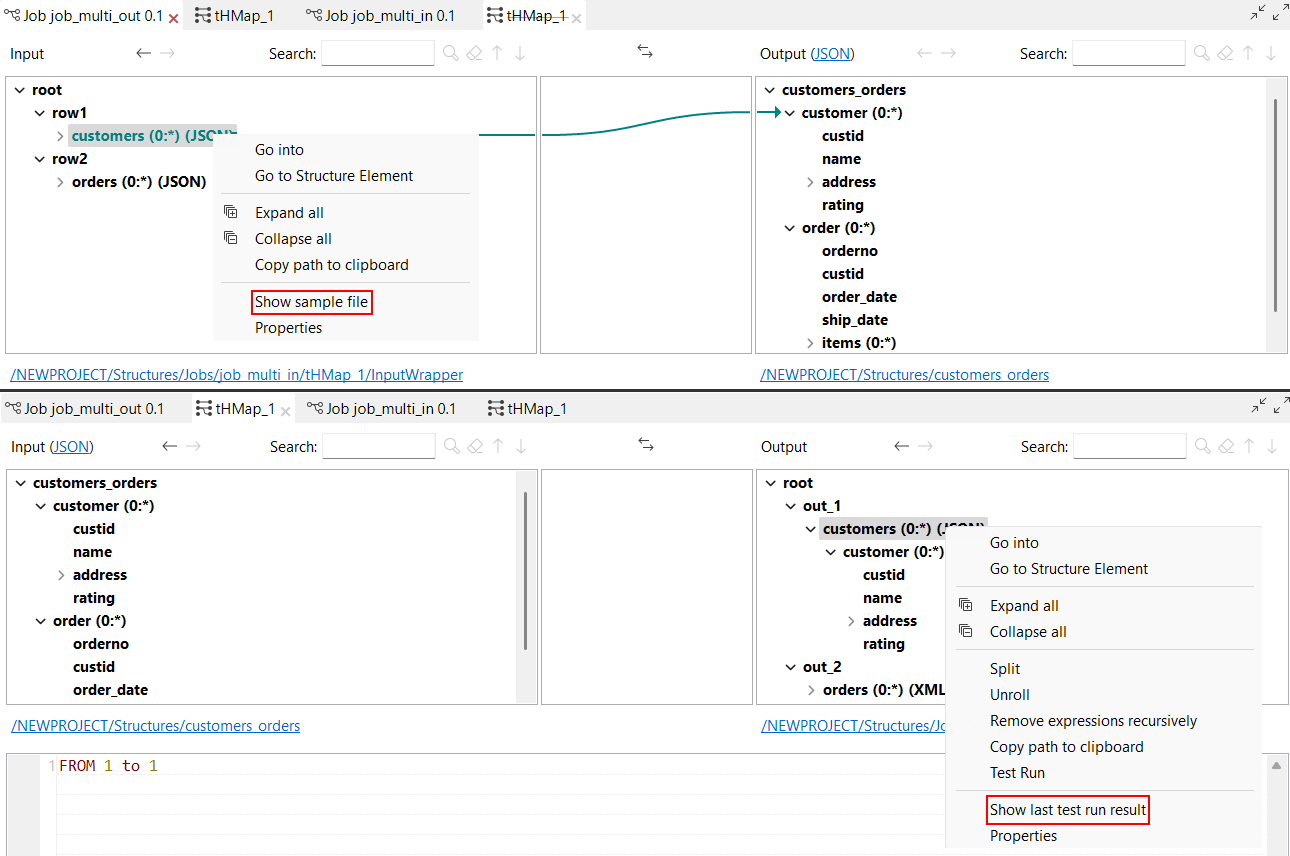

| Support de plusieurs entrées et sorties dans la vue Test Run (Exécution de test) des maps DSQL | La fonctionnalité Test Run (Exécution de test) peut à présent être utilisée sur les maps DSQL avec plusieurs entrées et sorties. Dans la vue Test Run (Exécution de test) :

Avec cette fonctionnalité, deux nouvelles options sont disponibles lorsque vous cliquez-droit sur la structure :

|

| Nouvelles fonctions de tableau dans les maps DSQL | Les fonctions de tableaux suivantes sont à présent disponibles dans les maps DSQL :

|

| Nouvelles fonctions getValueFromExternalMap et putValueToExternalMap dans les maps DSQL | Les fonctions suivantes sont à présent disponibles dans les maps DSQL :

|

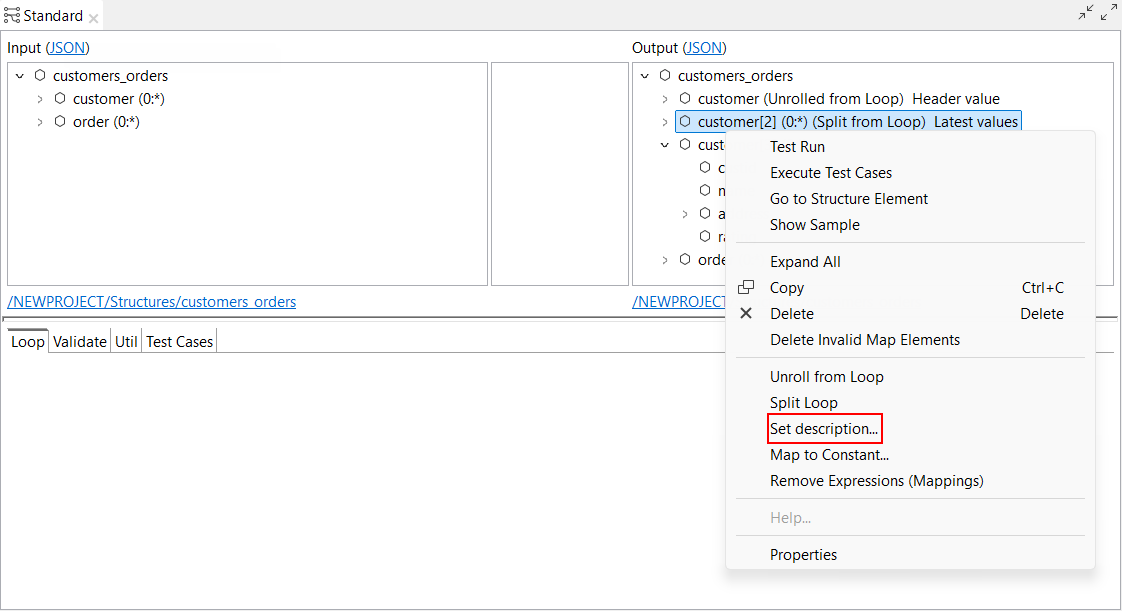

| Nouvelle option de définition d'une description pour les boucles scindées (split) et déroulées (unrolled) dans les maps Standards | Le paramètre Set description... (Configurer la description...) est à présent disponible pour les éléments scindés et déroulés dans les maps Standards. Il vous permet de configurer une description pour ces éléments, qui peuvent être différents des éléments de boucle de base de la map.  |

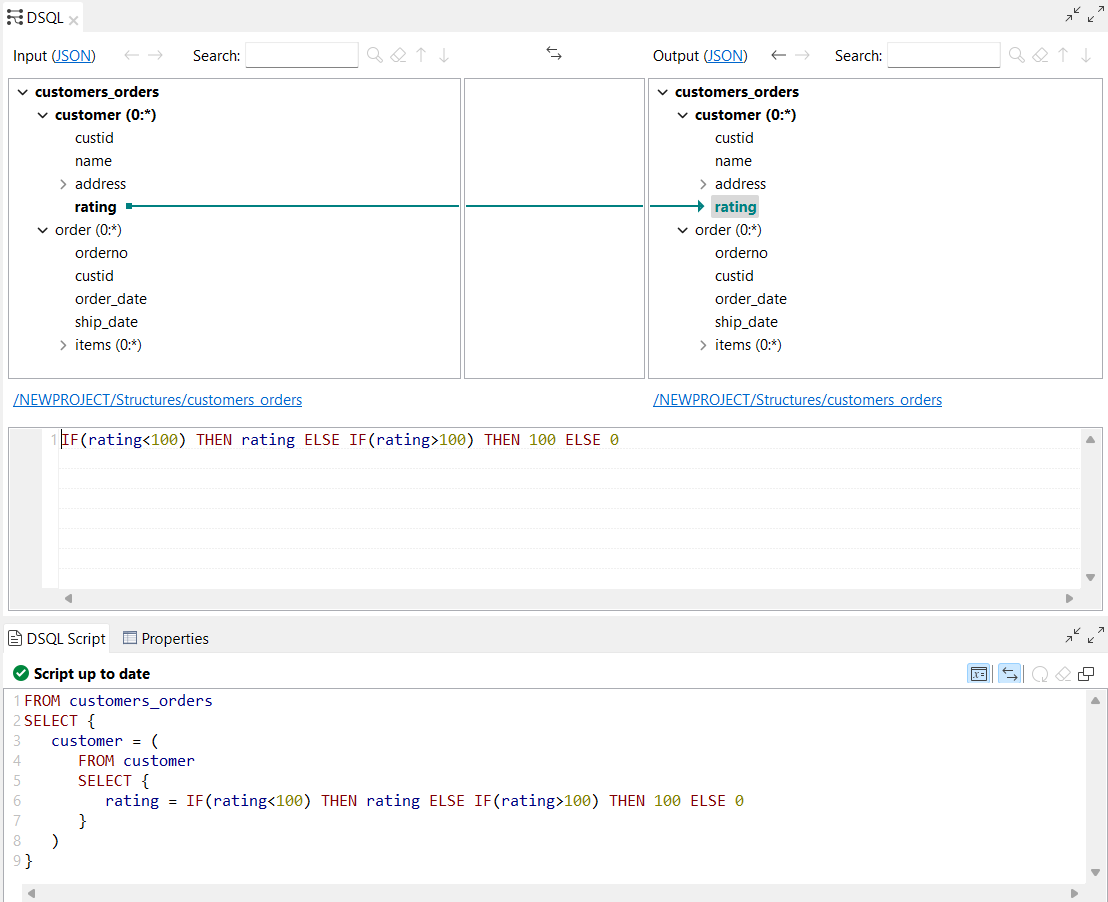

| Support des mots-clés ELSE IF et THEN dans les expressions conditionnelles des maps DSQL | Le Studio Talend supporte à présent les mots-clés ELSE IF et THEN dans les expressions conditionnelles des maps DSQL |

| Nouveau raccourci pour ouvrir et lancer l'exécution de test dans l'éditeur de maps DSQL | Un nouveau raccourci clavier, Ctrl + T, est à présent disponible pour ouvrir et démarrer une exécution de test dans l'éditeur de maps DSQL. |

| Mise à jour de la stratégie de résolution de choix du lecteur COBOL | La stratégie de résolution de choix du lecteur COBOL est mise à jour lors de l'exécution, lorsque votre structure contient un choix entre différentes alternatives. La stratégie de fallback fonctionne à présent comme suit :

Une nouvelle option Apply default Choice resolution strategy to all alternatives (Appliquer la stratégie de résolution de choix par défaut à toutes les alternatives) est disponible dans la boîte de dialogue Cobol Properties (Propriétés Cobol), vous permettant d'appliquer la stratégie de résolution de choix par défaut, ce qui signifie que la stratégie de fallback est toujours appliquée à toutes les alternatives, lorsqu'aucune alternative ne peut être sélectionnée à l'aide d'une expression isPresent.  |

| Support du littéral NULL comme expression dans les maps DSQL | Le Studio Talend supporte à présent le mot-clé NULL en tant que littéral dans les expressions des maps DSQL. |

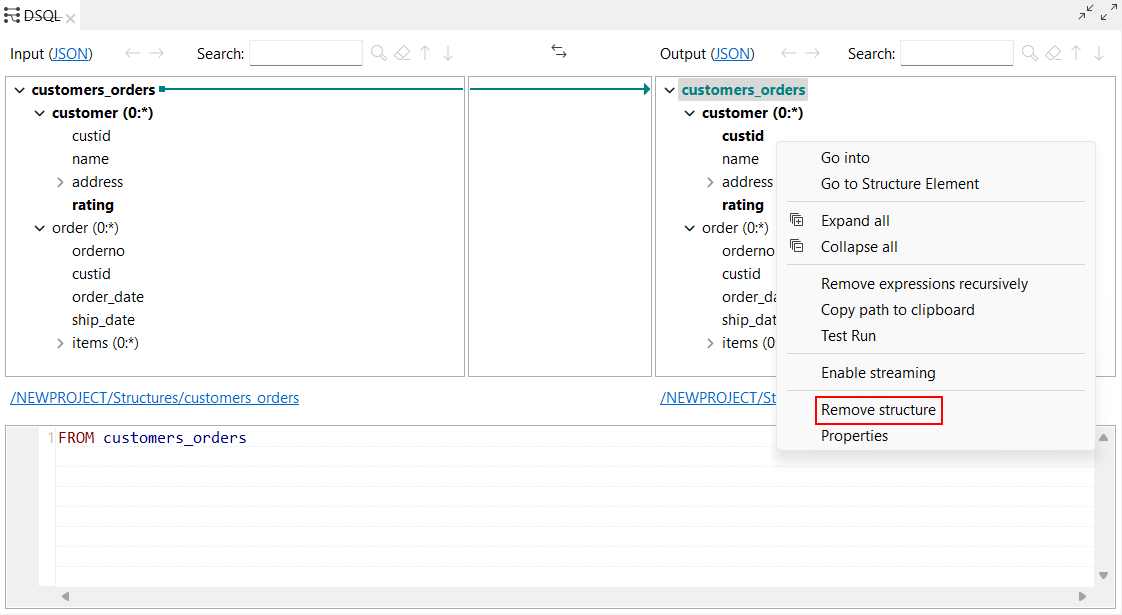

| Nouvelle option pour supprimer une structure d'une map DSQL | L'option Remove structure (Supprimer la structure) est à présent disponible lorsque vous cliquez-droit sur l'élément racine d'une structure dans une map DSQL. Cela vous permet de supprimer la structure d'entrée ou de sortie. |

Qualité de données

| Fonctionnalité | Description |

|---|---|

| Support de Snowflake pour la connexion à une base de données dans le référentiel | Vous pouvez créer une connexion à Snowflake dans la perspective Profiling et profiler des analyses de colonnes. |