新しい機能

アプリケーションインテグレーション

| 機能 | 説明 |

|---|---|

| ルートの新しいcAzureEventHubsコンポーネントとcAzureConnectionコンポーネント | ルートにcAzureEventHubsとcAzureConnectionという新しいコンポーネントが追加され、Google Cloud Pub/Subサービスにメッセージを送信したり、Azure Event Hubsからメッセージを受信できるようになりました。 |

| ルートの新しいcReplicateEnvelopeコンポーネント(ベータ版) | cReplicateEnvelopeという新しいコンポーネントがベータ版としてルートで利用可能になり、Qlik Replicateで作成されたメッセージをデコードできるようになりました。 |

ビッグデータ

| 機能 | 説明 |

|---|---|

| Unity Catalogをサポート | Spark Universal 3.4.xとDatabricks 13.3 LTS、およびSpark Universal 3.xとDatabricks 15.4 LTSを使用する場合に、SparkバッチジョブでUnity Catalogがサポートされるようになりました。 Spark Batchジョブの[Spark configuration] (Spark設定)ビューまたは[Hadoop Cluster Connection] (Hadoopクラスター接続)メタデータウィザードのどちらかで設定できます。 ![[Hadoop Cluster Connection] (Hadoopクラスター接続)メタデータウィザードで、[Enable Unity Catalog] (Unity Catalogを有効化)パラメーターが強調表示されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/enable-unity-catalog.png) また、Folderパラメーターにカタログ名、スキーマ名、ボリューム名が含まれていいるUnity Catalogへのフルパスを指定することで、ProcessingコンポーネントとExtractコンポーネントだけでなく、Spark Batchジョブで利用可能なすべての入出力コンポーネントでも、Unity Catalogを設定できます。 Unity Catalogでサポートされているのはデータセット(DS) APIを使用するコンポーネントのみですので、ご注意してください。この機能のベータ版では、Hiveコンポーネントはサポートされていません。 ![Unity Catalogへのパスが含まれている[Folder] (フォルダー)パラメーター。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/unity-catalog_components.png) tDeltaLakeInputコンポーネントとtDeltaLakeOutputコンポーネントでは、Unity Catalogを使って、管理対象テーブルで作業できます。

![tDeltaLakeInputの[Basic settings] (基本設定)ビューでのUnity Catalogオプション。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/unity-catalog-managed-tables.png) |

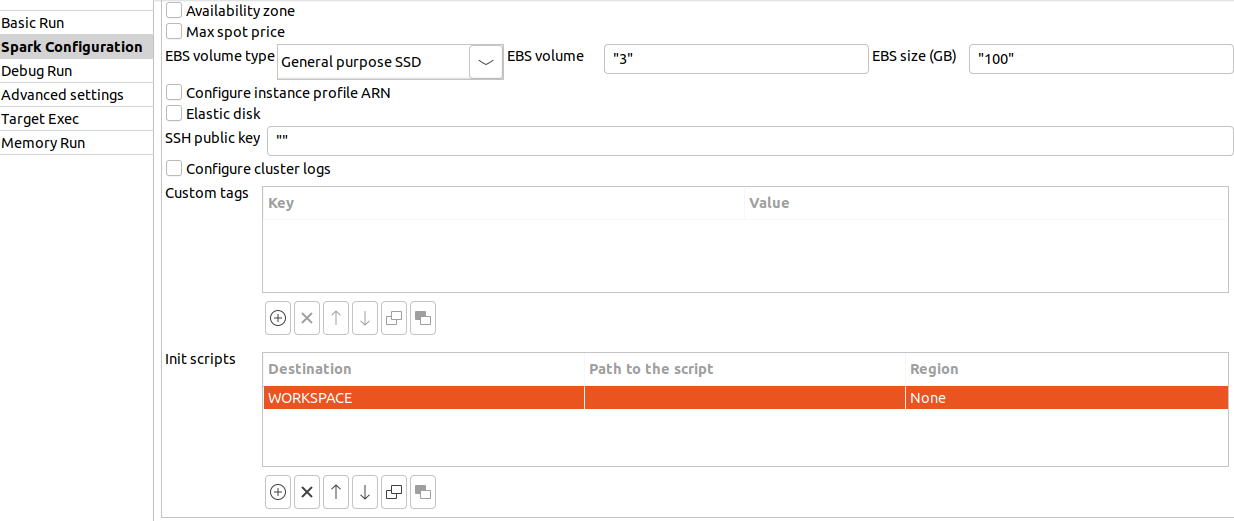

| Databricksのワークスペースロケーションをサポート |

Databricksでは、DBFSオプションがスクリプトの場所としてサポートされなくなりました。このオプションはワークスペースによって置き換えられました。

Databricks 15.4 LTS以降、DBFSはアプリケーションライブラリーの保存には使用されなくなりました。[Dependencies folder] (依存項目フォルダー)パラメーターは、デフォルトのライブラリーの場所として、代わりにワークスペースへのパスを使用します。 |

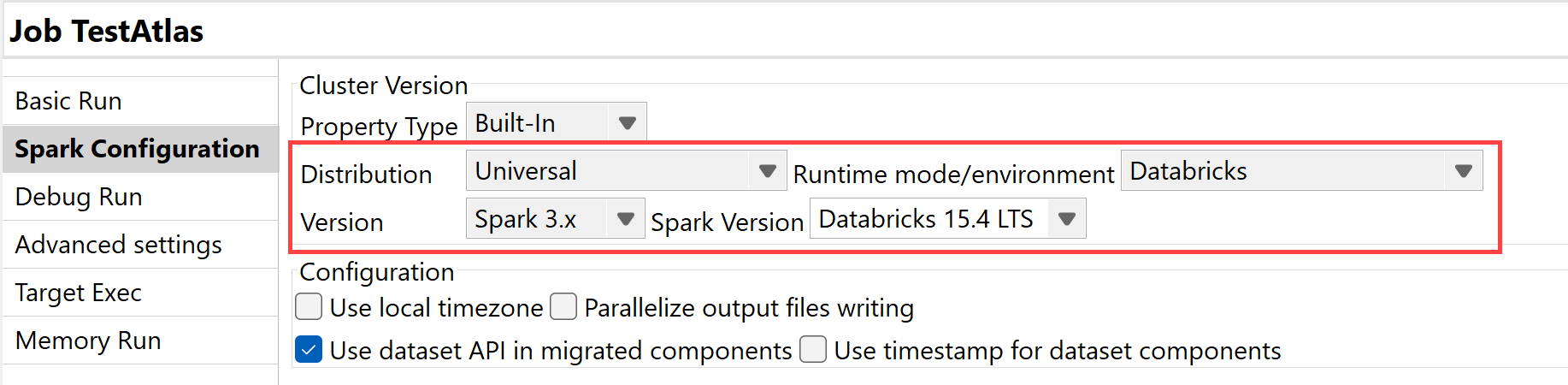

| Spark Universal 3.xとDatabricks 15.4 LTSをサポート |

Google Cloud Platform (GCP)、AWS、Azureで、Spark 3.xと共にSpark Universalを使い、Databricksのジョブクラスターと汎用クラスターでSpark BacthジョブやStreamingジョブを実行できるようになりました。Sparkジョブの[Spark configuration] (Spark設定)ビューまたは[Hadoop Cluster Connection] (Hadoopクラスター接続)メタデータウィザードのどちらかで設定できます。 このモードを選択すると、Talend StudioはDatabricks 15.4 LTSバージョンと互換性を持つようになります。  |

データ統合

| 機能 | 説明 |

|---|---|

|

標準ジョブのDelta Lakeコンポーネントでベクター検索をサポート |

Delta LakeコンポーネントがDatabricksのベクター検索機能を使用できるようになりました。 |

|

標準ジョブでtOllamaClientコンポーネントを入力コンポーネントとしてサポート |

tOllamaClientコンポーネントをジョブの開始コンポーネントとして使用できるようになりました。 |

|

tHTTPClientオプションを改善し、標準ジョブでリソースのダウンロードと保存が可能に |

tHTTPClientコンポーネントに[Use custom attachment name] (カスタムの添付ファイル名を使用)オプションと[Use cache to save resource] (キャッシュを使用してリソースを保存)オプションが追加されました。これにより、添付ファイルのファイル名を定義したり、パフォーマンス向上のためにデータをキャッシュに保存したりできるようになりました。 |

Data Mapper

| 機能 | 説明 |

|---|---|

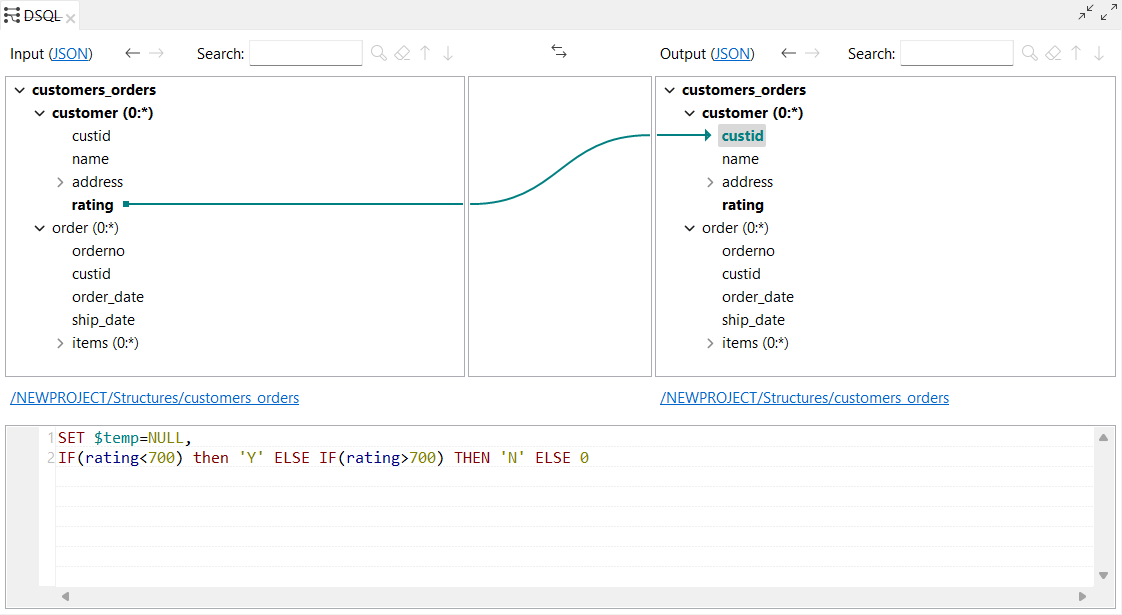

| DSQLマップエディター(DSEL)でパラメーター化済みの式をサポート | Talend Studioが、DSQLマップエディターでパラメーター化済みの式をサポートするようになりました。これによって、柔軟かつ適応性が高い式の作成が可能になります。![[DSQL Parameterized Expressions] (DSQLパラメーター化済みの式)ビュー。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/dsql-parameterized-expressions.jpg) |

| DSQLマップのCSVエクスポートをサポート | [Maps as CSV] (CSVとしてのマップ)オプションが追加され、標準マップをDSQLファイルとしてエクスポートできるようになりました。エクスポートされたファイルはExcelとも互換性があります。 詳細は、マップをエクスポートをご覧ください。 ![[Export Maps as CSV] (マップをCSVとしてエクスポート)ダイアログボックス。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/export-maps-as-csv.png) |

| ストラクチャーインポートによるAvroスキーマ(Confluentレジストリー)をサポート | Confluent Schema Registryに格納されているAvroスキーマからストラクチャーを作成できるようになりました。 詳細は、Avroスキーマ(Confluentレジストリー)で作業をご覧ください。 ![[Import Select] (インポート選択)ダイアログボックスで[Avro schema (Confluent Registry)] (Avroスキーマ(Confluentレジストリー))タイプが選択されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/tdm-avro-schema-confluent-registry.png) |

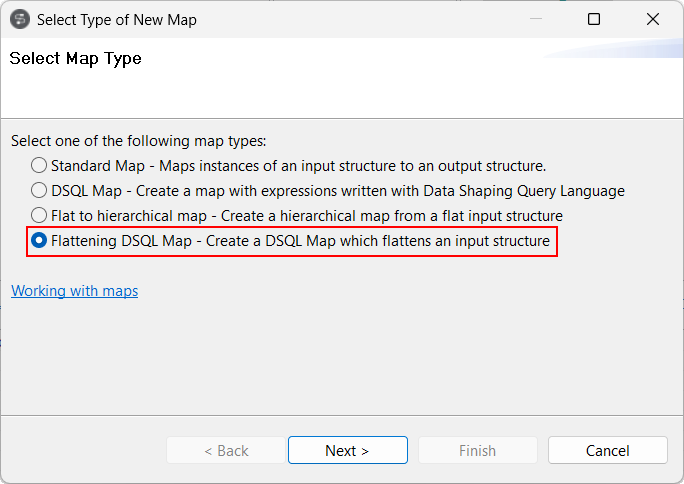

| DSQLフラット化マップをサポート | Talend StudioがDSQLフラット化マップをサポートするようになりました。この機能は、以前のフラット化標準マップのサポートに変わるものです。 DSQLフラット化マップの詳細は、フラット化マップを作成をご覧ください。  |

| DSQLマップの[Test Run] (テスト実行) ビューで複数の入出力をサポート | 入力や出力を複数持つDSQLマップの場合、[Test Run] (テスト実行)機能は使用できません。 [Test Run] (テスト実行)ビューで:

![[Test Run] (テスト実行)ビューで、複数の出力を持つストラクチャーが強調表示されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/dsql-map-multipleIO.png) これによって、ストラクチャーを右クリックした時に、次の2つの新しいオプションが利用可能になりました:

![ストラクチャーを右クリックし、[Show sample file] (サンプルファイルを表示)パラメーターと[Show last test run result] (最後の実行結果を表示)パラメーターが強調表示されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/dsql-map-multipleIO-rightclick.png) |

| DSQLマップでの新しい配列ファンクション | 次の配列ファンクションがDSQLマップで利用可能になりました:

|

| DSQLマップの新しいgetValueFromExternalMapファンクションとputValueToExternalMapファンクション | 次のファンクションがDSQLマップで利用可能になりました:

|

| 標準マップでの分割ループと展開ループに説明を設定できる新しいオプション | 標準マップ内の分割されたエレメントと展開されたエレメントで、[Set description...] (説明を設定...)パラメーターが利用可能になりました。そのようなエレメントに対し、ベースとなるループマップエレメントとは異なる説明を設定できます。 ![分割ループを右クリックし、[Set description...] (説明を設定...)パラメーターが強調表示されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/standard-map-set-description.png) |

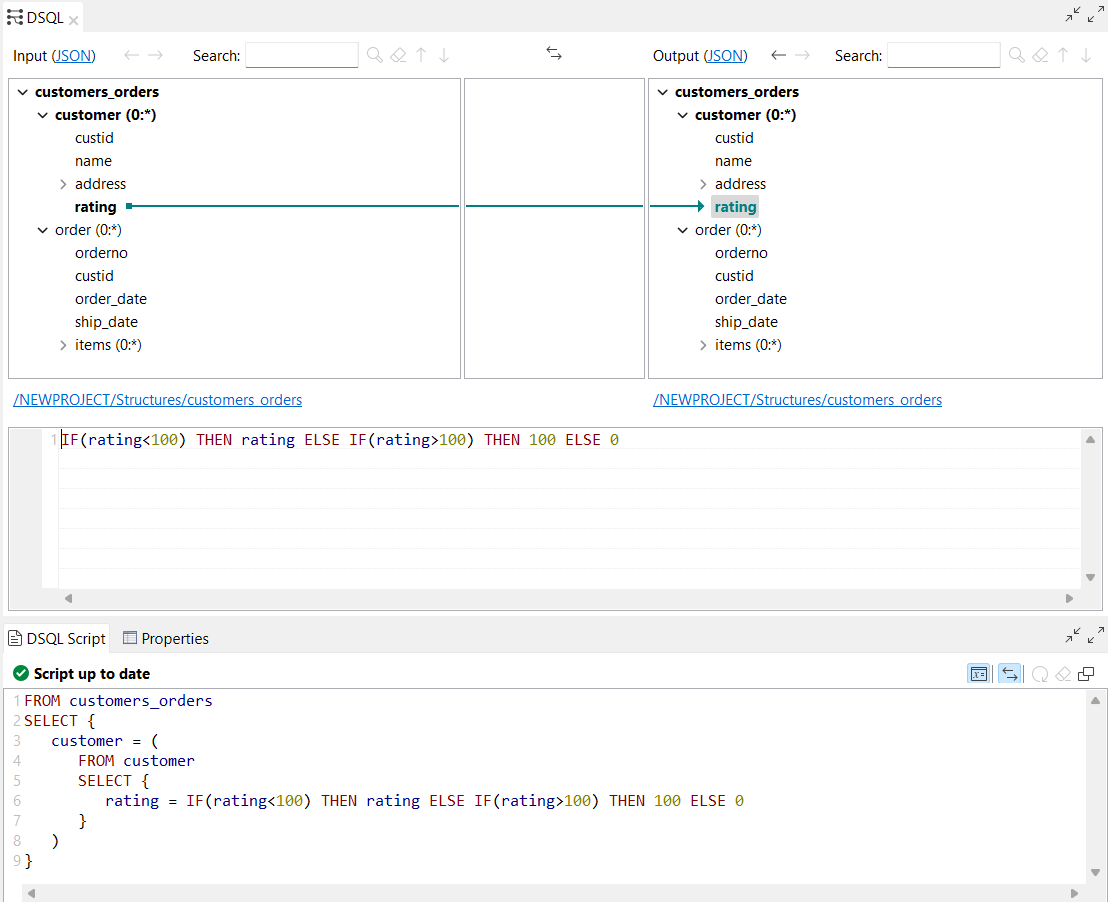

| DSQLマップの条件式でELSE IFキーワードとTHENキーワードをサポート | Talend Studioが、DSQLマップの条件式でELSE IFキーワードとTHENキーワードをサポートするようになりました。 |

| DSQLマップエディターでテスト実行を開いて実行できる新しいショートカット | 新しいキーボード ショートカットであるCtrl + Tによって、DSQLマップ エディターでテスト実行を開いて実行できるようになりました。 |

| Cobol Reader選択項目解決戦略のアップデート | Cobol Reader選択項目解決戦略は、ストラクチャーに複数の代替項目が含まれている場合は実行時にアップデートされます。フォールバック戦略は次のように動作するようになりました:

[Cobol Properties] (Cobolのプロパティ)ダイアログボックスに、[Apply default Choice resolution strategy to all alternatives] (すべての代替項目にデフォルトの選択項目解決戦略を適用)という新しいオプションが追加されました。これによってデフォルトの選択項目解決戦略を適用できるようになるため、isPresent式を使って代替項目を選択できなかった場合に、フォールバック戦略が常にすべての代替項目に適用されます。 ![[Cobol Properties] (Cobolのプロパティ)ダイアログボックス。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/tdm-cobol-properties.png) |

| DSQLマップの式としてNULLリテラルをサポート | Talend Studioが、DSQLマップ式のリテラルとしてNULLキーワードをサポートするようになりました。 |

| DSQLマップからストラクチャーを削除できる新しいオプション | DSQLマップでストラクチャーのルートエレメントを右クリックした時に、[Remove structure] (ストラクチャーを削除)が利用できるようになりました。これによって、入力ストラクチャーや出力ストラクチャーを削除できます。![DSQLマップでストラクチャーを右クリックし、[Remove structure] (ストラクチャーを削除)パラメーターが強調表示されている状態。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/dsql-map-remove-structure.png) |

データクオリティ

| 機能 | 説明 |

|---|---|

| リポジトリーでSnowflakeをデータベース接続としてサポート | Profilingパースペクティブとプロファイルカラム分析で、Snowflake接続を作成できるようになりました。 |

![[Repository] (リポジトリー)検索フィールド。](/talend/ja-JP/release-notes/8.0/Content/Resources/images/Filter_Repository6.png)