Neue Funktionen

Anwendungsintegration

| Funktion | Beschreibung |

|---|---|

| Neue cAzureEventHubs- und cAzureConnection-Komponenten in Routen | Die neuen cAzureEventHubs- und cAzureConnection-Komponenten sind jetzt in Routen verfügbar. Damit können Sie Nachrichten an Azure Event Hubs senden oder von diesen empfangen. |

| Neue cReplicateEnvelope-Komponente in Routen (Beta) | Die neue cReplicateEnvelope-Komponente ist jetzt in der Beta-Version in Routen verfügbar. Damit können Sie von Qlik Replicate erstellte Nachrichten decodieren. |

Big Data

| Funktion | Beschreibung |

|---|---|

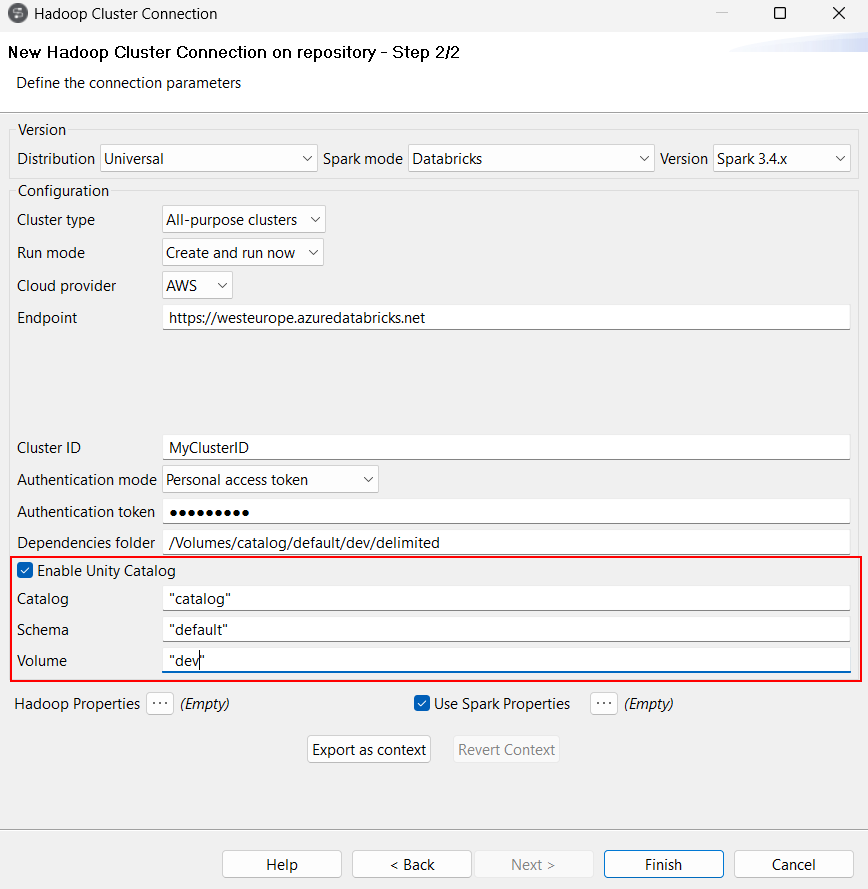

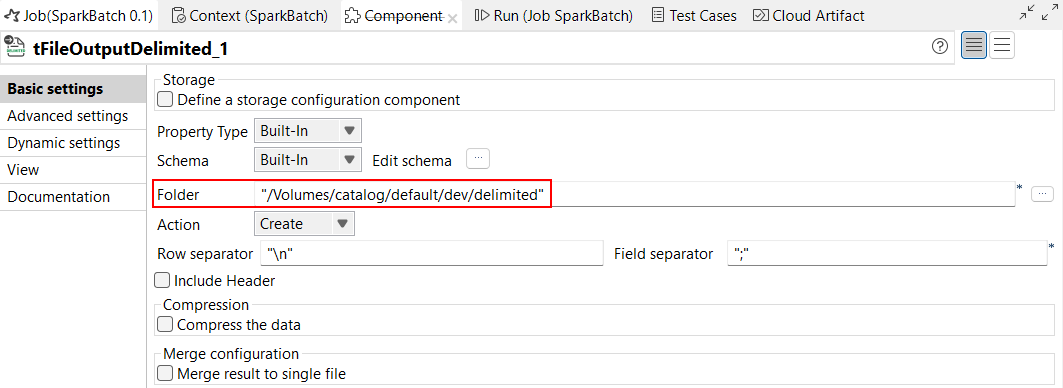

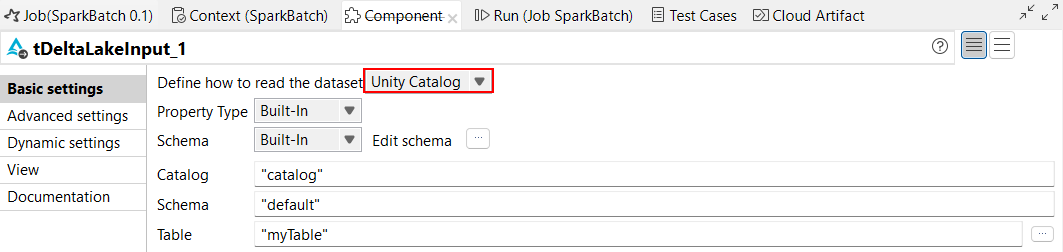

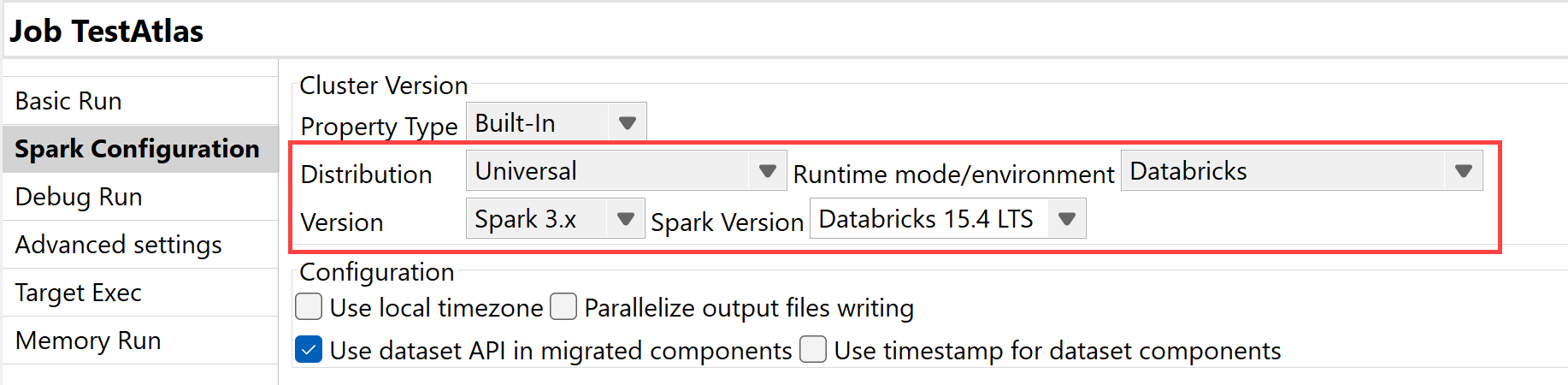

| Unterstützung für Unity Catalog | Unity Catalog wird jetzt in Spark-Batch-Aufträgen unterstützt, wenn Sie Spark Universal 3.4.x mit Databricks 13.3 LTS und Spark Universal 3.x mit Databricks 15.4 LTS verwenden. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Batch-Aufträge oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung).  Sie können Unity Catalog auch in Verarbeitungs- und Extrahierungskomponenten konfigurieren, aber auch in allen Eingabe- und Ausgabekomponenten, die in Spark-Batch-Aufträgen verfügbar sind, indem Sie den vollständigen Pfad zu Unity Catalog im Parameter Folder (Ordner) mit Katalog-, Schema- und Volume-Namen angeben. Beachten Sie, dass nur die Komponenten, die die Dataset (DS) API verwenden, für Unity Catalog unterstützt werden. Mit der Betaversion dieser Funktion wird keine Unterstützung für Hive-Komponenten geboten.  Für tDeltaLakeInput- und tDeltaLakeOutput-Komponenten können Sie Unity Catalog für die Arbeit mit verwalteten Tabellen verwenden.

|

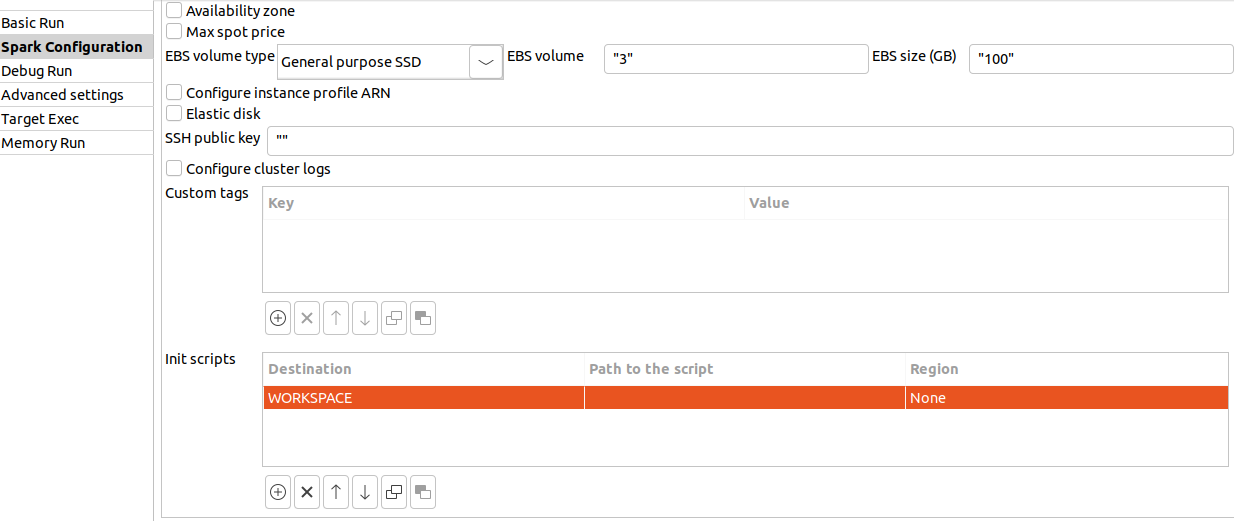

| Unterstützung für den Workspace-Speicherort für Databricks |

Für Databricks wird die DBFS-Option für den Skriptspeicherort nicht mehr unterstützt. Sie wird durch Workspace ersetzt.

Ab Databricks 15.4 LTS wird DBFS nicht mehr zum Speichern von Anwendungsbibliotheken unterstützt. Der Ordnerparameter Dependencies (Abhängigkeiten) verwendet stattdessen den Pfad zu Workspace als Standard-Bibliotheksspeicherort. |

| Unterstützung für Databricks 15.4 LTS mit Spark Universal 3.x |

Sie können Ihre Spark Batch- und Streaming-Jobs jetzt in jobbasierten wie auch in multifunktionalen Databricks-Clustern in Google Cloud Platform (GCP), AWS und Azure unter Rückgriff auf Spark Universal mit Spark 3.x ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, ist Talend Studio mit Databricks 15.4 LTS kompatibel.  |

Datenintegration

| Funktion | Beschreibung |

|---|---|

|

Unterstützung für die Vektorsuchfunktionen für Delta Lake-Komponenten in Standard-Jobs |

Die Delta Lake-Komponenten können jetzt die Databricks-Vektorsuchfunktionen verwenden. |

|

Die tOllamaClient-Komponente wird jetzt als Eingabekomponente in Standard-Jobs unterstützt |

Die tOllamaClient-Komponente kann jetzt als Startkomponente in einem Job verwendet werden. |

|

Verbesserungen in tHTTPClient-Optionen zum Herunterladen und Speichern von Ressourcen in Standard-Jobs |

Die Optionen Use custom attachment name (Benutzerdefinierten Anhangnamen verwenden) und Use cache to save resource (Cache zum Speichern der Ressource verwenden) wurden zur tHTTPClient-Komponente hinzugefügt und ermöglichen es Ihnen, den Dateinamen des Anhangs zu definieren und die Daten im Cache zu speichern, um die Leistung zu verbessern. |

Data Mapper

| Funktion | Beschreibung |

|---|---|

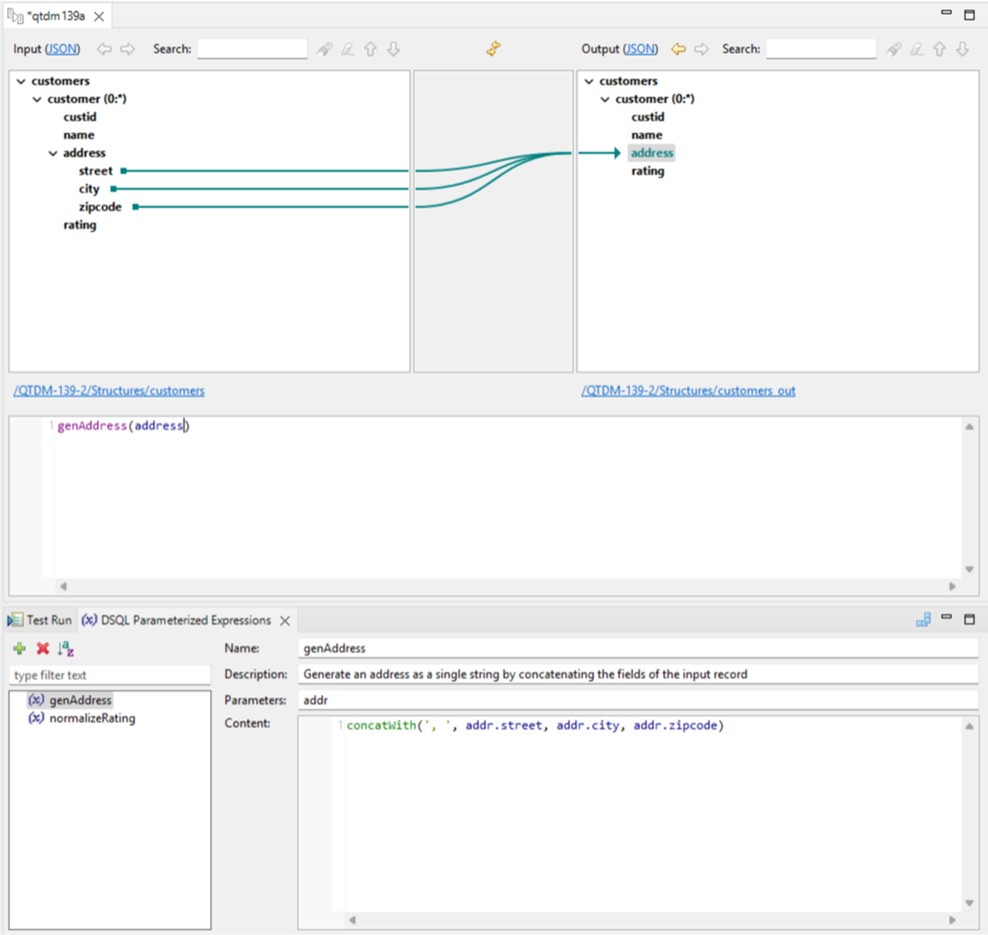

| Unterstützung für parametrisierte Ausdrücke in DSQL Map Editor (DSEL) | Talend Studio unterstützt jetzt parametrisierte Ausdrücke in DSQL Map Editor. Damit können Sie flexible und anpassbare Ausdrücke erstellen. |

| Unterstützung für den Export von DSQL-Maps als CSV | Sie können jetzt eine DSQL-Map mit der Option Maps as CSV (Maps als CSV) als CSV-Datei exportieren. Die exportierte Datei ist auch mit Excel kompatibel. Weitere Informationen finden Sie unter Exporting a map.  |

| Unterstützung für Avro-Schema (Confluent-Registrierung) mit Strukturimport | Sie können jetzt eine Struktur aus einem Avro-Schema erstellen, das in einer Confluent-Schemaregistrierung gespeichert ist. Weitere Informationen finden Sie unter Arbeiten mit Avro-Schema (Confluent-Registrierung).  |

| Unterstützung für DSQL-Maps zur Abflachung | Talend Studio unterstützt jetzt DSQL-Maps zur Abflachung. Diese Funktion ersetzt die vorherige Unterstützung für Standard-Maps zur Abflachung. Weitere Informationen zu DSQL-Maps zur Abflachung finden Sie unter Erstellen einer Map zur Abflachung.  |

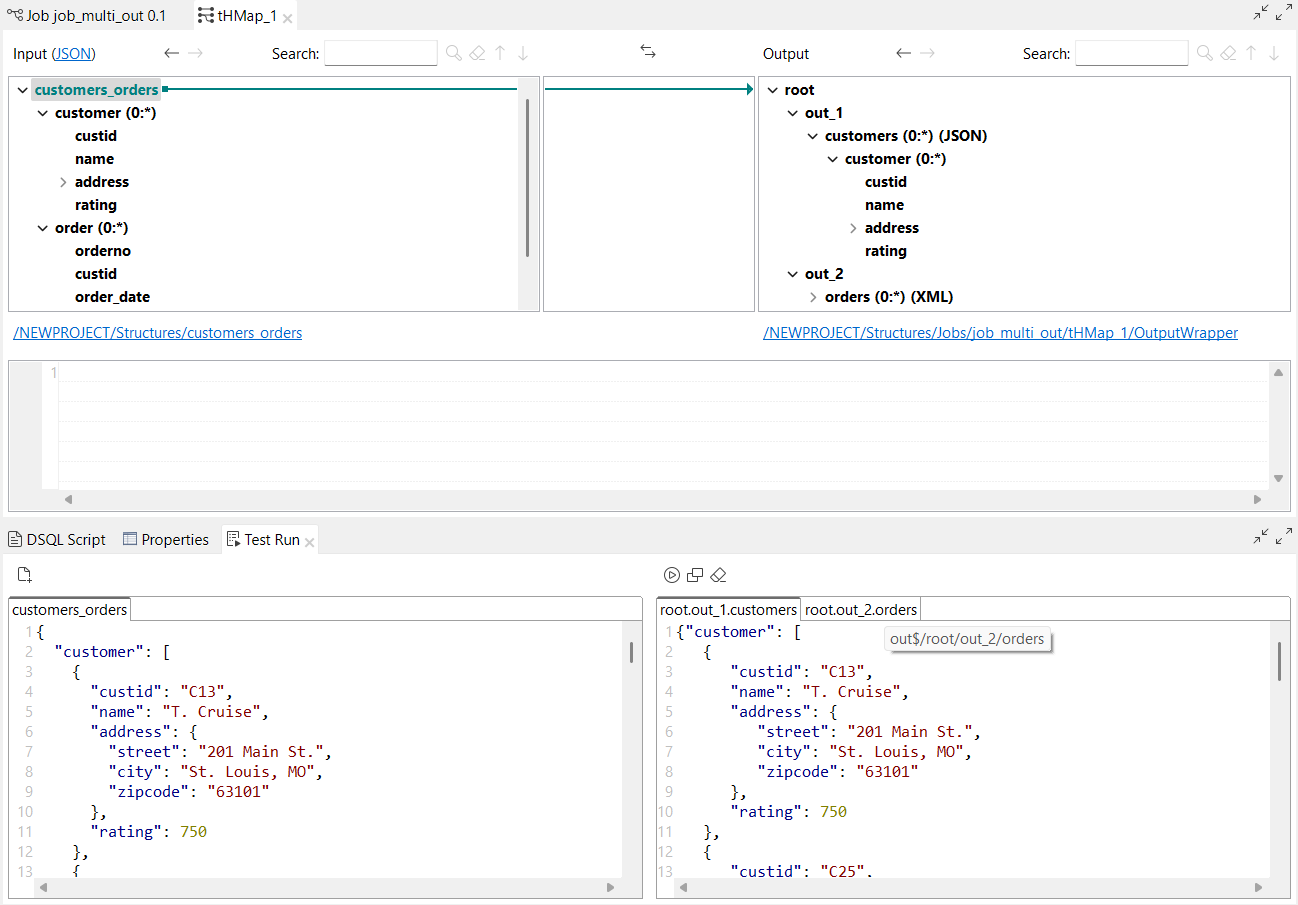

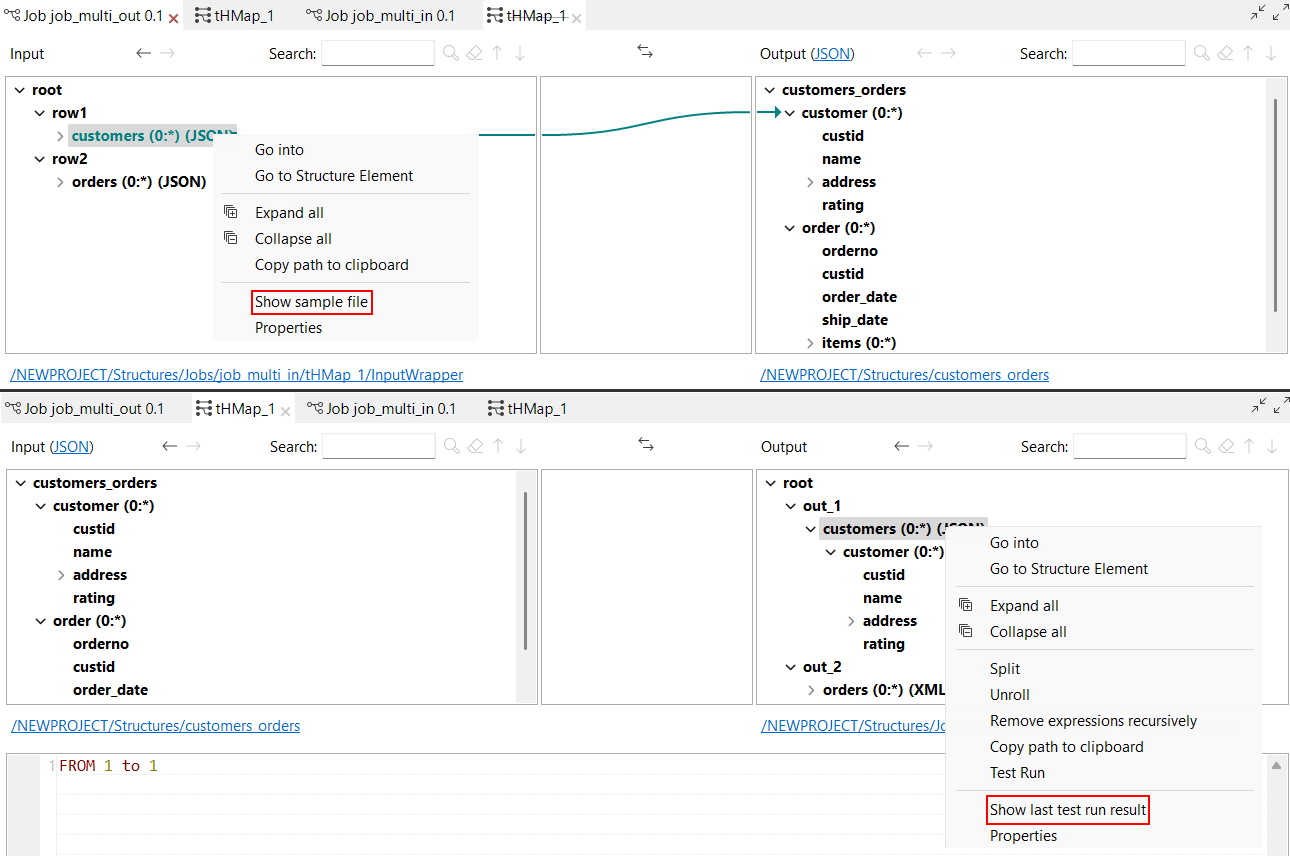

| Unterstützung für mehrere Eingaben und Ausgaben in der Ansicht Test Run (Testausführung) in DSQL-Maps. | Die Funktion Test Run (Testausführung) kann jetzt in DSQL-Maps mit mehreren Eingaben und Ausgaben verwendet werden. In der Ansicht Test Run (Testausführung):

Mit dieser Funktion sind zwei neue Optionen verfügbar, wenn Sie mit der rechten Maustaste auf die Struktur klicken:

|

| Neue Array-Funktionen in DSQL-Maps | Die folgenden Array-Funktionen sind jetzt in DSQL-Maps verfügbar:

|

| Neue Funktionen getValueFromExternalMap und putValueToExternalMap in DSQL-Maps | Die folgenden Funktionen sind jetzt in DSQL-Maps verfügbar:

|

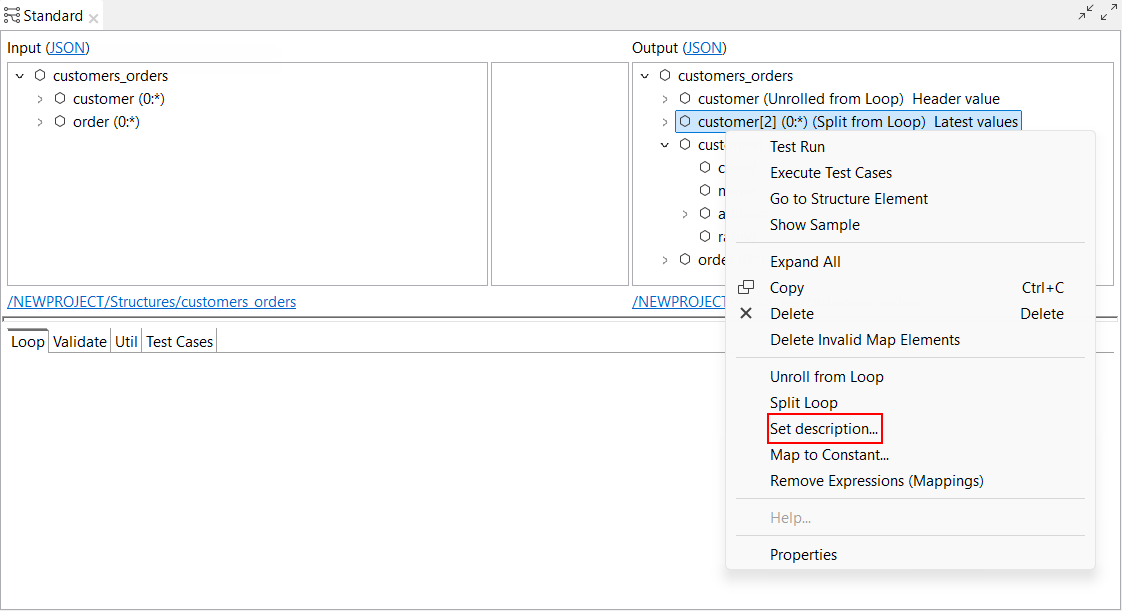

| Neue Option zum Festlegen einer Beschreibung für aufgeteilte und ausgerollte Schleifen in Standard-Maps | Der Parameter Set description... (Beschreibung festlegen) ist jetzt für aufgeteilte und ausgerollte Elemente in einer Standard-Map verfügbar. Damit kann eine Beschreibung für diese Elemente festgelegt werden, die vom Basisschleifen-Map-Element abweichen kann.  |

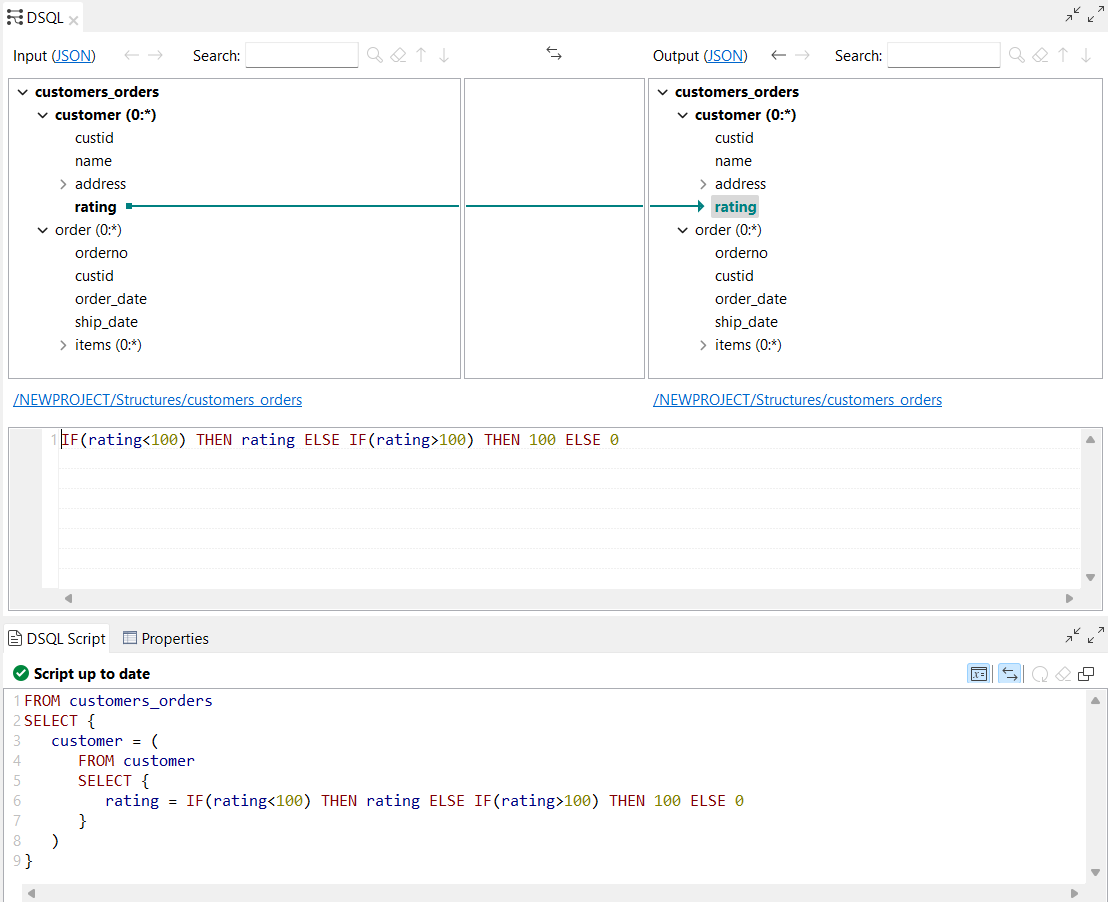

| Unterstützung für die Schlüsselwörter ELSE IF und THEN in bedingten Ausdrücken in DSQL-Maps | Talend Studio unterstützt jetzt die Schlüsselwörter ELSE IF und THEN in bedingten Ausdrücken in DSQL-Maps. |

| Neues Tastaturkürzel zum Öffnen und Ausführen von Testausführungen im DSQL Map Editor | Ein neues Tastaturkürzel Strg + T ist jetzt verfügbar, um Testausführungen in DSQL Map Editor zu öffnen und auszuführen. |

| Aktualisierung der Lösungsstrategie für die COBOL-Reader-Auswahl | Die Lösungsstrategie für die COBOL-Reader-Auswahl wird zur Laufzeit aktualisiert, wenn Ihre Struktur eine Auswahl zwischen mehreren Alternativen umfasst. Die Fallback-Strategie funktioniert jetzt wie folgt:

Im Dialogfeld Cobol Properties (COBOL-Eigenschaften) ist die neue Option Apply default Choice resolution strategy to all alternatives (Standard-Auswahllösungsstrategie auf alle Alternativen anwenden) verfügbar. Damit können Sie die Standard-Auswahllösungsstrategie anwenden, was bedeutet, dass die Fallback-Strategie immer auf alle Alternativen angewendet wird, wenn keine Alternative über einen isPresent-Ausdruck ausgewählt werden konnte.  |

| Unterstützung des Literals NULL als Ausdruck in DSQL-Maps | Talend Studio unterstützt jetzt das Schlüsselwort NULL als Literal in DSQL-Map-Ausdrücken. |

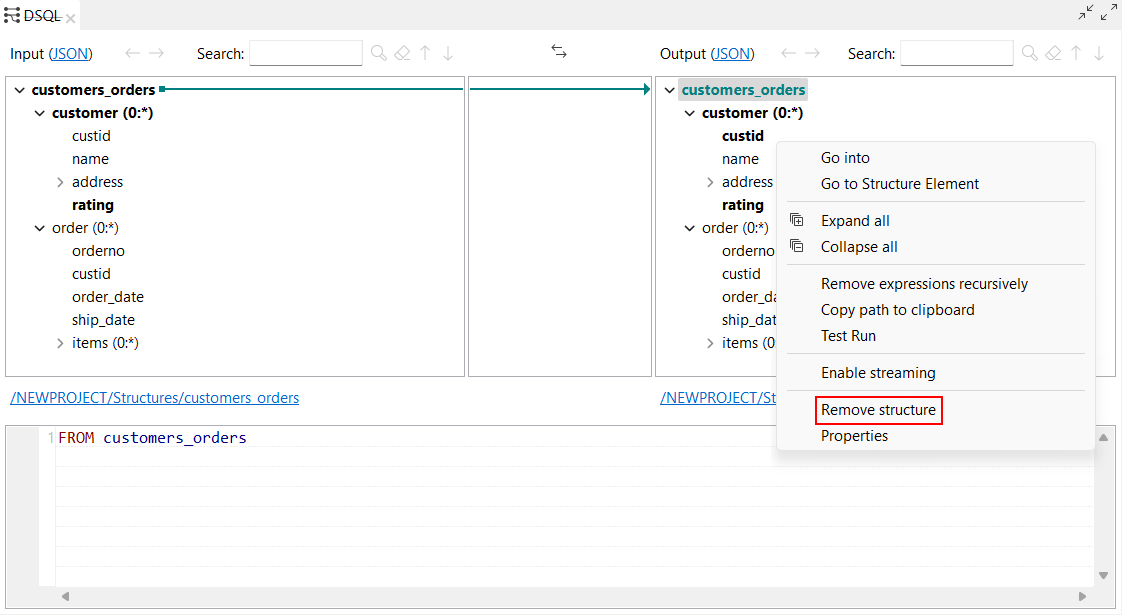

| Neue Option zum Entfernen einer Struktur aus einer DSQL-Map | Remove structure (Struktur entfernen) ist jetzt verfügbar, wenn Sie mit der rechten Maustaste auf das Root-Element einer Struktur in einer DSQL-Map klicken. Damit können Sie die Eingabe- oder Ausgabestruktur entfernen. |

Datenqualität

| Funktion | Beschreibung |

|---|---|

| Unterstützung für Snowflake als Datenbankverbindung im Repository | Sie können jetzt eine Snowflake-Verbindung in den Perspektiven- und Profilspaltenanalysen in Profiling erstellen. |