Configurer les composants HDFS pour utiliser Azure Data Lake Storage

Procédure

-

Double-cliquez sur le tFixedFlowInput pour ouvrir sa vue Component et fournir des données d'exemple dans le Job.

Les données d'exemple à utiliser contiennent une seule ligne comprenant deux colonnes : id et name.

- Cliquez sur le bouton [...] à côté du champ Edit schema pour ouvrir l'éditeur du schéma.

- Cliquez sur le bouton [+] pour ajouter les deux colonnes et renommez-les id et name.

- Cliquez sur OK pour fermer l'éditeur de schéma et valider le schéma.

-

Dans la zone Mode, sélectionnez Use single table.

Les colonnes id et name s'affichent automatiquement dans la table Value et vous pouvez saisir les valeurs que vous souhaitez, entre guillemets doubles, dans la colonne Value pour les deux valeurs de schéma.

-

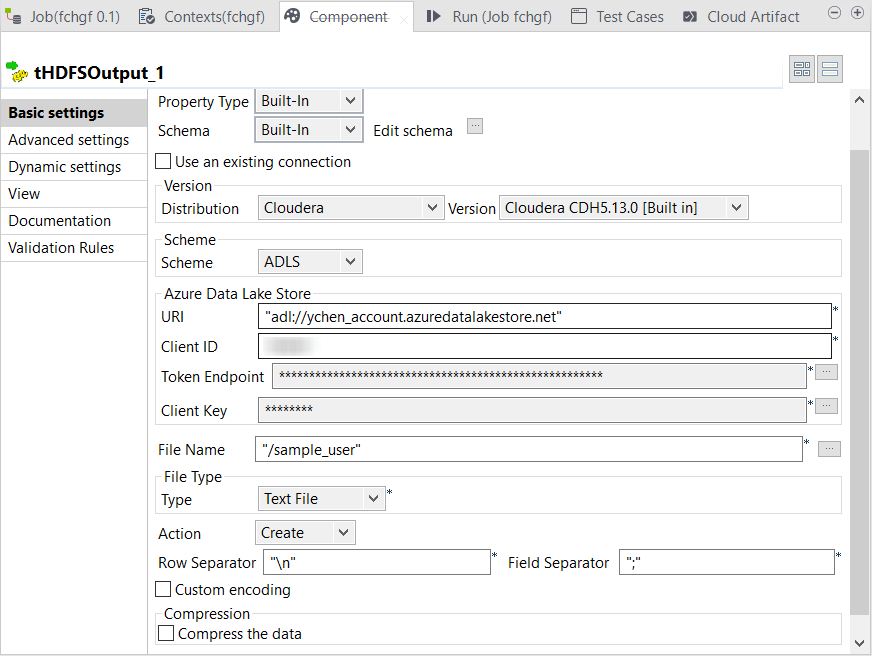

Double-cliquez sur le tHDFSOutput afin d'ouvrir sa vue Component.

Exemple

- Dans la zone Version, sélectionnez Hortonworks ou Cloudera, selon la distribution que vous utilisez. Dans le framework Standard, seules ces deux distributions avec ADLS sont supportées par les composants HDFS.

- Dans la liste déroulante Scheme, sélectionnez ADLS. Les paramètres relatifs à ADLS s'affichent dans la vue Component.

-

Dans le champ URI, saisissez le service du NameNode de votre application. Ce service se trouve à l'adresse de votre Data Lake Storage.

Par exemple, si votre Data Lake Storage se nomme data_lake_store_name, l'URI du NameNode à utiliser est adl://data_lake_store_name.azuredatalakestore.net.

-

Dans les champs Client ID et Client key, saisissez respectivement l'ID et la clé d'authentification générés après enregistrement de l'application que le Job que vous développez utilise pour accéder à Azure Data Lake Storage.

Assurez-vous que l'application à utiliser a les droits d'accès à Azure Data Lake. Vous pouvez vérifier dans la vue Required permissions de cette application, dans Azure. Pour plus d'informations, consultez la documentation Azure Affecter l’application Azure AD au dossier ou fichier de compte Azure Data Lake Storage (uniquement en anglais).

Cette application doit être celle à laquelle vous avez assigné des autorisations d'accès à Azure Data Lake Storage dans l'étape précédente.

- Dans le champ Token endpoint, copiez-collez l'endpoint du jeton OAuth 2.0 que vous pouvez obtenir à partir de la liste Endpoints dans la page App registrations de votre portail Azure.

- Dans le champ File name, saisissez le chemin d'accès au répertoire à utiliser pour stocker les données d'exemple dans le Azure Data Lake Storage.

- Dans la liste déroulante Action, sélectionnez Create si le répertoire à utiliser n'existe pas dans le Azure Data Lake Storage. Si ce dossier existe déjà, sélectionnez Overwrite.

- Configurez de la même manière le tHDFSInput.

- Si vous exécutez votre Job sous Windows, suivez cette procédure (en anglais) pour ajouter le programme winutils.exe à votre Job.

- Appuyez sur F6 pour exécuter le Job.

Cette page vous a-t-elle aidé ?

Si vous rencontrez des problèmes sur cette page ou dans son contenu – une faute de frappe, une étape manquante ou une erreur technique – faites-le-nous savoir.