Utiliser des variables de contexte avec Cloudera

Dans ce scénario, vous devez choisir où exécuter vos Jobs Spark parmi les Runtimes Cloudera on-premises 7.1.7 avec Spark 3.2.x et 7.1.9 avec Spark 3.3.x.

Vous pouvez également choisir un mélange de distributions Cloudera on-premises (7.1.x) et Cloud (7.2.x).

Cette fonctionnalité est activée avec la fonctionnalité de variables de contexte du Studio Talend et avec le mode de distribution de Qlik Spark Universal 3.3.x (le plus récent des distributions Cloudera).

Avant de commencer

- Consultez la documentation Cloudera (uniquement en anglais) (en anglais) pour voir si vos distributions cibles sont compatibles avec Spark 2, Spark 3 ou avec les deux à la fois.

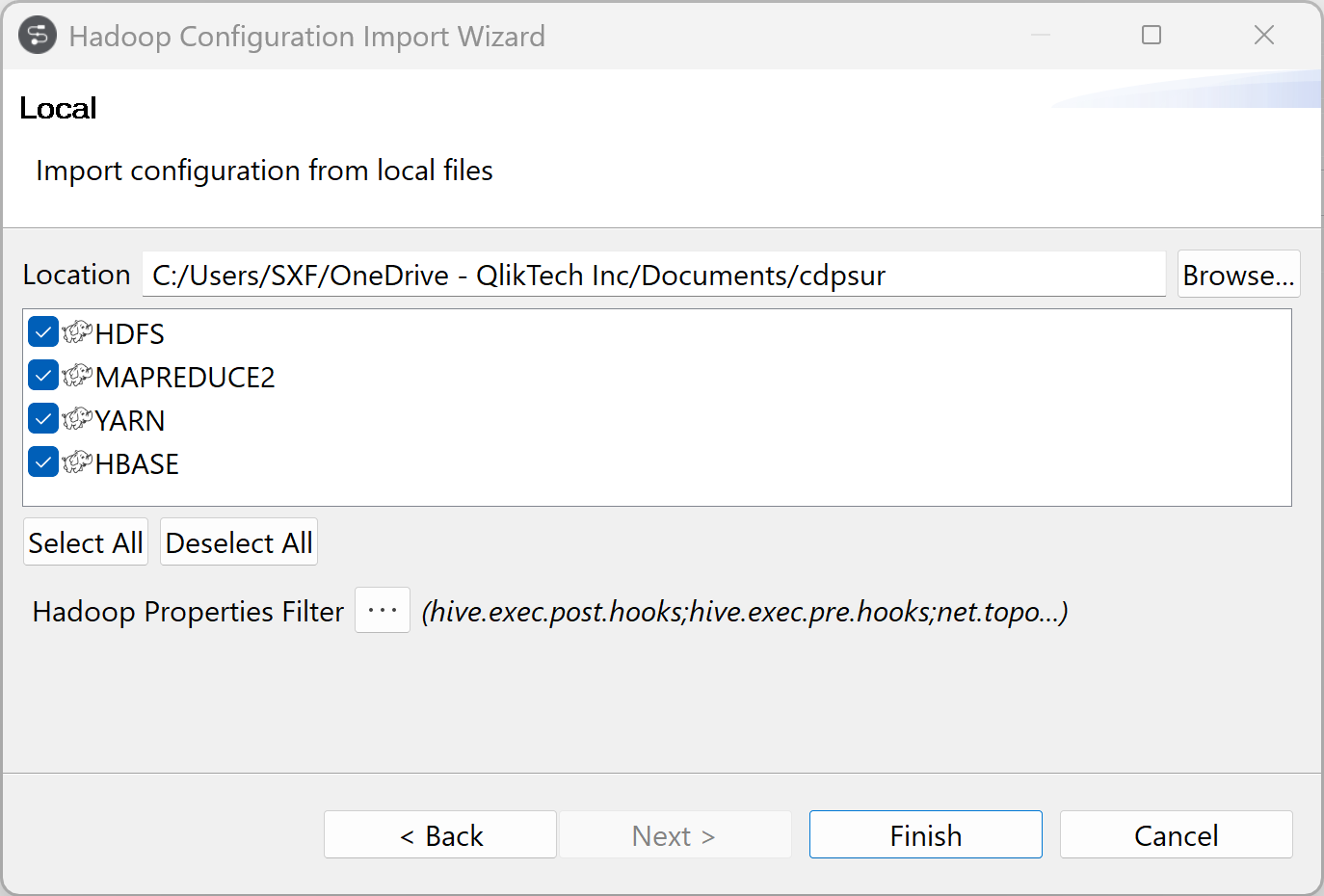

- Depuis Cloudera Manager, téléchargez la configuration du client pour chaque service Hadoop utilisé (HDFS, Hive, HBase...). Pour plus d'informations, consultez Downloading Client Configuration Files (uniquement en anglais) (en anglais), dans la documentation Cloudera.

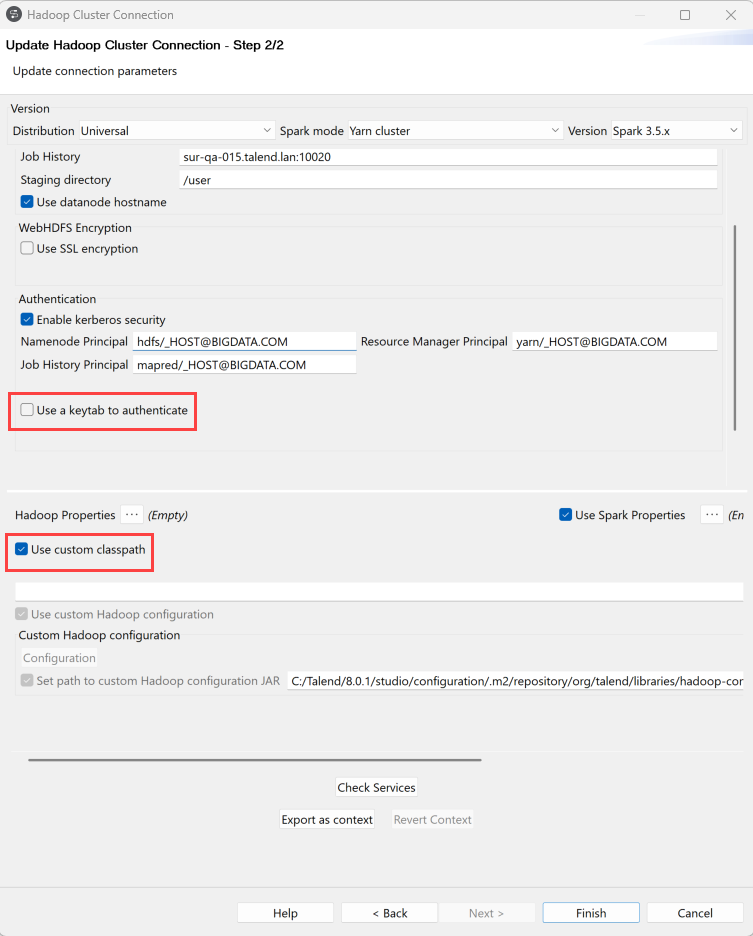

Créer une métadonnée de connexion à un cluster Hadoop

Procédure

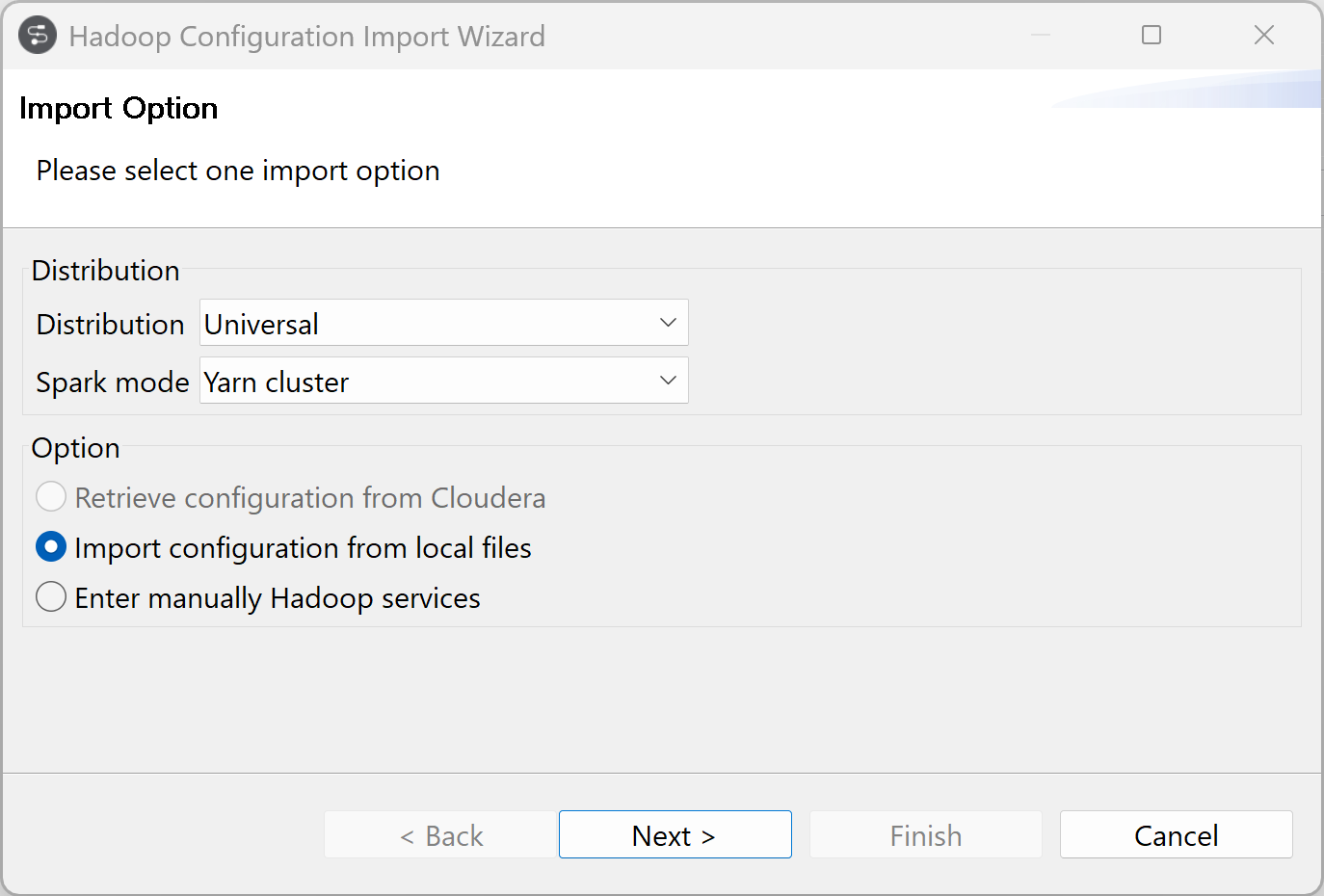

Importer une configuration Hadoop

Procédure

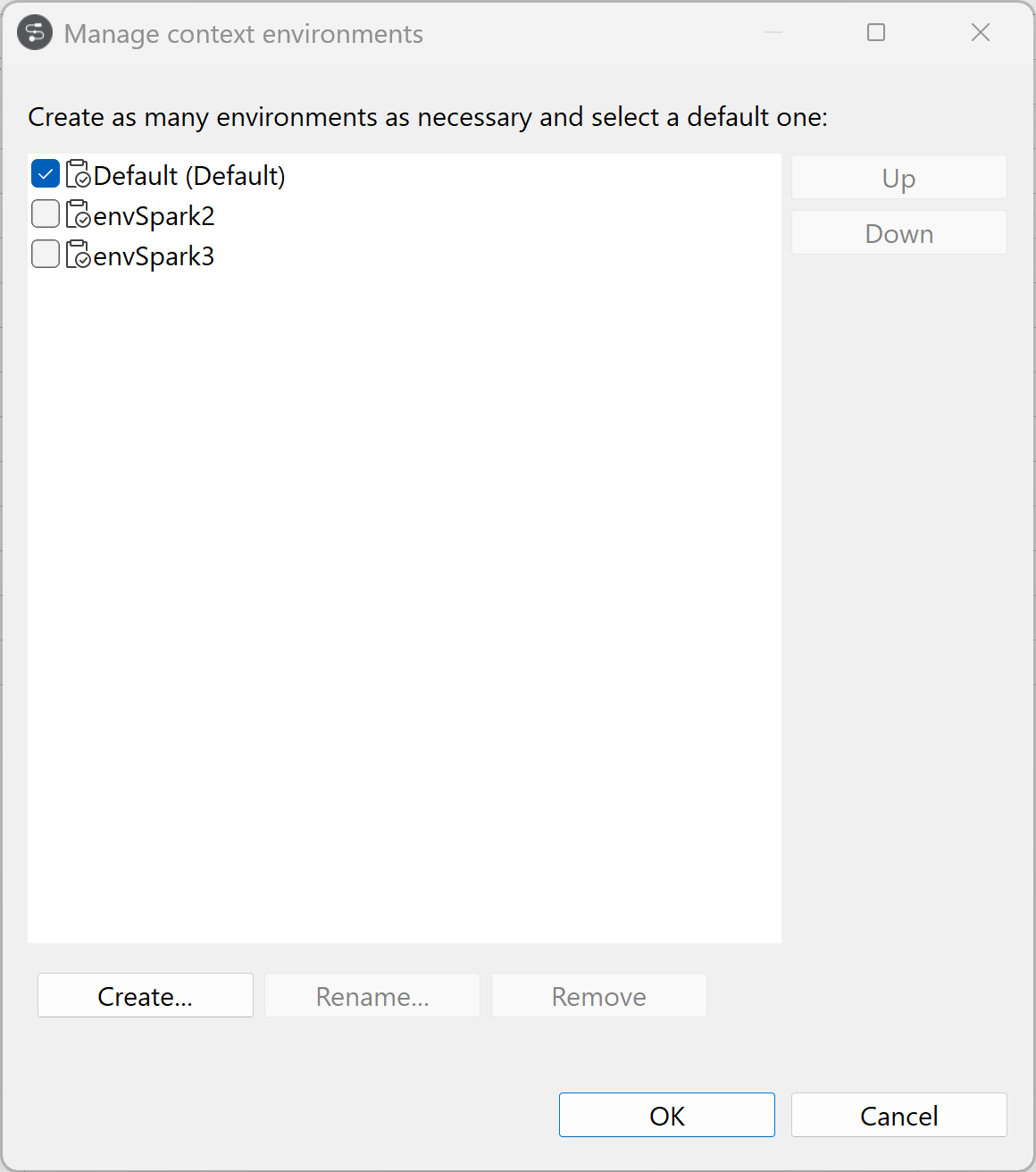

Contextualiser la métadonnée de connexion

Vous pouvez utiliser un seul cluster avec différents paramètres, grâce aux valeurs de contexte.