Nouvelles fonctionnalités

Intégration d'application

| Fonctionnalité | Description |

|---|---|

| cAWSConnection : support des paramètres de contexte dans la configuration des régions AWS | Vous pouvez à présent utiliser les paramètres de contexte afin de spécifier la région AWS dans le composant cAWSConnection. |

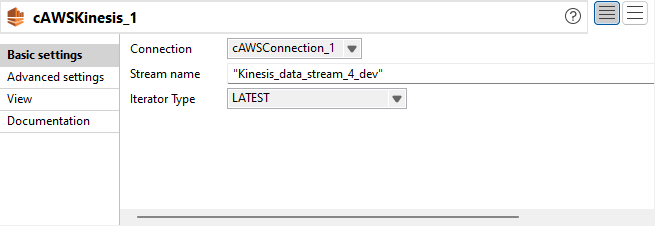

| Nouveau composant cAWSKinesis dans les Routes | Le composant cAWSKinesis est à présent disponible dans les Routes afin de consommer des messages depuis et de produire des messages vers un service Amazon Kinesis. |

Big Data

| Fonctionnalité | Description |

|---|---|

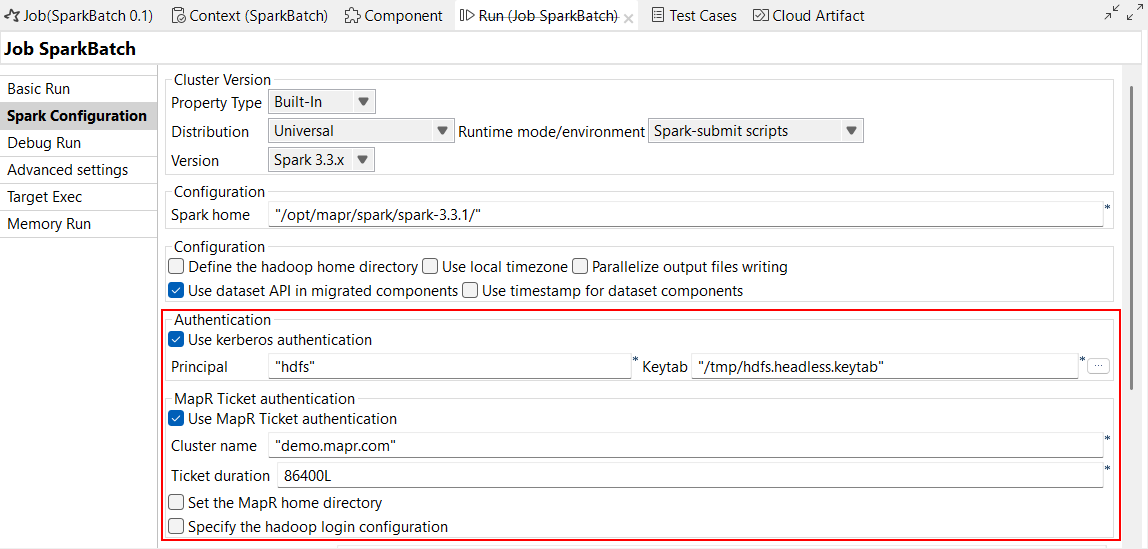

| Nouveaux composants MapRDB pour HPE Data Fabric 7.7 dans les Jobs Spark Batch | Les composants MapRDB suivants sont à présent disponibles dans les Jobs Spark Batch lorsque vous utilisez un cluster HPE Data Fabric 7.7 avec Spark Universal 3.3.x en mode Spark-submit scripts (Scripts Spark-submit) :

Via cette fonctionnalité, le Studio Talend supporte également l'authentification via Kerberos et les Tickets MapR. Vous pouvez la configurer dans la vue Spark Configuration (Configuration de Spark) de vos Jobs Spark Batch ou dans l'assistant de métadonnées Hadoop Cluster Connection (Connexion au cluster Hadoop).

|

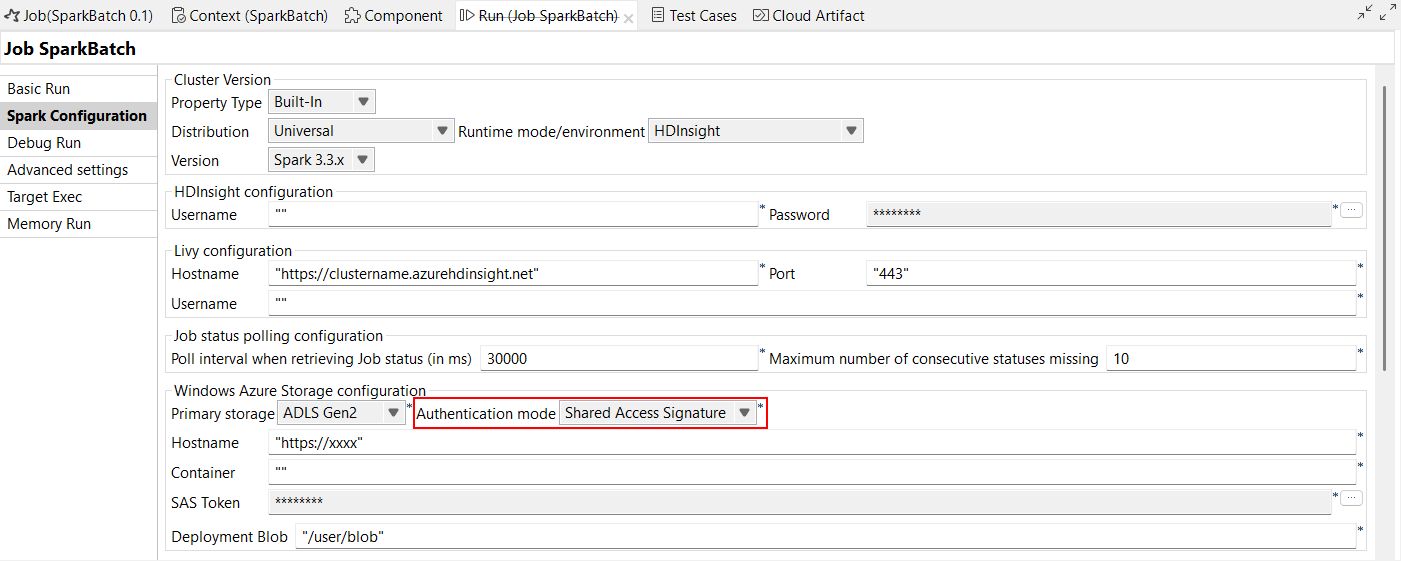

| Support de l'authentification par signature d'accès partagé dans les Jobs Spark utilisant HDInsight 5.0 et 5.1 | Le Studio Talend supporte l'authentification par signature d'accès partagé (SAS) dans les Jobs Spark Batch et Spark Streaming utilisant HDInsight 5.0 et 5.1. Cette authentification est disponible avec Azure Blob Storage et ADLS Gen2. Vous pouvez la configurer dans la vue Spark Configuration (Configuration de Spark) de vos Jobs Spark ou dans l'assistant de métadonnées Hadoop Cluster Connection (Connexion au cluster Hadoop).  |

| Support de Hive 3 dans l'assistant de métadonnées | Vous pouvez à présent configurer votre connexion à Hive 3 dans l'assistant de métadonnées Db Connections (Connexions à la base de données). Avec cette fonctionnalité, le nom de la propriété passe de Hive server à Hive version.  |

Intégration continue

| Fonctionnalité | Description |

|---|---|

| Le Builder Talend d'intégration continue a été mis à niveau en version 8.0.20 | Le Builder Talend d'intégration continue a été mis à niveau, passant de la version 8.0.19 à la version 8.0.20. Utilisez le Builder Talend d'intégration continue 8.0.20 dans vos commandes d'intégration continue ou dans vos scripts de pipelines, à partir de cette version mensuelle et jusqu'à la sortie d'une nouvelle version du Builder Talend d'intégration continue. |

Intégration de données

| Fonctionnalité | Description |

|---|---|

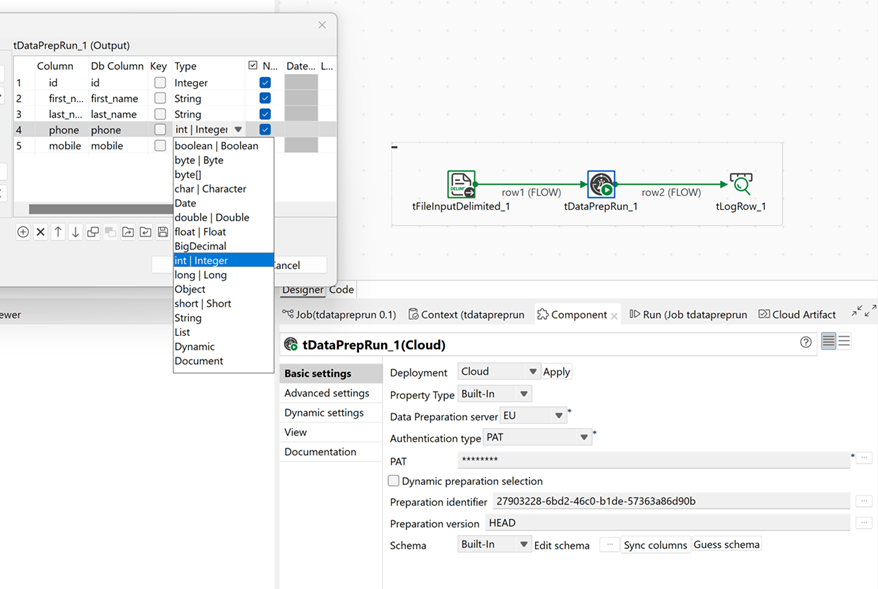

| Le composant tDataprepRun pour déploiement dans le Cloud est à présent généralement disponible. | Vous pouvez sélectionner Cloud dans le nouveau champ Deployment (Déploiement) du composant tDataprepRun pour bénéficier des options de configuration dédiées, si vous avez besoin d'utiliser des préparations de Talend Cloud Data Preparation dans vos Jobs. Le déploiement dans le Cloud permet d'exécuter vos préparations sur le même moteur que votre Job, afin que vos données ne quittent pas votre infrastructure. Les paramètres d'authentification utilisent à présent les jetons d'authentification personnels. La récupération des dépendances des préparations, comme les jeux de données de lookup et les types sémantiques a également été simplifiée. De plus, le composant supporte à présent les autres types de données, en plus du type string.  |

| Nouveau composant tQlikOutput permettant de charger des fichiers dans Qlik Cloud dans les Jobs Standards | Le nouveau composant tQlikOutput est à présent disponible dans les Jobs Standards et vous permet de créer, mettre à jour ou supprimer des fichiers de données dans Qlik Cloud. |

| Nouveau composant tChunking dans les Jobs Standards (bêta) | Le nouveau composant tChunking est à présent disponible dans les Jobs Standards et vous permet de scinder des textes volumineux en morceaux plus petits et plus gérables. |

| Support des composants Oracle de bases de données vectorielles avec la base de données 23ai dans les Jobs Standards | Avec l'ajout de la version 23ai, les composants Oracle supportent à présent les fonctionnalités vectorielles. |

| Support des chargements par morceaux (chunks) dans le tHTTPClient, dans les Jobs Standards | L'option Binary (Binaire) a été ajoutée au paramètre Body type (Type de corps) afin de permettre aux utilisateur·trices de charger de gros fichiers de données par morceaux. |

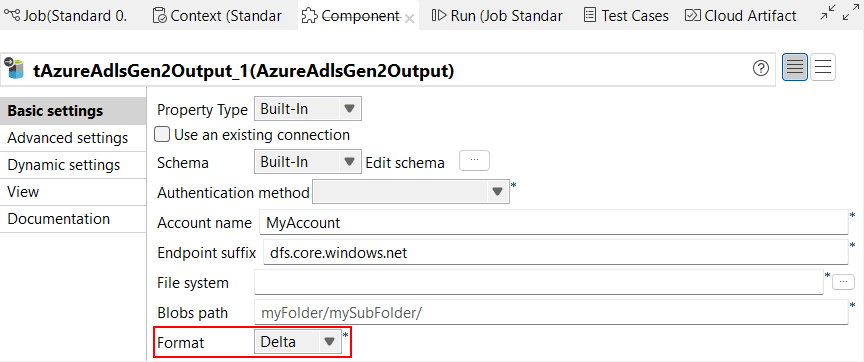

| Support du format Delta pour le tAzureADLSGen2Output dans les Jobs Standards | Le format Delta est à présent supporté dans le composant tAzureADLSGen2Output, vous permettant d'écrire des données dans une table Delta. |

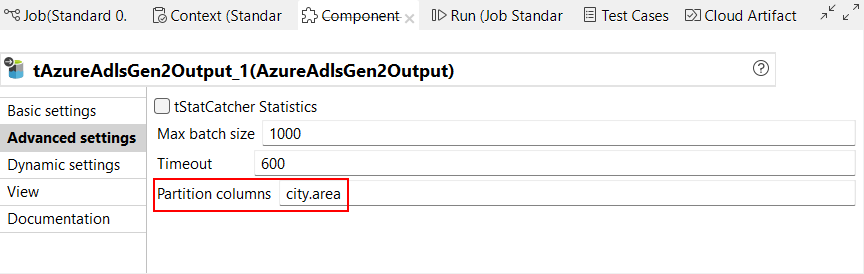

| Support du partitionnement pour le tAzureADLSGen2Output dans les Jobs Standards | La nouvelle option Partition columns (Colonnes de partition) est à présent disponible dans le composant tAzureADLSGen2Output afin de permettre aux utilisateur·trices de regrouper des données similaires en se basant sur des colonnes spécifiques. |

Data Mapper

| Fonctionnalité | Description |

|---|---|

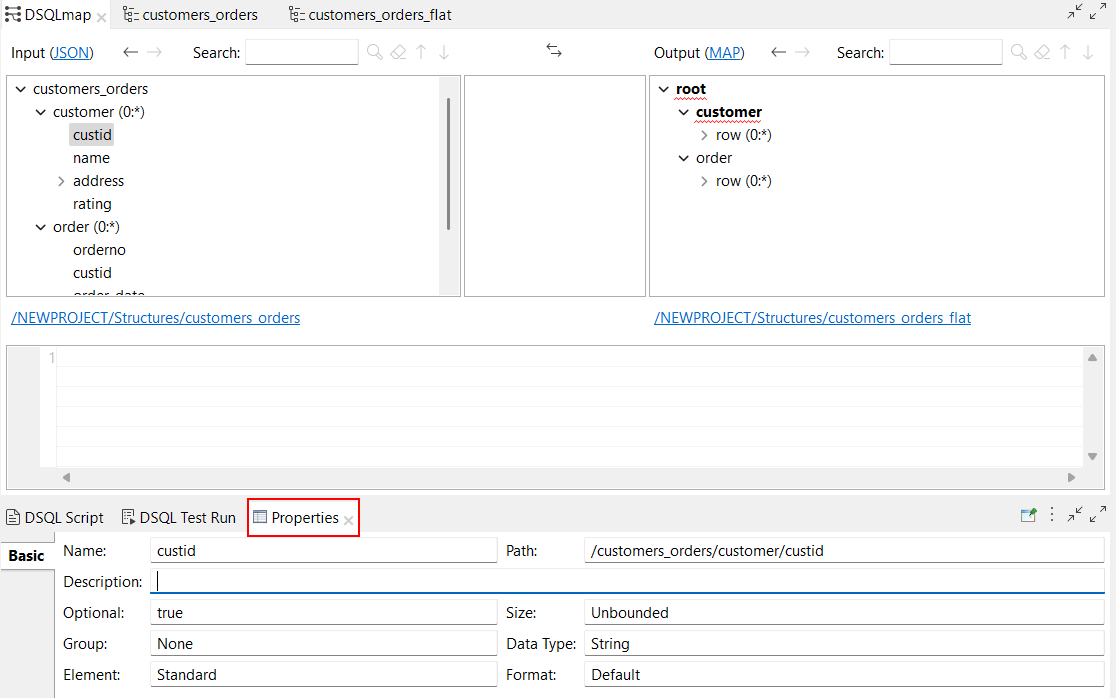

| Possibilité d'afficher les propriétés des éléments dans les maps DSQL | Une nouvelle vue Properties (Propriétés) est à présent disponible pour vos maps DSQL. Dans cet onglet, vous pouvez voir toutes les propriétés associées à un élément sélectionné dans la map. Vous pouvez trouver la vue Properties (Propriétés) en :

|