Przeprowadzanie szybkiej analizy modelu

Gdy modele ukończą szkolenie do wersji eksperymentalnej, przeprowadź analizę najważniejszych wskaźników modeli i przejdź do podsumowania sposobu przetwarzania danych szkoleniowych. Szybkiej analizy dokonuje się na kartach Dane i Modele.

Użyj karty Modele, aby zobaczyć przegląd wyników uczenia. Po uruchomieniu wersji eksperymentalnej następuje automatyczne przełączenie na kartę Modele. Zaleca się również sprawdzenie na karcie Dane, jak dane zostały wstępnie przetworzone i jak z nimi postąpiono.

Karta Modele dla eksperymentu klasyfikacji binarnej

Dostępne są dodatkowe opcje umożliwiające dalszą ocenę modeli. Można porównywać dodatkowe wskaźniki i hiperparametry między modelami lub skupić się na konkretnym modelu w celu przeprowadzenia szczegółowej analizy. Opcje te są dostępne na kartach Porównaj i Analizuj. Więcej informacji zawiera temat:

Omówienie pojęć

Przed rozpoczęciem porównywania modeli przydaje się podstawowa orientacja w pojęciach związanych z oceną modeli. Więcej informacji zawiera temat Omówienie pojęć związanych z przeglądem modelu.

Wpływ ustawień optymalizacyjnych na analizę

W przypadku eksperymentów klasyfikacji i regresji, doświadczenia związane z analizą mogą się nieznacznie różnić w zależności od tego, czy zastosowano inteligentną optymalizację modelu. W przypadku nowych eksperymentów klasyfikacji i regresji inteligentna optymalizacja modelu jest domyślnie włączona.

Analizowanie modeli uczonych przy użyciu inteligentnej optymalizacji

Domyślnie, nowe eksperymenty klasyfikacji i regresji są uruchamiane z inteligentną optymalizacją modelu.

Inteligentna optymalizacja modelu zapewnia bardziej skuteczny proces uczenia, który w idealnym przypadku tworzy model gotowy do wdrożenia, który prawie lub wcale nie wymaga udoskonalenia. Wydajność tych modeli po wdrożeniu produkcyjnym nadal zależy od uczenia ich przy użyciu zestawu danych wysokiej jakości, który zawiera odpowiednie funkcje i dane.

Jeśli Twoja wersja została nauczona przy użyciu inteligentnej optymalizacji modelu, uwzględnij następujące kwestie:

-

Każdy model w danej wersji może mieć inny wybór cech w zależności od sposobu analizy danych przez algorytm.

-

Na karcie Modele przeczytaj Podsumowanie uczenia modelu, zanim przejdziesz do szczegółowej analizy. Podsumowanie uczenia modelu pokazuje, jak Qlik Predict automatycznie zoptymalizował model przez iterację wyboru cech i stosowanie zaawansowanych transformacji.

Więcej informacji o inteligentnej optymalizacji modelu zawiera temat Inteligentna optymalizacja modeli.

Analizowanie modeli uczonych bez inteligentnej optymalizacji

Zamiast tego można było wyłączyć inteligentną optymalizację modelu dla wersji do uczenia. Ręczna optymalizacja modelu może być pomocna, jeśli potrzebujesz większej kontroli nad procesem uczenia.

Jeśli użyto optymalizacji ręcznej, wszystkie modele w danej wersji będą miały ten sam wybór cech, dlatego Podsumowanie uczenia modelu nie jest potrzebne.

Sprawdzanie konfiguracji

Podczas przetwarzania wstępnego cechy mogły zostać wyłączone z użycia w uczeniu. Zwykle dzieje się tak, ponieważ w miarę postępu uczenia jest dostępnych więcej informacji o danych niż przed uruchomieniem wersji.

Po przejrzeniu Podsumowania uczenia modelu (pokazywanego tylko w przypadku inteligentnej optymalizacji) możesz przyjrzeć się dokładniej konfiguracji eksperymentu, jeśli chcesz sprawdzić inne zmiany.

Wykonaj następujące czynności:

-

W eksperymencie przejdź do karty Dane.

-

Sprawdź, czy jesteś w widoku schematu

.

-

Aby wybrać model z wersji, użyj rozwijanego menu na pasku narzędzi.

-

Przeanalizuj schemat modelu. Możesz skoncentrować się na kolumnach Wnioski i Typ cechy, aby sprawdzić, czy określone cechy zostały usunięte lub przekształcone w inny typ cechy.

Na przykład cecha początkowo oznaczona jako Ewentualny dowolny tekst mogła zostać wykluczona po uruchomieniu wersji.

Więcej informacji na temat znaczenia poszczególnych wniosków zawiera temat Interpretowanie wniosków z zestawu danych.

Należy pamiętać, że jeśli uruchomiono wersję z domyślną opcją inteligentnej optymalizacji, każdy model w tej wersji mógł mieć inny wybór cech ze względu na automatyczne udoskonalanie. Jeżeli wersja została uruchomiona bez inteligentnej optymalizacji, wybór cech będzie taki sam dla wszystkich modeli w danej wersji. Więcej informacji o inteligentnej optymalizacji modelu zawiera temat Inteligentna optymalizacja modeli.

W zależności od tego, co znajdziesz w tej konfiguracji, może być wymagany powrót do etapu przygotowania zestawu danych, aby poprawić dane cech.

Po wyłączeniu inteligentnej optymalizacji modelu nie będzie widoczne Podsumowanie uczenia modelu w ramach szybkiej analizy. Ponadto wszystkie modele z wersji eksperymentalnej będą korzystać z tych samych kombinacji cech, podczas gdy modele uczone przy użyciu inteligentnej optymalizacji mogą mieć różne kombinacje cech.

Wybór modelu

Po zakończeniu uczenia rekomendowany model jest automatycznie wybierany do analizy i wyświetlane są wskaźniki tego modelu.

Przełączaj modele, aby porównać różnice we wskaźnikach i konfiguracji. Jeśli jesteś na karcie Dane, użyj menu rozwijanego na pasku narzędzi, aby wybrać model. Jeśli jesteś na karcie Modele, kliknij model w tabeli Wskaźniki modelu, aby wybrać model.

Analiza podsumowania szkolenia

Inteligentna optymalizacja modeli

W przypadku modeli uczonych przy użyciu inteligentnej optymalizacji modelu Podsumowanie uczenia modelu zawiera najważniejsze informacje o tym, co się wydarzyło podczas uczenia. To podsumowanie obejmuje następujące elementy:

-

Współczynnik próbkowania dla modelu.

-

Lista cech, które zostały automatycznie usunięte w wyniku inteligentnej optymalizacji.Ta lista różni się w zależności od wybranego modelu.

-

Podsumowanie wszelkich zaawansowanych transformacji, które zostały zastosowane podczas uczenia modelu.

-

Łącze do zestawu danych do uczenia.

Podsumowanie uczenia modelu nie jest wyświetlane, jeśli optymalizujesz modele ręcznie.

Więcej informacji o inteligentnej optymalizacji modelu zawiera temat Inteligentna optymalizacja modeli.

Wykres Podsumowanie uczenia modelu na karcie Modele

Podsumowanie uczenia modelu nie zawiera listy cech, które zostały usunięte na etapie wstępnego przetwarzania. Aby sprawdzić te informacje, wróć do karty Dane eksperymentu. Zobacz: Sprawdzanie konfiguracji

Wykonaj następujące czynności:

-

W eksperymencie przejdź na kartę Modele.

-

Potwierdź wybór modelu, który chcesz przeanalizować.

-

W sekcji Informacje o modelu po prawej stronie strony przejrzyj Podsumowanie uczenia modelu.

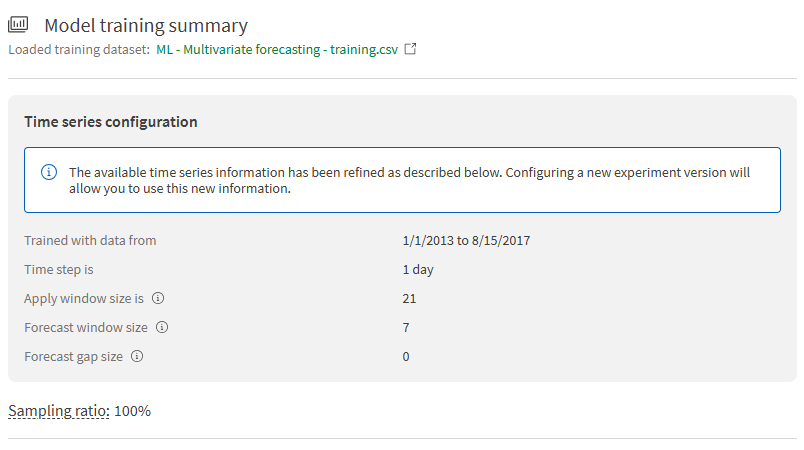

Eksperymenty szeregów czasowych

W eksperymentach szeregów czasowych Podsumowanie trenowania modelu pokazuje ustawienia konfiguracji dla problemu prognozowania szeregów czasowych, zgodnie z definicją zestawu danych i ustawień trenowania. Niektóre z tych szczegółów zostały oszacowane przed rozpoczęciem trenowania, ale teraz są potwierdzone z pewnością po przeanalizowaniu całego zestawu danych. Możesz wyświetlić:

-

Zakres dat danych użytych do trenowania modelu

-

Krok czasowy

-

Wielkość okna stosowania

-

Prognoza maksymalna

-

Wielkości okna prognozy i przerw

Wykres podsumowania trenowania modelu dla modelu w eksperymencie szeregów czasowych

Analiza tabeli wskaźników modelu

Tabela Wskaźniki modelu zawiera ogólne informacje na temat wydajności każdego modelu w eksperymencie. Zalecane modele z tej listy znajdują się nad tabelą.

Tabela Wskaźniki modeli z zalecanymi modelami i filtrami

Tabela pokazuje:

-

Czy model jest modelem z najlepszymi wynikami w odniesieniu do najlepszych typów modeli. Zobacz: Znajdowanie najlepszych modeli

-

Nazwa każdego modelu. (Można ją edytować dla wygody. Zobacz: Edytowanie szczegółów modelu)

-

Algorytm używany do uczenia modelu

-

Kluczowe wskaźniki związane z wydajnością modelu. Można przełączać:

-

Wspólne wskaźniki do oceny potencjału predykcyjnego, zgodnie z typem modelu. W przypadku modeli klasyfikacji binarnej jest to F1. W przypadku modeli klasyfikacji wieloklasowej jest to F1 Macro. W przypadku modeli regresji jest to R2.

-

Szybkość predykcji.

-

Dokładność. W przypadku modeli klasyfikacyjnych jest to wskaźnik o nazwie dokładność. W przypadku modeli regresji jest to MAE (średni błąd bezwzględny).

-

Znajdowanie najlepszych modeli

Modele najlepsze i z najlepszymi wynikami są określane na podstawie zastosowanych filtrów. Są one przedstawione jako rekomendacje nad tabelą wskaźników modelu, a także wyróżnione w tabeli.

Domyślnie jest wybrany Najlepszy model. Ten model jest oznaczony ikoną . Najlepszy model jest określany na podstawie zrównoważonych obliczeń, które uwzględniają zarówno dokładność, jak i szybkość przewidywania.

W zależności od zastosowania może Cię również interesować indywidualna analiza konkretnych markerów wydajności. Inne modele o najlepszych wynikach są wyróżnione następującymi markerami:

-

Najdokładniejszy: model wykazuje najwyższą dokładność w oparciu o odpowiednie wskaźniki punktacji dla danego typu problemu.

-

Najszybszy model: model zapewniający największą szybkość przewidywania. Pod uwagę brana jest również dokładność.

Możesz także wybrać najbardziej wydajne modele bezpośrednio z rekomendacji nad tabelą Wskaźniki modeli.

Pełny przegląd sposobu określania każdego typu zalecanego modelu można znaleźć na stronie Wybór najlepszego modelu dla siebie.

Filtrowanie modeli w tabeli

Tabelę wskaźników modelu można filtrować, aby wyświetlić tylko modele, które chcesz porównać.

Dostępne są następujące filtry i można je łączyć w zależności od potrzeb:

-

Wersja: wybierz jedną lub więcej wersji eksperymentu.

-

Algorytm: wybierz jeden lub więcej algorytmów.

-

Próbkowanie 100%: ten filtr jest stosowany domyślnie. W razie potrzeby można go usunąć. Filtr pokazuje modele, które wykorzystały cały zestaw danych do uczenia, aby ukończyć proces uczenia i weryfikacji krzyżowej. Można go znaleźć w obszarze Więcej filtrów modeli.

-

Wdrożono: pokazuje modele, które zostały wdrożone we wdrożeniach uczenia maszynowego. Można go znaleźć w obszarze Więcej filtrów modeli.

Po zastosowaniu żądanych filtrów najlepsze modele są automatycznie przeliczane na podstawie przefiltrowanych elementów. Zalecane modele są następnie aktualizowane.

Interpretowanie wizualizacji ważności cech

Na karcie Modele przewiń w dół, aby wyświetlić wizualizacje ważności cech. Są to Ważność permutacji i Ważność SHAP.

Wizualizacja ważności cech na karcie Modele

Wykres Ważności permutacji

Wykres Ważność permutacji pokazuje, jak ważna jest każda cecha dla ogólnej predykcji modelu. Zawartość wykresu Ważność permutacji może pomóc w zrozumieniu, jak udoskonalić modele.

Typowe wnioski, jakie można wyciągnąć z analizy tego wykresu:

-

Jeśli jedna cecha pochłania prawie całą ważność, jest to prawdopodobnie oznaka wycieku danych celu. Należy usunąć tę cechę. Jeżeli jest to spowodowane problemami z jakością danych, należy się nimi również zająć.

-

Niektóre cechy mogą mieć bardzo niewielki lub żaden wpływ na przewidywania modelu. Cechy o wyjątkowo niskiej ważności permutacji można uznać za szum statystyczny i należy je usunąć.

Jeśli do uczenia wersji użyto inteligentnej optymalizacji modelu, niektóre z typowych problemów wymienionych powyżej mogły zostać automatycznie rozwiązane przez usunięcie tych cech.

Więcej informacji na temat ważności permutacji zawiera temat Omówienie ważności permutacji.

Wykres Ważności SHAP

Wykres Ważność SHAP oferuje inny sposób analizy wpływu, jaki każda z cech w eksperymencie wywiera na predykcje z każdego modelu. Może to zapewnić wczesny wgląd w to, które cechy są istotne lub czy trzeba ponownie skonfigurować uczenie. Więcej informacji zawiera temat Omówienie ważności SHAP w uczeniu eksperymentów.

Interpretacja wizualizacji ocen modelu

Dla niektórych typów modeli dostępne są dodatkowe wizualizacje, aby pokazać przegląd tego, jak dobrze działa model.

Klasyfikacja binarna

Jeśli eksperyment dotyczy klasyfikacji binarnej, automatycznie generowanych jest kilka dodatkowych wizualizacji do szybkiego wykorzystania. Te wizualizacje dają lepszy wgląd w skuteczność predykcji klas dodatnich i ujemnych przez model.

Aby uzyskać więcej informacji na temat tych wizualizacji, zobacz temat Ocena modeli klasyfikacji binarnej.

Tablica pomyłek

Wykres Tablicy pomyłek pokazuje dokładność predykcji utworzonych przez model. Predykcji dokonuje się na podstawie danych z automatycznego wstrzymania.

Krzywa ROC

Wykres Krzywa ROC pokazuje, jak dobry jest model w przewidywaniu klasy pozytywnej, kiedy rzeczywisty wynik jest pozytywny.

Wygląd idealnej krzywej ROC można zobaczyć w temacie AUC i krzywa ROC.

Szereg czasowy

Dla modeli szeregów czasowych wykres Błąd prognozy w oknie prognozy jest generowany automatycznie, aby zapewnić wgląd w dokładność prognozy. Możesz wyświetlić wskaźnik błędu prognozy dla każdego kroku czasowego w oknie prognozy. Współczynniki błędów są podzielone na pięćdziesiąty, dziesiąty i dziewięćdziesiąty percentyl.

Analizowanie wyników wykrywania stronniczości

Jeśli w wersji aktywowano jakiekolwiek cechy do wykrywania stronniczości, możesz szybko uzyskać wgląd w to, które cechy zostały zidentyfikowane jako posiadające stronniczość danych i modelu.

Nie wszystkie metryki i grupy są wyświetlane w tym skróconym widoku ze względu na ograniczoną przestrzeń. Na przykład, mogą być wyświetlane tylko wartości minimalne i maksymalne, jeśli metryka wykrywania stronniczości jest obliczana na podstawie tych statystyk. Możesz przełączyć się na kartę Analizuj, aby wyświetlić szczegółowe informacje o wynikach stronniczości dla każdej wybranej cechy.

Więcej informacji zawiera temat Szybka analiza wyników stronniczości.