Оценка моделей двоичной классификации

Модели двоичной классификации распределяют результаты по двум категориям: «Да» или «Нет». Насколько точно модель распределяет результаты, можно оценить с помощью целого ряда метрик.

Метрики оценки раскрывают различные преимущества и недостатки модели. Но ни одна из них сама по себе не может быть истинным показателем того, подходит ли модель. В частности, важно отметить, что высокая общая оценка точности не означает, что модель будет работать отлично. Например, что, если у компании коэффициент конверсии составляет всего 10 процентов? В этом случае точность модели могла бы составлять 90 процентов, если бы она просто предположила, что ни один лид никогда не будет сконвертирован. Именно здесь в игру вступают метрики F1, recall (полнота) и precision (точность), которые помогают определить баланс между преимуществами и недостатками модели. Если бы модель предположила, что 100 процентов лидов не будут сконвертированы, значение F1 было бы равно 0.

В ходе обучения эксперимента с двоичной классификацией автоматически создаются следующие диаграммы, позволяющие быстро проанализировать оценки модели.

-

Матрица ошибок: диаграмма, которая суммирует точность результатов прогнозирования в модели классификации. См. Матрица ошибок.

-

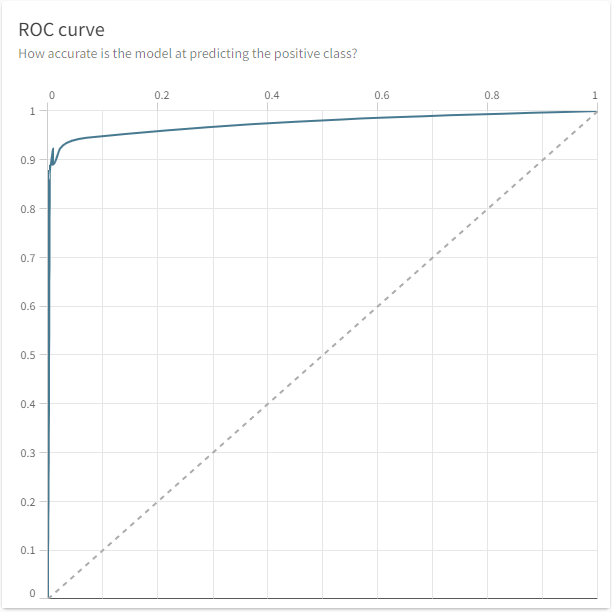

ROC-кривая: диаграмма, которая показывает, насколько хорошо модель машинного обучения прогнозирует положительный класс, когда фактический результат является положительным. См. ROC-кривая и площадь под ней.

Матрица ошибок

Большинство метрик для задач двоичной классификации создаются путем различных вычислений значений с помощью матрицы ошибок. Матрица ошибок — это одна из визуализаций, отображаемых на вкладке Модели. Она показывает, сколько фактически истинных и фактически ложных значений было спрогнозировано правильно, а также общее количество значений для каждого класса. Значения, отображаемые на диаграмме, основаны на автоматически отложенных данных, которые используются для проверки эффективности модели после обучения. Каждая запись в наборе данных распределяется в один из квадрантов.

-

Истинно положительные значения (TP — true positive): фактически истинные значения, которые были верно спрогнозированы как истинные.

-

Ложноположительные значения (FP — false positive): фактически ложные значения, которые были неверно спрогнозированы как истинные.

-

Ложноотрицательные значения (FN — false negative): фактически истинные значения, которые были неверно спрогнозированы как ложные.

-

Истинно отрицательные значения (TN — true negative): фактически ложные значения, которые были верно спрогнозированы как ложные.

Под цифрами в каждом квадранте указаны процентные значения для метрик recall (TP), fallout (FP), miss rate (FN) и specificity (TN). Наведите курсор на значение, чтобы увидеть подсказку о метрике.

Матрица ошибок для модели с двоичной классификацией

Любой реалистичный сценарий покажет ложноположительные и ложноотрицательные результаты в матрице ошибок. Идеальные прогнозы на основе данных для обучения указывают на то, что модель запомнила ответы и будет плохо работать в реальных условиях. Вам необходимо убедиться, что было получено достаточное количество истинно положительных и истинно отрицательных результатов.

F1

F1 — это метрика, которая пытается учитывать точность, когда классы не сбалансированы, сосредоточив внимание на точности положительных прогнозов и фактически положительных записей. С ее помощью можно определить, насколько точно модель показывает результаты, которые имеют для нас значение. Метрика F1 пытается сбалансировать значения полноты и точности, чтобы найти среднее гармоническое значение между этими двумя показателями. Следует учитывать, что чем более несбалансированным будет набор данных, тем ниже будет значение F1 даже при одинаковой общей точности.

Если значение F1 высокое, то и значения всех остальных метрик оценки тоже будут высокими. Если значение F1 низкое, это указывает на необходимость проведения дальнейшего анализа. Однако если значение метрики очень высокое или если оценка, полученная на основе отложенных данных, намного ниже, чем оценка, полученная в ходе перекрестной проверки, это может быть признаком утечки данных.

Значение F1 рассчитывается следующим образом: 2 x ((precision x recall) / (precision + recall)).

Полнота

Recall (полнота) — это доля истинно положительных результатов. Эта метрика измеряет, как часто модель точно спрогнозировала истинный результат, когда результат на самом деле является истинным, т. е. насколько точно модель нашла все фактически истинные значения в наборе данных. Полнота является показателем, позволяющим хорошо запоминать положительный класс. Это значение рассчитывается следующим образом: TP / (TP + FN).

Прецизионность

Метрика precision (точность) также известна как положительное прогнозное значение. Она измеряет вероятность того, что модель верно спрогнозировала, что значение является истинным. Это значение рассчитывается следующим образом: TP / (TP + FP).

Компромисс между полнотой и точностью

Полноту можно описать как уровень охвата модели: охватила ли она все истинные результаты, даже если сделала несколько ложноположительных прогнозов? Охватила ли она как можно больше истинных результатов? Точность является обратной величиной полноты. При этом необходимо убедиться в том, что когда модель прогнозирует истинные результаты, она прогнозирует их очень точно. Но при высокой точности мы получим больше ложноотрицательных результатов, когда модель прогнозирует ложные результаты, даже если что-то является истинным.

Существует компромисс между тем, чтобы не пропустить ни одного истинного результата, и тем, чтобы быть уверенным, что ни один из результатов, спрогнозированных как истинные, фактически не окажется ложным. Насколько целесообразно выбрать более высокую точность или более высокий уровень полноты, зависит от конкретного бизнес-сценария использования. Например, при прогнозировании диагноза заболевания важно убедиться, что не будет пропущен ни один пациент, который на самом деле страдает этим заболеванием, то есть ни один ложноотрицательный результат.

-

Если «стоимость» ложноотрицательного результата высока, целесообразно использовать модель с более высоким уровнем полноты.

-

Если «стоимость» ложноположительного результата высока, целесообразно использовать модель с более высокой точностью.

Точность

Accuracy (точность) измеряет, как часто модель в среднем дает правильный прогноз. Это значение рассчитывается следующим образом: (TP + TN) / (все прогнозы).

Специфичность

Specificity (специфичность) — это доля истинно отрицательных результатов. Специфичность измеряет, как часто модель точно спрогнозировала ложный результат, когда результат на самом деле является ложным. Это значение рассчитывается следующим образом: TN / (FP + TN).

MCC

Коэффициент корреляции Мэтьюса (MCC) варьируется в диапазоне от −1 до 1, где 1 означает, что модель правильно спрогнозировала каждый образец. Этот коэффициент рассчитывается следующим образом: ((TP x TN) - (FP x FN)) / [(TP + FP) x (FN + TN) x (FP + TN) x (TP + FN)]^(1/2)

Коэффициент пропусков

Miss rate (коэффициент пропусков) — это доля ложноотрицательных результатов. Это соотношение между количеством ложноотрицательных результатов и общим количеством фактически положительных результатов. Это значение рассчитывается следующим образом: FN / (TP + FN).

Выпадение

Fallout (коэффициент выпадения) — это доля ложноположительных результатов. Это соотношение между количеством ложноположительных результатов и общим количеством фактически отрицательных результатов. Это значение рассчитывается следующим образом: FP / (FP + TN).

NPV

Отрицательное прогнозное значение (NPV) измеряет вероятность того, что модель верно спрогнозировала, что значение является ложным. Это значение рассчитывается следующим образом: TN / (FN + TN).

Логарифмические потери

Log Loss (логарифмическая потеря) — это общий показатель точности в логистической регрессии. Чем ниже значение log loss, тем точнее прогнозирование — в идеальной модели значение log loss было бы равно 0.

ROC-кривая и площадь под ней

Площадь под кривой (AUC) — это более сложная метрика точности, которая помогает понять, насколько детерминирована модель. Она описывает, насколько хорошо модель прогнозирует положительный класс, когда фактический результат является положительным.

Метрика AUC определяется как площадь под ROC-кривой. ROC-кривая показывает соотношение доли ложноположительных результатов (ось x) и доли истинно положительных результатов (ось y) для ряда различных пороговых значений в диапазоне от 0,0 до 1,0. Другими словами, она показывает соотношение доли ложных тревог и доли правильных прогнозов. Эта кривая позволяет понять, возможно ли распределение по классам, и показывает, достаточно ли хороши данные, чтобы можно было четко различить прогнозируемые результаты.

Доля истинно положительных результатов рассчитывается следующим образом: TP / (TP + FN).

-

Чем ближе доля истинно положительных результатов к значению 1,0 (максимально возможная площадь под кривой), тем более детерминированной является модель.

-

Чем ближе доля истинно положительных результатов к значению 0,5, тем менее детерминированной является модель.

На рисунке ниже показана хорошая ROC-кривая. Она хороша тем, что проходит максимально близко к значению 1, что дает высокое значение AUC. Пунктирная линия означает случайный результат, 50:50. Если значение AUC низкое, кривая считается плохой.

Хорошая ROC-кривая с высоким значением AUC

Порог

Порог — это вероятность того, что прогноз верен. Он представляет собой компромисс между ложноположительными и ложноотрицательными результатами. Пороговое значение определяется для каждого алгоритма, и, скорее всего, у каждого алгоритма в модели будет свое пороговое значение.

Настройка порога

Настройка порога — это эффективный способ обеспечить выбор правильного порогового значения, чтобы оптимизировать показатель F1 для моделей двоичной классификации. Qlik Predict рассчитывает точность и полноту для сотен различных возможных пороговых значений в диапазоне от 0 до 1. Затем выбирается пороговое значение, при котором достигается наибольшее значение F1.

Выбор порога — вместо того, чтобы полагаться на пороговое значение по умолчанию 0,5 — позволяет получать прогнозы, которые являются более надежными для наборов данных с несбалансированным количеством положительных и отрицательных классов.

На графике порог установлен на отметке 0,5. В этом случае фактически истинные записи с результатом прогнозирования менее 0,5 были определены как ложные (ложноотрицательные).

Пороговое значение на отметке 0,5

Изменение порога, который определяет, будет ли запись спрогнозирована как истинная или ложная, может привести к смещению в сторону более высокого уровня полноты или более высокой точности.

Альтернативные пороговые значения приводят либо к более высокому уровню полноты, либо к более высокой точности

Скорость прогнозирования

Скорость предсказания – это метрика, которая применяется ко всем типам моделей: бинарной классификации, многоклассовой классификации, регрессии и временных рядов. Скорость предсказания измеряет, насколько быстро модель машинного обучения способна генерировать предсказания.

В Qlik Predict скорость предсказания рассчитывается по двум факторам: времени вычисления признака и времени предсказания на тестовом наборе данных. Отображается в строках в секунду.

Скорость предсказания можно проанализировать в таблице Метрики модели после выполнения версии эксперимента. Кроме того, скорость предсказания данных можно проверить при анализе моделей со встроенной аналитикой. Для получения дополнительной информации см.:

Замечания

Результирующее значение скорости предсказания зависит от размера обучающего набора данных, а не от характера данных, на основе которых делаются предсказания. После развертывания модели разница в скорости генерации предсказаний заметна, если обучающие данные и новые входные данные значительно отличаются по размеру или предсказания генерируются в режиме реального времени на одном или нескольких рядах данных.

Метрики смещения

В дополнение к этим метрикам также доступен ряд метрик предвзятости для функциональности, на которой вы выполняете обнаружение предвзятости. Некоторые из этих метрик специфичны для типа модели, которую вы обучаете. Для получения дополнительной информации см. раздел Обнаружение предвзятости в моделях машинного обучения.