Évaluer et générer un modèle de classification

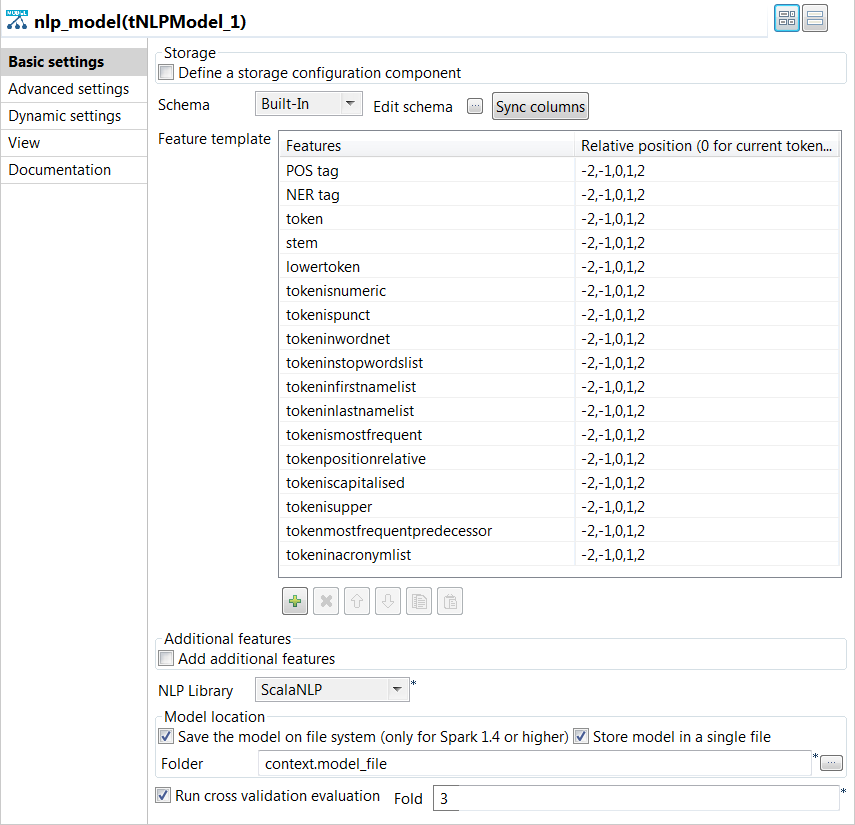

Le tNLPModel lit des données d'apprentissage au format CoNLL afin d'évaluer et de générer un modèle de classification.

Procédure

Résultats

Les éléments suivants sont également écrits en sortie dans la console de la vue Run :

| Catégorie | Élément |

|---|---|

| Pour chaque classe | Le nom de la classe |

| True Positive : le nombre d'éléments correctement identifiés comme étant des éléments de cette classe. | |

| Predicted True : le nombre d'éléments identifiés comme étant des éléments de cette classe. | |

| Labeled True : le nombre d'éléments appartenant à cette classe. | |

| Precision score : ce score varie de 0 à 1, indique la pertinence des éléments sélectionnés par la classification par rapport à une classe donnée. | |

| Recall score : ce score varie de 0 à 1, indique combien d'éléments pertinents sont sélectionnés. | |

| F1-score : la moyenne harmonique du Precision score (score de précision) et du Recall score (score de rappel). | |

| Pour le meilleur modèle | Le F1-score pondéré global |

Le fichier de modèle est stocké dans le dossier spécifié. Vous pouvez maintenant utiliser le modèle généré par le composant tNLPPredict afin d'effectuer une prédiction des entités nommées et de libeller automatiquement les données textuelles.