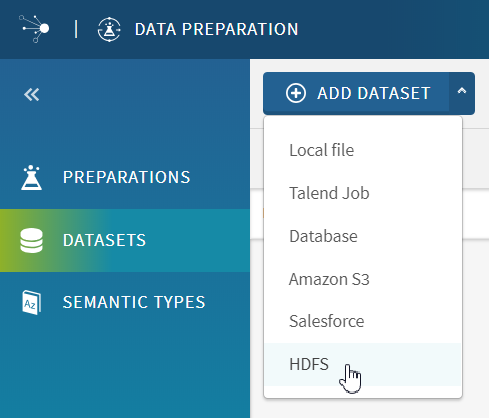

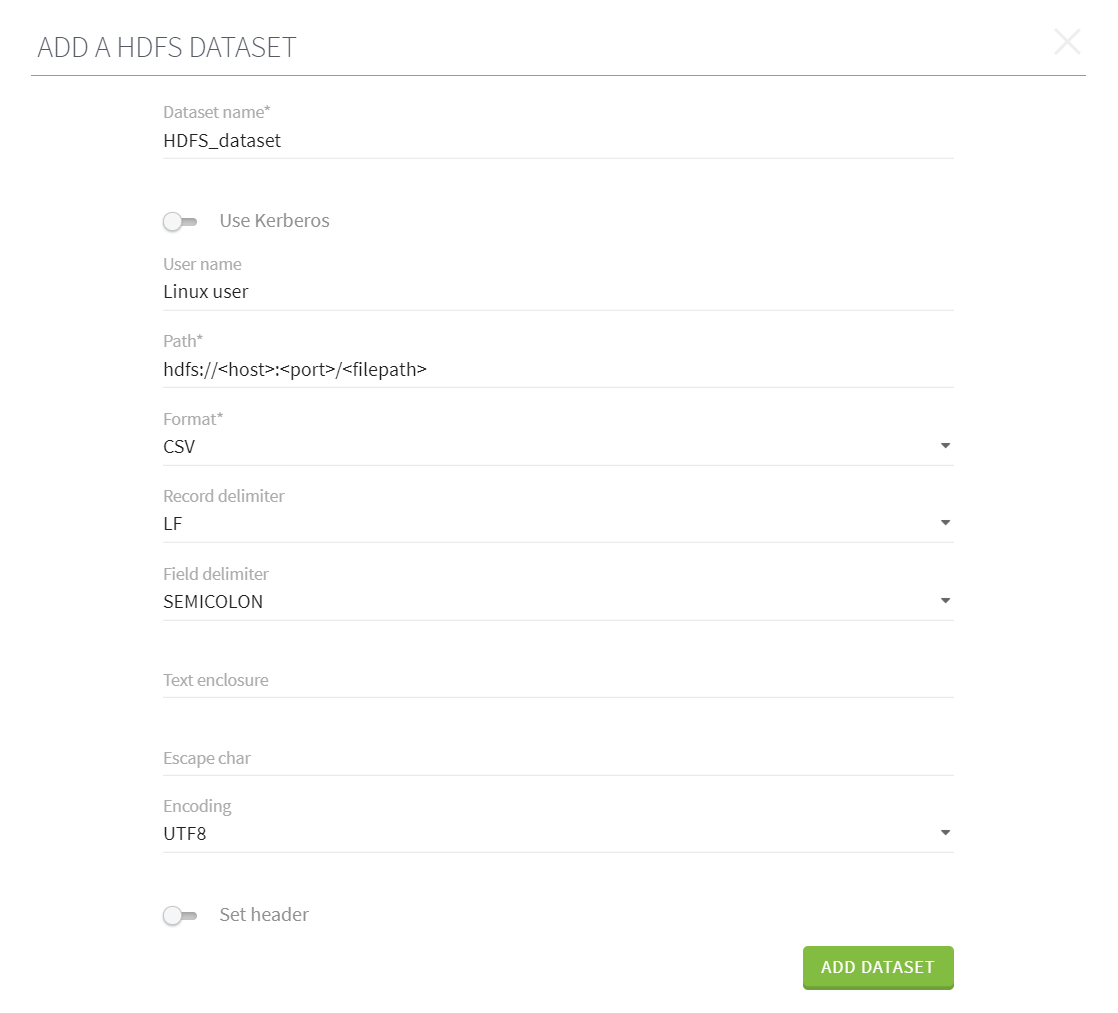

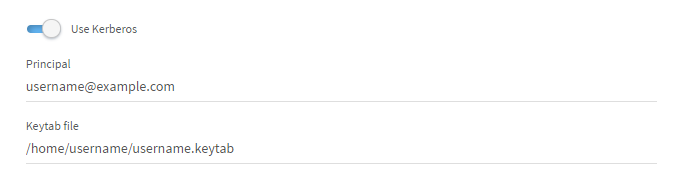

HDFSからデータセットを追加

HDFS (Hadoop File System)に保存されたデータにTalend Data Preparationインターフェイスから直接アクセスして、データセットの形でインポートできます。

手順

タスクの結果

クラスターから抽出されたデータがグリッド内に開かれ、プレパレーションへの作業を開始できます。

データはクラスターに保存されたままの状態であり、Talend Data Preparationはサンプルのみをオンデマンドで取得します。

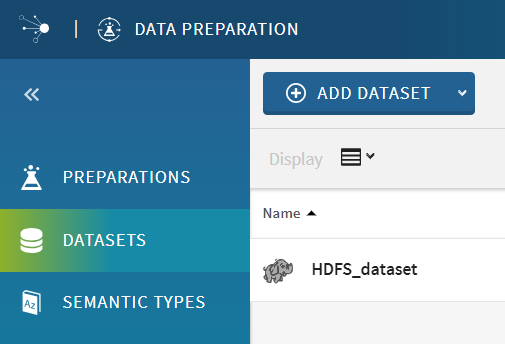

これで、データセットがアプリケーションのホームページの[Datasets] (データセット)ビューに表示されるようになります。