変換済みジョブを編集

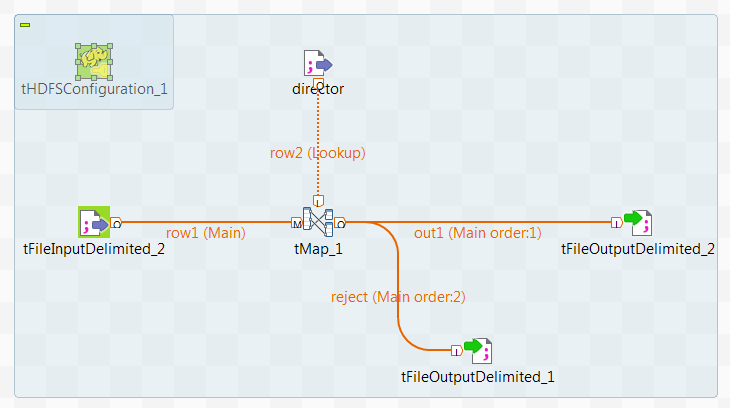

コンポーネントを更新し、Spark Streamingフレームワーク内で実行されるデータ変換プロセスを確定します。

DBFSシステムの代わりにKafkaクラスターを使用して、ストリーミング映画データをジョブに提供します。ディレクターデータは、ルックアップフローでDBFSから引き続き取り込まれます。

始める前に

-

使用するDatabricksクラスターが正しく設定され、実行されています。

-

クラスターの管理者が、読み書き権限と、ユーザー名をDBFSおよびAzure ADLS Gen2ストレージシステム内の関連データとディレクトリーへのアクセスに使用する権限を付与していること。

手順

タスクの結果

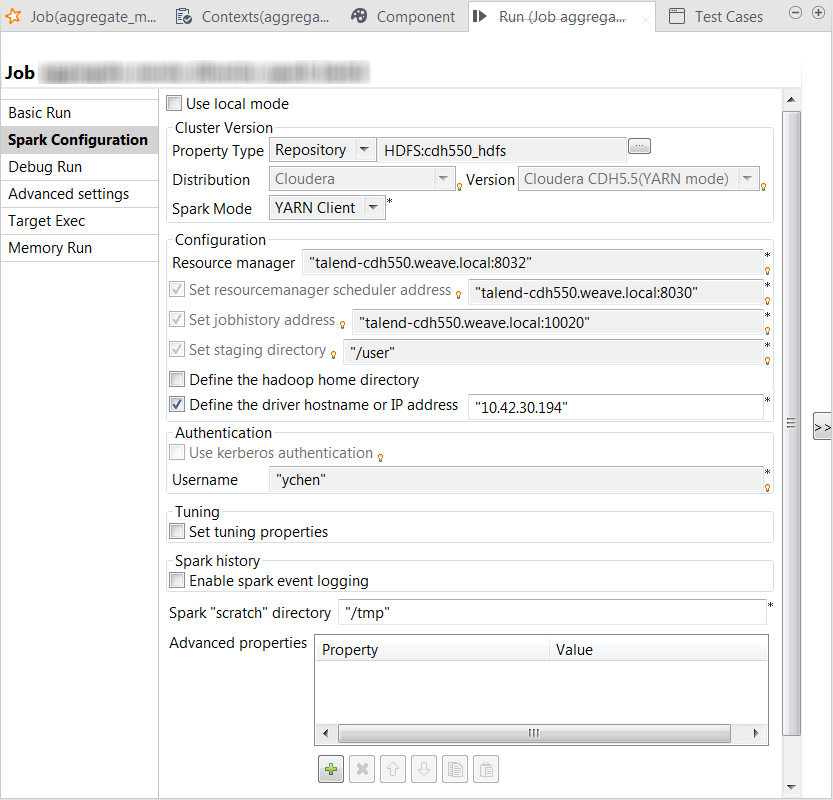

[Run] (実行)ビューがStudioの下側に自動的に開き、このジョブの実行の進行状況を示します。

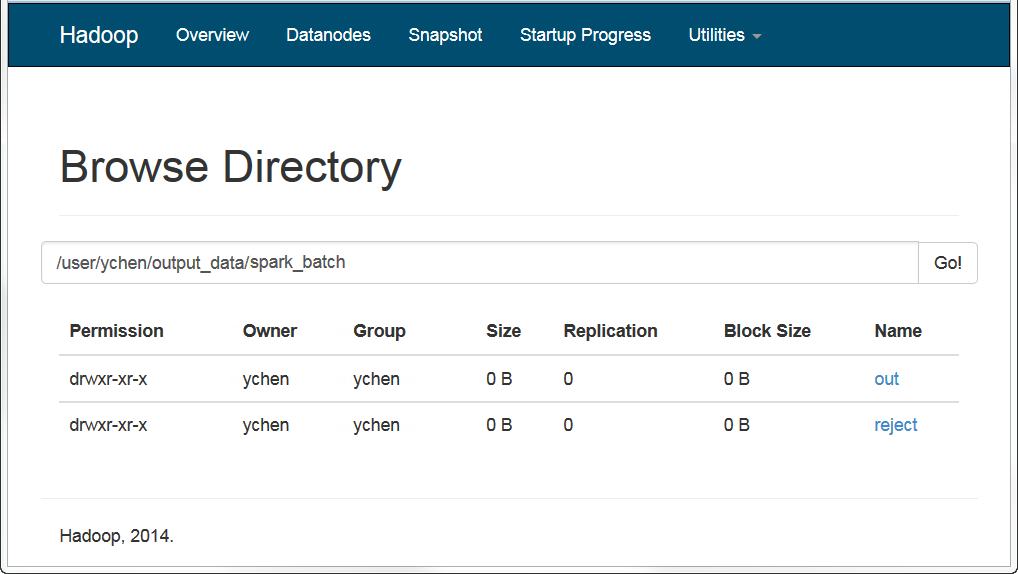

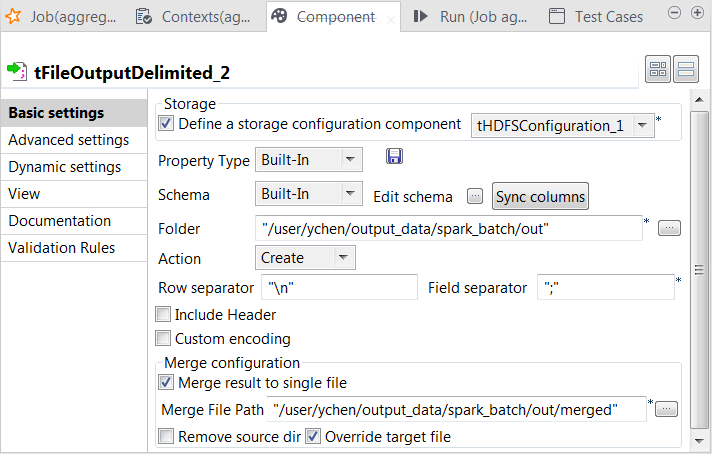

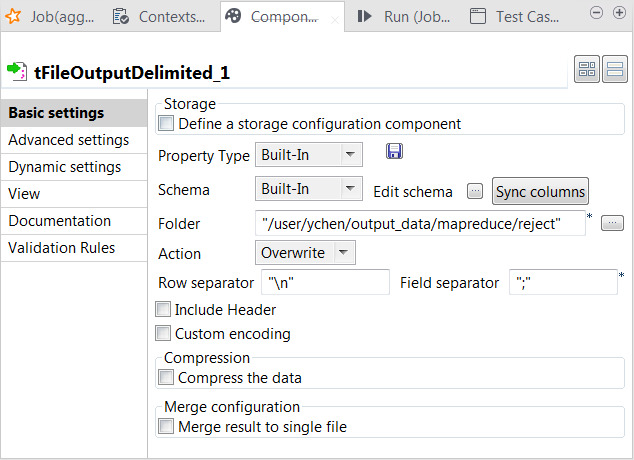

ジョブが完了すると、たとえばHDFSシステムのWebコンソール内で、出力がHDFSに書き込まれていることを確認できます。