编辑已转换的作业

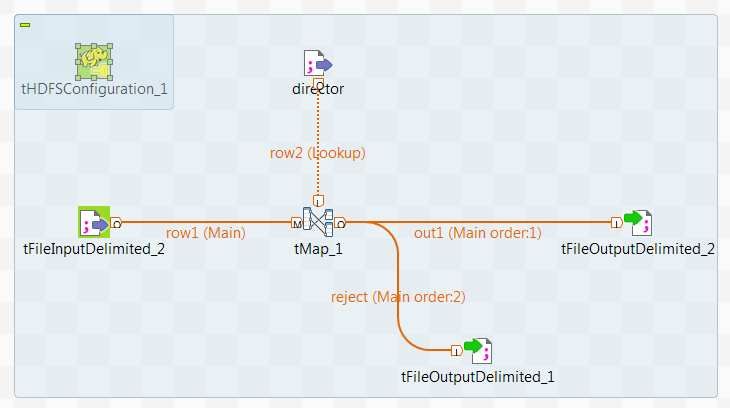

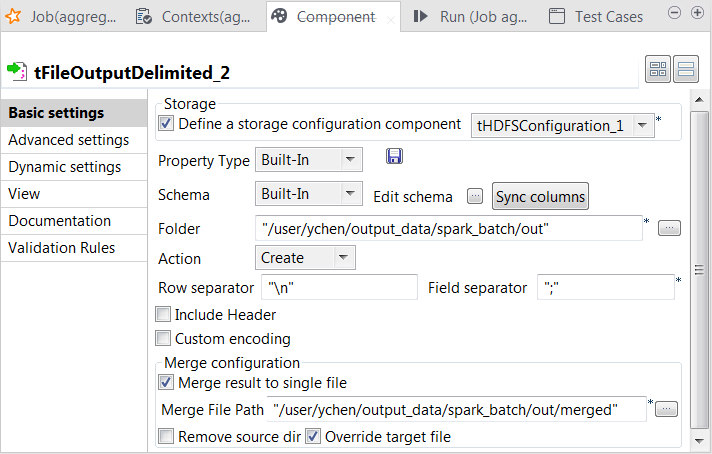

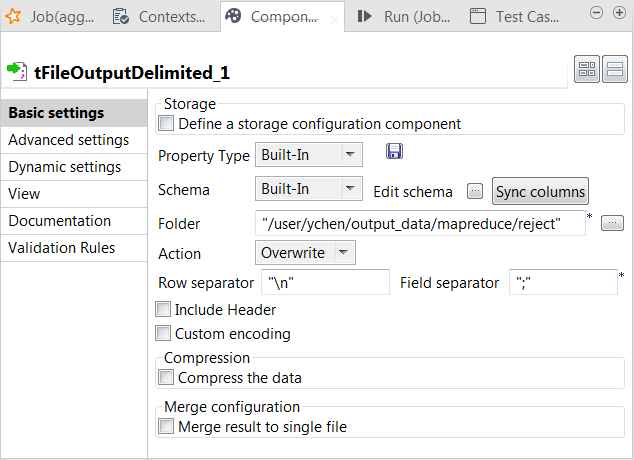

更新组件以完成在 Spark Streaming 框架中运行的数据转换流程。

使用 Kafka 集群而非 DBFS 系统,将流式处理影片数据提供给作业。在查找流中,仍然从 DBFS 提取导演数据。

开始之前

-

要使用的 Databricks 集群已正确配置,并且正在运行。

-

集群管理员已经为用户名提供读取/写入权限,使其能够访问 DBFS 和 Azure ADLS Gen2 存储系统中的相关数据和目录。

步骤

结果

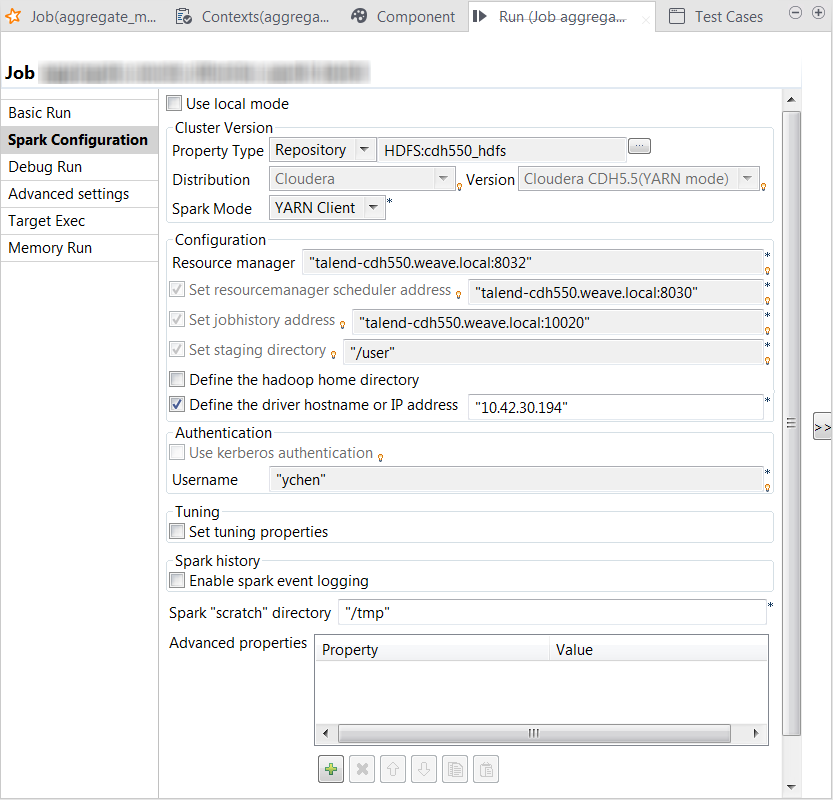

Run (运行) 视图将在 Studio 的下半部分自动打开,并显示此作业的执行进度。

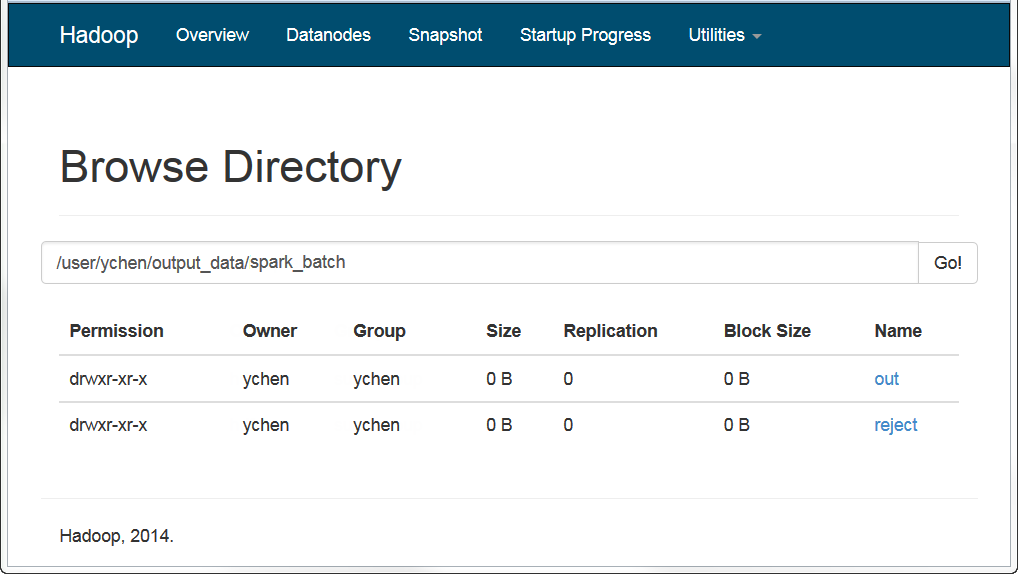

完成后,您可以检查 (例如在 HDFS 系统的 Web 控制台中) 输出是否已被写入了 HDFS 中。