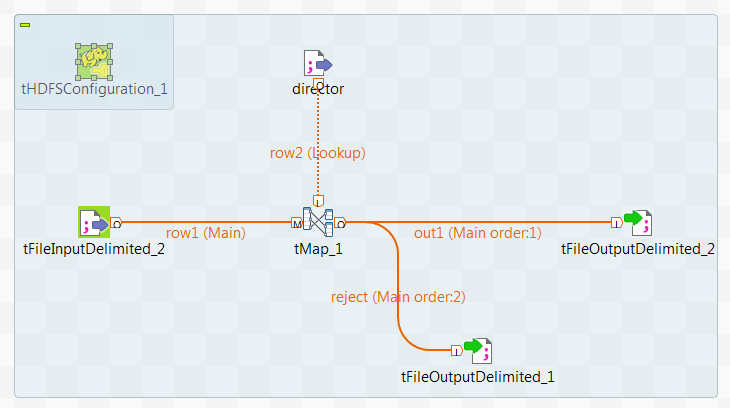

Modifier le Job converti

Vous pouvez mettre à jour les composants, si nécessaire, pour finaliser un processus de transformation de données dans le framework Spark Streaming.

Un cluster Kafka est utilisé au lieu du système DBFS afin de fournir les données relatives au streaming de films au Job. Les données des cinéastes sont ingérées depuis DBFS dans le flux Lookup.

Avant de commencer

-

Le cluster Databricks à utiliser a été correctement configuré et est en cours de fonctionnement.

-

L'administrateur du cluster doit avoir donné les droits d'accès en lecture/écriture à l'utilisateur ou l'utilisatrice accédant aux données et répertoires dans DBFS et dans le système de stockage Azure ADLS Gen2.

Procédure

Résultats

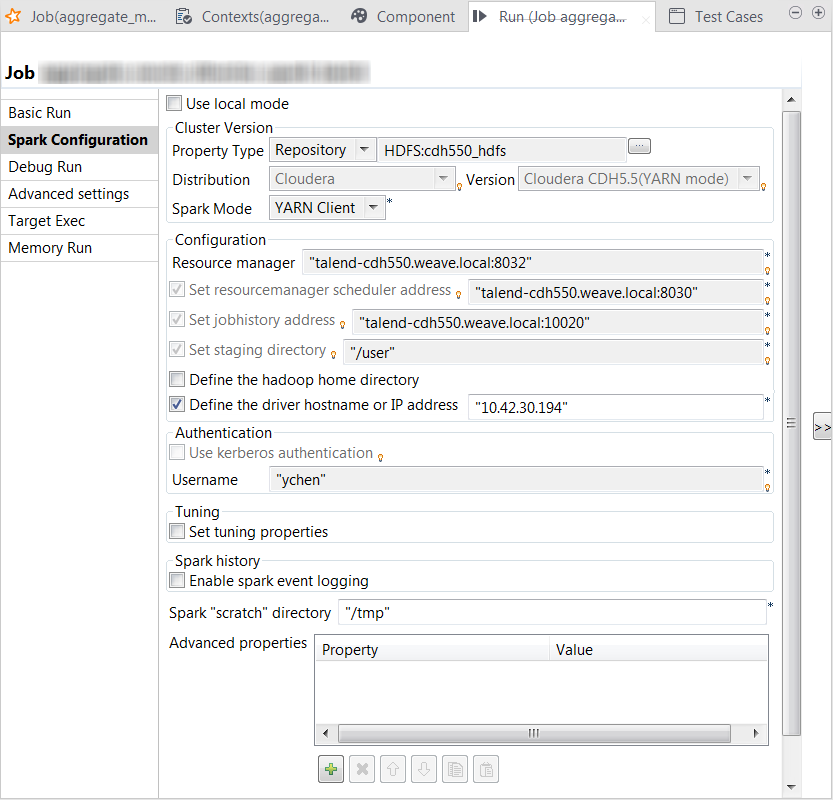

La vue Run s'ouvre automatiquement dans la partie inférieure du Studio et affiche l'avancement de l'exécution du Job.

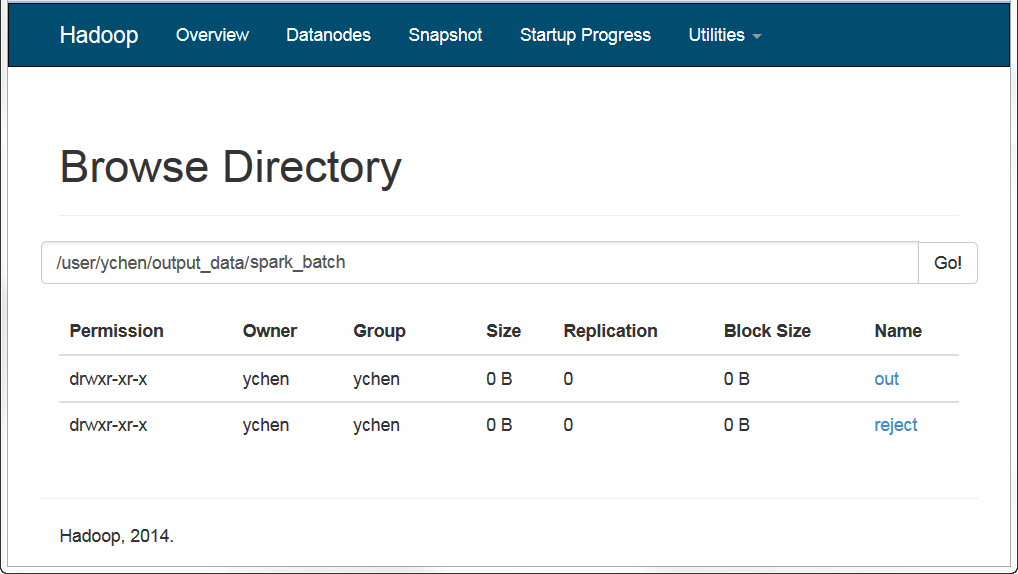

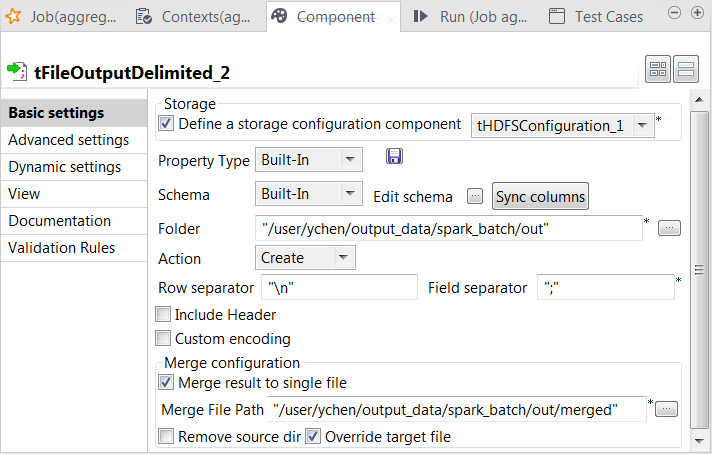

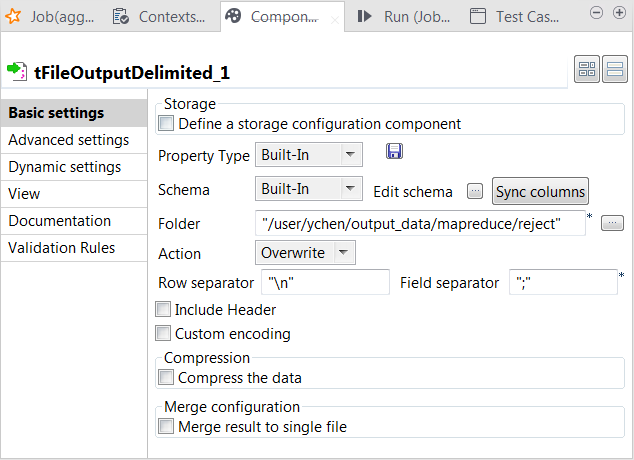

Cela fait, vous pouvez vérifier, par exemple, dans la console Web de votre système HDFS, que la sortie a bien été écrite dans HDFS.