Sparkジョブの作成

Integration パースペクティブの[Repository] (リポジトリー)ツリービューにある[Job Designs] (ジョブデザイン)ノードから、または[Job Designs] (ジョブデザイン)ノードの下にある[Big Data Batch] (ビッグデータバッチ)ノードから始めることができます。

2つのアプローチは似ています。次の手順は、[Job Designs] (ジョブデザイン)ノードからSparkジョブを作成する方法を示すものです。

手順

タスクの結果

[Repository] (リポジトリー)ツリービューで、作成されたこのSparkジョブが、[Job Designs] (ジョブデザイン)の下にある[Big Data Batch] (ビッグデータバッチ)ノードの下に自動的に表示されます。

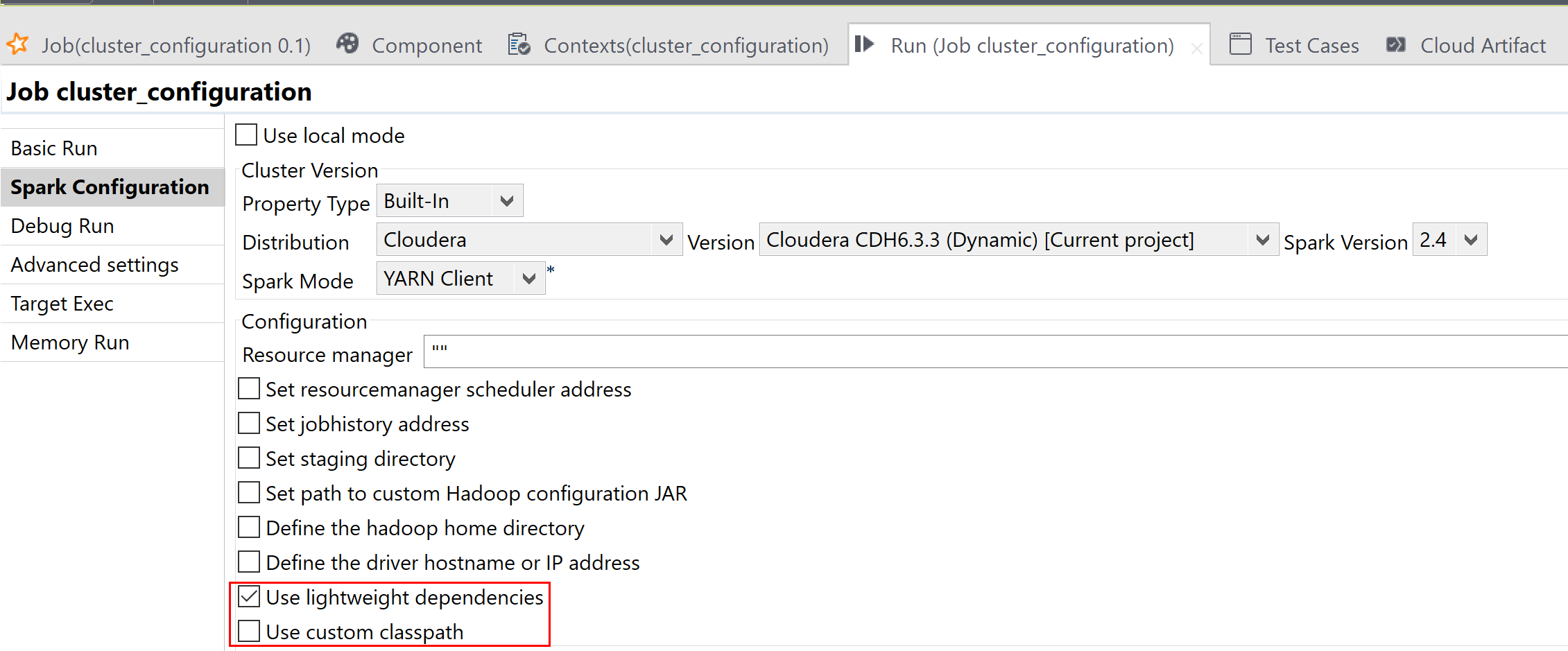

使用するコンポーネントを[Palette] (パレット)からワークスペースに配置し、標準ジョブの場合と同様じ方法でリンクや設定を行ってSparkジョブをデザインします。また、[Run] (実行)ビューの[Spark configuration] (Spark設定)タブで、使用するSparkクラスターへの接続をセットアップする必要があります。

Spark Streamingジョブを作成する場合も、同じオペレーションを繰り返します。唯一異なるステップは、[Job Designs] (ジョブデザイン)ノードを右クリックした後でコンテキストメニューから[Create Big Data Streaming Job] (ビッグデータストリーミングジョブの作成)を選択し、表示される[New Big Data Streaming Job] (新しいビッグデータストリーミングジョブ)ウィザードで、[Framework] (フレームワーク)ドロップダウンリストからSpark Streamingを選択する点だけです。

- Amazon EMR 6.2.0

- Cloudera CDH 6.1.1、およびその他の6.xバージョン(ダイナミックディストリビューションを通じて互換性あるもの)

- Cloudera CDH 7.1.1、およびその他の7.1.xバージョン(ダイナミックディストリビューションを通じて互換性あるもの)

Sparkジョブを[Local] (ローカル)モード以外のモードで実行する必要がある場合は、同じジョブ内にストレージコンポーネント(通常はtHDFSConfigurationコンポーネント)が必要です。これは、Sparkがこのコンポーネントを使用して、ジョブに依存するjarファイルの転送先のファイルシステムに接続できるようにするためです。

ジョブスクリプトビューにジョブスクリプトを書き込み、ジョブを生成することで、これらのタイプのジョブを作成することも可能です。ジョブスクリプトの使い方の詳細は、ジョブスクリプトリファレンスガイドをご覧ください。