Verarbeiten von Streamingdaten zu Flugzeugen

Vorbereitungen

-

Sie haben zuvor eine Verbindung zu dem System erstellt, in dem die Quelldaten gespeichert sind.

-

Sie haben zuvor den Datensatz hinzugefügt, der die Quelldaten enthält.

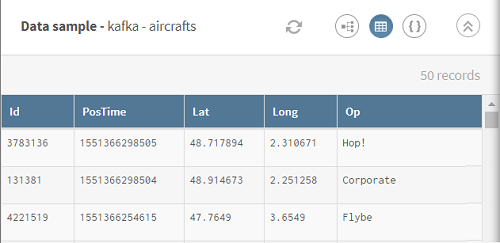

In diesem Beispiel Streamingdaten zu Flugzeugen, d. h. Flugzeug-ID, Position und Zeitstempel.

Um dieses Szenario besser zu verstehen, finden Sie nachstehend das AVRO-Schema der im Szenario verwendeten Streamingdaten:{ "type": "record", "name": "aircrafts", "fields": [ {"name": "Id", "type": "int"}, {"name": "PosTime", "type": "long"}, {"name": "Lat", "type": "double"}, {"name": "Long", "type": "double"}, {"name": "Op", "type": "string"} ] }Hierbei gilt: Id entspricht der Flugzeug-ID, PosTime dem Zeitstempel der Position, Lat/Long dem Breiten-/Ländengrad des Flugzeugs und Op den Fluggesellschaften.

-

Sie haben außerdem die Verbindung und den zugehörigen Datensatz erstellt, der die verarbeiteten Daten aufnehmen soll.

In diesem Beispiel eine MySQL-Tabelle.

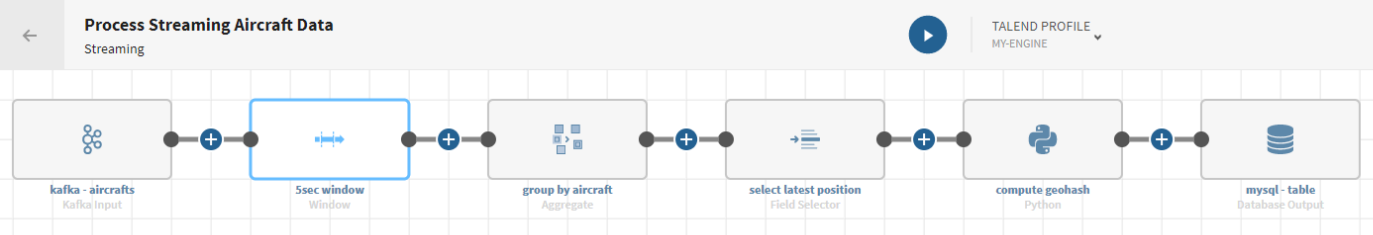

Prozedur

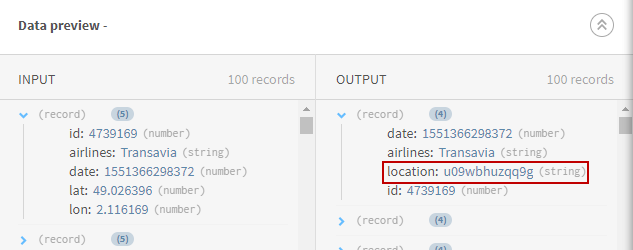

Ergebnisse

Ihre Streaming-Pipeline wird ausgeführt und bleibt aktiv, bis Sie sie explizit beenden. Die Flugzeugdaten werden geändert und die berechneten Geohash-Daten an das von Ihnen angegebene Zielsystem gesendet.