Traiter des données de streaming d'avions

Avant de commencer

-

Vous avez précédemment créé une connexion au système stockant vos données source.

-

Vous avez précédemment ajouté le jeu de données contenant vos données source.

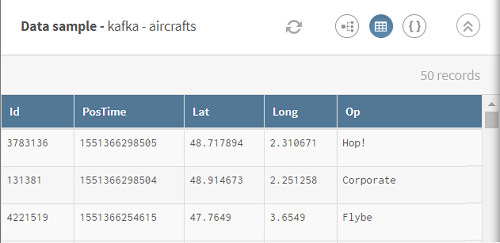

Ici, les données de streaming des avions comprennent l'identifiant des avions, leur position et la date et l'heure.

Pour vous aider à comprendre ce scénario, vous trouverez ci-dessous le schéma Avro des données de streaming utilisées dans ce scénario :{ "type": "record", "name": "aircrafts", "fields": [ {"name": "Id", "type": "int"}, {"name": "PosTime", "type": "long"}, {"name": "Lat", "type": "double"}, {"name": "Long", "type": "double"}, {"name": "Op", "type": "string"} ] }où Id correspond aux identifiants des avions, PosTime à la date et l'heure de la position, Lat/Long à la latitude et à la longitude des avions, et Op aux compagnies aériennes.

-

Vous avez créé la connexion et le jeu de données associé qui contiendra les données traitées.

Ici, une table MySQL.

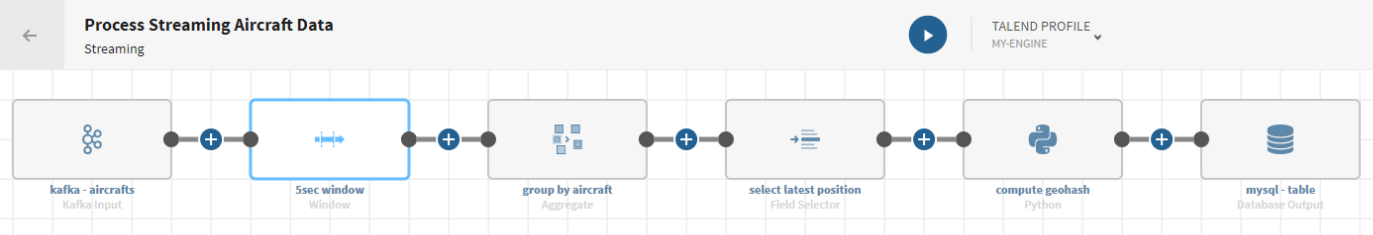

Procédure

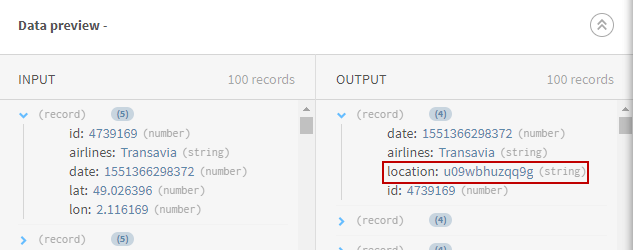

Résultats

Votre pipeline de streaming est en cours d'exécution et sera exécuté jusqu'à ce que vous l'arrêtiez. Les données des avions sont modifiées et les informations des geohashes calculés sont envoyés au système cible que vous avez spécifié.