Test de Jobs Spark à l'aide de scénarios de test

Vous devez suivre les mêmes étapes détaillées dans Tests des Jobs et des Services à l'aide de scénarios de test pour réaliser un scénario de test Spark, mais notez qu'un squelette de test différent est dédié aux Jobs Spark.

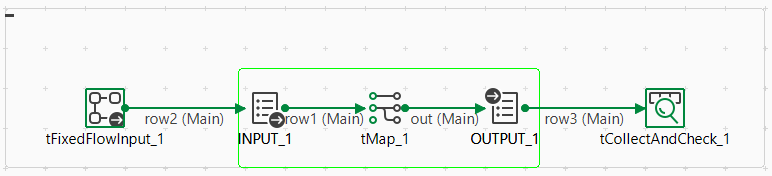

Cependant, soyez conscient que le squelette de test dédié aux Jobs Spark est différent :

-

un ou plusieurs composants tFixedFlowInput (ou tBoundedStreamInput pour un Job Spark Streaming), selon le nombre de flux d'entrée du Job, pour charger le(s) fichier(s) d'entrée,

-

un ou plusieurs composants tBoundedStreamInput pour un Job Spark Streaming, selon le nombre de flux d'entrée du Job, pour charger le(s) fichier(s) d'entrée,

-

les icônes INPUT et OUTPUT en lecture seule sont utilisées pour indiquer le commencement et la fin des parties à tester,

-

un ou plusieurs composants tCollectAndCheck, selon le nombre de flux de sortie du Job, pour comparer le(s) fichier(s) temporaire(s) de sortie au(x) fichier(s) de référence. Le test est réalisé avec succès si les fichiers comparés sont identiques.

De plus, le mode Local est utilisé par défaut dans l'onglet Spark configuration. Un bouton radio Use context variable est disponible dans l'onglet Basic settings du tFixedFlowInput ou du tBoundedStreamInput et est automatiquement sélectionné pour vous permettre de choisir d'utiliser l'une de ces nouvelles variables de contexte.

Avant de créer un scénario de test pour un Job, assurez-vous que tous les composants de votre Job ont été configurés.

Pour plus d'informations concernant l'intégration continue et son implémentation avec Talend, consultez le Software Development Life Cycle - Guide de bonnes pratiques.