Création d'un Job Spark

Vous pouvez créer un Job Spark soit depuis le nœud Job Designs de la vue Repository, dans la perspective Integration, soit depuis le nœud Big Data Batch sous le nœud Job Designs.

La procédure suivante vous explique comment créer un Job Spark depuis le nœud Job Designs.

Procédure

Résultats

Dans la vue Repository, le Job Spark créé s'affiche automatiquement sous le nœud Big Data Batch, sous le nœud Job Designs.

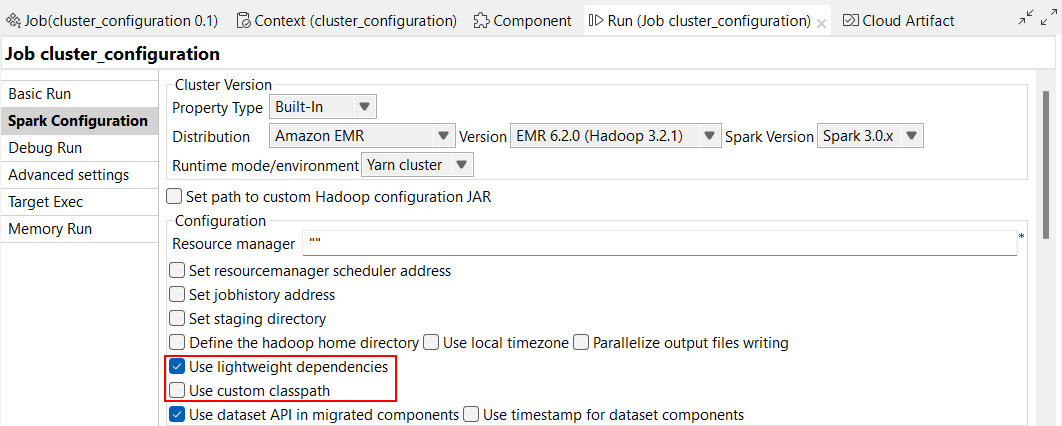

Déposez depuis la Palette les composants à utiliser dans l'espace de modélisation graphique, reliez-les et configurez-les afin de créer un Job Spark, de la même manière que pour un Job standard. Vous devez également configurer la connexion au cluster Spark à utiliser dans l'onglet Spark configuration de la vue Run.

Vous pouvez répéter les mêmes opérations afin de créer un Job Spark Streaming. La seule différence est que vous devez sélectionner Create Big Data Streaming Job dans le menu contextuel après avoir cliqué-droit sur le nœud Job Designs et que vous devez sélectionner Spark Streaming dans la liste Framework de l'assistant [New Big Data Streaming Job] ouvert.

- Amazon EMR 6.2.0

- Cloudera CDH 6.1.1 et autres versions 6.x compatibles via les distributions dynamiques

- Cloudera CDP 7.1.1 et autres versions 7.x compatibles via les distributions dynamiques

Notez que, si vous devez exécuter votre Job Spark dans un mode différent du mode Local et dans une distribution différente de Universal, vous devez utiliser un composant de stockage de la famille Storage, comme le composant tHDFSConfiguration, au sein du Job, afin que Spark utilise ce composant pour se connecter au système de fichiers auquel les fichiers JAR dépendants du Job seront transférés.

Vous pouvez également créer ces types de Jobs en écrivant leur script dans la vue Jobscript puis en les générant à partir de ce script. Pour plus d'informations concernant l'utilisation des scripts de Jobs, consultez le Guide de référence des scripts de Jobs Talend.