Nouveautés de la version R2021-03

Big Data : nouvelles fonctionnalités

|

Fonctionnalité |

Description |

Disponible dans |

|---|---|---|

| Support de Databricks 7.3 LTS avec les composants Spark 3.0 |

Vous pouvez à présent exécuter des Jobs Spark Batch et Spark Streaming sur la distribution Databricks 7.3 LTS, sur AWS et sur Azure pour des clusters interactifs et transitoires, avec Spark 3.0. Les composants suivants sont supportés :

Cette fonctionnalité est à présent généralement disponible. |

Tous les produits Talend incluant Big Data |

| Support de CDP Public Cloud Data Hub sur AWS | Vous pouvez à présent configurer une instance de CDP Public Cloud Data Hub sur AWS dans Cloudera Management Console pour exécuter votre Job sur un JobServer distant dans le Studio Talend. Cela vous permet de configurer votre cluster en choisissant directement une définition de cluster Data Hub selon vos besoins (par exemple Data Engineering pour AWS ou Data Discovery and Exploration pour AWS). Vous n'avez plus qu'à importer tous les fichiers de configuration depuis ce cluster dans le Studio Talend afin de lancer votre Job. Cette fonctionnalité vous permet de tirer parti de l'élasticité d'un cluster Cloud directement dans CDP Public Cloud. |

Tous les produits Talend incluant Big Data |

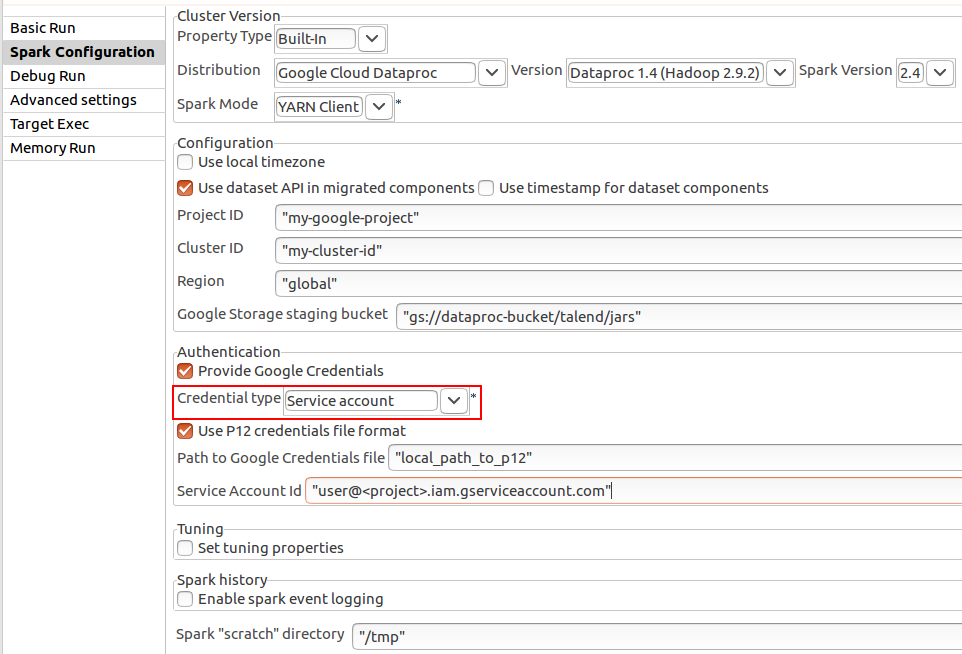

| Support de l'authentification par compte de service et jeton d'accès OAuth2 pour la distribution Google Cloud Platform dans des Jobs Spark Batch | Vous pouvez à présent vous authentifier à Google Cloud Platform soit par un compte de service, soit par un jeton d'accès OAuth2 dans des Jobs Spark Batch, en version 1.4 de Dataproc. Ces méthodes d'authentification sont disponibles dans la vue Spark configuration (Configuration Spark) de votre Job Spark Batch.

|

Tous les produits Talend incluant Big Data |

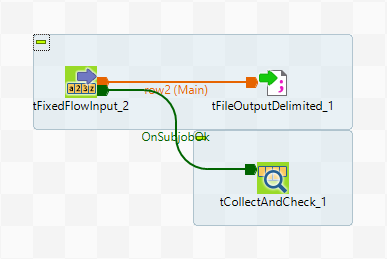

| Mise à jour du composant tCollectAndCheck dans les Jobs Spark | Vous pouvez à présent vérifier directement les données d'entrée avec le tCollectAndCheck dans des Jobs Spark. Les types d'entrées suivants sont supportés :

Pour les Jobs Spark Batch, le composant est connecté comme suit :

Le composant vérifie qu'il y a bien le nombre exact de lignes et que la valeur des lignes est correcte dans les Jobs Spark Batch. Pour les Jobs Spark Streaming, le composant vérifie les données à la fin de l'exécution du Job, après une expiration du délai, comme suit :

Le composant vérifie que les valeurs sont correctes. Il est admis que l'entrée puisse être nulle ou que les lignes ne soient pas uniques dans des Jobs Spark Streaming. |

Tous les produits Talend incluant Big Data |

Data Integration : nouvelles fonctionnalités

|

Fonctionnalité |

Description |

Disponible dans |

|---|---|---|

| Amélioration de la gestion des dépendances du code | Le Studio Talend vous permet de créer des JAR de routines personnalisées, de mettre en package plusieurs routines personnalisées dans un JAR de routines personnalisées et de configurer des dépendances de JAR de routines personnalisées dans des Jobs et Joblets. En configurant les dépendances du JAR de routines personnalisées dans les Jobs et Joblets, les dépendances du code pour les Jobs et les Joblets deviennent plus explicites et peuvent réduire les conflits de dépendances. Note InformationsRemarque : Par défaut, les routines personnalisées migrées depuis une version précédente du Studio Talend sont toutes sauvegardées sous le nœud .

|

Tous les produits Talend incluant le Studio Talend |

| Amélioration du tELTOracleMap | L'éditeur ELT Map du composant tELTOracleMap offre une nouvelle boîte de dialogue Property Settings (Paramètres des propriétés), contenant deux options :

|

Tous les produits Talend incluant le Studio Talend |

| Amélioration de la résolution de conflits Git pour le tELTMap | Le Studio Talend supporte à présent la comparaison des conflits pour le tELTMap dans l'éditeur de comparaison de Jobs.

|

Tous les produits Talend incluant le Studio Talend |

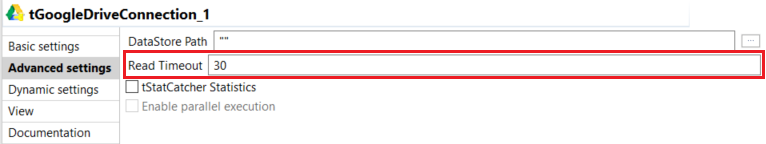

| Composants Google Drive : nouvelle option Read Timeout (Expiration du délai de lecture) | L'option Read Timeout (Expiration du délai de lecture) a été ajoutée à la vue Advanced settings. Cette option est disponible pour les composants tGoogleDriveConnection, tGoogleDriveCopy, tGoogleDriveCreate, tGoogleDriveDelete, tGoogleDriveGet, tGoogleDriveList et tGoogleDrivePut.

|

Tous les produits Talend sauf Talend ESB |

| Support de l'API Mongo DB 4.4 pour les composants MongoDB et CosmosDB | Vous pouvez à présent connecter les composants MongoDB et CosmosDB à la version 4.4 de MongoDB. |

Tous les produits Talend incluant Big Data |

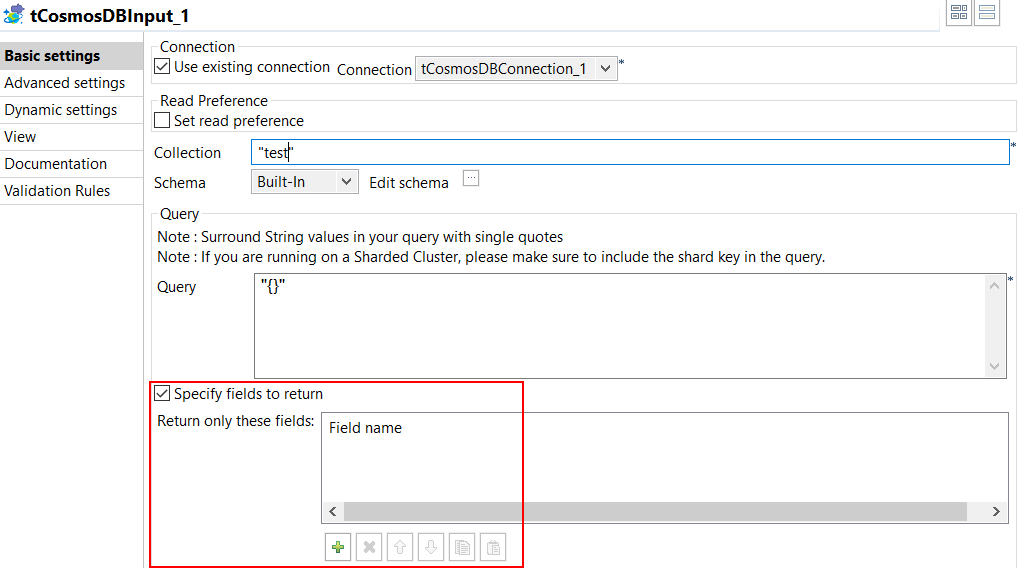

| Amélioration des performances des composants MongoDB et CosmosDB dans des Jobs Standard | Les composants MongoDB et CosmosDB fournissent à présent les options suivantes dans les Jobs Standard :

|

Tous les produits Talend incluant Big Data |

|

Nouveaux composants SingleStore |

Les trois nouveaux composants SingleStore suivants sont disponibles. Ils offrent de meilleures performances pour le chargement de données dans des tables de bases de données.

|

Tous les produits Talend incluant le Studio Talend |

|

Nouvelle option pour attribuer des autorisations AWS prédéfinies aux ressources S3 |

Une nouvelle option, Canned Access Control, est à présent fournie dans les composants suivants, pour que vous puissiez attribuer des autorisations AWS prédéfinies aux ressources S3 :

|

Tous les produits Talend incluant le Studio Talend |

Data Mapper : nouvelles fonctionnalités

|

Fonctionnalité |

Description |

Disponible dans |

|---|---|---|

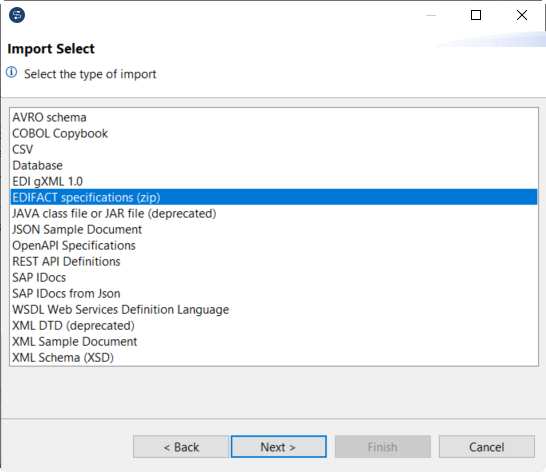

| Import d'EDIFACT | Vous pouvez à présent importer des spécifications UN/EDIFACT en tant que fichiers ZIP afin de créer des structures. Talend Data Mapper supporte les spécifications à partir de la version D.96A.

|

Tous les produits Talend Platform et Data Fabric |

| Fonctions XPath dans la propriété Distinct Child Element | Dans la fonction SimpleLoop, si vous sélectionnez Element XPath dans le champ Distinct Option, vous pouvez utiliser une fonction XPath pour définir des valeurs distinctes. |

Tous les produits Talend Platform et Data Fabric |

Intégration d'applications : nouvelles fonctionnalités

|

Fonctionnalité |

Description |

Disponible dans |

|---|---|---|

| Amélioration de la gestion des dépendances du code | Le Studio Talend vous permet à présent de créer des JAR de beans personnalisés et des JAR de routines personnalisées, de mettre en bundle plusieurs beans ou routines personnalisées dans un JAR de bean personnalisé ou dans un JAR de routine et de configurer le JAR de bean personnalisé ou les dépendances du JAR de routine dans les Routes et Routelets. En configurant le JAR de bean personnalisé ou les dépendances du JAR de routine dans les Routes et Routelets, les dépendances du code deviennent plus explicites et peuvent réduire les conflits de dépendances.

|

Tous les produits Talend incluant ESB |